是什么让我对人工智能忧心忡忡?

本文作者想和大家聊聊让我对人工智能忧心忡忡的问题是:人工智能对人类行为具有高效、可扩展性操作的能力,以及企业和政府对人工智能的滥用。enjoy~

如果你身在 20 世纪 80 年代、90 年代左右,你可能还记得已经消失的“电脑恐惧症”。

直到 21 世纪初,我还亲身经历过随着个人电脑在我们的生活、工作和家庭中出现,很多人会焦虑、恐惧甚至出现攻击行为。

虽然其中的一些人被电脑吸引,并且看到了电脑的潜力,但大多数人并不了解电脑。这些人对电脑感到陌生、费解,并在许多方面存在着威胁。他们害怕被技术取代。

大多数人对技术的态度,最好的情况是反感,最坏的情况是恐慌——也许对任何变化,人们的反应都是这样的。

值得注意的是:我们所担心的,大部分都是杞人忧天。

让我们快进一下:

因电脑而担忧的人已经不能没有电脑了,并且他们用电脑为自己谋利。计算机并没有取代我们,也没有引发大规模失业。反倒是现在,我们无法想象没有笔记本电脑、平板电脑和智能手机的生活。昔日的杞人忧天却朝着相反的方向发展,我们的担忧未能实现。

但同时,在 20 世纪 80 年代和 90 年代,没有人警告我们电脑和互联网将会产生一定的威胁——无处不在的大规模监控:黑客通过追踪网络设施或者个人数据,人们通过社交网络表现出心理异化,人们的耐心和注意力丧失,网上易受政治思想或宗教激进化的影响,敌对的境外势力劫持社交网络以破坏国家主权。

如果大部分的恐惧变得非理性的话,相反地,人们才发现过去由于技术变化而产生的担忧已成为现实。

一百年前,我们无法真正预测到,正在开发的运输和制造技术将导致新的工业战争,而这在两次世界大战中使数千万人丧生。我们并没有过早地意识到电台的发明,会促成一种新的大众传播形式,这种形式有助于意大利和德国的法西斯主义兴起。

20 世纪 20 年代和 30 年代理论物理学的发展的同时,并没有相应的带有焦虑性的前瞻报道,即关于这些理论发展如何能够很快落地并发展成核武器,使世界永远处于即将毁灭的恐慌之中。而当今,即便是被关注十多年的气候等严重问题,大部分美国人(44%)也仍然会选择忽视。

作为一种文明,我们似乎很难正确辨别它们的未来是好是坏,正如我们因非理性的恐惧而出现恐慌一样。

与过去一样,当前我们依然处在一场根本性变革的新浪潮当中:认知自动化,它可以概括为“人工智能(AI)”。与过去一样,我们担心这种新技术会伤害我们——人工智能会导致大规模失业,或者人工智能会拥有自己的机构,变成超人,把我们摧毁。

图片来源:facebook.com/zuck

但如果这些担心是多余的,就像我们以前一样?如果人工智能的真正危险与当下令人惊慌的“超级智能”和“奇点”叙述大相径庭呢?

在本文,我想和大家聊聊让我对人工智能忧心忡忡的问题是:人工智能对人类行为具有高效、可扩展性操作的能力,以及企业和政府对人工智能的滥用。

当然,这不是唯一的有形风险,还有很多,特别是与机器学习模型有害偏见相关的问题;就这个问题,其他人的见解比我更加出色。

本文选择从大规模人口控制的角度进行切入,是因为我认为这种风险是迫切并且被严重低估的。

今天,这种风险已经变为现实,在接下来的几十年里,许多技术会有增强的趋势。

我们的生活越来越数字化,社交媒体公司越来越了解我们的生活和想法。与此同时,他们越来越多地使用一些手段控制我们获取信息,特别是通过算法手段。他们将人类行为视为一个可优化的问题,一个人工智能问题:社交媒体公司调整算法变量实现某种特定行为,就像游戏人工智能会改进游戏策略一样。这个过程中唯一的瓶颈就是算法。这些事情都正在发生或即将到来,最大的社交网络公司目前正在潜心研究人工智能技术,并在相关项目上投资了数十亿美元。

接下来的讨论,我将分成以下几部分,对上面的问题进行拆解并详细描述:

- 社交媒体是一种心理监狱

- 内容消费是心理控制载体

- 用户行为是待优化的问题

- 当前的情况

- 反面:人工智能能为我们做什么

- 反社交媒体的构建

- 结论:在前进的岔道口上

一、社交媒体是一种心理监狱

在过去的 20 年中,我们的私人和公共生活已经转移到网络上。我们每天用更多的时间盯着屏幕。我们的世界正在转向某个状态,在这个状态中我们所做的大部分事都由内容消费、修改或创造构成的。

这种趋势的反面是:企业和政府正在大量收集我们的数据,特别是通过社交网络了解我们与谁交流,我们说什么,我们在看什么内容——图片、电影、音乐以及新闻,我们在特定时间的心情,等等。最终,几乎与我们相关的一切最终都会以数据的形式记录在某个服务器上。

理论上,这些数据能够让收集的企业和政府为个人以及团体建立非常准确的心理画像。你的观点和行为可以与成千上万的“同类”产生共鸣,让你对所选的内容有不可思议的理解——这可能比你单纯通过自省的手段要好的多。

例如,通过 Facebook 的“喜欢”功能更好地评估朋友的个性。大量的数据让下面这些成为可能:提前几天预测用户何时(与谁)建立关系,何时结束关系;谁有自杀倾向;在选举中,用户最终会票投给谁——即便是那时用户仍犹豫不决。

这不仅仅能对个人进行分析,对大型团队的预测能做得更好(拥有大量数据消除其中的随机性以及异常值)。

二、内容消费是心理控制载体

被收集数据还只是个开始,社交网络越来越多地控制着我们获取的内容。

目前,我们看到的内容大多是算法在起作用。算法越来越多地影响并决定我们阅读的政治文章、我们看到的电影预告片、与我们保持联系的人,甚至是我们收到谁关于自己的反馈。

综合多年的报道,算法对我们的生活有相当大的影响——比如我们是谁、我们会成为谁。

如果 Facebook 能够在较长时间内能够决定你将看到哪些新闻(或真或假),以及决定你的政治地位的变化,甚至会决定谁会看到有关你的新闻;那么,Facebook 就会实际控制你的世界观以及政治信仰。

Facebook 的业务在于影响人们,从而向广告主提供服务。

Facebook 建立了一个微调算法引擎,这个算法引擎不仅能够影响你对品牌或购买智能音箱的看法。调整这个算法给你的内容,能够影响并控制你的情绪——这个算法甚至能够改变选举结果。

三、用户行为是待优化的问题

社交网络能够在衡量我们一切的同时,控制我们获取的内容——而这一切正在加速发展。

当我们感知并行动时,就会考虑人工智能问题了。

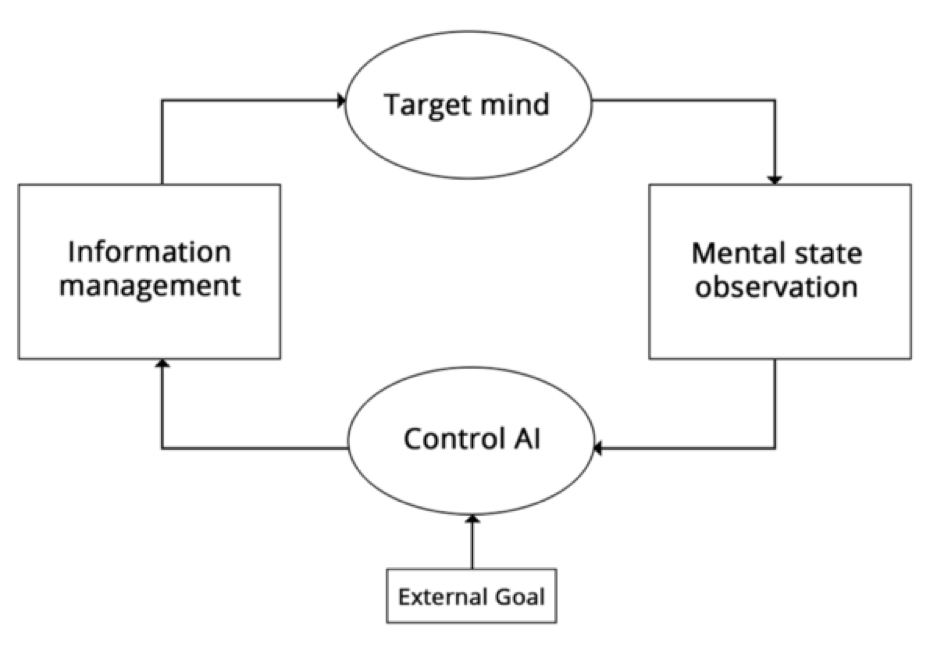

你能够建立一个行为的优化循环,在这个循环中,可以观察目标当前状态并不断调整提供的信息,直到目标。人工智能领域的一大子集——特别是“强化学习”——是关于开发算法来有效地解决待优化的问题,从而关闭循环并完全控制目标。在这种情况下,通过把我们的生活转移到数字领域,我们会易受人工智能影响。

人类行强化学习循环

人类的思想很容易受简单社交模式的影响,因此更容易受到攻击和控制。比如以下角度:

- 身份强化:自从有广告后一直被利用的技巧,现在任然奏效。它把特定的内容和你的标记联系起来,进而能把控内容。在人工智能参与的社交媒体下,算法可以让你你只看到自己希望看到的内容(无论是新闻,还是来自朋友的博文);相反,算法也可以让你远离你不想看到的内容。

- 消极社交强化:如果你发表的文章表达了算法不希望你持有的观点,系统可以选择仅向持有相反观点的人推荐你的文章(可能是熟人、陌生人,甚至是机器人)。反复多次,这可能会让你与初始观点相去甚远。

- 积极社交强化:如果你发表文章表达的观点是算法想要传播的,算法会选择将文章展示给“喜欢”它的人(甚至是机器人)——这会加强你的信念,让你觉得自己是多数人当中的一员。

- 样本偏好:算法也能控制向你显示来自你朋友(或广大媒体)的支持你观点博文。在这样的信息泡沫中,你会觉得这些观点会获得比现实中更广泛的支持。

- 参数个性化:算法也可能会观察到和你的心理属性相似的人——毕竟“人以群分”嘛。然后,算法为你提供内容,这些内容会对和你有类似观点和生活经验的人最有益。从长远来看,该算法甚至可以从头开始生成特别适合你的、最高效的内容。

从信息安全的角度来看,你会称这些为漏洞——已知的可接管系统的漏洞。就人类思维而言,这些漏洞永远不会被修补,它们只是我们的生活方式,存在于我们的 DNA 中。

人类思维是一个静态的、易受攻击的系统,并将越来越受到人工智能算法的控制,这些算法在完全了解我们所做的和相信的事情的同时,开始完全控制我们获取的内容。

四、当前的情况

值得注意的是,在获取信息的过程中应用人工智能算法,会引起大规模的人口控制——特别是政治控制——这个过程中使用的人工智能算法,不一定非常先进。

你不需要自我意识,目前的技术可能就足够了,人工智能是这样可怕的存在——社交网络公司在这方面已经开展了较长时间的研究,并且取得了显着的成果。

虽然可能只是试图将“参与”效果最大化并影响你的购买决定,而不是操纵你对世界的看法,但他们开发的工具已被反对派在政治事件中使用。如 2016 年英国脱欧公投或 2016 年美国总统选举——这是我们必须面对的现实。但是,如果今天大规模人口控制已经成为可能,那理论上,为什么世界还没有颠覆呢?

总之,我认为这是因为我们并不擅长运用人工智能;但这也意味着有很大的潜力,或许即将有所改变。

直到 2015 年,整个行业所有广告相关的算法都只靠逻辑回归运行——事实上,就算是现在,很大程度上也是如此,毕竟只有行业大佬才会用更先进的模式。

逻辑回归是一种早于计算时代的算法,是个性化推荐的最基本的技术之一——这就是为什么在网上看到的这么多广告,而这些广告却毫无关系的根源所在。同样,反对派用来影响舆论的社交媒体机器人几乎没有人工智能,目前他们的做法都非常原始。

机器学习和人工智能近年来飞速发展,而且它们才开始在算法和社交媒体机器人上得到应用;直到在 2016 年,深度学习才开始在新闻传播和广告网络中得到应用。

谁知道接下来会发生什么呢?

Facebook 在人工智能研究和开发方面投入了大量资金,并且励志成为该领域的领导者,这令人为之兴奋。当你的产品是新闻源时,对你来说,自然语言处理和强化学习会有什么用武之地呢?

我们正在创建一家公司,该公司可为近 20 亿人构建细致入微的心理画像,为许多人提供主要的新闻来源,它运行大规模的行为操纵实验,旨在开发当今世界还没有的、最先进的人工智能技术——就我个人而言,它让我感到害怕。

在我看来,Facebook 可能不是最令人担忧的存在。许多人喜欢意淫某些大企业统治着世界,但这些企业的权力却远远小于政府。如果对我们的思想通过算法进行控制,那么政府很可能会变的很差,而不是企业。

现在,我们能做些什么呢?我们如何保护自己?作为技术人员,我们通过社交媒体做什么才能避免大规模控制?

五、反面:人工智能能为我们做什么

重要的是,这种威胁即便是存在,也不意味着所有的算法策略都是不好的,或者说所有的广告都不好,它们都有一定的价值。

随着互联网和人工智能的兴起,将算法应用于获取信息不仅是必然的趋势,更是理想的趋势。

随着我们的生活越来越数字化、联系越来越紧密,信息也变得越来越密集,人工智能变成我们与世界的桥梁。长远看,教育和自我提高将是人工智能最强的应用场景——这种情况会在动态变化中实现,这些变化几乎完全反映了试图控制你的恶意人工智能在内容推送中的运用。在帮助我们方面,算法存在巨大的潜力,能够赋予个人更多能力,并帮助社会更好地自我管理。

问题不是人工智能,而是——控制。

我们不应该让内容推送算法控制用户并暗中实现隐藏的目标——比如左右他们的政治观点,或者不断地浪费时间——而应该让用户负责算法优化。毕竟,我们正在谈论的是有关自己的内容、自己的世界观、自己的朋友、自己的生活;技术对你的影响应该自然地受制于你自己。

算法不应该成为一股神秘的力量,靠这个力量实现有损于自身利益目标;相反,他们应该为我们所用,能够为自身利益服务的工具。如教育、自我营销,而不是为了娱乐。

我想,任何应用算法的产品都应该:

- 公开透明地告知算法目前优化的目标,以及这些目标如何影响用户的信息获取。

- 提供给用户简洁的功能设定他们的目标。例如,用户应该能够在特定的地方能够自由控制,从而最大限度地保护自己,并未自己服务。

- 始终以可见的方式了解用户在当前产品上花费的时间。

- 通过工具能够控制用户自己在当前产品上花费的时间。如设置每天的时间目标,算法通过该目标让你实现自我管理。

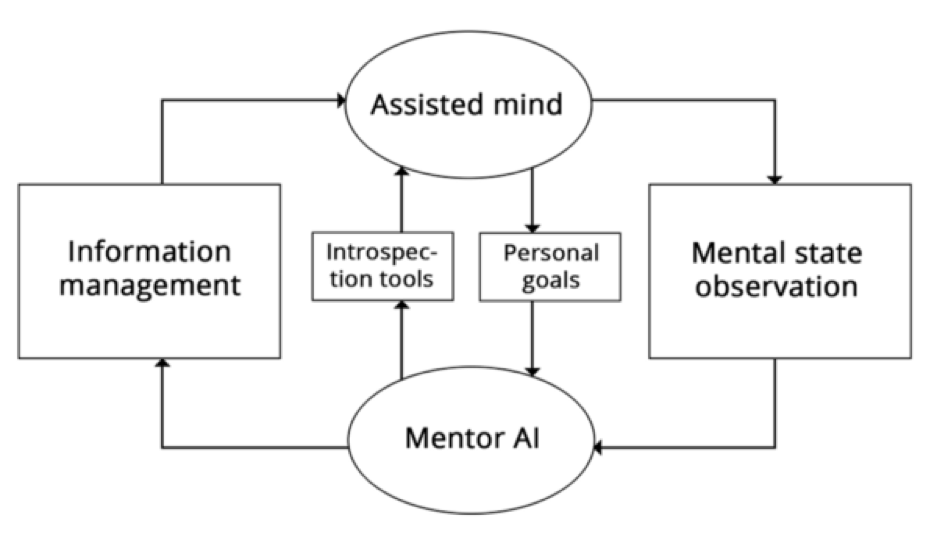

在避免被控制的同时用人工智能保护自己

我们应该让人工智能为人类服务,而不应该操纵用户牟取利润或者达到某种政治目的。

如果算法不像赌场运营商或宣传人员那样运作,该怎么办?

相反,如果算法更像一位导师或一位优秀的图书管理员,对你以及数百万人的心理洞若观火——在此基础上,算法向你推荐了一本书,这会与你的需求不谋而合,并且他们相伴而生。

这种人工智能是一种指导你生活的工具,它能够帮你找到实现目的的最佳路径。

如果算法已经分析过数百万人,你能想象通过算法了解的世界来看待自己的生活吗?或者与一个百科全书式的系统合著一本书?又或者与一个了解当前人类全部知识的系统合作进行研究?

在一个完全受制于人工智能的产品中,更先进的算法——而不是威胁,将会存在一些积极的方面,让你更有效地实现自己的目标。

六、反社交媒体的构建

总而言之,未来人工智能将成为我们与世界的接口,这是一个由数字信息组成的世界——这同样会让个人有可能更好地管理自己的生活,当然也有可能完全丧失这个权利。

不幸的是:社交媒体目前的发展有些南辕北辙。

不过,千万不要觉得我们可以扭转局面,这还为时尚早。

我们需要开发这个行业内的产品类别和市场,其中的激励措施与让用户负责影响他们的算法是一致的,而不是使用人工智能操纵用户牟取利润或者达到某种政治目的;我们需要努力做出反 Facebook 一类社交媒体的产品。

在遥远的未来,这些产品可能会以人工智能助手的形式出现。数字导师通过程序帮助你,你能够通过他们控制自己在交往过程中所追求的目标。

而在目前,搜索引擎可以被看作是一个人工智能驱动信息的出雏形,它为用户服务,而不是试图控制用户。

搜索引擎是一种有意控制而达到特定目的的工具,你告诉搜索引擎它应该为你做什么,而不是被动的获得内容;搜索引擎会尽量减少从问题到答案,从问题到解决方案所需的时间,而不是在浪费时间。

你可能会想:毕竟搜索引擎仍然是我们和信息之间的人工智能层,它做展示的结果,是否会有所偏好从而控制我们呢?

是的,每种信息管理算法都存在这种风险。

但与社交网络形成鲜明对比的是:在这种情况下,市场激励实际上与用户需求一致,推动搜索引擎尽可能做到相关和客观。如果不能最大限度地发挥作用,那么用户会毫不犹豫地转向竞品。重要的是:搜索引擎对用户心理的攻击,比社交内容小得多。

本文所描述的产品中的威胁包含以下内容:

- 感知和行动:产品不仅应该控制向你展示的内容(新闻和社交内容),还应该通过类似“喜欢”的功能、聊天信息和状态更新来“感知”你当前的心理状态。没有认知和行动,就不能强化学习。正所谓“工欲善其事,必先利其器”。

- 生活的中心:产品应该是一部分用户的主要信息来源,典型用户会每天花费数小时在产品上。辅助性和专业化的产品或服务(如亚马逊的物品推荐)将不会存在严重的威胁。

- 社会成分:激活更广泛和更有效的心理控制因素(特别是社会强化)。没有人情味的内容只占我们思想的一小部分。

- 业务激励:目的在于操纵用户,并让用户在产品上停留更多时间。

而大多数人工智能驱动的产品,都不符合以上这些要求。

另一方面,社交网络是风险因素的组合,它拥有可怕的力量。

作为技术专家,我们应该倾向于那些不具备这些功能的产品,拒绝那些将这些功能组合在一起的产品,它们因错误使用而具有潜在危险性。

建立搜索引擎和数字助理,而不是社会新闻,这将使推荐透明,并且富有可配置性和建设性,而不是蹩脚的机器,最大限度地提高“参与度”并浪费你时间。

关注界面和交互,以及人工智能等相关的专业知识,为算法构建出色的设置界面,让用户能够按照自己的目标使用产品。

重要的是:我们应该将这些问题告知并教育用户,以便他们能够有足够的信息,决定是否使用有一定可能性控制自己的产品——那样就能够产生足够的市场压力,从而引发技术变革。

七、结论:在前进的岔道口上

- 社交媒体不仅足够了解个人和组织建立的强大的心理模型,而且也越来越多地控制着我们的信息获取。它可以通过一系列行之有效的心理攻击,操纵我们相信的东西、我们的感受以及我们的所作所为。

- 一个足够先进的人工智能算法,可以通过对我们精神状态的感知以及受精神状态支配的行动的了解,能够高效地控制我们的信念和行为。

- 使用人工智能作为信息接口本身并不是问题。这样的人机交互界面,如果设计良好,有可能为我们所有人带来巨大的益处和赋权。关键在于:用户应该完全控制算法,将其作为用于追求自己目标的工具(与使用搜索引擎的方式相同)。

- 作为技术专家,我们有责任拒绝脱离控制的产品,并致力于构建对用户负责的信息界面。不要将 AI 当作控制用户的工具;而是让你的用户把 AI 当成工具,为他们服务。

一条路让我感到害怕,另一条路让我充满希望——还有足够的时间让我们做的更好。

如果你正在使用这些技术,请牢记这一点:

你可能没有恶意,你可能毫不在乎;相比分享你的未来,你或许更容易评估受限制股票的发展。但是无论你是否在意,因为你掌握了数字世界的基础设施,你的选择会影响他人,而你最终也可能会为他们负责。

免责声明:本文仅代表我的(作者)个人观点。我不会为我的老板发言。如果你引用了文章中的内容,请务必诚实地将这些信息展示出来:个人的、推测性的,根据自己的是非曲直判断得来的。

原文作者:François Chollet

原文地址:https://medium.com/@francois.chollet/what-worries-me-about-ai-ed9df072b704

#专栏作家#

郑几块,人人都是产品经理专栏作家,前新浪微博产品经理。

本文系作者@郑几块 独家翻译授权,未经本站许可,不得转载

题图来自 Pixabay,基于 CC0 协议

起点课堂会员权益

起点课堂会员权益

墨菲定律 《事情如果有变坏的可能,不管这种可能性有多小,它总会发生。》——小鱼儿