AI Agent产品落地:从“万金油”到“专业工具”的蜕变

AI Agent的热潮让无数产品尝试“万能助手”的定位,但真正的落地却并不轻松。它们在实践中逐渐暴露出边界与局限,也因此催生了向“专业工具”转型的趋势。本文将带你拆解这一蜕变背后的逻辑。

最近跟几个做产品的朋友聊天,大家都在吐槽AI Agent这东西。 demo做出来的时候溜得起飞,一落地就摔得稀碎。你说它智能吧,确实能帮你写代码、做报告;你说它靠谱吧,用户用一次就再也不来了。这感觉就像找了个特别能说的实习生,干活的时候总得你在旁边盯着,生怕出什么岔子。

我记得上个月有个做电商的朋友,兴冲冲地搞了个智能客服Agent,结果第一周就被用户骂惨了。用户问”包裹到哪了”,Agent回了一堆官方话术,连基本的物流信息都查不准。朋友气得直拍桌子:”这玩意儿还不如我雇个大学生!”

说实话,我也经历过这种挫败感。刚开始做AI产品的时候,总觉得有了大模型就能解决所有问题。后来才发现,技术再厉害,也得先搞清楚到底要解决什么问题。今天就想跟大家聊聊,怎么让Agent产品真正落地,而不是活在PPT里。

当”智能助手”回归”智能工具”

不知道你发现没有,现在市面上好多Agent产品都陷入了一个怪圈:拼命宣传自己有多智能,能干啥啥啥,但用户实际用起来总觉得差点意思。就像你去买辆车,销售光说这车能飞能跑能潜水,结果你开上路发现连倒车都费劲。

我有个做投资的朋友说得挺形象:”现在的Agent就像个啥都会点的万金油,但真到用的时候,你不敢把重要的事交给它。” 这话虽然扎心,但确实点出了问题的核心。

失败案例1:通用办公助手的”大而全”陷阱

去年我参与过一个项目,想做个通用的办公助手Agent。我们团队花了三个月,把各种功能堆得满满的:写邮件、做PPT、安排会议、甚至还能帮你点外卖。 demo做出来的时候老板可开心了,觉得这下员工能省不少事。结果上线一个月,数据惨不忍睹:90%的用户试用一次就再也没打开过。

后来我们做了个用户访谈,有个老哥的话让我印象特别深:”我用它写邮件,还得先花十分钟告诉它背景信息,写完还得自己改半天。有这功夫我自己早写完了。”

更讽刺的是,我们发现使用频率最高的功能竟然是”点外卖”,但这显然不是我们产品的核心价值。这个项目最后不了了之,团队也解散了大半。

失败案例2:教育领域的”万能学习助手”困境

前阵子碰到一个做教育科技的团队,他们开发了一款号称”从小学到大学全覆盖”的学习助手Agent。功能包括作业批改、知识点讲解、作文辅导、甚至还有心理咨询。团队信心满满地投入了数百万研发费用,结果上线半年付费用户不足千人。

深入分析后发现,他们的数学解题功能不如专门的拍照解题App准确,英语作文批改不如专业的语法检查工具细致,而心理咨询功能更是因为缺乏专业资质被家长投诉。就像一个什么都想教的老师,结果什么都教不精。

这件事让我想明白一个道理:用户要的不是什么都能干的”超人”,而是能在特定场景下真正帮上忙的”专业工具”。就像你不会指望一把螺丝刀能当锤子用,但一把好螺丝刀拧螺丝就是比别的工具顺手。

成功案例:法律行业的合同审查专家Agent

相反,我认识一家专注于法律科技的初创公司,他们只做一件事:合同审查。他们的Agent不吹嘘自己能写诉状、能打官司,就专注于帮律师快速找出合同中的风险点和不规范条款。

他们花了两年时间,收集并标注了超过10万份各类合同,训练出的模型能识别出300多种常见风险点。现在这款产品已经被国内多家律所采用,准确率达到92%,平均能帮律师节省40%的合同审查时间。

最有意思的是,他们不追求”全自动审查”,而是采用”AI初筛+律师复核”的模式,既提高了效率,又保证了专业性。这种清晰的定位让他们在竞争激烈的法律科技领域站稳了脚跟。

祛魅与归真:重新定义Agent产品的价值内核

产品视角下的Agent:不是”科幻主角”,而是”价值载体”

咱们先抛开那些高大上的技术名词,想想Agent到底是什么。在我看来,它就是个能帮你干活的数字员工。但这个员工到底能干多好,取决于你给了它什么样的”工作岗位”。

所谓 “祛魅”,是剥离对它 “全能智能” 的幻想:它不是科幻电影里能自主决策、无所不能的人造生命,而是一个基于场景需求构建的工具,核心作用是 “解决具体问题”,而非 “展示技术炫技”。

所谓 “归真”,是回归 “价值载体” 的本质:它的价值不在于 “看起来多智能”,而在于能在多大程度上满足用户的真实需求、创造可感知的价值—— 比如帮企业降低运营成本、帮个人提升事务处理效率。

把它理解成 “数字员工”,这个逻辑会更清晰:就像企业里的客服专员、行政助理、数据分析师有明确的岗位权责和价值产出,Agent 的能力也完全由 “岗位场景” 定义 ——

- 把它放在 “智能客服” 的岗位上,它的价值是 “7×24 小时解决用户高频问题,降低人力成本”;

- 把它放在 “个人健康管理” 的岗位上,它的价值是 “实时追踪健康数据、推送个性化建议,提升生活质量”;

- 但如果不给它明确的 “岗位”,让它盲目追求 “全能性”,最终只会变成 “什么都想做,却什么都做不精” 的无效工具。

所以,做 Agent 产品的核心逻辑,不是 “堆砌技术让它看起来像科幻主角”,而是先想清楚用户需要一个 “什么样的数字员工”,再围绕这个 “岗位” 去构建它的能力—— 这才是 Agent 产品价值的内核。

核心约束:认清大模型的”能力边界”

说到这儿,我得泼点冷水。大模型确实厉害,但它不是万能的。我总结了下,主要有这么几个坎儿过不去:

第一是可靠性问题。这玩意儿有时候就跟抽奖似的,同样的输入可能给出完全不同的输出。我们做过测试,让同一个Agent连续处理十份相同的合同审阅任务,结果能找出七八个不同的风险点。这要是在真实业务场景里,法务部门非得疯了不可。

第二是准确性问题。大模型经常会”一本正经地胡说八道”。我记得有个医疗Agent,用户问”感冒了吃什么药”,它居然推荐了一种处方药,还把剂量写错了。幸亏及时发现,不然真要出大事。

最要命的是成本问题。我们算过一笔账,如果一个Agent每天处理1000个任务,光API调用费用就能吃掉大部分利润。更别说还要考虑服务器、运维这些隐性成本。

所以在设计Agent产品时,一定要做好成本测算,避免产品上线后才发现”卖得越多亏得越多”。

最后是信任问题。用户对AI总有种天然的不信任感,特别是涉及到钱或者重要决策的时候。就像你不会让一个刚来的实习生直接审批百万级的采购单一样。

战略基石:如何为你的Agent产品精准定位

灵魂三问:定位的起点

每次有新同事加入产品团队,我都会让他们先回答三个问题。这三个问题看起来简单,但能筛掉80%不靠谱的产品想法。

第一个问题:这产品到底给谁用?是给小白用户还是专业人士?是To B还是To C?

我自己就踩过这个坑。之前做过一个智能写作Agent,想着既能帮大学生写论文,又能帮自媒体写稿子,还能帮企业写报告。结果就是两头不讨好:

- 学生觉得太专业看不懂,想要的“降重”功能我们没有,我们有的学术引用格式他们又用不上

- 媒体人觉得太浅用不上,他们需要的深度分析和创意构思Agent做不好

- 企业用户嫌不够正式,法律合规性也无法保证

后来我们聚焦到财经记者这个群体,专门做财报分析写作助手。因为这个群体需求明确:需要快速从财报中提取关键数据,生成客观中立的报道初稿。定位清晰后,产品才慢慢有了起色。

第二个问题:解决什么痛点?这个痛点要足够具体,最好是用户每天都会遇到的麻烦事。

比如我们现在做的一个Agent,就专门解决程序员找API文档的问题。程序员最头疼的就是翻文档,我们这个Agent能把常用API的用法、参数、示例都整理好,还能根据代码上下文给出建议。虽然场景很小,但用户粘性特别高。

第三个问题:做到什么程度?是100%自动化还是80%辅助?这个度一定要把握好。

我们之前犯过错误,总想追求全自动。后来发现,在很多场景下,用户更需要的是”智能辅助”。比如法律合同审查,完全让AI做主风险太大,但如果AI能先筛选出重点条款,律师再复核,效率就能提升好几倍。

定位法则:垂直深耕优于通用万能

这几年我看过太多Agent项目死在了”大而全”上。有个团队做了个”万能办公助手”,功能多得吓人,结果每个功能都做得不深。用户用着用着就跑了,因为每个场景都有更专业的替代品。

反而是一些垂直领域的小产品活得很滋润。我记得有个团队专门做电商客服的质检Agent。功能特别单一:监听客服通话,自动打分,找出服务问题。但因为做得深,准确率能达到95%以上,现在已经被好几家大电商采用了。

我的经验是,选赛道就像挖井,宁愿挖一口深井,也不要挖十个浅坑。特别是在资源有限的情况下,把一两个场景做透,比铺个大摊子更重要。

避坑指南:警惕”技术驱动”的定位陷阱

做技术的人最容易犯的错就是”技术自嗨”。太多团队因为掌握了个新技术,就非要找个场景落地。结果往往是产品做出来了,却发现根本没人需要。技术只是手段,解决问题才是目的。

我现在定产品方向时,都会先问自己:如果没有AI技术,这个问题能不能解决?如果能,用户为什么非要用你的AI方案?如果找不到足够强的理由,这个方向大概率有问题。

需求验证五步法

分享一个我们团队用的需求验证方法,能有效避免技术驱动的陷阱:

- 问题定义:用一句话清晰描述要解决的问题,不能包含任何技术术语

- 现状分析:用户现在是怎么解决这个问题的?有什么痛点?

- 价值主张:AI方案能带来什么具体的改进?效率提升?成本降低?体验改善?需要有可量化的指标

- 替代方案:有没有非AI的解决方案?为什么AI方案更好?

- 最小验证:能不能用非AI的方式(如人工+Excel)先验证这个需求的真实性和价值?

只有这五个问题都得到满意答案,我们才会启动AI Agent的开发。这个方法虽然看起来麻烦,但能帮我们避免很多不必要的投入。

破局关键:如何筛选与评估高价值Agent场景

理想场景的”四高”特征

经过这么多项目,我总结出一个筛选Agent场景的”四高”标准。符合这些特征的项目,成功率会高很多。

高价值是说这个场景解决的问题得值钱。比如我们帮银行做的反欺诈Agent,每阻止一笔欺诈交易就能避免几千上万的损失,这种价值就很直观。

高容错很重要。有些场景错了也没太大关系,比如生成营销文案,多个少个形容词影响不大。但有些场景,比如医疗诊断,错一点可能就是人命关天。

高结构化指的是任务流程要清晰。像数据报表生成这种工作,输入输出都很明确,Agent就容易做好。但如果是创意策划这种模糊任务,就比较难。

高壁垒是说这个场景要有一定的专业门槛。如果随便找个开源模型就能搞定,那你的产品很容易被复制。但如果需要深厚的行业知识,护城河就深了。

场景可行性评估矩阵

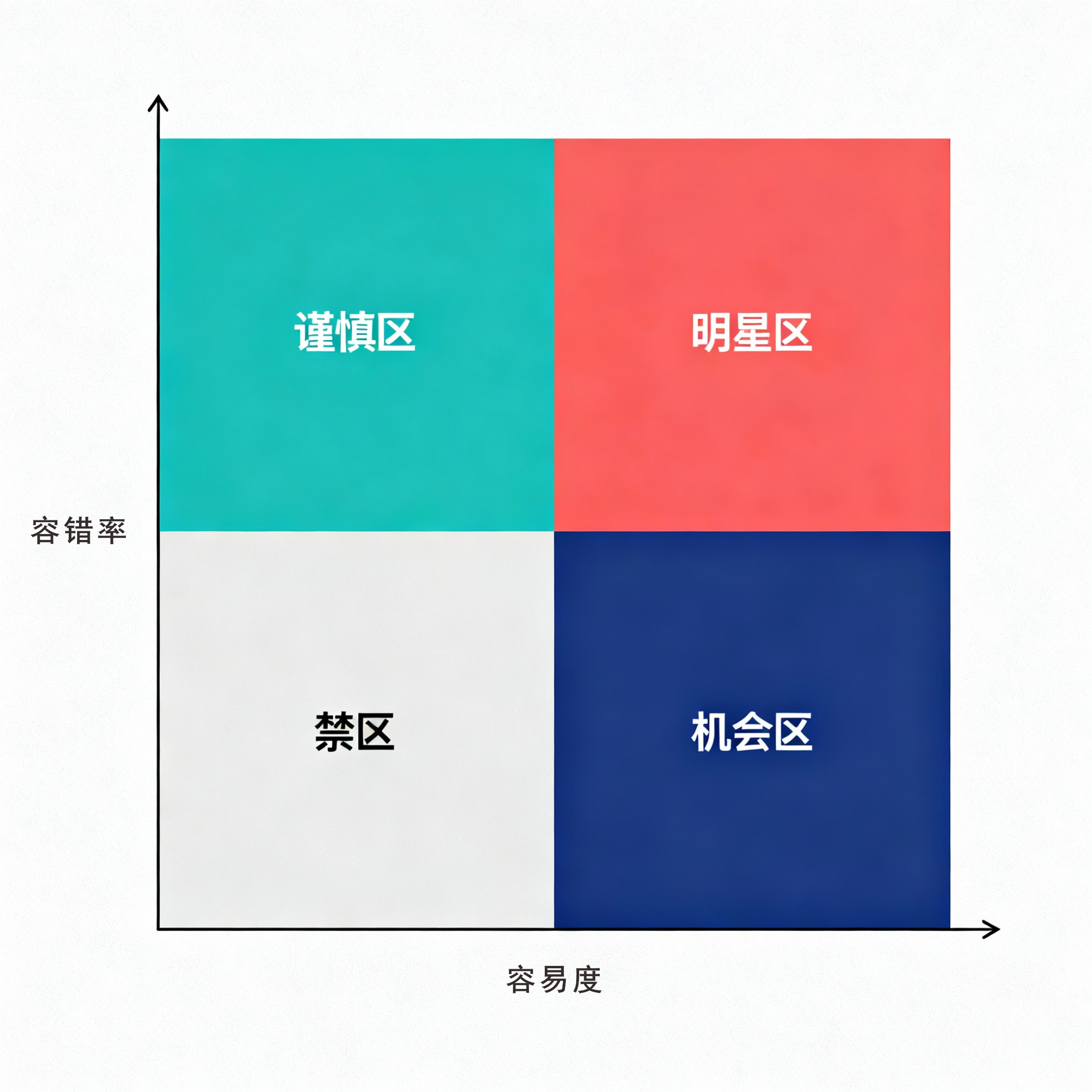

我习惯用一个简单的四宫格来评估场景。横轴是任务容易度,纵轴是容错率。

- 左下角是”禁区”:复杂又不容错的场景,比如自动驾驶、医疗手术。这些现在最好别碰。

- 右下角是”机会区”:复杂但容错率高,比如市场分析、科研辅助。这些可以尝试,但需要重投入。

- 左上角是”谨慎区”:容易但容错率低,比如数据录入。可以用工作流+人工审核的方式做。

- 右上角是”明星区”:容易又容错率高,比如内容生成、邮件分类。这些是最佳切入点。

我们现在长记性了,项目基本都是先从”明星区”做起,积累经验和数据后,再慢慢向”机会区”拓展。

落地实践:从场景到产品的关键设计原则

设计”可控的自主性”

Agent最难把握的就是自主性的度。给太多自由怕它乱来,给太少又体现不出价值。

我们的经验是采用”渐进式授权”。就像带新人一样,先让它做最简单的工作,做好了再给更多权限。

比如客服Agent,刚开始只让它回答常见问题,复杂问题转人工。等准确率达标后,再允许它处理一些中等难度的问题。最重要的是设置明确的”刹车”机制,一旦发现问题能立即介入。

构建透明的交互体验

用户对AI的不信任,很大程度上是因为不知道它在想什么。所以我们特别强调交互的透明度。

比如我们的数据分析Agent,每个结论都会标注数据来源和计算过程。用户随时可以点击查看详细推导步骤。虽然会增加一些开发成本,但换来的是用户的信任。

另一个技巧是让Agent主动暴露不确定性。当它不太确定时,会说”这个判断我有80%的把握,建议您再核实一下”,而不是硬着头皮给出肯定答案。

提升AI透明度的五个实用技巧

分享几个提升AI Agent透明度的实用技巧,这些都是我们在实践中总结出来的:

- 用自然语言解释决策:不要只给结果,用用户能理解的语言解释为什么做出这个决策。

- 可视化思考过程:对于复杂任务,可以用流程图、思维导图等方式展示Agent的思考过程。

- 提供证据支持:为关键结论提供证据支持,如引用数据、文档片段等。

- 主动承认不确定性:当Agent不确定时,要明确告知用户,并给出不确定性的原因。

- 允许用户调整参数:在适当情况下,允许用户调整影响Agent决策的关键参数,增加控制感。

这些技巧虽然会增加一些开发工作量,但能显著提升用户信任和满意度,从长远来看是非常值得的。

建立可靠的效果评估与迭代机制

Agent产品最怕的就是上线后就不管了。因为场景和数据都在变化,需要持续优化。

最重要的是建立用户反馈闭环。让用户能方便地指出问题,并且确保每个反馈都能得到处理。有些团队觉得这很麻烦,但长远看这是保持产品活力的关键。

在AI的浪潮中,做最清醒的产品掌舵人

写了这么多,其实最想说的是:做Agent产品需要特别的耐心和清醒。

现在行业有点过热,每天都能看到各种炫酷的demo。但作为产品人,我们要能分辨哪些是真正的创新,哪些只是昙花一现的概念。

我们老大经常提醒团队:别被技术带着跑,要带着技术跑。意思是说,要先想清楚要解决什么问题,再去找合适的技术方案,而不是反过来。

我观察那些做得好的Agent团队,都有一个共同点:他们不追求技术的最新最炫,而是死磕用户体验。每个功能上线前都要反复测试,每个用户反馈都要认真对待。

这种”笨功夫”在当下可能显得不够酷,但长远看,这才是构建护城河的正确方式。

本文由 @进化之家BRN 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益