生成式UI+多模态融合:Gemini 3如何重塑人机交互未来

Gemini 3的发布标志着人机交互从对话迈向共同创造的新纪元。其原生多模态能力与硬件调用,让用户能以自然语言生成交互界面,在教育、娱乐、企业服务等领域实现即时定制。本文深度解析技术底座与应用场景,探讨生成式UI如何降低创造门槛,释放无限想象力。

引言:从对话到创造的范式革命

说实话,我看到Gemini 3 这两天的消息后,第一反应不是技术有多厉害,而是感觉一个新时代好像真的要来了。我们跟机器的互动方式,好像要从“对话”变成“一起创造”了。以前我们用键盘、鼠标,后来用触摸屏、语音助手,这些都是在已有的框架里去操作。你得先学会用这个软件,知道哪个按钮是干嘛的。但现在,情况不一样了。Gemini 3,特别是它的 Canvas 功能,我感觉就像是给了我们一张白纸和一盒能听懂人话的画笔。你不再是软件的使用者,而是工具的创造者。你说“我想要一个能记账的工具”,它就给你生成一个;你说“帮我做一个模拟行星运动的动画”,它也能给你变出来。这种感觉,有点像科幻电影照进现实。这已经不是简单的AIGC,生成个图片、写个文案那么简单了。这是在生成“交互”,生成“功能”,生成“体验”。我觉得,这可能是一次人机交互的范式革命。我们正在从一个消费者,变成一个创造者。而这一切的背后,就是那个听起来有点玄乎的词:多模态融合和生成式UI。

技术底座解析——多模态如何赋能生成式UI

聊了这么多感性的东西,我们还是得回到理性的层面,看看这背后到底是什么在支撑。为什么Gemini 3能做到这些?关键就在于它的“原生多模态”和对硬件的调用能力。

原生多模态训练机制

“多模态”这个词听起来很高大上,其实没那么复杂。你可以把它想象成一个人的成长过程。一个孩子从小就是同时通过看、听、说来认识世界的,他看到苹果的图片,听到“苹果”这个词的发音,尝到苹果的味道,这些信息在他脑子里是自然融合的。他不会先把视觉和听觉分开处理。过去很多AI模型,有点像偏科生。有的擅长处理文字,有的擅长识别图像。你要让它们合作,就得在中间加个“翻译”。比如,你看图写话,模型得先用一个图像模型看懂图,再把看懂的信息转成文字,交给语言模型去写。这个过程里,信息多少会有点损失。Gemini 3不一样,它是个“全科生”,天生就能同时理解文本、图像、代码、声音这些东西。它在训练的时候,就是把这些不同类型的数据放在一个统一的空间里学习。所以,当你给它一张图,再给它一段文字指令,它能非常自然地把两者关联起来,因为它脑子里本来就是这么想问题的。这种原生的理解能力,是实现复杂生成式UI的基础。没有这个,后面的一切都无从谈起。

多维度的交互形式

如果说原生多模态是AI的大脑,那硬件交互能力就是它的“五官”和“四肢”。这是我觉得Gemini 3这次最让人兴奋的一点。它不再是一个只活在云端的虚拟大脑,它开始能跟我们现实世界的设备互动了。比如调用摄像头。这让AI有了“眼睛”。它能看到你,看到你周围的环境,看到你的手势。完全可以通过摄像头捕捉到你的手在空中移动,然后实时生成一个UI界面跟着你的手走。你的手就是鼠标,空气就是屏幕。这种交互方式,以前只在电影里见过。还有传感器。你的手机里有陀螺仪、加速度计,你的电脑有触控板。未来当AI可以调用所有传感器的数据时,玩法就更多了。你可以晃动手机来控制一个3D模型的旋转,或者在触控板上画个手势来触发某个特定功能。这让交互变得非常直观和有趣。AI不再是被动地等你输入文字,而是能主动感知你的物理动作。

(谷歌有个介绍 Google AI Edge 提供的 MediaPipe 解决方案套件的指南 “Google AI Edge MediaPipe Solutions” ,它是一个零门槛、跨平台的 AI/ML 解决方案套件,让你的应用瞬间拥有“超能力”。主打 Google AI Edge,核心优势在于端侧部署,让你能在 Android、Web、Python 和 iOS 等多端设备上直接运行模型,实现本地高效计算。)

审美智能的诞生

光能生成UI还不够,生成的界面得好看、好用才行。这就涉及到另一个很有意思的概念:审美智能。AI是怎么学会设计的?其实也没什么魔法。它就是“读书破万卷,下笔如有神”。它在训练过程中,看了海量的网页、App界面、设计作品。这些数据里,蕴含了人类几十年积累下来的设计原则和审美偏好。什么样的颜色搭配是和谐的,什么样的布局是清晰的,什么样的字体是易读的……它看的多了,慢慢就总结出了规律。所以,当你让它生成一个界面时,它不是随机组合元素,而是会下意识地遵循这些它学到的“设计感”。当然,它目前的审美可能还达不到顶尖设计师的水平,有时候会有点“模板化”,但对于快速生成一个可用、美观的原型来说,已经绰绰有余了。这大大降低了设计的门槛。

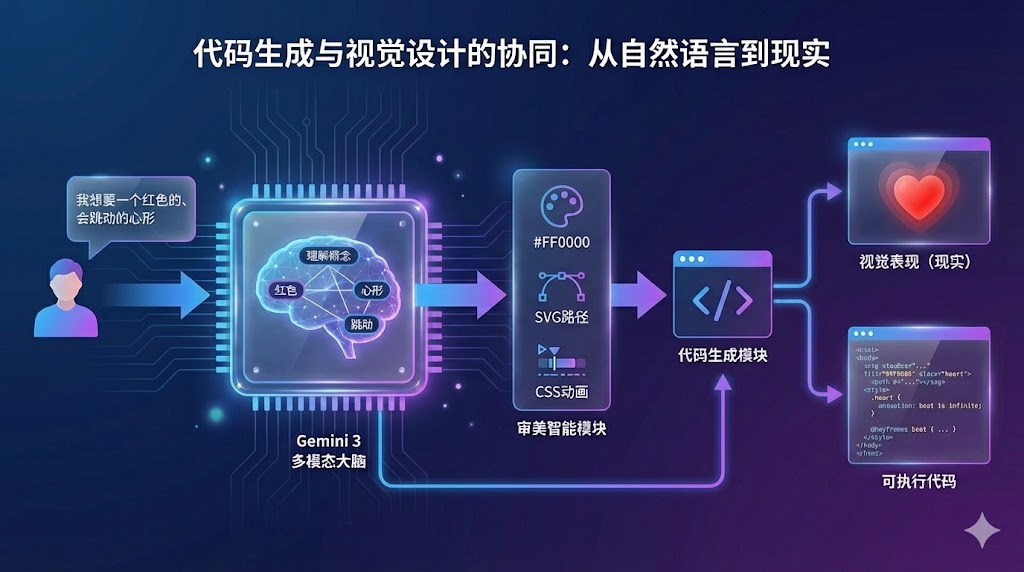

代码生成与视觉设计的协同

最后,这一切是怎么从想法变成现实的?靠的是代码生成和视觉设计的无缝协同。当你用自然语言描述“我想要一个红色的、会跳动的心形”时,Gemini 3的内部流程大概是这样的:首先,它的多模态大脑理解了“红色”、“心形”、“跳动”这几个概念。然后,它的审美智能模块会觉得,嗯,红色可以用#FF0000,心形可以用SVG路径画出来,跳动可以用CSS动画来实现。最后,它的代码生成模块就把这些想法翻译成了真正的代码,比如一段包含SVG和CSS的HTML文件。  整个过程一气呵成。它既是设计师,又是前端工程师。无论是画一个简单的SVG图形,还是构建一个复杂的3D场景,底层的逻辑都是一样的:将自然语言描述的需求,转化为视觉表现和可执行的代码。这种能力,是生成式UI能够落地的关键一环。

整个过程一气呵成。它既是设计师,又是前端工程师。无论是画一个简单的SVG图形,还是构建一个复杂的3D场景,底层的逻辑都是一样的:将自然语言描述的需求,转化为视觉表现和可执行的代码。这种能力,是生成式UI能够落地的关键一环。

生态应用场景——生成式UI的落地实践

聊完技术,我们来看看这些能力组合在一起,到底能玩出什么花样。我觉得,它的应用潜力几乎是无限的,因为它触及了所有需要“界面”的地方。我随便想几个方向,你就能感受到它的威力。

教育领域:让知识“活”起来

我一直觉得,现在的很多在线教育工具还是太“死板”了。学生只能被动地看视频、做选择题。但如果有了生成式UI,情况就完全不同了。想象一个生物课的场景。老师在讲DNA双螺旋结构,这东西很抽象。学生可能会问:“老师,这个解旋复制到底是怎么回事?” 以前,老师只能找个动画片放放。现在,学生可以直接对AI说:“嘿,给我生成一个DNA模型,要可以互动的。我拖动一下,它就能开始解旋,然后显示出两条新的链是怎么合成的。”AI会立刻生成一个3D的、可交互的DNA模型界面。学生可以用鼠标拖拽、旋转,从任何角度观察。他甚至可以问:“如果这里发生一个碱基对突变,会怎么样?” AI会实时修改模型,并高亮显示出变化。知识不再是书本上静态的图画,而是可以亲手“把玩”的玩具。这种探索式的学习,效率和趣味性肯定比死记硬背高多了。

娱乐创新:一个人的“游戏开发工作室”

游戏开发是个门槛很高的事,需要策划、美术、程序一大堆人合作。很多人有好点子,但因为技术门槛被挡在了门外。生成式UI可能会改变这个局面。比如,你想做一个简单的像素风小游戏。你可以直接跟AI“口述”你的想法:“帮我创建一个横版卷轴游戏。主角是一个戴着红帽子的小人,按空格键可以跳。地面是绿色的草地,天上飘着几朵白云。随机生成一些可以踩的平台和需要躲开的怪物。”几分钟后,一个可以玩的游戏原型就出现在你面前了。你玩了一下,觉得不满意:“跳得太低了,让他跳高一点。怪物移动速度太快,减慢一半。” AI会立刻修改代码,实时更新游戏。你甚至可以自己画个怪物的草图,让AI把它变成游戏里的角色。从一个想法到一个可玩的原型,可能只需要一个下午。这对于独立开发者或者想尝试做游戏的人来说,简直是梦想成真。

企业服务:按需定制的“瑞士军刀”

在公司里,我们经常会遇到各种各样的需求。销售要看业绩报表,市场要分析活动数据,运营要监控用户留存。每个人的需求都不太一样。传统的做法是,提需求给IT部门,然后排期、开发、上线,一套流程下来,黄花菜都凉了。有了生成式UI,每个员工都可以成为自己的“工具人”。运营同学可以直接说:“我需要一个数据看板,左边显示今天的日活跃用户数和7日留存率,用大数字卡片。右边用一个折线图,展示过去30天的用户增长趋势。数据源从我们的数据库里取。”AI会生成一个专属的数据看板。如果下周需求变了,想看用户地域分布,再说一句“把右边的折线图换成中国地图,用颜色深浅表示各省用户量”,看板就立刻更新了。这种按需生成、即时修改的能力,能极大地提升企业内部的效率。每个团队都可以拥有最适合自己工作流的工具,而不是去削足适履,适应那些笨重的通用系统。

个人生产力:你的专属生活助理

我们每天都在用各种App来管理生活,日程、待办、记账、旅行规划……但每个人的习惯和需求千差万别,很难有一个App能完美满足你。要么功能太多太臃肿,要么功能太少不够用。生成式UI可以帮你打造完全个人化的工具。比如你正在计划一次旅行,你可以对AI说:“我要去云南玩10天,这是我的预算和必去景点列表。帮我生成一个旅行规划器。左边是每天的行程安排,中间是地图,标注出地点和路线,右边是预算花费记录。当我完成一项行程时,可以打勾。”一个为你这次旅行量身定做的App就诞生了。它没有多余的功能,所有的一切都完全符合你的心意。下次你计划别的旅行,又可以生成一个新的。这种“一次性”的、为特定场景而生的个人工具,可能会成为未来的新常态。

混合现实体验:打破屏幕的边界

最后,回到那个最酷的玩法:混合现实。当AI的生成能力和摄像头的感知能力结合,交互就不再局限于屏幕之内了。比如,你是个室内设计师,可以拿着手机或平板,对着空房间说:“帮我在这里放一个宜家风格的沙发,要米白色的。” 屏幕上,一个虚拟的沙发就出现在了真实的环境里,你可以走过去,绕着它看,调整大小和位置。或者,你可以在桌面上玩一个塔防游戏。摄像头识别出你的桌子、水杯、书本,把它们变成游戏里的地形和障碍物,然后AI在上面生成敌人的进攻路线和你的防御塔。你的物理世界,直接变成了游戏的画布。这种虚实结合的体验,是真正意义上的“空间计算”,也是生成式UI最具想象力的方向之一。

创意无限——当技术门槛消失后,想象力成为唯一限制

聊了这么多应用,我反复想强调的一个观点就是:现在缺的真的不是技术,而是创意。技术已经把路铺到我们脚下了,但往哪个方向走,能走多远,取决于我们的想象力。过去,我们总觉得创造是少数人的特权。你想开发一个App,得学编程;你想设计一个海报,得学PS;你想制作一个动画,得学AE。每一项创造的背后,都有一道高高的技术门槛。很多人有绝妙的想法,但就因为“我不会……”而放弃了。

非技术人员的创意实现

Gemini 3这样的工具,最大的意义就在于它把这道门槛给铲平了。它让“表达”和“实现”之间的距离,缩短到只剩一句话。你不需要懂代码,不需要懂设计,你只需要清晰地描述出你想要什么。

硬件整合的无限可能

我们再把思路打开一点。当AI能调用各种硬件之后,创意的可能性就更大了。别只盯着摄像头,想想你身边还有什么可以跟AI互动的东西。你电脑的麦克风,能不能用来做什么?比如,做一个声控的虚拟宠物,你说话声音大,它就害怕地躲起来;你轻声细语,它就凑过来跟你撒娇。或者,做一个音乐可视化工具,AI根据麦克风收到的音乐节奏和音高,实时生成千变万化的视觉特效。你电脑的触控板,除了移动光标还能干嘛?能不能定义一些手势?比如,在触控板上画一个圈,就打开一个快速笔记窗口;画一个叉,就关闭当前应用。这些在以前需要复杂软件才能实现的功能,现在可能就是一句“当我用三根手指在触控板上画一个五角星时,帮我锁定电脑屏幕”的事。甚至,它可以连接到你家里的智能家居设备。你可以对它说:“创建一个智能家居控制面板。左边是客厅灯的开关和亮度条,右边是空调的温度调节。背景设置成我家的客厅照片。” 一个完全为你家定制的遥控器就诞生了。关键在于,我们不能再用旧的思维方式去思考交互了。以前是“这个软件能做什么”,现在是“我能用这些工具组合出什么”。这是一个从被动到主动的转变。

更多应用的诞生只需要你的一个念头

能不能做一个AR试妆应用?摄像头对着你的脸,你说“给我试试Dior 999这个色号”,AI就在你的嘴唇上实时渲染出对应的颜色和质感。能不能做一个健身指导应用?摄像头看着你做深蹲,AI实时在你身体上画出骨骼线,告诉你“膝盖超过脚尖了”或者“腰背没有挺直”,并用语音提醒你。能不能做一个给孩子的AR识物卡片?打印一张普通的卡片,上面画着苹果。孩子用手机摄像头对准它,屏幕上就会跳出一个3D的苹果模型,旁边还有AI生成的文字和语音介绍:“这是苹果,富含维生素……”这些想法,在技术上已经没有不可逾越的障碍了。现在,球真的传到了我们这些有想法、有需求的人脚下。我们敢不敢想,敢不敢去尝试,这才是唯一的限制。

开发者生态变革——从编码到“描述需求”的转变

聊了这么多对普通人的影响,那对于专业的开发者,比如程序员、产品经理、设计师,这意味着什么?很多人可能会有点焦虑,觉得自己的工作要被替代了。老实说,我觉得“替代”这个词不准确,“变革”可能更合适。

新工作流展示

我们先来看看未来的工作流可能会变成什么样。以前,开发一个复杂应用,流程很长:产品经理写PRD,设计师出UI/UX稿,前端写界面,后端写逻辑,测试再来找bug……每个环节都是割裂的,沟通成本极高。现在,这个流程可能会被大大压缩。产品经理可能不再需要写几十页的文档,而是直接打开Canvas,用自然语言“画”出应用的原型。他可以说:“我需要一个用户登录页面,包含手机号和验证码输入框,一个’获取验证码’按钮和一个’登录’按钮。风格要简约一点,主色调用蓝色。”一个可交互的原型立刻就生成了。他可以马上拿去给用户测试,或者跟团队讨论。设计师看到了这个原型,觉得颜色不好看,可以直接对AI说:“把主色调换成更有科技感的深空灰,按钮做成圆角的。” 前端工程师呢?他可能不再需要从零开始写HTML/CSS,而是检查AI生成的代码,优化性能,处理一些AI搞不定的复杂交互逻辑。迭代的过程也变得飞快。以前改个按钮位置可能都要重新走一遍流程,现在就是一句话的事。整个团队围绕着一个“活”的、可以随时演进的原型来工作,而不是一堆静态的文档和设计稿。效率的提升是指数级的。

开发者角色演变

在这种新的工作流下,开发者的角色肯定会变。我觉得,会从“代码实现者”转向“需求架构师”和“系统优化师”。什么意思呢?AI擅长的是把一个明确的需求翻译成代码,但它自己并不知道什么是“好”的需求。定义需求、拆解复杂业务逻辑、设计整个系统的架构,这些事情还是得靠人。一个优秀的开发者,他的价值不再是能写多漂亮的代码,而是能多深刻地理解业务,把一个模糊的想法,转化成一套清晰、可执行、能让AI理解的指令。他就像一个乐队的指挥,AI是乐手,他负责告诉乐手们该演奏什么、怎么配合。另外,AI生成的代码不可能是完美的。它可能会有性能问题,有安全漏洞,或者在某些极端情况下会出错。这时候就需要人类开发者来“兜底”。代码审查、性能调优、安全加固、处理复杂的状态管理……这些深度的工作,AI短期内还做不好。开发者的工作会变得更“精”,更偏向于专家角色,而不是一个“码农”。

创意实现者的崛起

还有一个巨大的变化,就是“开发者”的定义被扩大了。就像我前面说的,那些懂业务、有创意的产品经理、设计师、运营,甚至任何一个普通用户,现在都有可能参与到应用的开发中来。他们可能不会写代码,但他们最懂需求。在生成式UI的帮助下,他们可以自己动手,把想法变成现实。这会催生出一个全新的群体,我愿意称他们为“创意实现者”。他们是连接“纯粹的用户”和“专业的开发者”之间的桥梁。未来的软件开发,可能不再是少数专业人士的专利,而是一种全民参与的活动。这对于整个软件行业来说,既是挑战,也是巨大的机遇。

挑战与边界——当前技术的局限性分析

说了这么多激动人心的可能性,我们也要冷静下来,看看现实。生成式UI不是万能的,它现阶段还有很多局限和挑战。作为一个产品经理,我很清楚,任何技术都不能神化,看清它的边界很重要。

复杂业务逻辑的处理限度

AI现在能很好地生成界面和简单的交互,但一旦涉及到复杂的业务逻辑,它就有点力不从心了。比如,一个电商应用的支付流程。这背后涉及到订单状态管理、库存扣减、优惠券计算、支付网关对接、异常处理、安全风控……这一整套逻辑链条非常长,而且环环相扣,错一步都不行。你很难用几句自然语言把这么复杂的逻辑描述清楚。就算你描述清楚了,AI生成的代码也很可能存在各种各.洞和考虑不周的地方。对于这种需要极高稳定性和安全性的核心业务,目前还是得靠人类工程师来精心设计和编写代码。AI可以帮你生成支付按钮的样式,但按钮按下去之后发生的事情,它还管不了。

生成一致性的维护挑战

另一个大问题是“一致性”。当你做一个稍微复杂点的应用时,它会包含很多个页面和组件。你需要保证这些页面在风格、布局、交互上都是统一的。比如,所有按钮的样式都一样,所有弹窗的关闭逻辑都一样。在多轮对话和迭代中,AI有时候会“忘事”。你第一轮让它生成了一个蓝色主题的页面,第二轮你让它加个新功能,它可能就忘了你之前的主题色,给你生成一个绿色的按钮。或者,你在A页面定义了一个交互,到了B页面,它又用了另一种交互。这种“风格漂移”的问题,在目前的生成式模型中还普遍存在。要维护一个项目级的、长期的一致性,还是需要人类设计师和开发者来建立和维护一套设计规范(Design System)和组件库。AI可以作为填充内容的工具,但整个框架的“骨架”和“规则”,还得人来定。

创意实现的边界

虽然我前面一直在说“想象力是唯一的限制”,但我们也要承认,有些创意,AI是无法理解和实现的。AI的“创意”本质上是对已有数据的学习和重组,它很难做出真正“从0到1”的、颠覆性的创新。比如,一种全新的、前所未有的交互范式。当年iPhone的多点触控,就是一种颠覆性的创造。这种级别的创意,来自于人对物理世界、对心理学的深刻洞察,而不是对数据的分析。AI可以帮你优化一个已有的交互,但很难发明一个全新的交互。另外,涉及到深刻情感表达、文化内涵、艺术哲思的场景,AI也只能做到“形似”而无法“神似”。它可以生成一个看起来很悲伤的界面,但这种悲伤是符号化的,是它从数据里学来的“悲伤模板”,而不是真正的情感共鸣。在这些需要人类深度参与的领域,AI更多的是一个辅助工具,而不是主导者。 所以,我们既要拥抱AI带来的效率提升,也要清醒地认识到,人类的逻辑、审美和原创能力,在可预见的未来里,依然是不可替代的核心价值。

未来演进路径——全民创造时代的到来

这是我最期待的一点,也是前面反复提到的。当技术门槛被无限降低,当每个人都能用最自然的方式去创造工具和内容时,一个“全民创造”的时代就可能到来。今天,我们说一个人“会上网”,指的是他会使用浏览器、会用搜索引擎、会玩社交媒体。未来,说一个人“会上网”,可能指的是他能根据自己的需求,随手生成一个App或一个AR体验。创造,会像今天我们发一条朋友圈一样简单和普遍。这不仅仅是生产力的解放,更是一种文化现象。它会极大地激发整个社会的创新活力。无数个体的、小众的、个性化的需求会被满足。我们使用的工具,将不再是少数大公司提供的标准化产品,而是由我们自己和身边的人创造的、丰富多彩的、充满个性的作品。这可能才是生成式UI带来的最深远的影响。

结论——人机共创的新纪元

聊到这里,我们似乎绕了一大圈,从一个具体的demo,聊到技术、应用,再到未来。但我想回到最初的那个点:我们与机器的关系正在发生根本性的改变。过去,我们是机器的“使用者”。我们学习它的规则,适应它的逻辑。我们是主,它是仆,但有时候,我们更像是被工具束缚的仆人。现在,我们正在进入一个“人机共创”的新纪元。机器不再是冰冷的工具,而是一个有“灵性”的合作伙伴。它能理解我们的意图,激发我们的灵感,补全我们的能力。我们和它的关系,变得更像是舞伴,你进一步,我退一步,共同完成一支优美的舞蹈。在这个新纪元里,技术的价值不再是替代人,而是赋能人。它把我们从繁琐、重复的执行工作中解放出来,让我们能专注于更重要的事情:思考、创意、情感和连接。最终,技术是中立的,它是一面镜子,照见的是我们自己的想象力。Gemini 3和它所代表的生成式UI,为我们打开了一扇通往未来的窗。窗外的风景究竟有多美,取决于我们敢不敢推开它,走出去,去探索,去创造。

本文由 @进化之家BRN 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Pixabay,基于CC0协议

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益