语音助手的进化:从级联“工具链”到端到端“原生脑”

AI语音助手正经历一场从技术架构到交互逻辑的深度变革。从多模态互通到端到端模型,新一代的System Agent正在打破应用孤岛,实现全场景智能服务。本文将剖析语音助手如何从‘传声筒’进化为‘原生脑’,并揭示系统级AI管家如何重构人机交互信任。

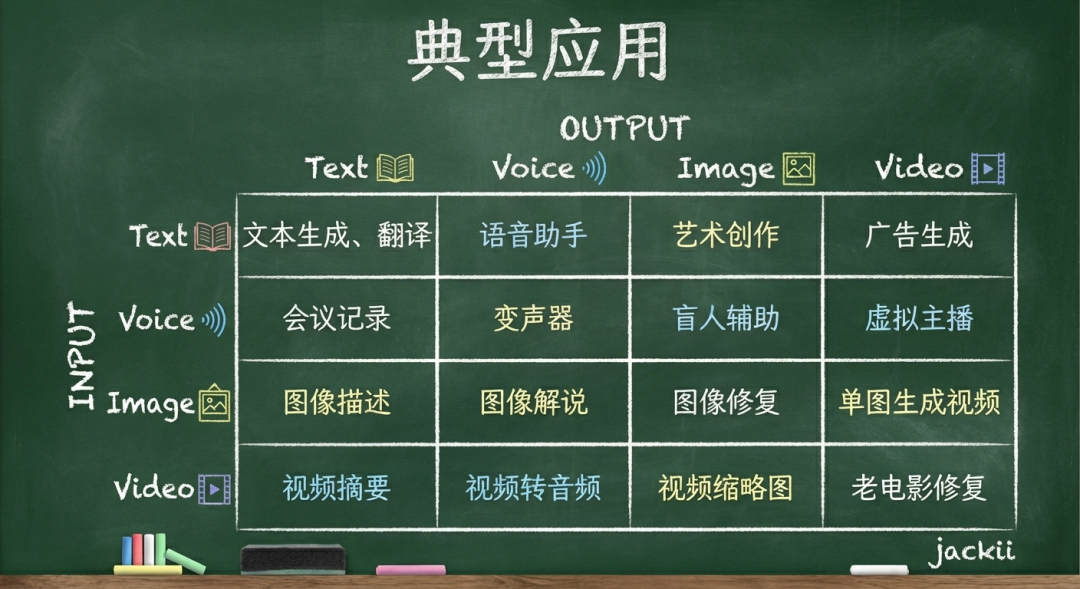

1. 多模态互通矩阵

模态不仅是信息的载体(文本、音频、图像、视频),更是信息维度的容器。在AI视角下,它们是可以相互转化的数据流,有着丰富的落地应用场景。

2. 从“传声筒”到“原生脑”

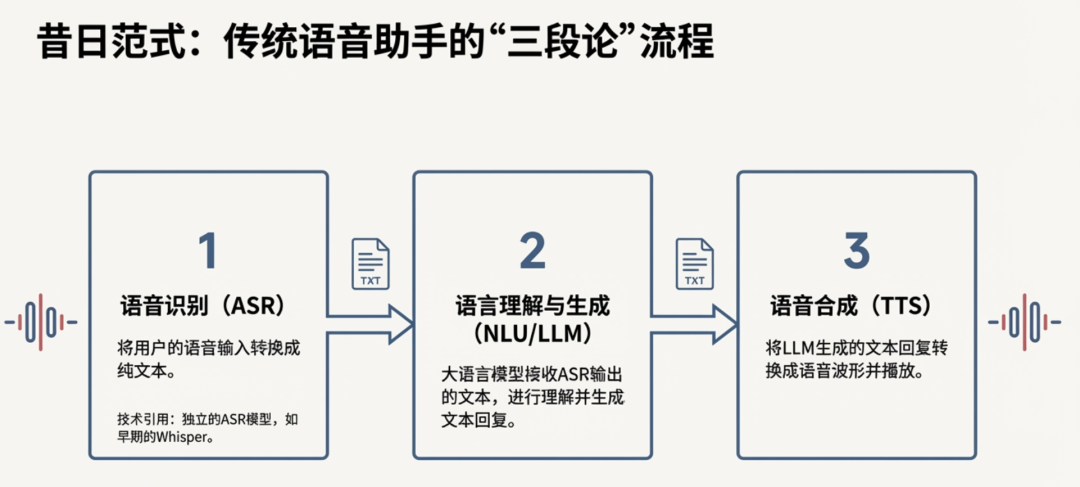

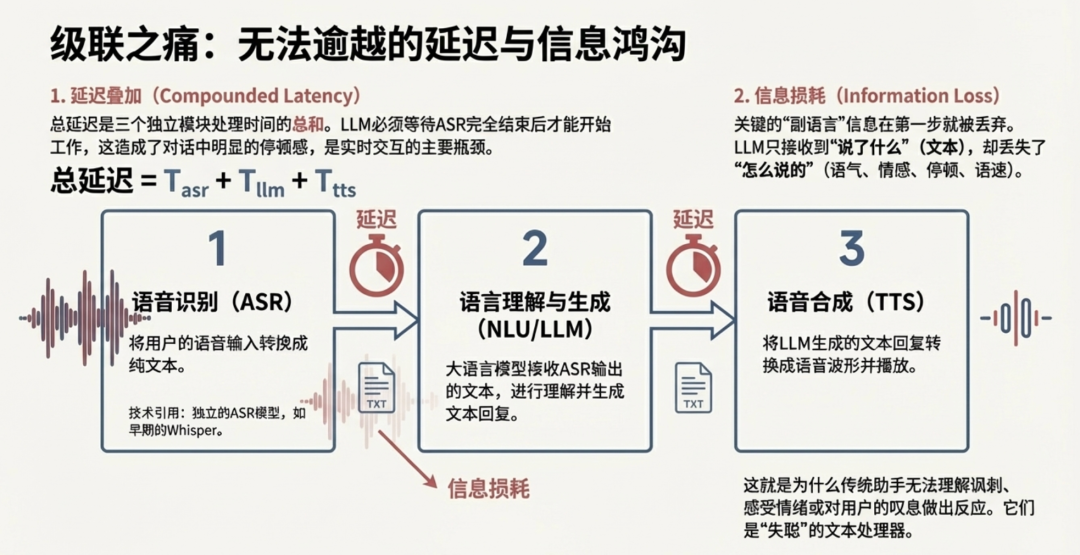

2.1传统架构:级联式 —— “信息的传声筒”

原理:类似一个接力赛:ASR (耳朵)➔LLM (大脑)➔TTS (嘴巴)。

致命缺陷:信息损耗

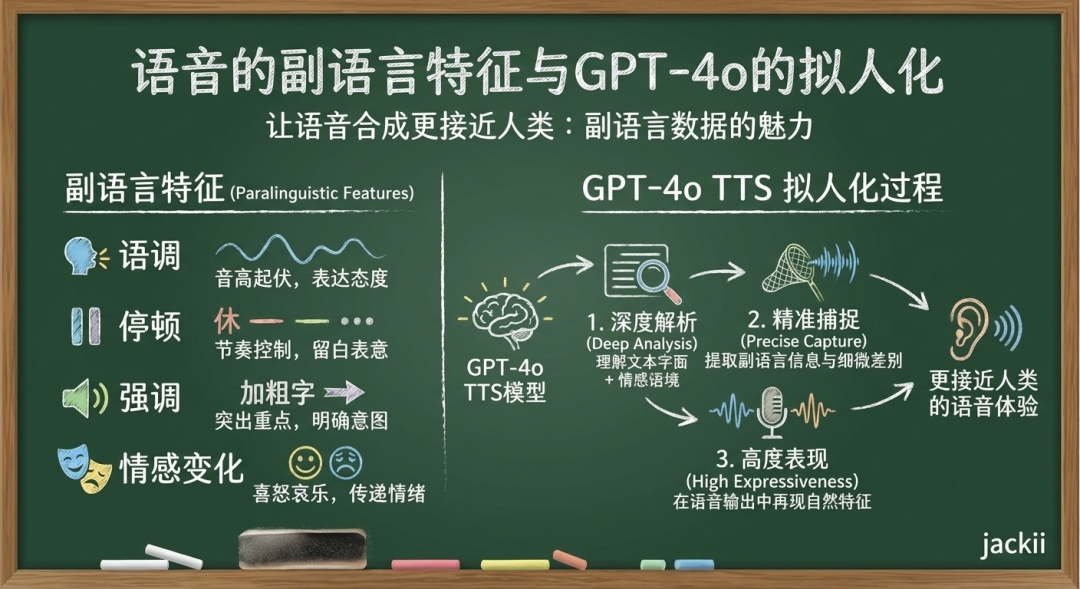

- 降维打击:声音包含[内容 + 身份 + 情绪 + 环境]副语言信息,而ASR将其强行压缩为[内容](Text)。

- 举例:用户用颤抖的声音说“我没事”,ASR转成文字“我没事”,LLM理解为“他很好”,TTS用开心的语调播报“那太好了”。——这就是人工智障的来源。

- 延时痛点:每一步都要等待上一步完成,造成2-5秒的交互延迟。

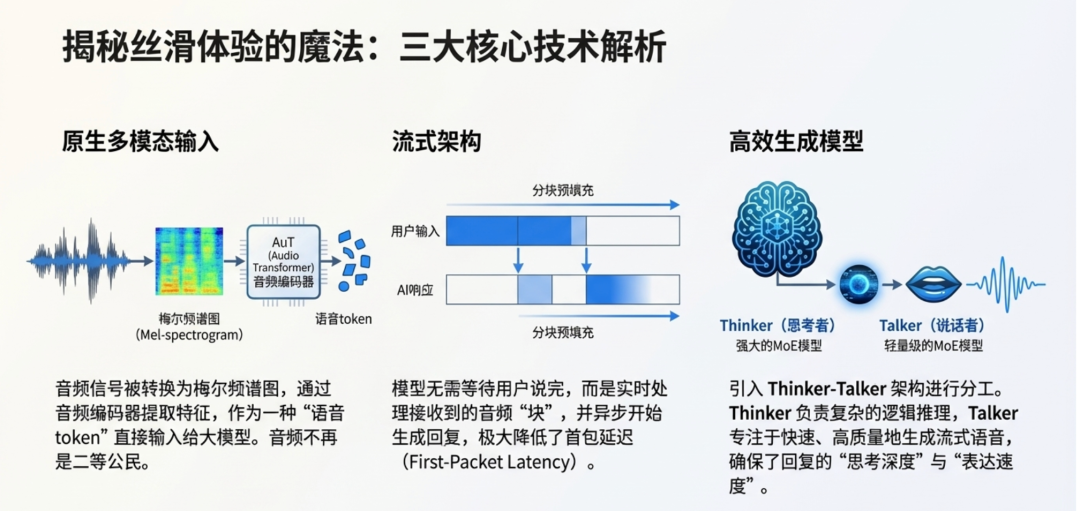

2.2进化架构:端到端 (E2E) —— “直觉反应”

原理:Audio In➔Model➔Audio Out。

核心变革:

- Tokenization:声音直接被切分成 Token 进入模型,保留了副语言特征 (Paralinguistics)。

- 模态对齐:模型直接“听懂”了笑声、叹气和犹豫。

3.语音助手场景评估

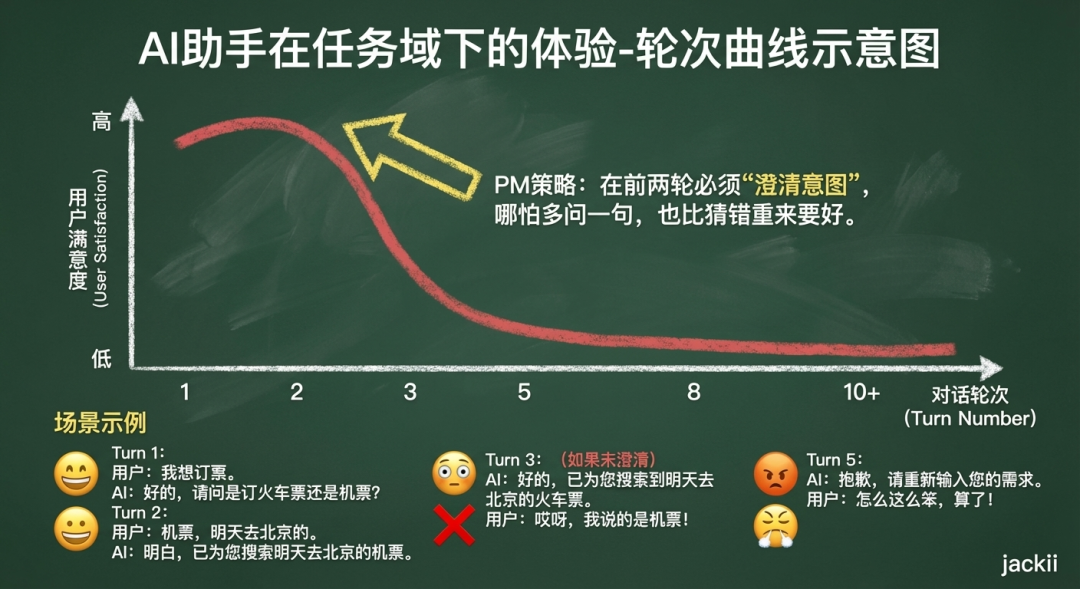

3.1 场景差异化:任务域 vs. 闲聊域

任务域:效率至上

- 核心目标:用最少的轮次解决问题。

- 关键指标:任务完成率。

- 交互代价:用户为了达成目标所付出的时间与认知成本。

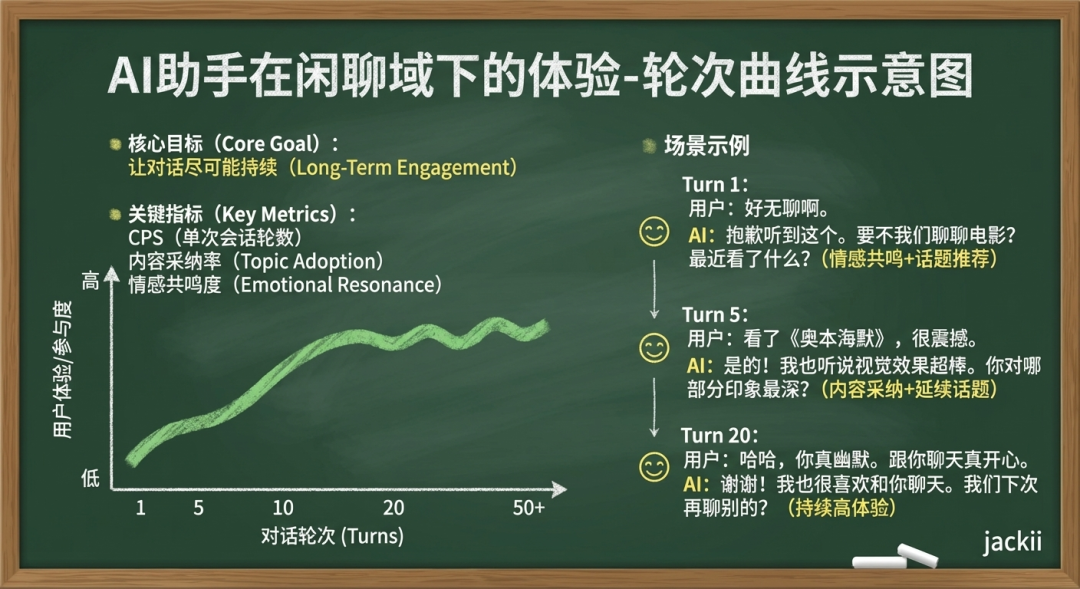

闲聊域:连接至上

核心目标:让对话尽可能持续 (Long-Term Engagement)。

关键指标:

- CPS (Conversation Turns Per Session):单次会话轮数。

- 内容采纳率:AI 推荐的话题或建议,用户是否接茬。

- 情感共鸣度:用户是否在对话中表现出正向情绪变化。

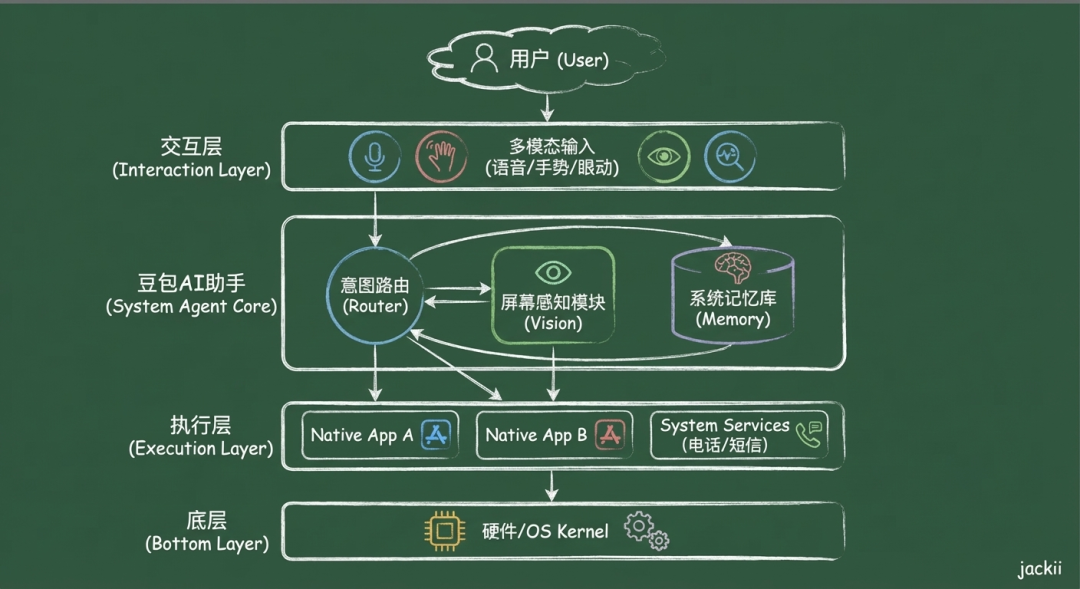

4.从 App Agent 到 System Agent

最新的豆包 AI 手机不仅是装了一个 App,而是将 Agent 下沉到了 OS 系层,打破“应用孤岛”。

体验购买豆包手机助手技术预览版:https://o.doubao.com/

App Agent (应用层):只能在自己 App 里聊天,无法操作微信发消息,无法读取美团的订单。

System Agent (系统层):

- 全屏幕感知:能“看见”你屏幕上正显示的打车页面。

- 跨应用执行 :能够调动系统 API,跨越 App 边界。

- 记忆总线:记住你在小红书看过的攻略,并在携程里帮你规划行程

5. 结语

从丢失情绪的文字转化,到听懂弦外之音的端到端模型;

从被困在App里的聊天机器人,到掌管手机的系统级管家;

AI 语音助手终于不再是“助手”,而开始成为真正的“分身”;

这不仅是技术栈的重构,更是对“人机交互信任”的重新定义。

本文由 @杰克说AI 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

评论

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益