告别API焦虑!零代码本地部署:Dify.AI + Ollama + Qwen2,打造你的专属AI智能体

数据安全、成本控制与专业内容创作的三大痛点困扰着每一位产品经理。本文揭秘一套完全免费、本地私有化的AI解决方案,通过Docker+Dify+Ollama的黄金组合,1小时内打造专属写作智能体。从极简部署到知识库搭建,手把手教你突破商用AI的局限,让垂直领域创作从此游刃有余。

产品经理如何用免费开源工具,构建自己的专业内容创作智能体

前言:为什么需要本地私有化AI?

作为产品经理,我们在撰写产品方案、项目文档、行业分析时,经常面临三大痛点:

1. 数据安全顾虑:企业内部文档、项目细节涉及敏感信息,不敢直接传给云端AI

2. 成本控制压力:GPT-4、Claude等商用模型API费用不菲,长期使用成本高企

3. 内容专业度要求:通用AI难以理解企业信息化、ERP、数智化等垂直领域知识

今天分享一套完全免费、本地私有化、零代码的解决方案,让你在1小时内搭建专属AI写作工作台。

先说个实话:如果你只是想快速体验本地大模型,其实有个更简单的方案——直接安装Ollama就行。

下载安装Ollama,ollama pull qwen2:7b,然后ollama run qwen2:7b,就能在命令行里对话了。这个方案5分钟搞定,没有Docker、没有Dify,就是一个纯粹的本地模型调用工具。

但为什么我还是推荐你花点时间把Docker和Dify.AI也装上?因为它们能解决的问题,Ollama做不到。

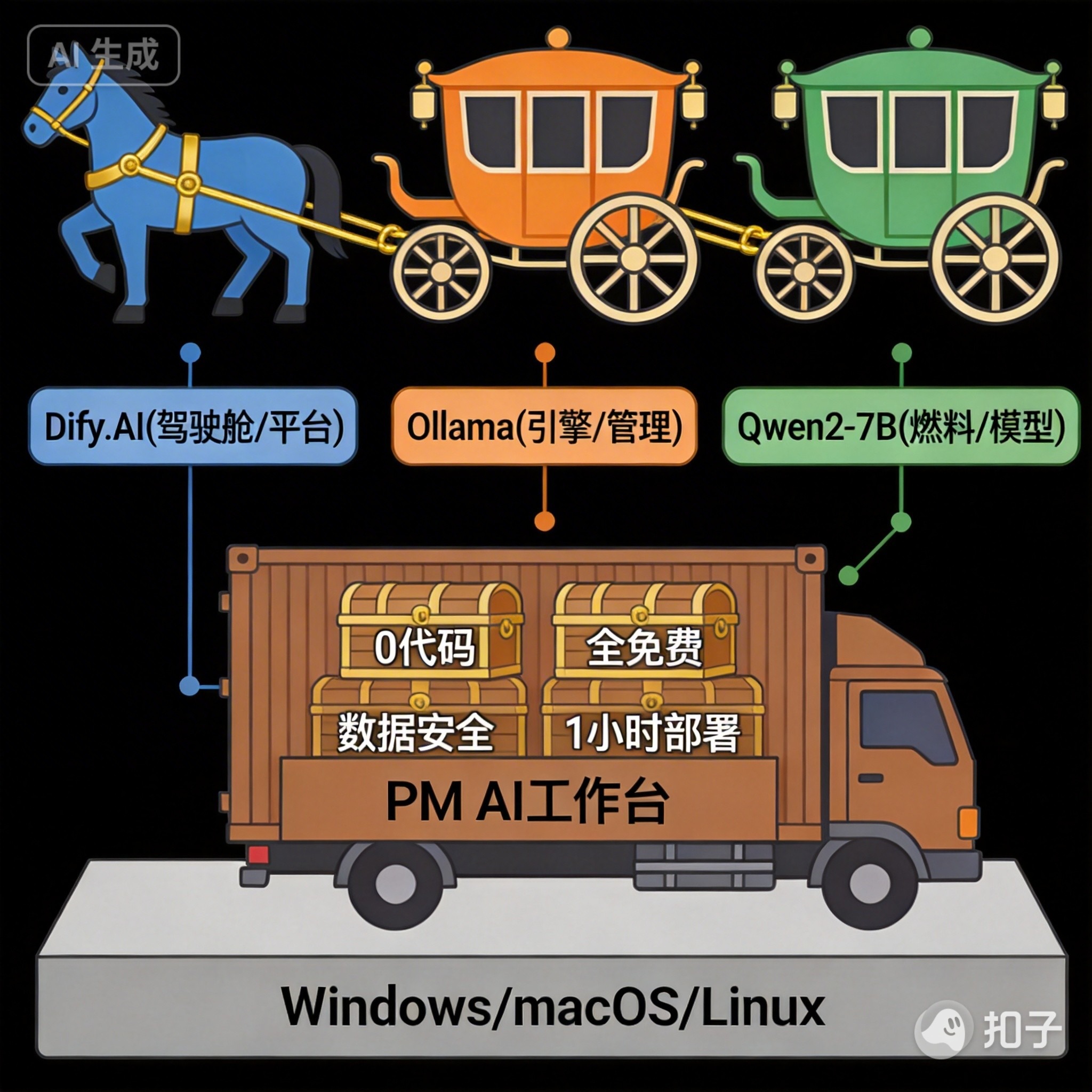

一、核心方案架构

我们采用”三驾马车”组合,每个都经过实战验证:

整体优势:

0代码部署,产品经理也能轻松上手

全程本地运行,数据零外泄

三大组件全免费,无任何隐性成本

支持Windows/macOS/Linux,推荐桌面版体验

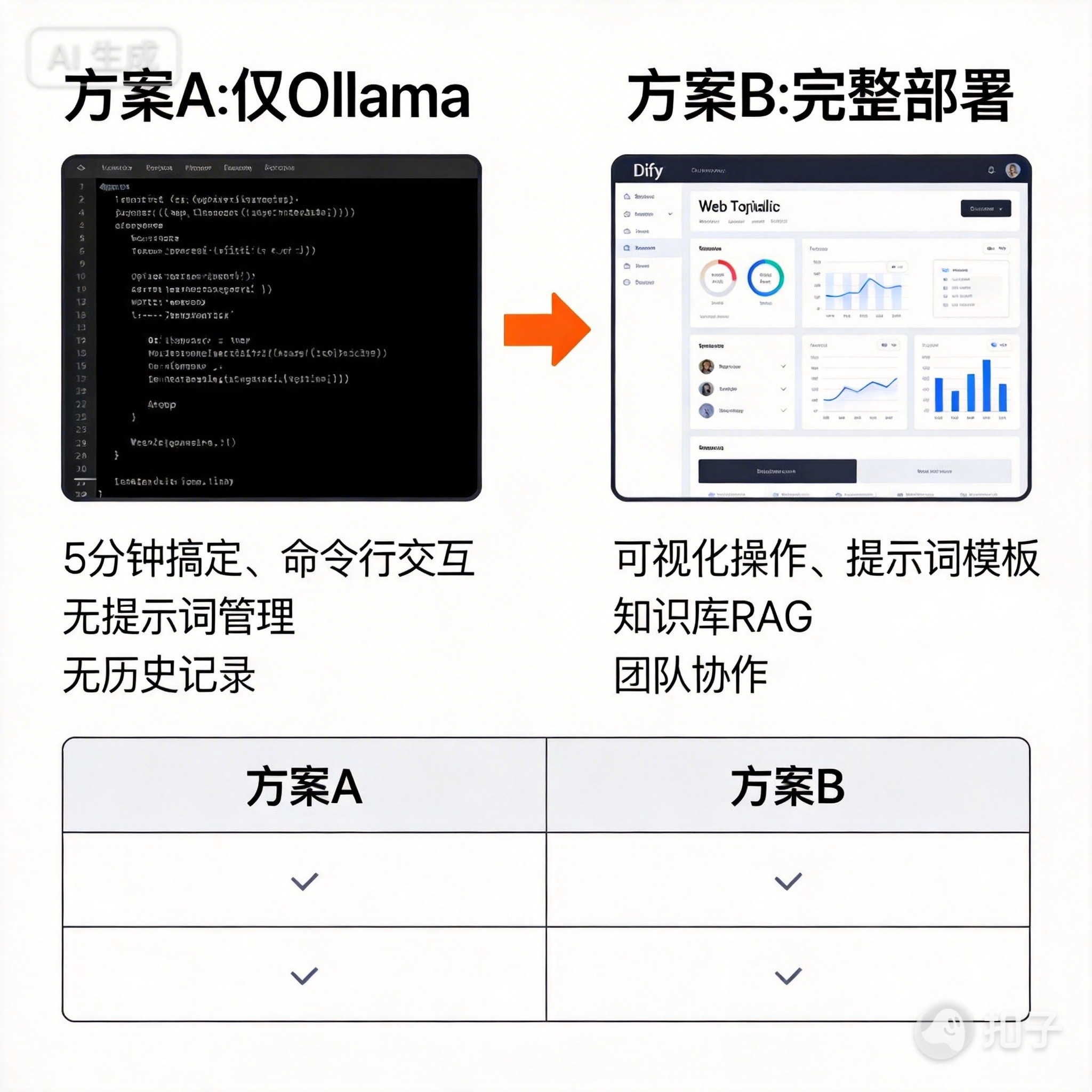

二、方案选择:直接用Ollama vs 完整部署

先把这个说清楚,避免你走弯路。

方案A:只装Ollama(极简方案)

适用场景:

只是想快速体验本地大模型

临时需要AI帮忙写点东西

对命令行不排斥

操作步骤:

// bash

#

1. 安装Ollama(5分钟)

# 下载:https://ollama.com/

#

2. 拉取模型(2-5分钟) ollama pull qwen2:7b

#

3. 开始对话 ollama run qwen2:7b

优点:

5分钟搞定,没有学习成本

不需要Docker,不占用额外资源

纯净,就是模型调用

缺点:

命令行交互,体验一般

没有提示词管理,每次都要重新输入

没有历史记录,对话完就没了

没法上传文档构建知识库

不方便分享给别人用

我的判断:如果你只是偶尔用用,这个方案足够了。但如果打算长期用、深度用,建议往下看。

方案B:完整部署(推荐方案)

为什么推荐:

1. 可视化交互

Dify提供Web界面,不用记命令,浏览器打开就能用,和用ChatGPT体验差不多。

2. 提示词模板化

你可以把常用的Prompt保存成模板,比如”PRD模板”、”竞品分析模板”,点一下就能用。不用每次重新输入。

3. 知识库能力(RAG)

这是关键。你可以上传公司文档、产品手册、历史PRD,AI会检索这些内容再回答。相当于给AI”喂”了你们公司的知识库,输出更贴合实际。

4. 多应用管理

可以创建多个应用:一个写PRD、一个写竞品分析、一个写周报。每个应用有独立的提示词和配置,互不干扰。

5. 协作分享

生成链接分享给团队成员,大家都能用。特别是你搭建好一个专业助手后,其他人也能复用,避免重复造轮子。

6. 工作流编排

Dify支持工作流,可以编排复杂任务:比如”检索资料→生成大纲→撰写内容→格式化输出”,一键完成。

额外成本:

Docker:约3-5GB磁盘空间

学习时间:额外40分钟(主要是配置)

我的建议:

如果你是产品经理,打算用AI提升日常工作效率,方案B worth it。一次部署,长期受益。

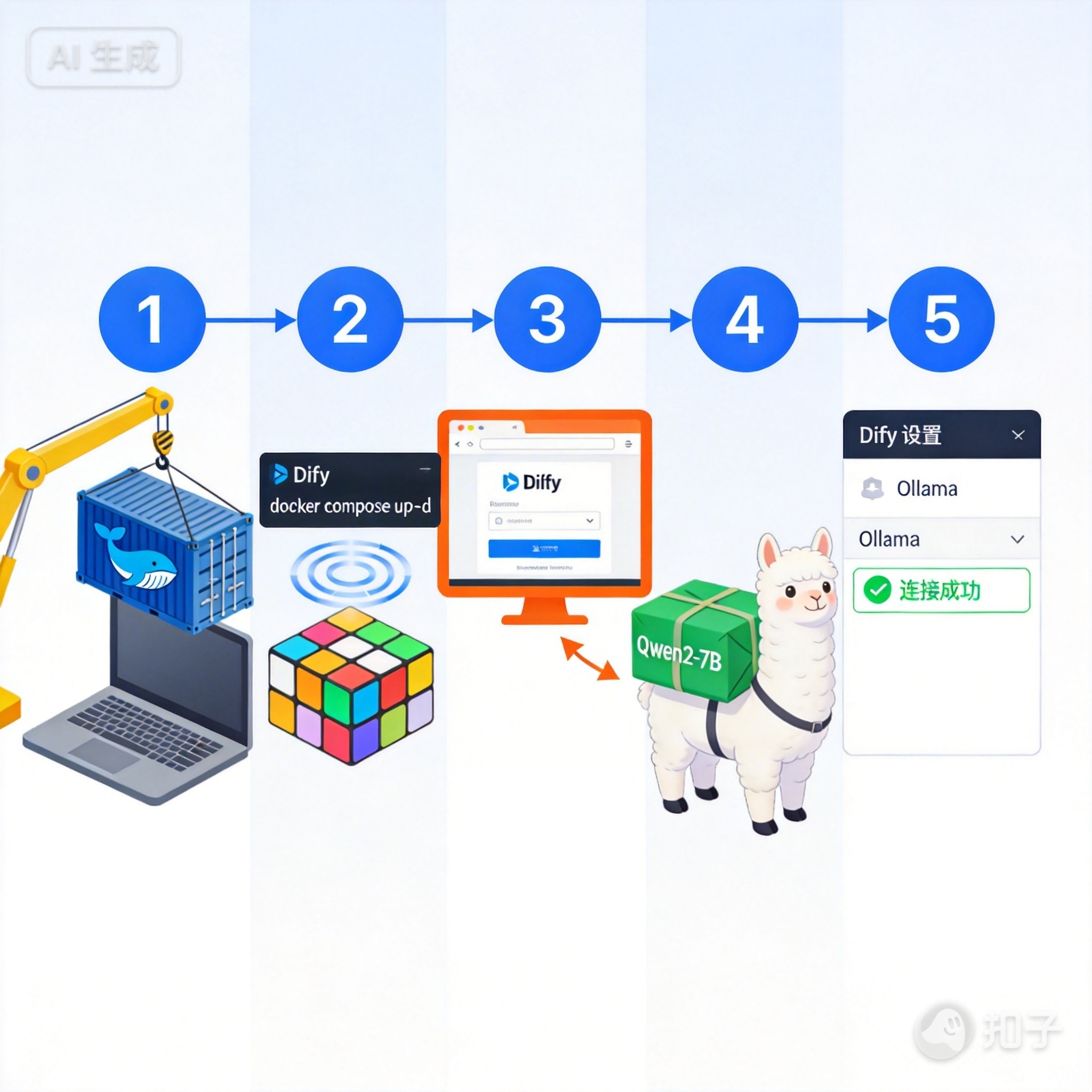

三、部署实战(5步完成)

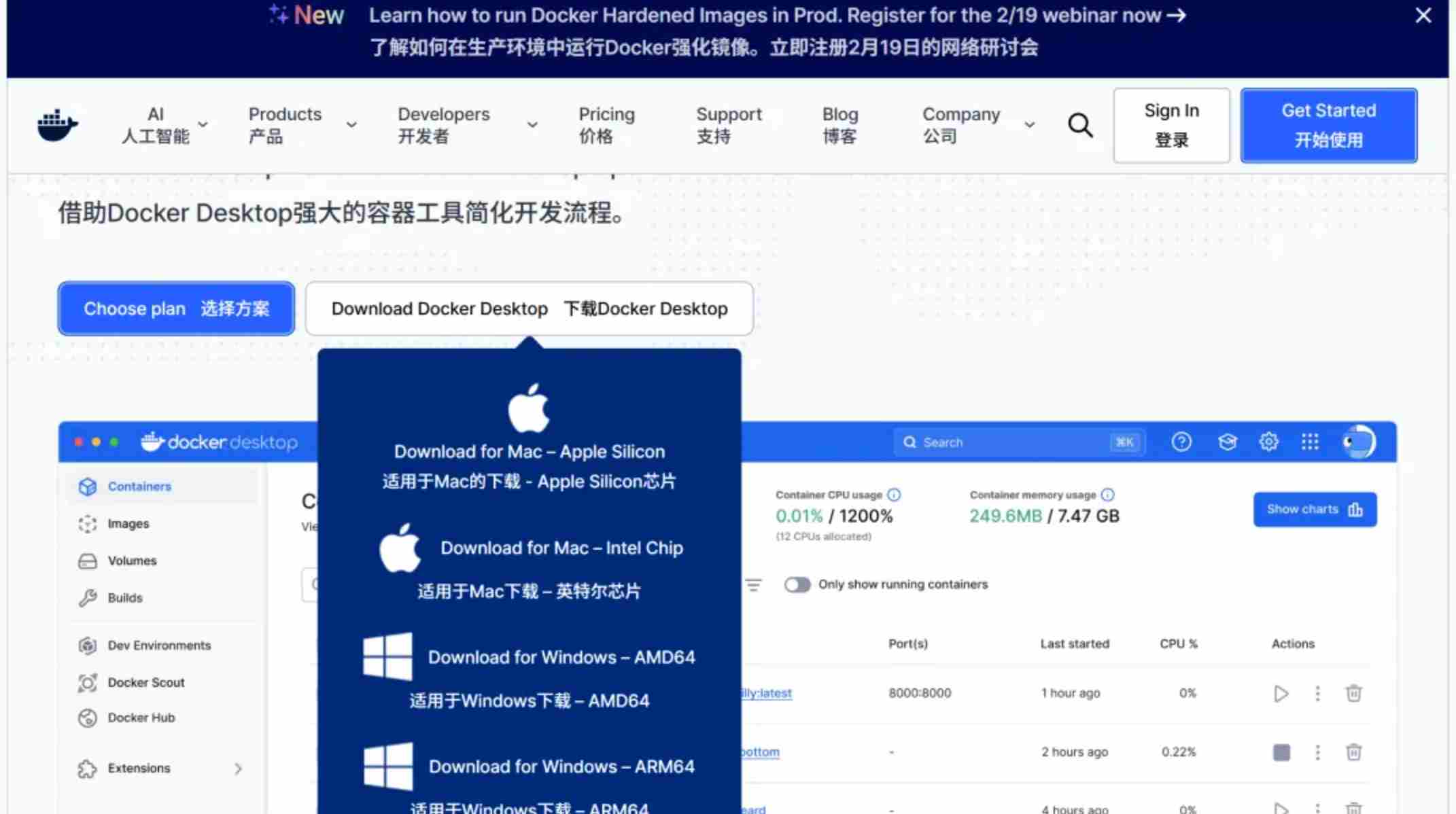

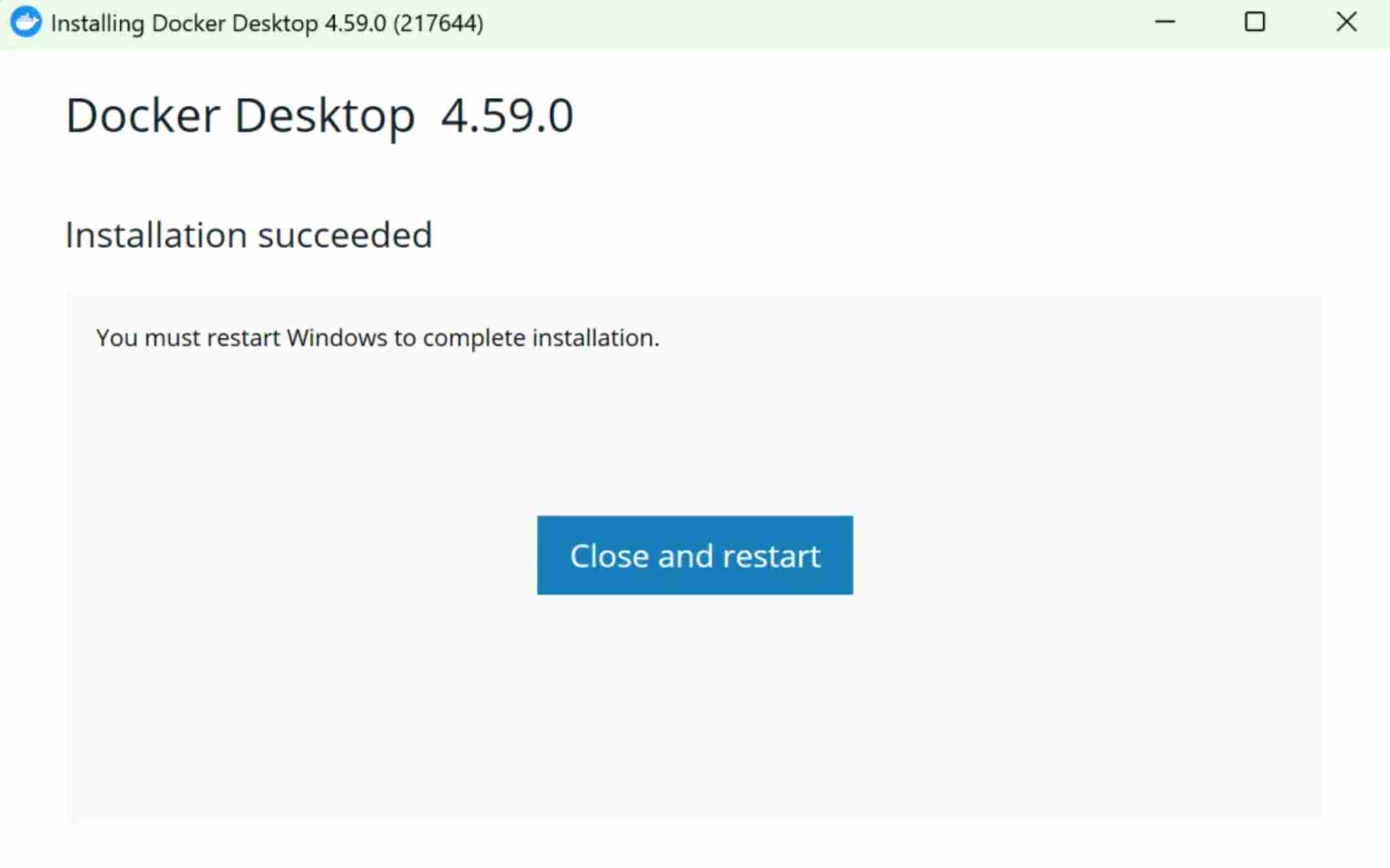

第一步:安装Docker(基础设施)

Docker是容器化技术,让部署像安装软件一样简单。

下载安装:

官网:https://www.docker.com/products/docker-desktop/

Windows用户需先开启WSL2功能

双击安装包,一路”下一步”即可

验证安装:

打开终端(CMD/PowerShell),执行:

// bash docker –version docker compose version

出现版本号说明安装成功。

第二步:本地部署Dify.AI

这部分的时间会比较长,主要是下载相关文件较久。

1. 克隆Dify代码

// bash git clone https://github.com/langgenius/dify.git cd dify/docker

2. 配置环境变量

// bash cp .env.example .env

用记事本打开.env文件,修改两项关键配置:

数据库密码(改成强密码)

POSTGRES_PASSWORD=your_strong_password

Web端口(默认80,如冲突可改为8080)

NGINX_HTTP_PORT=80

3. 启动服务

// bash docker compose up -d

首次启动会下载镜像(约3-5GB),耐心等待5-10分钟。

4. 访问初始化

浏览器打开:http://localhost:80

按提示创建管理员账号

登录后进入Dify控制台

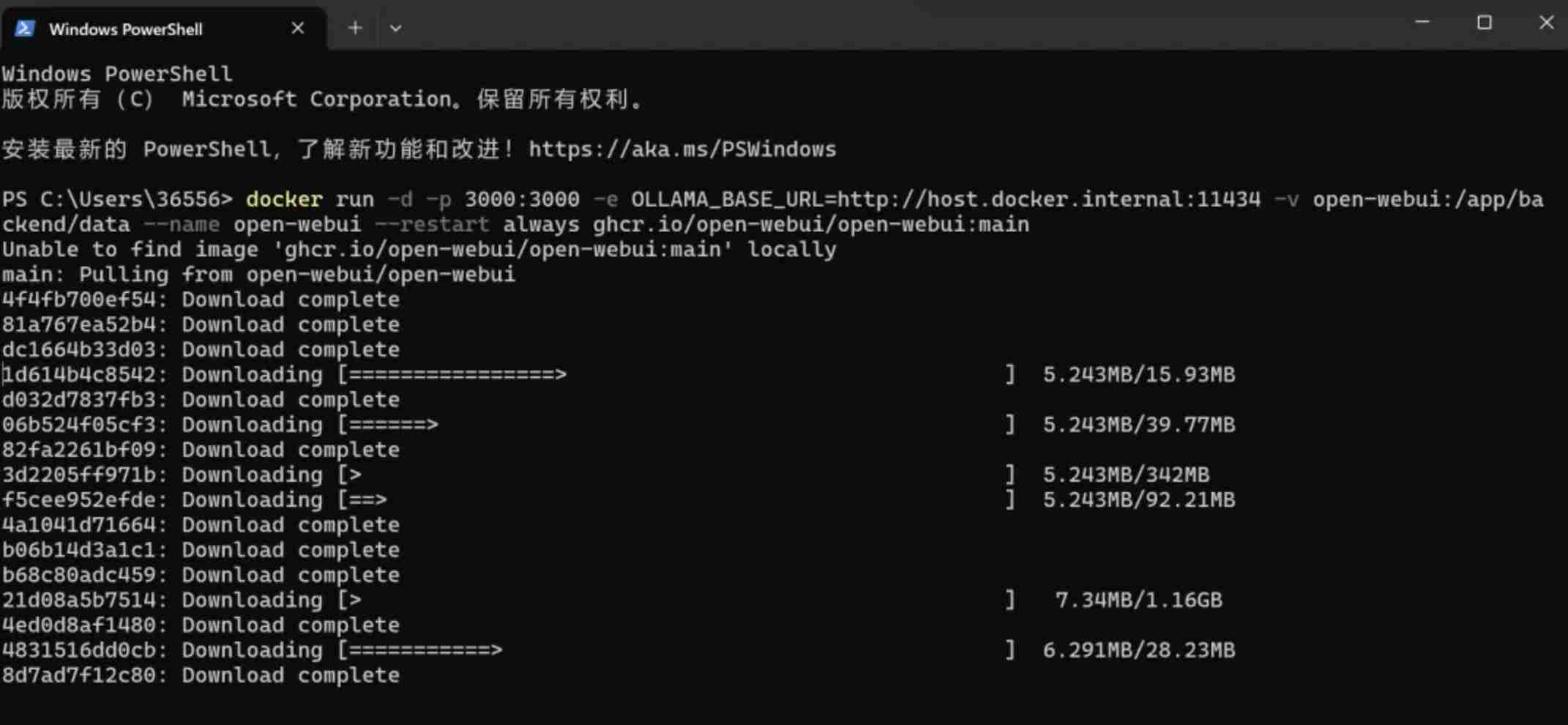

第三步:安装Ollama并加载模型

1.下载Ollama

官网:https://ollama.com/

双击安装包,默认路径安装

2. 验证安装

// bash ollama –version

3. 拉取Qwen2-7B模型

// bash ollama pull qwen2:7b

模型约4GB,下载后自动启动服务。

4. 测试运行

// bash ollama run qwen2:7b

进入对话模式,输入/bye退出。

第四步:Dify对接Ollama

1. 安装Ollama插件

Dify控制台 → 左侧「插件」→「探索Marketplace」→ 搜索「Ollama」→ 安装

2. 配置模型供应商

右上角头像 →「设置」→「模型供应商」→「Ollama」→「添加模型」

填写关键参数:

模型名称:qwen2:7b

基础URL:http://host.docker.internal:11434

模型类型:对话

上下文长度:4096

最大Token:4096

3. 测试连接

点击「测试连接」,显示「成功」即完成对接。

第五步:创建专业内容创作智能体

1. 新建对话型应用

Dify控制台 →「应用」→「创建应用」→ 选择「对话型应用」

名称:专业内容创作助手

2. 配置系统提示词

在「系统提示词」中粘贴:

你是一位资深产品经理,擅长撰写产品经理、AI、企业数智化、信息化领域的专业文章。

要求:

- 结构清晰:标题+摘要+分点论述+案例+总结

- 风格专业:逻辑严谨、数据准确、语言精炼

- 适配平台:公众号(吸睛标题+排版)、知乎(深度拆解)、人人都是产品经理(实战导向)

- 融入案例:结合企业信息化、ERP、数智化落地实战经验

- 避免AI味:自然流畅、符合资深PM视角

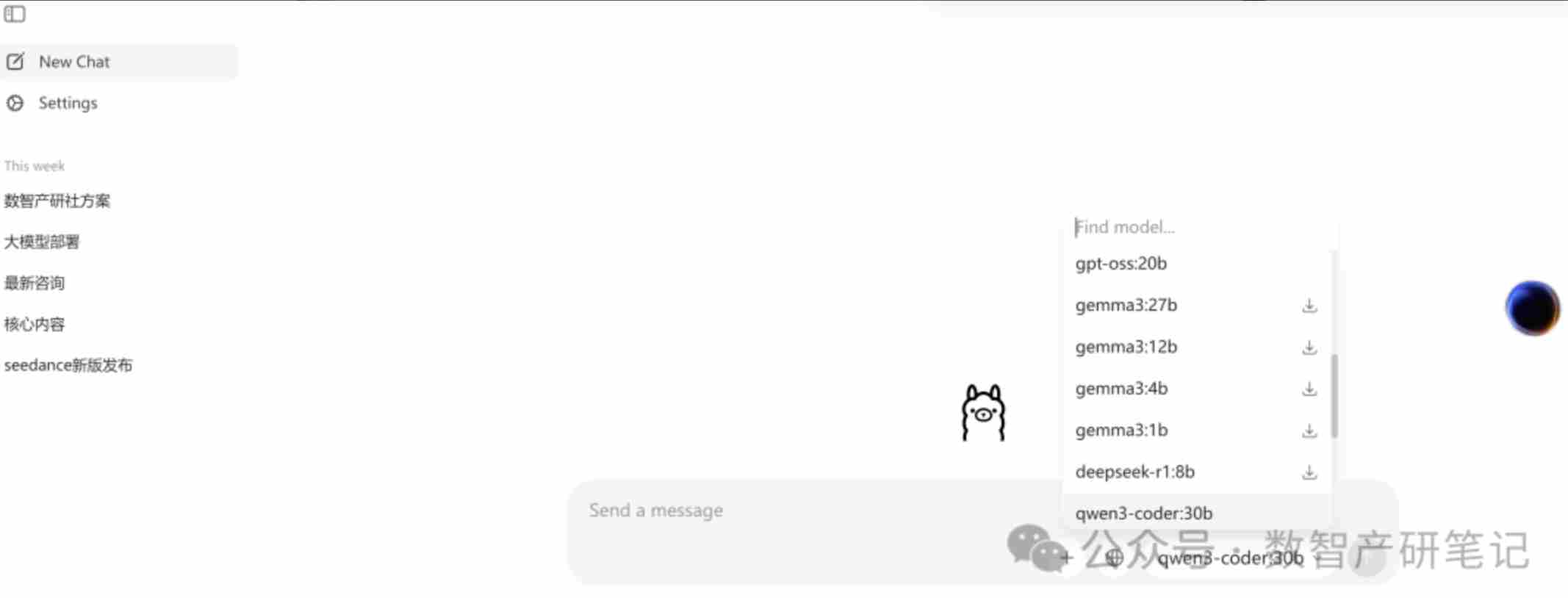

3.选择模型

模型:qwen2:7b

温度:0.7(平衡创意与严谨)

4. 发布使用

点击「发布」→ 生成访问链接,开始创作!

四、应用实战

输入指令示例:

“写一篇《产品经理如何落地企业数智化项目》,适配公众号风格”

AI输出结构化内容:

吸睛标题:《从0到1:产品经理如何落地企业数智化项目(附实战清单)》

摘要:200字核心观点

正文:分5个章节(现状分析、方法论、实施步骤、避坑指南、案例复盘)

总结:3条关键洞察

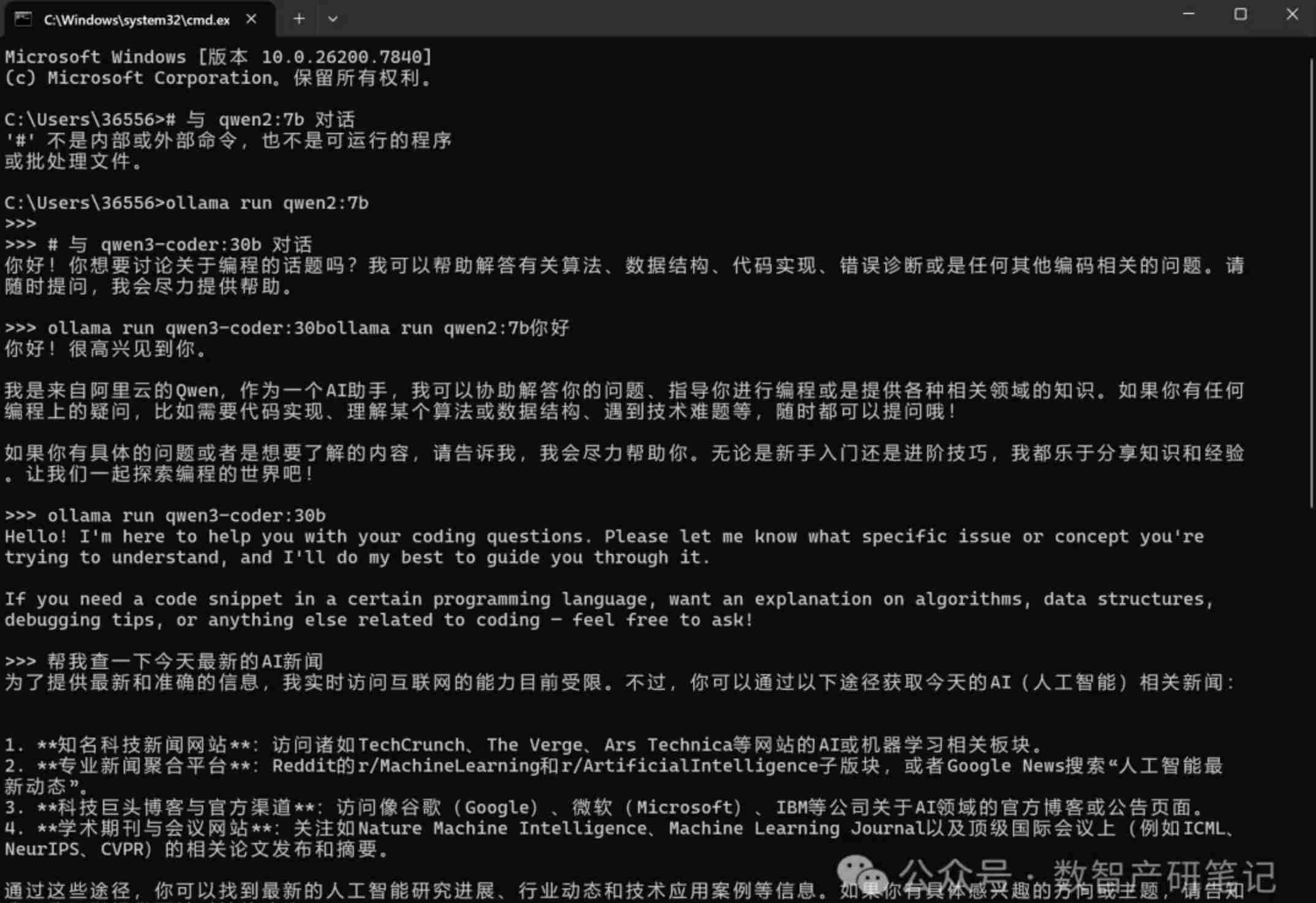

验证大模型为本地模型,Ollama也可以用powershell访问:

五、高级PM落地要点

1. MVP思维

先完成基础创作功能,验证效果后再扩展知识库、多平台适配。

2. 数据安全优先

全程本地部署,企业敏感文档可上传至Dify知识库,实现RAG增强,数据不经过任何第三方服务器。

3. 成本控制

当前方案零成本,后续如需更强性能,可接入GPT、DeepSeek、千问等模型,依然本地运行,无API费用。

我在本地部署、嵌入了3个大模型gpt-oss:20b,qwen3-coder:30b和qwen2:7b。

4. 可扩展性

添加企业知识库:上传PDF/Word/Excel文档,构建专属知识库

多模型切换:不同场景用不同模型(创作用Qwen2,代码用DeepSeek-Coder)

工作流编排:Dify支持复杂工作流,可实现”检索-创作-校对-发布”自动化

六、部署避坑提示

说个我踩过的坑,你别踩。

部署过程中,我一度以为Docker和Dify没装好,因为访问localhost没反应。折腾半天后发现其实已经部署成功了,只是我没注意到登录入口在80端口。

然后参考多方智能工具的答疑与指引把所有容器都删了重新来——完全没必要。

给你的建议:

1. 耐心等待:docker compose up -d后,等5-10分钟再访问,首次启动下载镜像需要时间

2. 检查端口:默认80端口,如果被占用记得改.env里的配置

3. 看日志:如果访问不了,执行docker compose logs看报错信息

4. 不要急着删:容器启动失败通常是配置问题,不是部署失败,先排查原因

如果实在折腾不动怎么办?

那就先用Ollama方案,至少能快速用起来。等有时间再慢慢折腾Dify,不急。

七、关键资源汇总

Dify官方资源

官网:https://dify.ai/

开源仓库:https://github.com/langgenius/dify

部署文档:https://docs.dify.ai/getting-started/install-self-hosted/docker-compose

Ollama官方资源

官网:https://ollama.com/

模型库:https://ollama.com/library

Qwen2官方资源

模型页面:https://ollama.com/library/qwen2

阿里通义千问:https://tongyi.aliyun.com/qianwen/

写在最后

这套方案的真正价值不在于”免费”,而在于让产品经理拥有了可控的AI能力。

当你能本地化部署、自定义提示词、管理企业知识库时,AI就不再是一个简单的对话工具,而是真正融入你工作流的生产力引擎。

如果你在部署过程中遇到问题,欢迎在评论区交流,我会一一解答。

关注我,每周分享产品经理实战干货、AI 落地技巧、数智化前沿玩法,带你用最低成本搭建专属生产力工具!

本文由 @数智产研笔记 原创发布于人人都是产品经理。未经许可,禁止转载。

题图来自Unsplash,基于 CC0 协议

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益