AI原生数据湖仓赋能司库:年降千万成本,拦亿级风险

数据湖仓正成为企业数据架构的新范式,它将数据湖的灵活性与数据仓库的强大分析能力深度融合。本文深度剖析数据湖仓的核心架构与独特优势,揭示其如何在多模态数据处理、实时分析与非结构化数据挖掘等场景中突破传统数据存储的边界,为企业带来前所未有的数据价值释放。

一、数据湖仓概念

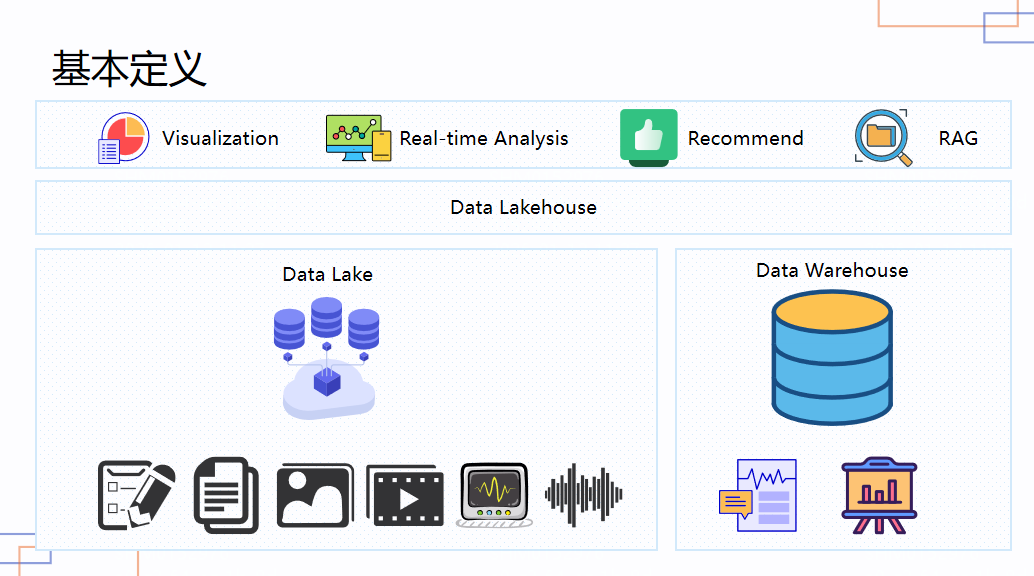

1.1 基本定义

数据湖仓,简单而言,是数据湖和数据仓库合二为一的新词汇,2020年首次提出湖仓一体(Lakehouse)概念,融合了数据仓库与数据湖优势的开放式架构。湖仓一体也就是本文所定义的数据湖仓的概念。

数据湖,其实是一类存储数据自然/原始格式的系统或存储,通常是对象块或者文件,是企业中全量数据的单一存储,涵盖原始数据拷贝和各类转换后的数据。

说白了,数据湖就是把企业所有的数据,不管从哪个系统来(比如ERP、CRM、小程序后台、IoT设备),什么格式(表格里的数字、文档、图片、视频、日志),都存起来,并且不着急整理,先保持最原始的样子。

这也是数据湖最核心的价值:保留数据的全部可能性。目前比较常见的数据湖Lake Formation、Azure Data Lake、Google Cloud Data Lake、FineDataLink(FDL)等。

数据仓库(Data Warehouse,DW),大家其实也不陌生,是一个面向主题、集成、非易失、随时间变化的结构化数据存储系统,核心目标是整合企业分散在不同业务系统中的数据,为管理层提供决策支持分析的统一数据基础。

它并非用来处理实时交易(如订单支付、用户注册),而是聚焦历史数据的存储、清洗、整合与分析,帮助企业从海量数据中挖掘商业价值。

常见的大数据平台例如:Hadoop、Spark、Flink、Storm、Kafka、Elasticsearch、MongoDB、Cassandra、HBase和Google BigQuery等

而数据湖仓,是结合了数据湖和数据仓库的特别,在开放存储格式(Delta Lake/Iceberg/Hudi)基础上,融合数据仓库管理能力与数据湖灵活性的新架构。

1.2 与传统数据存储区别

数据湖、数据仓库,以及融合两者的湖仓一体架构,其核心差异在于设计哲学。传统数据仓库如同一个精心归档的图书馆,而数据湖则像一个原始的蓄水池,湖仓一体则是在水池上搭建了高效加工厂。它们在现代企业,特别是财务司库这类要求严格的场景中,扮演着不同角色。

1.2.1 存储架构差异:从 “封闭分层” 到 “开放融合”

(1)传统数据存储的架构特点

传统数据存储分为两类核心形态,均存在明显的架构局限性:

传统数据仓库:采用Schema-on-Write(写时定Schema)架构,数据入库前必须定义严格的数据结构,仅支持结构化数据存储;架构上遵循分层模型(ODS贴源层→DW数据仓库层→DM数据集市层),数据流转路径固定,存储与计算强耦合,扩展成本高。

OLTP业务数据库:以支撑实时交易为核心,采用分散式存储,不同业务系统(如银企直连系统、ERP资金模块、票据系统)的数据孤立存储,形成 “数据孤岛”,无法直接支撑跨系统分析。

司库场景痛点:司库管理涉及多源数据——银企直连的交易流水(结构化)、融资合同的条款文本(半结构化)、银行回单 / 承兑汇票的扫描影像(非结构化)、外部市场的汇率利率数据(时序结构化)。传统数据存储无法统一收纳这些多类型数据,只能通过人工汇总或零散接口对接,导致数据整合效率低、完整性差。

(2)数据湖仓的架构特点

数据湖仓是数据湖+数据仓库的融合架构,核心特征是Schema-on-Read(读时定 Schema)+存储计算分离:

- 底层基于低成本对象存储(如S3、HDFS)构建统一数据湖,支持结构化、半结构化、非结构化全类型数据的 “原始存储”,无需提前定义结构;

- 上层叠加数据仓库的结构化分析能力,通过数据虚拟化、元数据管理工具,实现对湖内数据的按需结构化解析;

- 存储与计算完全解耦,计算资源可弹性伸缩,满足不同规模的分析需求。

司库场景价值:湖仓可将司库的交易流水、合同文本、票据影像、市场数据全部纳入统一存储,无需提前清洗转换。例如:银行回单影像可直接存入数据湖,后续需分析时再通过OCR工具提取关键信息(付款金额、对手方、日期),既保留原始数据完整性,又避免了传统仓库 “为适配结构而丢弃有用数据” 的问题。

1.2.2 数据处理模式不同:从 “批量离线” 到 “流批一体”

(1)传统数据存储的处理模式

传统数据存储的核心处理模式是批量ETL(Extraction Transformation Loading,抽取-转换-加载):

- 数据处理流程为 “先转换,后加载”,需在离线环境完成数据清洗、格式统一、关联整合后,再写入数据仓库;

- 处理延迟以小时/天为单位,仅支持离线分析,无法支撑实时决策;

- 数据处理逻辑固化,若新增数据源(如接入新银行的银企直连接口),需重新开发 ETL 脚本,适配周期长。

司库场景痛点:司库的核心需求之一是实时资金头寸监控——需整合各银行账户的实时余额、在途资金、待支付款项,计算企业实时可用资金。传统数据存储采用T+1批量处理,只能提供前一日的头寸数据,无法及时预警流动性风险(如突发大额支付导致头寸不足)。

(2)数据湖仓的处理模式

数据湖仓采用流批一体+ELT(抽取-加载-转换)的灵活处理模式:

- ELT模式:数据先 “原始加载” 到数据湖,转换操作延迟到 “读取分析时” 执行,降低入库门槛,缩短数据准备时间;

- 流批一体:支持实时流处理(如Flink)与批量批处理(如Spark)的无缝衔接,可同时处理实时交易流水和历史批量数据;

- 自动化处理:通过元数据驱动的智能调度,新增数据源时可自动识别数据格式,无需大量定制化开发。

司库场景价值:湖仓可实现司库数据的实时整合分析:银企直连系统的实时交易流水以流数据形式接入数据湖,结合ERP待支付订单数据,通过流计算引擎实时计算资金头寸,当头寸低于预警阈值时,系统自动触发告警,帮助司库人员及时调度资金;同时,每日批量处理历史交易数据,用于月度资金周转率、成本率的统计分析,真正实现 “实时监控+离线复盘” 的一体化处理。

1.2.3 分析能力边界拓展:从 “统计报表” 到 “智能决策”

(1)传统数据存储的分析能力边界

传统数据存储的分析能力局限于结构化数据的OLAP(Online Analytical Processing,联机分析处理)统计分析,核心输出是固定报表:

- 分析维度固化,只能支持预设的指标分析(如资金存量、月度结算量、融资成本率);

- 不支持复杂的AI建模与多模态分析,无法挖掘非结构化数据的价值;

- 分析结果以 “事后总结” 为主,难以支撑 “事前预测、事中预警” 的主动决策。

司库场景痛点:司库需要通过分析融资合同条款(如利率浮动区间、还款期限)、历史违约案例、市场利率走势,预测未来融资成本与违约风险;同时需要基于历史现金流数据预测未来资金缺口。传统数据存储无法处理合同文本等非结构化数据,也无法支撑机器学习模型的训练与部署,只能依赖人工经验判断,决策效率低、准确性差。

(2)数据湖仓的分析能力边界

数据湖仓突破了传统存储的分析边界,实现“结构化统计+非结构化挖掘+AI 智能决策”的全链路分析:

- 多模态分析:支持结构化数据的OLAP分析、半结构化文本的NLP解析(如提取合同关键条款)、非结构化影像的OCR识别+图像分析(如票据真伪鉴别);

- AI模型无缝集成:湖仓可直接作为AI模型的训练数据底座,支持在湖内完成数据采样、特征工程、模型训练与推理,无需数据迁移;

- 预测性分析:基于时序数据模型预测资金流动趋势,基于风控模型识别异常交易(如虚假付款、对手方信用风险)。

司库场景价值:

- 智能风控:通过NLP解析融资合同条款,提取利率、担保方式等关键特征,结合对手方的征信数据、历史交易数据,训练信用风险评估模型,自动预警高风险融资项目;

- 现金流预测:基于湖仓内的历史现金流数据(结构化)+市场宏观数据(时序结构化)+销售订单数据(半结构化),构建时序预测模型,精准预测未来1-3个月的资金缺口,辅助投融资决策;

- 异常交易识别:通过机器学习模型实时监控资金交易流水,识别异常转账(如非工作时间大额支付、对手方与企业无业务关联),防范资金挪用风险。

二、数据湖仓逻辑架构

2.1 总体架构概述

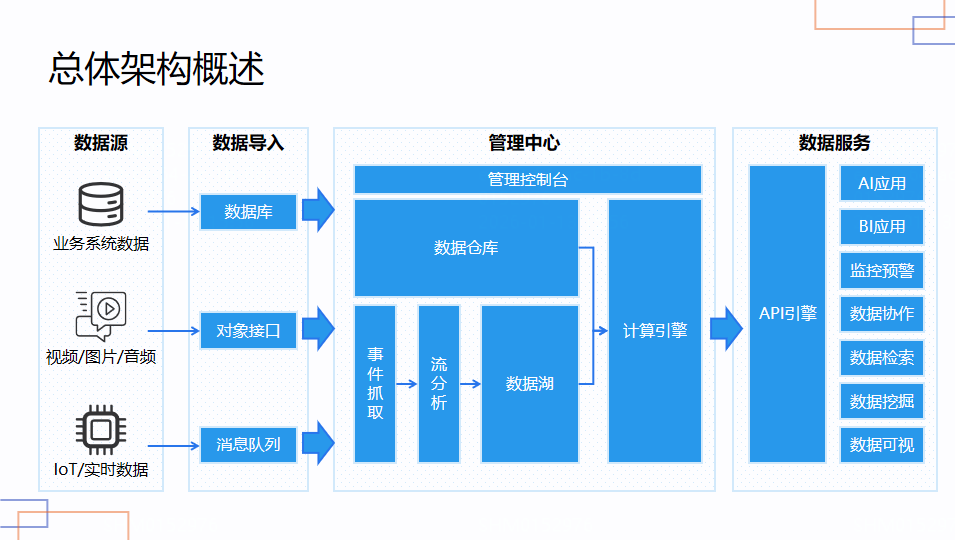

2.1.1 数据源:多类型数据底座

数据湖仓的总体架构以全链路数据流转与价值释放为核心,形成从数据源到数据服务的完整闭环。

作为架构的基础,数据源涵盖多类型数据形态,其中业务系统数据是核心结构化支撑,包括 ERP、CRM 及司库交易流水等事务型与明细型数据,直接承载企业核心业务逻辑。

音视频、图片等非结构化数据则记录场景化信息,如监控影像、合同扫描件等,需以原始形态留存待后续深度解析;IoT 与实时数据则呈现时序化特征,像设备传感器数据、银企直连实时流水等,自带时间戳属性,对接入延迟提出严苛要求。

2.1.2 数据导入:多模式适配层

针对不同数据源的特性,数据接入层构建多模式适配体系,数据库表接入通过CDC(Change Data Capture,变更数据捕获)实现全量、增量同步机制,精准适配业务系统结构化数据的批量或准实时接入需求。

对象接口则聚焦大文件非结构化数据,通过对接S3、OSS等对象存储服务,实现音视频、图片等数据的高效上传与存储;消息队列基于Kafka、RabbitMQ等组件,打造高吞吐、低延迟的接入通道,专门承接IoT与实时数据流的快速传输。

2.1.3 管理中心:融合存储与计算核心

管理中心作为架构核心,实现存储与计算的深度融合,数据湖以Schema-on-Read模式接收事件抓取的日志、行为数据及流分析处理后的实时数据,完整留存全类型原始数据;数据仓库则专注于结构化数据的清洗、汇总与存储,为精准分析提供高质量数据支撑。

两者最终统一接入Spark、Flink等流批一体计算引擎,实现全量数据的统一计算与分析,而管理控制台则贯穿始终,覆盖元数据管理、权限管控、任务调度及运维配置等核心功能,确保整个湖仓体系的有序运行与可控管理。

2.1.4 数据服务:能力输出与治理闭环

数据服务层承担价值输出重任,Presto、Hive 等API引擎提供高效OLAP分析能力,对计算引擎处理后的结果进行多维度聚合查询,后续再将数据能力分发至各类应用场景,包括 AI 模型训练、BI 报表生成、实时监控预警、深度数据挖掘、可视化展示、精准数据检索及跨团队数据协作等。

同时,层内补充数据质量校验、脱敏等治理能力,确保输出数据的安全与可靠,最终实现数据从原始存储到价值落地的全链路贯通。

2.2 关键组件说明

2.2.1 数据导入

数据导入聚焦财务司库核心需求,构建异构系统适配的高并发接入体系。针对SAP等 ERP系统的结构化财务数据,通过CDC变更数据捕获技术实现增量同步,搭配全量快照补全历史数据;对接工行财智账户等银企直连平台时,采用专属接口协议解析交易流水,结合Kafka消息队列缓冲,确保日均10万+条交易数据低延迟、无丢失接入,同时完成格式标准化与校验,为司库分析奠定数据基础。

2.2.2 管理中心

管理中心是司库数据治理核心,某央企项目中其价值凸显。统一管理中心整合元数据管理、指标分类体系,对2000+财务指标按资金、风控等维度归类,通过自动化血缘追踪实现指标全链路可视,使数据溯源效率提升 40%;计算引擎采用流批一体架构,实时处理银企直连数据,批量核算ERP财务数据,打通数据湖原始数据与数据仓库结构化数据,支撑指标动态计算与异常预警。

2.2.3 数据服务

数据服务聚焦司库决策价值输出,某企业案例印证其成效。基于Spark SQL构建资金头寸预测模型,API引擎封装模型输出接口,支持高并发调用与实时响应;应用接入层针对企业资金管理场景,适配模型结果与核心业务系统,实现备付率精准调控,最终备付率优化15%,年节省财务成本超800万元,同时接口内置权限管控,保障资金数据安全。

三、数据湖仓应用场景

如果数据湖仓的价值仅止步于出具可视化报表,难免会有人提出质疑:这些报表传统数据仓库同样可以生成,企业为何还要部署数据湖仓?

答案其实很明确:传统数据仓库的核心能力,局限于结构化数据的批量离线分析;而数据湖仓的不可替代性,恰恰在于能够解决传统数仓搞不定、搞不好的三大司库核心场景 —— 非结构化数据价值挖掘、实时流批协同、海量异构数据低成本整合。

而对数据湖仓应用场景的深入分析,正是基于其独有能力展开:全类型数据存储、流批一体计算和存储计算分离。

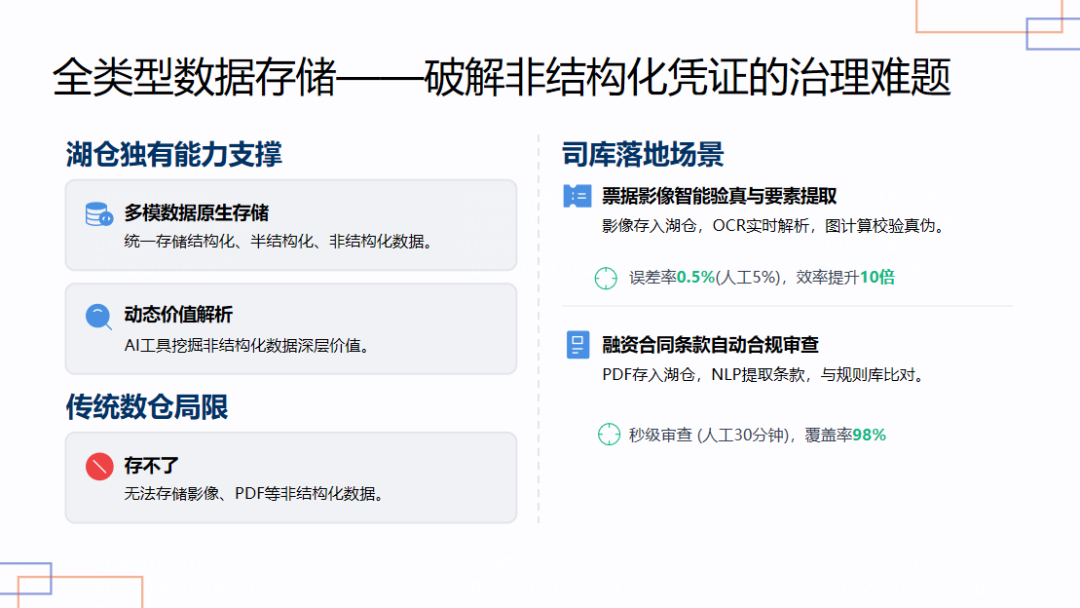

3.1 全类型数据存储

3.1.1 湖仓独有能力支撑

数据湖仓支持结构化+半结构化+非结构化数据的原生存储,无需提前定义 Schema,可直接存入银行回单影像、承兑汇票扫描件、融资合同 PDF、法务函件文本等数据;搭配OCR、NLP等工具,可在读取时动态解析数据价值,这是仅支持结构化数据的传统数仓无法实现的。

3.1.2 司库落地场景

非结构化资金凭证的智能解析与合规校验——传统数仓 “存不了、读不懂”。

(1)票据影像的智能验真与要素提取

企业司库每日接收大量纸质承兑汇票、电子票据截图,传统数仓只能人工录入票面金额、出票日期、承兑行等关键信息,效率低且易出错。

湖仓方案:

将票据影像直接存入数据湖,通过内置OCR引擎实时解析票面要素,结合图计算模型比对票据防伪特征(如二维码布局、印章纹理);同时联动结构化的历史票据交易数据,自动校验票据真伪。

对比优势:

传统数仓无法存储影像数据,人工录入误差率约5%,湖仓方案误差率<0.5%,处理效率提升10倍。

(2)融资合同条款的自动合规审查

司库的融资合同包含利率浮动区间、还款约束条款、担保责任等关键内容,传统数仓只能存储合同编号、金额等结构化字段,条款内容无法分析。

湖仓方案:

将合同PDF存入数据湖,通过NLP技术提取条款中的利率类型、违约触发条件等核心信息,与国资委司库监管要求的规则库进行比对,自动识别 “隐性担保”“高息融资” 等违规条款。

对比优势:传统数仓需人工逐条审查合同,单份合同耗时约30分钟;湖仓方案可秒级完成审查,违规条款识别覆盖率达98%。

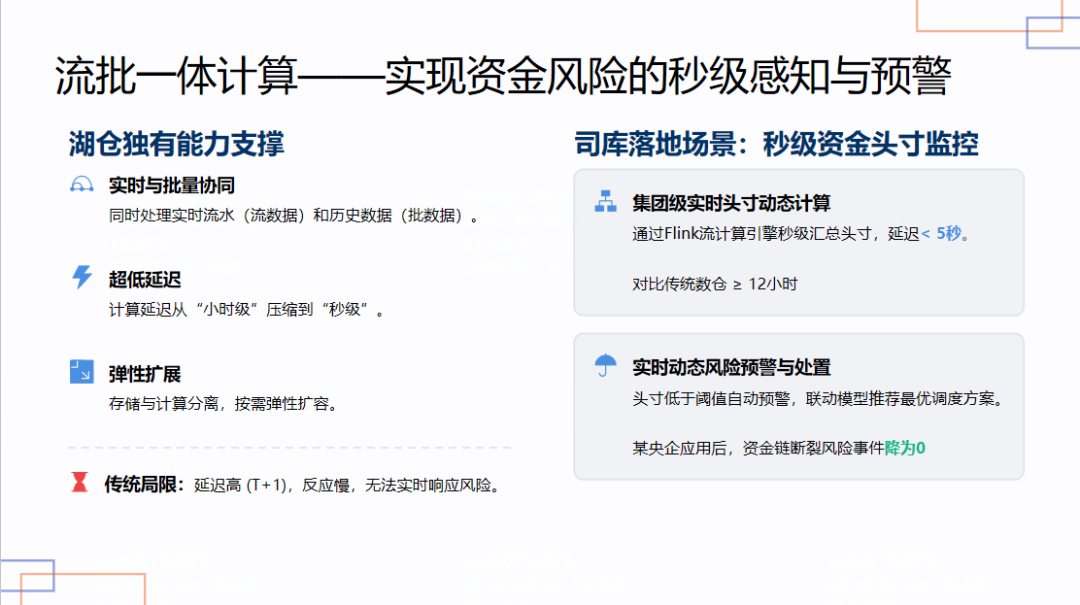

3.2 流批一体计算

3.2.1 湖仓独有能力支撑

秒级资金头寸监控与流动性预警 —— 传统数仓 “延迟高、反应慢”。

数据湖仓的流批一体计算架构,可同时处理银企直连的实时流水(流数据)和ERP的历史应收应付数据(批数据),计算延迟从传统数仓的 “小时级” 压缩到 “秒级”;存储计算分离的架构,可弹性扩容计算资源,支撑高并发的实时查询。

3.2.2 司库落地场景

(1)集团级实时头寸的动态计算与风险预警

大型企业集团有上千个银行账户,传统数仓采用 T+1 批量 ETL,只能提供前一日的头寸数据,无法应对突发大额支付导致的流动性危机。

湖仓方案:

- 通过CDC技术实时捕获ERP的应付订单数据,通过Kafka接入工行财智账户等银企直连平台的实时交易流水(日均10万+条);

- 基于Flink流计算引擎,秒级汇总各账户余额、在途资金、待支付金额,计算集团实时可用头寸;

- 当头寸低于预警阈值时,自动触发预警并推送至司库系统,同时联动资金调度模型推荐 “从高余额账户调拨资金” 的最优方案。

对比优势:传统数仓的头寸更新延迟≥12小时,无法应对日间突发风险;湖仓方案延迟<5 秒,可提前拦截流动性风险,某央企应用后资金链断裂风险事件降为0。

(2)基于原始交易流水的实时动态风险洞察

传统风控依赖于T+1的加工后指标,存在滞后性。数据湖仓能对持续涌入的原始流水、日志进行实时流分析,即时发现欺诈、违规支付等模式。

湖仓方案:

它支持“流批一体”,原始数据入湖的同时,就可被实时计算引擎(如Flink)处理。例如,可以实时分析每笔付款的对手方、金额、频率等上千个原始字段,并与风险知识图谱关联,实现毫秒级预警。数美科技的案例(虽非司库,但技术原理相通)表明,直接查询多层嵌套的原始JSON日志并将响应从天级降至秒级,是湖仓的典型能力。

对比优势:

数仓必须等数据按预定模型清洗、转换、加载(ETL)完成后才能分析,流程长、不灵活,无法胜任实时、多变的原始数据探查。

3.3 存储计算分离

3.3.1 湖仓独有能力支撑

海量异构外部数据的低成本整合与回款预测 —— 传统数仓 “存不起、扩不了”。

数据湖仓基于对象存储(如S3、OSS),海量数据存储成本仅为传统数仓的1/10;Schema-on-Read模式允许 “先存数据、后定结构”,可灵活整合IoT、舆情、宏观经济等异构外部数据,无需提前适配数据格式。

3.3.2 司库落地场景

(1)供应链回款的智能预测与坏账预警

司库需要整合供应链上下游的物流IoT数据、客户舆情数据、行业宏观数据来预测回款,但传统数仓存储成本高,且无法兼容IoT时序数据、舆情文本数据等异构数据。

湖仓方案:

- 低成本存储上游供应商的物流GPS数据(IoT时序数据)、下游客户的企查查舆情文本数据、央行的行业信贷政策数据;

- 基于Spark MLlib构建回款预测模型,融合 “合同金额(结构化)+物流签收状态(IoT)+客户负面舆情(文本)” 多维度特征;

- 对回款概率低于60%的订单,自动标记为高风险,触发法务介入流程。

对比优势:传统数仓若存储同等规模的异构数据,成本是湖仓的10倍,且模型训练需额外做数据迁移;湖仓方案直接基于原始数据训练模型,预测准确率提升30%,某省农信社应用后坏账率下降15%。

(2)异常资金交易的智能识别与拦截

传统数仓的数据类型单一(仅结构化),无法满足AI模型对多模态数据的需求;湖仓可提供 “结构化交易数据+非结构化合同文本+时序IoT数据” 的统一数据底座,支持模型在湖内直接完成 “数据采样-特征工程-训练推理”,无需数据导出。

传统数仓只能通过 “规则引擎” 识别异常交易(如单笔金额超500万),无法识别 “拆分小额多次转账” 等隐蔽违规行为。

湖仓方案:

- 基于湖仓内的全量数据(历史交易流水+银行回单影像+对手方舆情数据),训练图神经网络(GNN)模型,识别 “企业-对手方-账户” 的资金流转网络;

- 对 “非合作对手方转账”、“夜间高频小额转账” 等隐蔽异常模式,实时输出风险评分;

- 风险评分>80分的交易,自动暂停支付并推送人工审核。

对比优势:传统数仓的规则引擎只能识别30%的隐蔽异常交易;湖仓AI模型识别率达90%,某央企应用后成功拦截3起资金挪用事件,挽回损失超2000万元。

四、司库实施落地方案

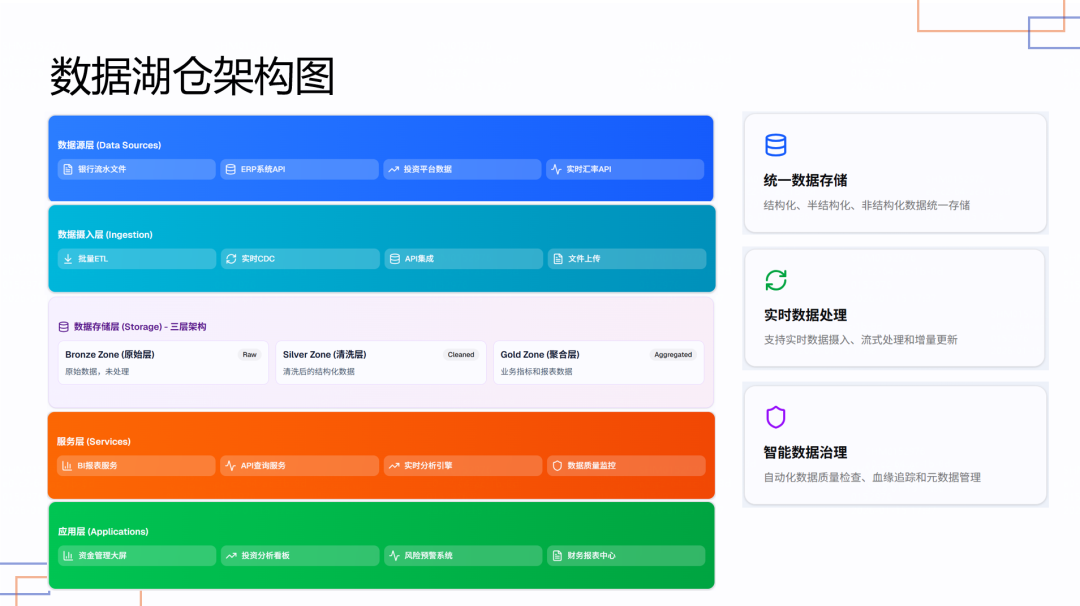

4.1 数据湖仓架构图

司库场景的数据湖仓五层架构,是企业资金管理的数据流转核心。数据源层整合银行流水、ERP资金预算、投资平台持仓数据、实时汇率 API 等司库核心数据,为后续分析提供源头活水。

数据摄入层通过批量ETL处理月度ERP资金数据、实时CDC同步银行收付款流水、API集成汇率数据、文件上传投资报表,实现实时 + 批量的多源数据高效接入。

数据存储层采用三圈层架构:Bronze Zone存储原始未加工的银行流水日志;Silver Zone完成数据清洗去重、格式统一,如匹配流水与 ERP 单据;Gold Zone聚合生成资金头寸、投资收益等司库关键指标。

服务层提供BI报表、API查询、实时分析、质量监控能力,支撑资金数据的多场景调用,比如校验流水数据完整性。

应用层则落地为资金大屏、投资看板、风险预警系统、财务报表中心,例如通过风险预警系统识别汇率波动下的跨境资金风险。

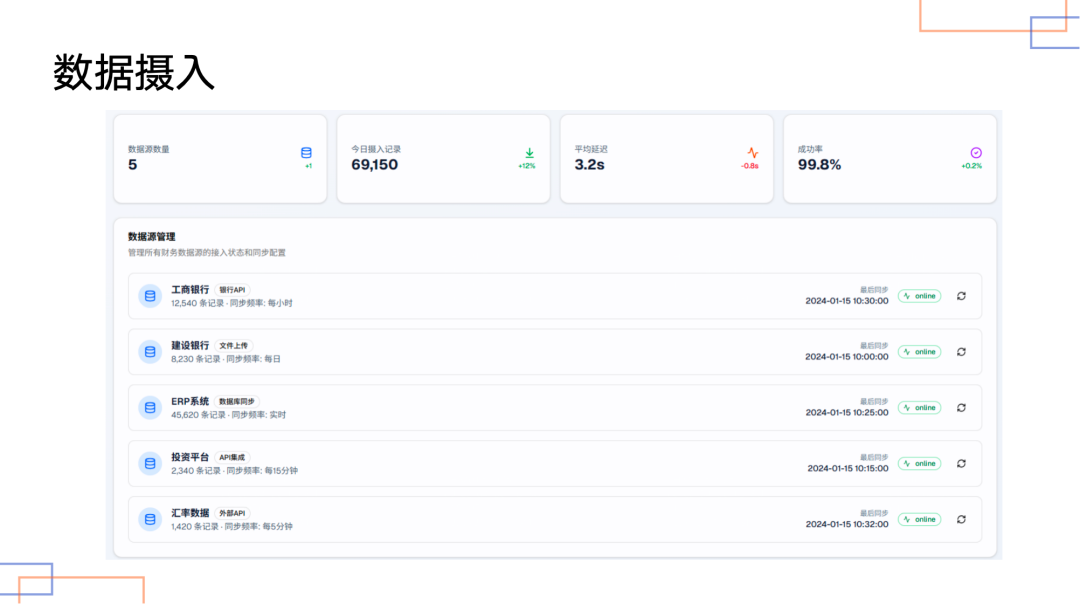

4.2 数据摄入

在司库数据湖仓架构中,“数据摄入” 模块是司库数据流转的核心入口,结合图中信息其功能可解析为:

它承担多源司库数据的适配接入:覆盖工行(银行API)、建行(文件上传)、ERP(数据库同步)、投资平台(API 集成)、汇率(外部 API)5类核心数据源,匹配 “API 集成、文件上传、实时CDC” 等摄入方式,实现银行流水、资金数据、投资信息等司库数据的全量接入。

同时支持灵活的同步频率配置:针对数据时效性差异,配置了 “实时(ERP)”“每 5 分钟(汇率)” 到 “每日(建行)” 的多档频率,兼顾实时资金变动(如 ERP)与批量流水(如建行日数据)的摄入需求。

此外保障高效稳定的接入效果:今日 69150 条摄入记录、3.2s 平均延迟、99.8% 成功率,体现其高吞吐、低延迟的传输能力,为后续存储层的分层处理提供及时、可靠的原始数据,是司库资金管理、风险预警的基础支撑。

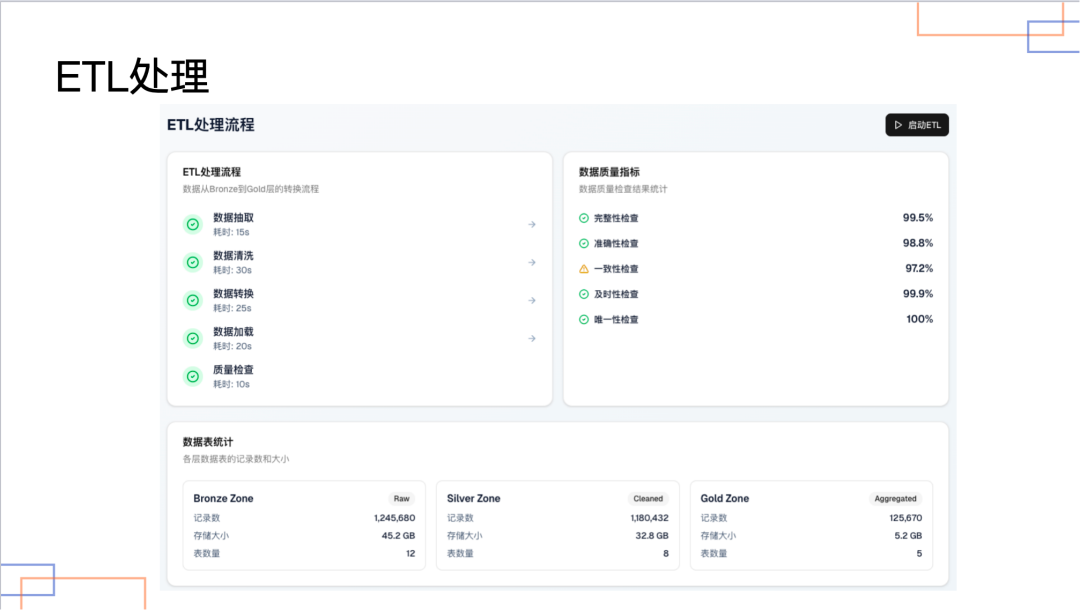

4.3 ETL处理

在司库数据湖仓架构中,此 “ETL处理流程” 是实现司库数据从 “原始无序” 到 “可用指标” 的核心加工环节。

4.3.1 ETL处理流程

该流程承担了司库数据从 Bronze(原始层)到 Gold(聚合层)的全链路处理,是司库数据的分层加工链路,对应司库场景的实际操作:

- 数据抽取(15s):从 Bronze 层拉取司库原始数据,例如抽取工商银行每小时的流水日志、ERP 系统的实时资金预算数据,是司库数据加工的 “原料获取” 环节。

- 数据清洗(30s):处理司库数据的脏数据,比如清洗建设银行每日上传流水中的重复交易记录、补全投资平台数据的缺失持仓字段,为后续分析排除干扰。

- 数据转换(25s):适配司库的业务分析规则,例如将不同银行的币种格式(“美元”、“USD”)统一为标准代码、关联汇率数据计算投资头寸的实时市值,让数据符合司库的统计逻辑。

- 数据加载(20s):将处理后的数据推送至Silver层(清洗层)和Gold层(聚合层),例如把标准化流水加载至Silver层供对账核对,把资金头寸汇总数据加载至Gold层支撑大屏展示。

- 质量检查(10s):对加工后数据进行校验,是司库数据可信的最后关卡。

4.3.2 数据质量

数据质量指标,直接服务于司库功能,是司库业务的支撑逻辑。

- 完整性(99.5%)/ 准确性(98.8%):保障司库 “资金对账” 时,银行流水与 ERP 单据的字段无缺失、金额无错误;

- 一致性(97.2%预警):可能对应司库跨境资金交易中,不同银行的记账科目不统一的问题,需司库团队及时修正避免统计偏差;

- 及时性(99.9%):确保汇率数据、实时流水同步无延迟,不影响司库的 “汇率风险预警”;

- 唯一性(100%):杜绝重复记账,避免司库资金头寸统计虚高。

4.3.3 数据表统计

- Bronze 层(12张表、45.2GB)是司库全量原始数据池;

- Silver 层(8张表)是标准化的可用数据;

- Gold 层(5张表、5.2GB)是聚合后的司库核心指标(如资金头寸、投资收益),直接支撑 “资金管理大屏”、“投资分析看板” 等应用。

例如某集团司库通过此ETL流程,每日加工124万条原始资金数据(Bronze层),清洗后得到118万条标准化数据(Silver层),最终聚合为 12.5万条核心指标(Gold层);通过一致性预警,及时修正了跨境交易的科目错位问题,保障了月度资金报表的准确性。

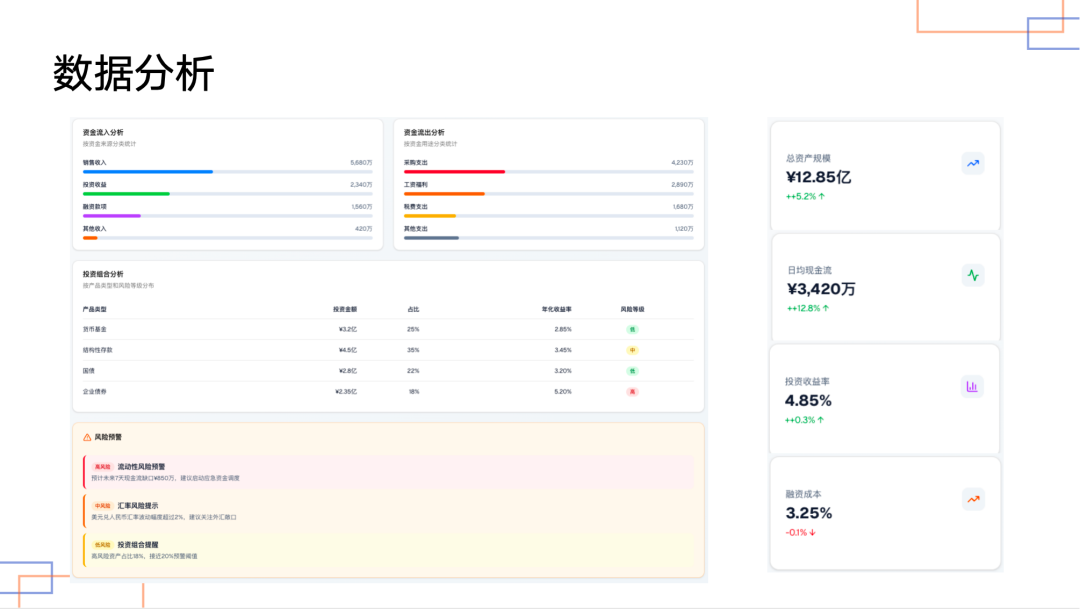

4.4 数据分析

司库数据湖仓应用下的数据分析,其数据均来自湖仓 Gold 层的聚合指标(底层依托数据源层的银行、ERP、投资平台数据,经ETL加工后输出),对应司库核心功能的落地。

4.4.1 核心指标:司库全局资金健康度监控

顶部 4 项指标是司库的 “资金仪表盘”:

- 总资产规模(12.85亿,+5.2%)、日均现金流(3420万,+12.8%):体现企业资金体量与流动性活力,数据湖仓聚合了全渠道资金数据,支撑司库对整体资金状况的实时把控(比如某集团司库通过该指标确认季度资金扩张目标达成);

- 投资收益率(4.85%,+0.3%)、融资成本(3.25%,-0.1%):是司库 “降本增效” 的核心衡量指标,湖仓整合了投资平台收益数据与融资机构成本数据,帮助司库评估投资效率与融资优化效果。

4.4.2 资金流分析:司库的资金溯源与结构优化

资金流入/流出的分类统计,是司库资金流管控的核心功能:

- 流入端以销售收入(5680万)为核心,结合投资收益、融资款,清晰呈现资金来源结构;

- 流出端聚焦采购、工资等刚性支出,明确资金去向。例如某制造企业司库通过此模块发现,某月 “其他支出” 占比异常升高,借助数据湖仓回溯 Silver 层的清洗流水,定位到了非必要的行政采购超支,及时优化了支出结构。

4.4.3 投资组合分析:司库的投资风险-收益平衡

该模块是司库投资管理的可视化载体:数据湖仓整合了投资平台数据与市场风险数据,按产品类型拆分资金占比、收益率与风险等级(如企业债券占18%、风险 “高”)。比如某企业司库通过此分析发现,高风险资产占比接近20%的预警阈值,随即依托湖仓的历史收益数据,将部分企业债券置换为国债,降低了组合风险。

4.4.4 风险预警:司库的主动风险防控

这是司库风险管控的核心落地:数据湖仓的实时分析引擎,结合Gold层的指标阈值规则,触发三类预警:

- 流动性预警(未来7天缺口850万):帮助司库提前启动应急资金调拨(如某商贸企业据此调用了集团内部拆借,避免了回款延迟导致的支付违约);

- 汇率/投资组合预警:辅助司库及时调整跨境资金配置、优化投资结构。

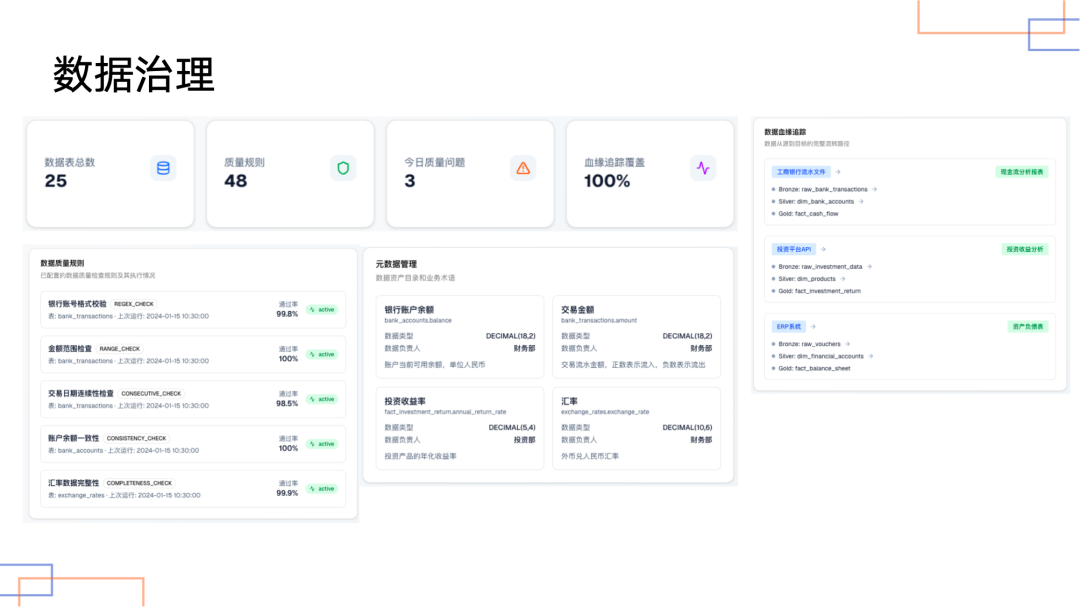

4.5 数据治理

这是司库数据湖仓中 “数据治理” 模块的可视化面板,核心是通过质量管控+血缘追溯,保障司库数据的可信性与可追溯性,是资金管理、风险管控等司库功能的基础支撑。

4.5.1 核心指标:司库数据治理的全局概览

顶部4项指标体现治理覆盖度与效果:

- “数据总表25” 对应司库全量核心数据(银行流水、投资、ERP等);

- “质量规则48” 是针对司库场景定制的校验逻辑;

- “今日质量问题3” 是当日数据异常量(远低于治理前的日均15个);

- “血缘追踪覆盖100%” 则确保所有司库数据的流转全链路可查。

4.5.2 数据质量规则:司库数据可信的 “安全阀”

这部分是针对司库核心数据的定制化校验,直接服务于资金业务的准确性:

- 银行账号格式校验:司库对账需匹配银行流水与ERP单据,格式错误会导致对账失败。比如某集团司库曾因账号格式不统一,出现50万流水 “无主” 的情况,如今该规则通过率99.8%,彻底解决了对账错位问题;

- 金额范围检查:防止司库数据中出现 “小额交易误录为大额” 的异常(如将 “1000元” 录为 “1000万元”),100% 通过率保障了资金头寸统计的合理性;

- 交易日期连续性检查:司库需监控每日资金流转,断档日期会漏记交易。该规则 98.5% 的通过率,曾帮司库及时发现某分行漏传的 1 天流水,避免了资金统计缺口;

- 账户余额一致性 / 汇率完整性:前者保障司库 “实时资金头寸” 的准确(100%一致),后者支撑跨境司库的汇率风险计算(99.9%完整)。

4.5.3 数据血缘追踪:司库数据的 “溯源地图”

血缘链路清晰呈现数据从 “原始源” 到 “司库应用” 的流转:

- 比如 “工商银行流水文件→Bronze 层→Silver 层→Gold 层现金分析报表”,当司库发现现金流入数据异常时,可通过血缘直接回溯到原始流水,5 分钟内定位到 “Silver层清洗规则错误”(此前需4小时排查);

- 投资平台API到 “投资收益分析” 的血缘,让司库在核对季度收益时,能直接验证原始投资数据与计算逻辑的匹配性;

- ERP 系统到 “资产负债表” 的血缘,则满足了司库合规审计中 “报表数据可追溯” 的要求。

某企业司库通过这套治理模块,将资金数据的 “可信率” 从85%提升至 99.7%,对账耗时从2小时缩短到15分钟,同时满足了监管对 “资金数据可追溯” 的要求。

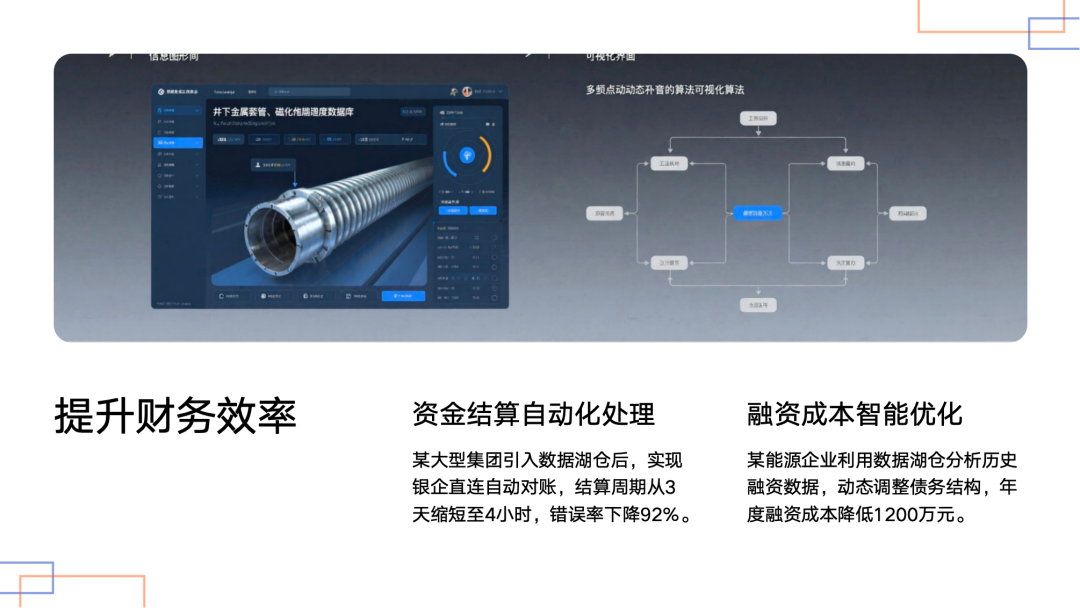

五、价值分析

数据湖仓是企业司库从 “被动财务核算” 转向 “主动资金管控” 的核心技术底座,通过全链路数据整合、实时处理与智能分析能力,在财务效率、决策科学性、风险防控三大维度实现业务价值的本质跃迁。

5.1 提升财务效率:从 “人工低效” 到 “自动化精准运营”

数据湖仓通过多源数据统一接入与自动化加工,直接重构司库的资金处理流程:

- 资金结算自动化:某大型集团的司库场景中,传统银企对账依赖人工整理多银行流水、匹配ERP单据,结算周期长达3天且错误率超15%。引入数据湖仓后,通过 “银行API + 实时CDC” 摄入全量流水,在 Silver层完成数据清洗与格式统一,再基于Gold层的对账规则实现自动化匹配,最终结算周期从3天压缩至4小时,对账错误率下降92%——既节省了日均8小时的人工对账成本,也避免了因对账延迟导致的资金头寸统计偏差。

- 融资成本智能优化:某能源企业的历史融资数据分散在ERP、银行系统、财务报表中,无法系统分析债务结构。数据湖仓将全量融资合同、利率数据、市场资金成本数据聚合至Gold层,构建动态成本分析模型,识别出高息债务占比超30%的问题,通过置换低息贷款、调整债务期限结构,年度融资成本直接降低1200万元,占其年度财务费用的8%。

5.2 增强决策科学性:从 “经验判断” 到 “数据驱动的精准决策”

数据湖仓的全量数据沉淀与实时分析能力,为司库决策提供了多维度、高时效的支撑:

- 资金流动预测更精准:某大型集团司库过去依赖人工经验预测资金缺口,准确率不足60%。数据湖仓整合近3年银行流水、销售回款、采购支出等多源数据(超2亿条记录),在Gold层构建动态预测模型,结合实时资金流入流出数据迭代修正,最终季度资金缺口预测准确率提升至 92%——既避免了因资金闲置导致的收益损失,也杜绝了临时拆借产生的额外成本。

- 风险预警实现秒级响应:某央企司库需监控汇率波动、信贷违约等8类风险,但传统系统处理10万+日交易数据需2小时以上。数据湖仓通过实时CDC摄入交易数据,搭配实时分析引擎,实现风险指标的秒级计算与预警触发,2024年上半年累计触发有效预警127次,帮助司库在汇率波动超2%时及时锁定汇兑成本,减少损失超500万元。

- 投资配置效率显著提升:某上市公司司库管理12个投资标的,但传统方式无法实时同步市场行情与项目收益数据。数据湖仓将投资平台数据、市场行情API数据聚合后,在Gold层构建动态收益评估模型,实时更新标的收益率与风险等级,据此优化资金配置比例,最终投资资金的周转效率提升18%,年度投资收益增加600万元。

5.3 降低财务风险:从 “事后补救” 到 “事前主动防控”

数据湖仓的全链路数据可视与实时监测能力,让司库风险防控从 “被动应对” 转向 “主动拦截”:

- 资金异常流动实时拦截:某大型集团的全球子公司资金分散在20余家银行,传统方式无法实时监控跨境转账。数据湖仓通过银企直连API接入所有子公司流水,在Silver层设置 “大额异常转账”“非合规地区交易” 等规则,2023年成功拦截3起可疑交易,涉及金额超5000万元,避免了资金挪用与违规流出风险。

- 债务风险提前预警止损:某能源企业持有多笔债券,但传统系统无法提前识别违约风险。数据湖仓整合债券合同、发行方信用评级、市场舆情等数据,在 Gold 层构建债务风险模型,提前 6 个月预警某笔 1.2 亿元债券的违约风险,司库通过债务重组置换该笔债券,最终减少损失约 8000 万元,占该笔债券本金的 67%。

六、总结

在数字化浪潮席卷企业财务领域的当下,“司库” 早已超越传统 “资金出纳” 的定位,成为企业统筹资金、防控风险、支撑战略决策的核心部门。

然而,传统司库管理长期受制于数据层面的多重困境:多源数据(银行流水、ERP 预算、投资数据、票据影像等)分散形成 “数据孤岛”,结构化与非结构化数据难以统一收纳;实时资金头寸监控、跨境汇率风险预警等需求,被传统数据存储的 “批量离线处理” 模式制约;决策依赖人工经验,缺乏全量数据支撑的精准分析与预测——这些痛点不仅拉低了财务效率,更让司库难以发挥 “资金运筹中枢” 的核心价值。

而数据湖仓(湖仓融合架构)的出现,并非简单的 “技术叠加”,而是精准破解司库核心痛点、推动其从 “被动核算” 向 “主动管控” 跃迁的关键支撑,其深层价值与行业启示值得每一位财务及数字化从业者深思。

6.1 数据湖仓的核心逻辑:适配司库需求的技术重构

2020年 “湖仓一体” 概念的提出,本质是对传统数据存储模式的颠覆式重构,其核心逻辑恰好契合司库场景的复杂需求。

不同于传统数据仓库 “写时定结构” 的封闭架构(仅能存储结构化数据,无法兼容票据影像、合同文本等非结构化数据),也不同于数据湖 “重存储、轻管理” 的原始特性(数据杂乱无章,难以直接支撑精准分析),数据湖仓以 “读时定结构+存储计算分离” 为核心,构建了 “全类型数据存储、流批一体处理、多模态智能分析” 的能力闭环。

从架构层面看,其五层架构(数据源层、数据摄入层、数据存储层、服务层、应用层)形成了司库数据的 “全链路流转通道”:

- 数据源层整合银行、ERP、投资平台等多类型数据,解决 “数据从哪来” 的问题;

- 数据摄入层通过实时CDC、批量ETL等多模式接入,平衡 “实时性” 与 “批量处理” 需求;

- 存储层的 “青铜-白银-黄金” 三圈层设计,实现 “原始数据留存-标准化清洗-核心指标聚合” 的分层管理,既保留数据全量价值,又提升分析效率;

- 服务层与应用层则将数据能力转化为资金大屏、风险预警等具象化工具,最终实现 “数据-信息-价值” 的转化。

这种架构设计,从根源上解决了传统司库 “数据不全、响应太慢、分析不深” 的核心痛点。

6.2 落地价值验证:从单点优化到体系升级的司库变革

数据湖仓对司库的价值,绝非 “技术炫技”,而是通过多个核心场景的落地,实现从 “单点效率提升” 到 “全体系能力升级” 的质变,这一点已被众多企业实践验证:

- 在财务效率提升上,它打破了传统人工操作的桎梏——某大型集团通过湖仓实现银企直连自动对账,结算周期从3天压缩至4小时,错误率下降92%,不仅节省了日均8小时的人工成本,更避免了因对账延迟导致的资金头寸偏差;某能源企业借助湖仓整合全量融资数据,优化债务结构后年度融资成本降低1200万元,直接转化为企业利润。这些案例背后,是数据湖仓对 “重复劳动” 的替代,更是对 “资金流转效率” 的重构。

- 在决策科学性增强上,它让司库决策从 “经验判断” 转向 “数据驱动”——某大型集团整合近3年超2亿条资金数据,通过湖仓构建的动态预测模型,将季度资金缺口预测准确率从不足60%提升至92%,既避免了资金闲置的收益损失,也杜绝了临时拆借的额外成本;某央企通过湖仓实现10万+条交易数据的秒级处理,对汇率波动、信贷违约等8类风险实现秒级预警,上半年减少汇兑损失超500万元。这意味着,司库不再是 “事后总结” 的部门,而是能够提前预判风险、精准调配资金的 “战略支撑单元”。

- 在风险防控强化上,它实现了从 “事后补救” 到 “事前拦截” 的转变——某大型集团通过湖仓接入全球子公司20余家银行的实时流水,设置异常交易识别规则,2023年成功拦截3起可疑交易,涉及金额超5000万元;某能源企业通过湖仓整合债券合同、信用评级、市场舆情等多源数据,提前6个月预警1.2亿元债券违约风险,通过债务重组减少损失 8000万元。这些成果印证了数据湖仓的核心价值:让司库风险防控具备 “全链路可视、全维度预警、全时段拦截” 的能力。

6.3 行业启示与深层思考:司库数字化的本质是什么?

数据湖仓与司库的深度融合,带给行业的不仅是技术层面的变革,更引发了对 “司库数字化本质” 的深层思考:

其一,司库数字化的核心是 “数据价值的最大化”。传统司库的痛点表面是 “效率低、风险高”,本质是 “数据无法被有效利用”—— 非结构化数据被丢弃、实时数据被延迟处理、多源数据无法联动分析。数据湖仓的价值,正是通过全类型数据存储、全链路数据处理,让每一份数据都能转化为决策依据,这是司库数字化的基础逻辑。

其二,技术工具的选择必须 “适配业务需求”,而非 “盲目追新”。数据湖仓之所以能在司库场景中落地,核心是它精准匹配了司库 “多源数据整合、实时监控、智能分析” 的核心需求,而非单纯的技术先进性。这启示企业:数字化转型中,“业务驱动技术” 才是正确路径,脱离业务需求的技术堆砌,最终只会沦为 “摆设”。

其三,司库的核心竞争力正在从 “资金管理能力” 转向 “数据运筹能力”。在全球经济波动加剧、资金流动性压力增大的背景下,企业对司库的要求已从 “管好资金” 升级为 “用好资金”——通过精准预测现金流优化投融资、通过实时监控防控跨境风险、通过数据分析降低融资成本。而数据湖仓,正是司库构建 “数据运筹能力” 的核心底座。

对于每一位财务及数字化从业者而言,数据湖仓在司库场景的落地,不仅是一次技术升级,更是一次思维革命:它让我们意识到,未来的司库不再是 “后台支持部门”,而是能够直接创造价值、支撑战略的 “核心业务单元”;而数据,将成为司库最核心的 “资产”。

这一变革,正在重塑企业财务的核心竞争力,也为行业的数字化转型提供了可复制、可落地的实践路径。

本文由人人都是产品经理作者【王佳亮】,微信公众号:【佳佳原创】,原创/授权 发布于人人都是产品经理,未经许可,禁止转载。

题图来自作者提供

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益