安全产品之内容审核体系

对于资讯类产品和内容产品来说,内容审核是必不可少的环节之一。平台如何搭建审核体系?本文给大家分享了内容审核体系搭建的5个步骤,并对与审核相关的问题展开了分析说明,希望对你有用。

不用怀疑,我们在网上创建和发布的任何信息都会被审核,包括实名信息、昵称头像、个人自拍、甚至自己设置私密的动态。

大多数情况下,只要我们遵纪守法,不会感知到自己被审核,但是审核不止决定发言会不会被封,还决定能不能发出去,获得多少曝光,后两种很多时候是不会察觉到的。

内容审核在互联网行业发展已经趋向成熟,建立内容审核体系无外乎这5个步骤:

- 盘点平台里可能会产生用户发布内容的渠道和量级

- 定义可能会产生的内容类别,并根据风险程度排序

- 根据风险情况及平台需要选择合适的审核方式和处理方式

- 搭建线上审核平台,选择自建或采购的机器审核工具

- 自建或外包人工审核团队,包括规则、培训、SOP

一、为什么需要审核?

用户发布的内容不受平台控制,而部分内容会给平台造成风险,审核是阻断内容风险的主要方式。有风险的内容粗略划分主要有两种:

不能接受的内容:谁也碰不得的红线内容,审核是为了避免用户发布违法不良内容,让平台承受整改关停风险。

主要是黄反等违法违规类,只有守住这条红线,才能让平台在国内正常运转。有关部门会时不时对平台内容进行抽查,一旦被查到轻则点名批评、重则关停封杀。这些内容出现的概率很低,但任何平台都不惜任何成本去来规避这类内容的出现,代价包括建立庞大的人工审核团队,牺牲一定用户体验,禁止发布任何沾边的内容,哪怕你不是这个意思,这是不得已而为之。

不合适、不鼓励的内容:审核是为了让平台内容有自己的调性。

比如在人人都是产品经理,投稿一篇娱乐八卦文章,肯定不会被通过,因为平台只鼓励展示跟互联网产品相关的内容,其他内容即使会带来流量但会影响自身品牌形象,久而久之失去专业性。

很多平台因为对自己的内容定位把控不清晰或者力度不够大,从神坛跌落,百度贴吧就是一个。值得注意的是,有关部门越来越重视内容平台的整体调性,尤其是直播,对直播的要求越来越接近电视媒体,甚至更严格。

- 不能接受的内容::风险高、投入高、需要快速处理,杜绝出现。

- 不合适、不鼓励的内容:风险低、可以结合平台需要来选择处理方式和力度。

百度、抖音等app都因为内容问题被约谈过:

二、审核方式

按时间维度可分为先审后发、先发后审。选择什么样的审核方式,是对内容风险和用户体验的一种取舍,先审后发没有风险必伤体验,先发后审体验好但必定有大风险。

先审后发:所有内容审核通过后才可以提交,适用于对自身定位很强,对内容质量要求很高,信息量不是很大的平台,比如人人都是产品经理,以新闻为主的资讯平台,比如一点资讯等。优点是可以避免所有的违规,缺点是用户创作的环节和成本提高了,可能会劝退很多想试试的用户。

先发后审:发布后再审核,适用于信息量非常大的内容,没有那么多资源可以支撑先审后发,比如评论等。

这两种是比较粗暴的分类,现在大部分平台不会单一地采取一种方式进行审核,更多是组合审核。前边也说到过,即便是一条短短几个字的评论,如果出现红线问题,也是致命的。所以先审后发还是先发后审,不进是时间维度的划分,也是风险维度的划分,只有违规风险低的内容才适用先发后审。

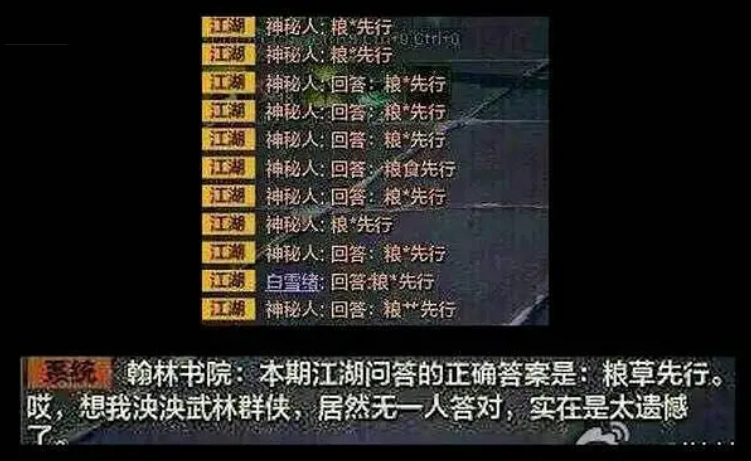

所有的内容,必定先过一道机器,如果识别出现违规,直接处理,比如一些评论根本不出去,或者发出去了也被打上*。

有些不确定是否违规,需要综合判断,综合上下文理解,这就需要先审后发,补充一点,如果平台资源足够强大,这一道审核的效率是可以瞬间审核完成的。

如果没有出现不能接受的内容的风险,不会出现才会进入到先发后审的环节。

需要注意的是,在内容场景中,直播不可能先审后发,先审后发那就不是直播了,直播的审核体系比其他内容更复杂要求更高。

此外,先发后审必须配合授权审核、举报反馈等方式来节约审核资源,缩短我们发现和审核的时间。

- 授权审核:平台设置某些用户帮助维护社区氛围,比如直播间管理员,贴吧吧主等。

- 举报反馈:所有内容都需要有一个举报的渠道,有些内容审核没发现违规,并不代表没问题,用户会提供更多有效的信息,比如诈骗。

三、处理方式

内容维度:清除内容,比如自见、删除;限制曝光,也就是常见的限流,大部分时候用户不会知道限流是因为审核操作还是算法推荐的结果。

限流是最好用的一种,不进能达到控制曝光的效果,而且对于用户来说没有感知。限流不是简单地给多少流量这么简单,限流的手段有:限制这个内容展现的渠道,比如某条微博关注的人可见,非关注不可见;限制这个内容的曝光上限,避免成为热点;

帐号维度:限制功能,某类功能不能使用,比如微信限制转账提现功能,直播平台限制开播。封禁账号也就是限制账号登录。

对于一些钻平台漏洞的黑产大佬们,弄几百上千个账号也是分分钟的事,所以还有针对设备号、ip号、甚至身份证号的审核处理,限制某个手机某个人使用app。

四、人工审核

审核方式包括机器审核、人工审核。机器审核解决大批量问题,人工审核解决其他问题。所有平台设立了人工审核团队,因机器审核只适用于特征极为明显的,大众有所共识的违规,也可作为人工审核的辅助判断工具。

比如当审核员审核我这篇文章时,可能不会逐字看完文章,而是通过机器标记了敏感词来辅助判断。(编辑回复:并不是……)

机器审核的弊端:不灵活,只依据客观特征来判断内容,机器眼里一张色情图片就是肉色很多的人体图片,一句话里出现草就会被屏蔽,容易带来体验不佳的问题。

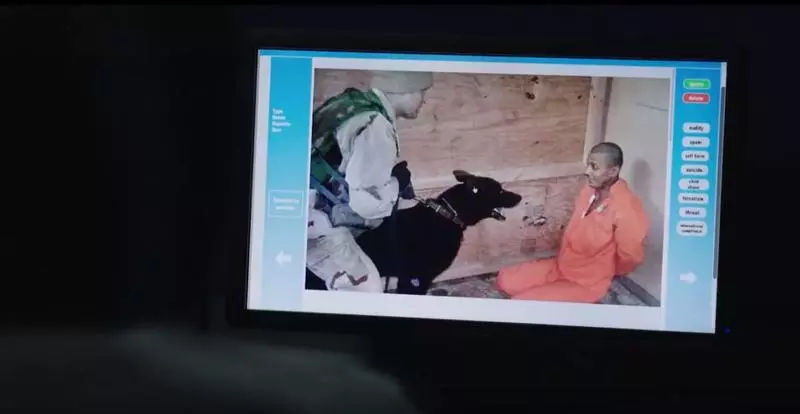

某个第三方机器审核工具:

人工审核不是平台随心所欲,也不是管理员主观判断,审核规则的设定就是为了避免同样的内容被不平等对待,因此人工审核必须严格遵循一套非常严格的审核规则进行操作。

审核规则如何制定?形式类似于法条,但需要结合平台的内容特征来因地制宜。无外乎这个套路:内容定义+内容特征+内容以外的条件限制+处理结果。

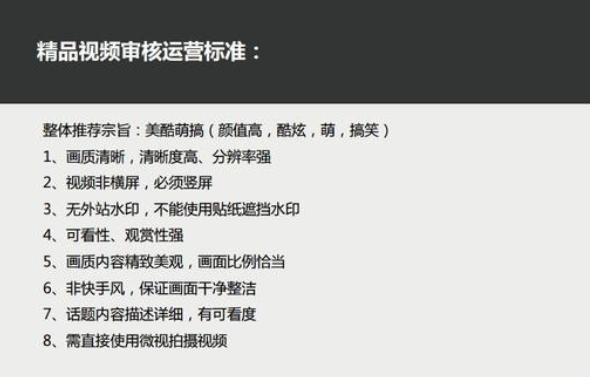

比如某视频的精品视频审核标准:

- 内容定义:优质内容

- 内容特征:画质清晰,竖屏,无水印……

- 条件:使用微视拍摄

- 处理结果:这里不清楚,既然是精品视频结果可能是获得额外流量

一条规则写得清晰明了,准确可执行,可以省下很多为了让审核同学理解,解释和培训的成本,更重要的是,准确定义需要干预的内容类型也影响着这类内容生产者的存亡。因此越来越多的UGC平台也开始重视这方面的人才,并设立了规则运营等相关岗位。

但,人并非机器,人对事物有自己的理解,大家所受的教育和生长环境不同,怎么让一条规则每个人执行都一样呢?这就需要针对人工审核团队设立培训体系和sop体系,操作准确-符合要求,操作不准确-克扣绩效,并加强培训,通过无数次循环考核,可达到非常一致的效果,人工审核操做越来越机械化……

内容量级越大,对应的审核团队也越庞大,很多公司会选择通过外包的方式节省办公成本。谷歌、脸书等就在东南亚地区设立了庞大的审核团队。随着外界对内容审查的要求越来越高,审核从业者也越来越多。

审核人员不仅需要承受大量的夜班工作,还会浏览到很多血腥暴力等有损身心健康的内容,有的干1,2个月就会出现心理问题,所以人员流动性极大。

五、内容审核平台

前面已经定义好了我们的审核方式和处理方式,那审核人员怎么进行审核呢?这就需要建立一个线上内容审核平台,审核后台一般分为信息区、操作区,审核员根据提供的信息判断并操作。

审核平台展示的信息是从规则和效率出发的。比如色情信息,我们规定用户名、头像、简介出现色情信息,用户需要标记处罚,那么审核后台需要展示用户名、头像、简介。

信息越充分,越有助于准确判断,但信息越多也会增加判断的时长。为了提高审核效率,会按内容元素拆分为图片审核、文本审核、音频审核,审核员几秒钟就能看完并标记一条内容,视频和直播同样也能拆解成这3个元素。

针对不同类型的内容也可以配备不同的辅助信息帮助审核,比如敏感词高亮显示、命中风险的图片截出风险部分。

图:电影《网络审查员》截取

本文由 @晖晖 原创发布于人人都是产品经理,未经作者许可,禁止转载。

题图来自Unsplash,基于CC0协议。

起点课堂会员权益

起点课堂会员权益

不进 不仅

编辑回复是真的吗…..

编辑回复hhhh

写的真棒 看完受益匪浅

之前给知识付费平台的用户评论业务建立审核机制时所考虑的点大致跟作者相同。