AI视频如何控制主体的一致性

如何在AI生成的视频中保持主体人物形象的一致性,成为影响作品质量的关键因素。本文将深入探讨AI视频创作中主体一致性的重要性,并分享两种实用的方法,希望能帮到大家。

在短视频碎片化传播的浪潮中,越来越多创作者尝试用 AI 技术打造剧情连贯的长视频。然而,主体人物形象特征的「前后割裂」,成为横在优质视频前的「拦路虎」—— 比方前一秒还穿着蓝色风衣的中年侦探,下一秒突然换成红色外套的少年…… 这类细节瑕疵不仅让观众出戏,更会瓦解故事的情感张力。

今天,我们结合 AI 视频创作的核心工作流(视频剧本→脚本分镜→提示词生成→图像生成→图生视频→剪辑优化),拆解两大实操方法,教你用技术手段精准把控人物一致性。

一、「图像生成」控制一致性

方法1:从「图像生成」这个步骤保持图片主体的一致性。

工具:即梦AI-参考角色特征,上传我们的主体物,输入提示词,想要主体物做什么动作,或者拿什么道具,通过此方法生成的静态图,人物相似度可达90% 以上,为后续动态视频奠定「形象锚点」。

以上步骤操作下来,就得到了我们的视频主人公的多动作静态图。再将得到的多张静态图,通过图生视频的方式,进行长视频的生成。

二、「图生视频」控制一致性

方法2:从「图生视频」这个步骤控制主体的一致性

直接基于单张角色图生成动态视频时,通过 AI 工具的「参考生视频」功能,强制锁定人物特征与动作连贯性。

使用工具:vidu、Viggle、海螺AI等工具,上传我们的图片,以参考生视频的方式进行视频的生成。

⬇️ Vidu链接:https://www.vidu.studio/zh

→ 上传角色静态图 → 选择「参考生视频」模式 → 输入角色提示词(如制造工人正在搬动手中的纸箱)借助主体库、参考图片融合生成视频。

(进阶玩法)提示词三帧法控制动作

在提示词中也可明确首帧、中间帧、尾帧的关键动作,单次生成需要简化动作步骤以保证主体的稳定性。

⬇️ Viggle链接:https://viggle.ai/home→ 上传角色图 → 选择「Move」功能 → 从平台资产库中选取相似动作的视频(如跳舞视频)→ 生成带角色特征的动态视频。

借助 Viggle 的 自带资产库,可自动匹配物理规律(如走路时手臂摆动幅度、跑步时身体前倾角度、跳舞时跃起跳动的姿态),同时还能保留角色的独有特征(如面部、服装)。

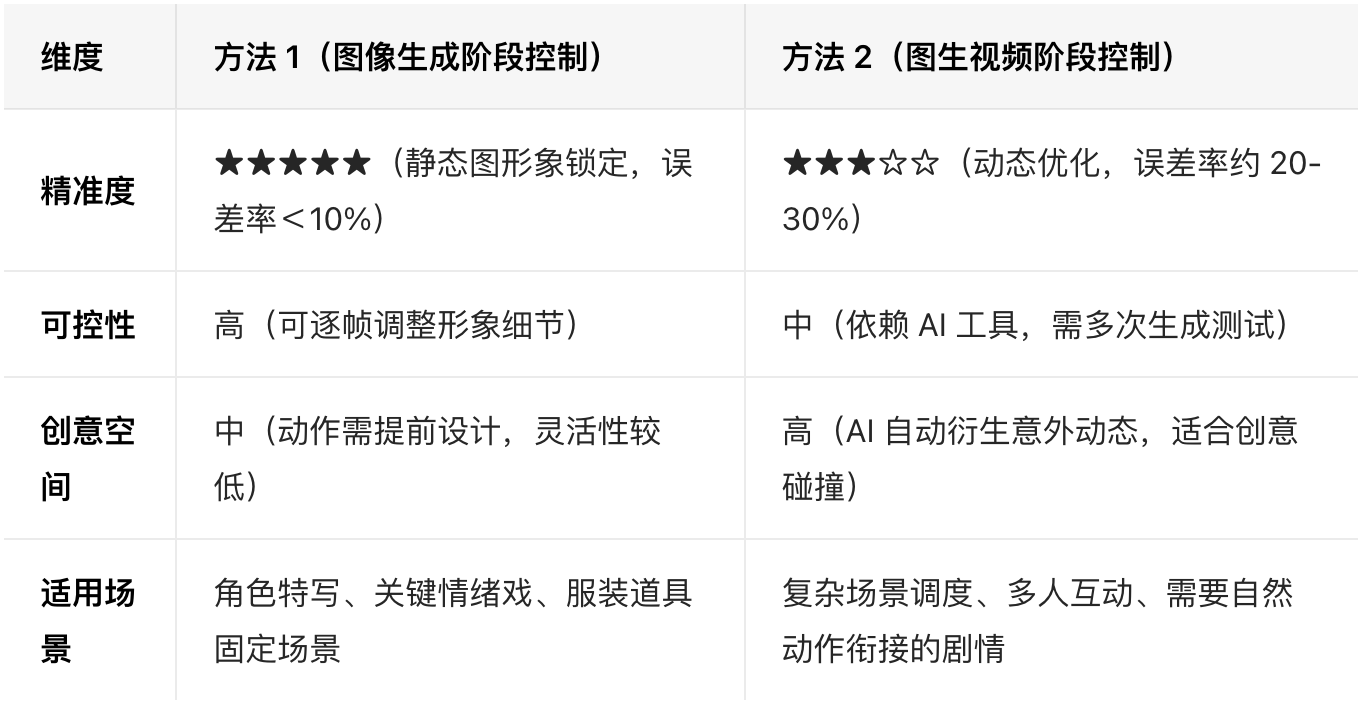

两种方法的多维度对比维度

三、写在最后

从静态形象到动态行为,主体一致性的本质是赋予角色「形象记忆」—— 让 AI 理解「这是谁」「在什么情境下做什么」。

无论是通过「图像锚点」还是「动态参考」,核心都是在创作流程中建立「角色档案」,并将其嵌入每一个生成环节。

本文由人人都是产品经理作者【58UXD】,微信公众号:【58UXD】,原创/授权 发布于人人都是产品经理,未经许可,禁止转载。

题图来自Unsplash,基于 CC0 协议。

起点课堂会员权益

起点课堂会员权益

增加模型训练的数据量和多样性,确保模型能够学习到更广泛的人物形象和情节变化。例如,可以收集更多关于中年侦探在不同情境下的穿着和行为的数据,让模型更好地理解和生成连贯的人物形象。

提升上下文理解能力:改进AI模型的上下文理解算法,使其能够更好地理解视频的整体情节和人物角色的连贯性。例如,可以引入更先进的自然语言处理技术,让模型更好地理解剧本内容,从而生成更连贯的人物形象。