探究微软 HAX 背后的设计逻辑

微软 HAX,不只是一个工具集,更是一种面向未来的设计哲学。本文深入拆解其背后的设计逻辑,从系统架构到用户体验,从战略意图到生态布局,试图还原微软在新一代人机交互中的底层思考,为产品人和设计师提供一份值得参考的认知地图。

“一款成熟的 AI,我们通常称之为 Software。”前段时间在播客听到这样的言论。

回想 2022 年初语言大模型横空出世之前应用于搜索、推荐的算法,一时间竟再认同不过。

不禁想起,早些时候,我们使用了丰富的案例介绍微软 HAX 设计原则的文章——那么,人与 AI 的交互原则和模式,为何要区别于传统软件呢?

某天,在看库布里克《2001 太空漫游》时,幡然醒悟。

我似乎陷入了将结果作为原因的逻辑悖论中。

传统软件像是片头智人高举的骨棒,是一个基于规则的确定性工具。在数百万年间,人类在使用工具获取的反馈中,培养了记忆与预期,人们也习惯于依赖可预测的工具生产劳动。

《2001 太空漫游》智人高举骨棒作为工具准备砸下去。

片中“ HAL9000”人工智能,好似如今基于概率模型和动态学习的生成式 AI ,具有天然的随机性和黑箱特质。若没有人类正确的引导和约束,最终悄无声息地带领人类走向失控。

《2001 太空漫游》宇航员发现正在排查有问题的 HAL9000。

这部 1968 年的科幻电影,在 AI 概念诞生的早期,就使用“HAL9000”的叛变警示了 AI 失控的风险。AI 作为仍具黑箱特征的技术,微软的设计师和工程师如何使用 HAX 原则进行约束与引导?其背后遵循着怎样的逻辑与思考?

这篇文章想与你探讨微软为什么要制定 HAX ——又靠什么支撑起这些规则?

我们一步步拆开它的逻辑脉络,看看这些设计思考是如何演化成一条条原则的。

01 人与 AI 的特征与局限

我们为什么不能用对待传统的技术交互方式来应用 AI 体验?与其说是技术区别,不如说是人的心智和互动习惯不适应新的技术。

思维如何被误导?——人类心智的运作机制

《思考,快与慢》中,卡尼曼提出了两种思维模式。

快思:依靠本能、快速、凭直觉运行,几乎不耗费脑力。比如,野外看见蛇会警惕想跑。

慢想:需要刻意、专注、有逻辑地分析,非常耗费精力。比如,正在查资料写文章的我。

在日常生活中,快思模式处理了绝大多数信息,但为了追求效率,依赖于个人经验的思维,常常引起系统性偏见。这与 AI 和人类 的交互体验有什么关系?传统软件的错误通常显而易见——”网络未连接“、”创建失败“、死机等机器反馈。这类明确的“失败”信号会调用我们的“慢想”思维模式,让我们用逻辑思维分析解决问题。

但是,AI 的错误却是微妙但隐蔽的,他们通常“自信”地犯错。如 GPT、Gemini、DeepSeek 等大语言模型应用,生成看起来合理但不符合事实的“幻觉”。这种难以察觉的错误,不易让人类触发“慢想”模式,而更倾向于采用“快思”的思维理解内容。

“快思”,这种思维模式总倾向于接收和处理看起来熟悉、流畅、易于理解的信息,即在书中提到的“认知放松”。你是否曾经尝试消除这类错误?但我们大多时候,并不会去怀疑一个 90% 时间里都有效,只有 10% 的时间里产生难以察觉的错误。

或者,你会去每一次都耗费大量时间精力去校对、批判、决策每一个 AI 的反馈吗?

这是我们身为人类,在与 AI 交互中的局限性。

为了缓解这种局限性,HAX 设计原则在 4 个环节中多次提倡建立一个交互的缓冲带,制造有益的摩擦。以便于人类有逻辑的“慢想”思维介入交互过程中的关键时刻,达到可控的目的。

我们为何以“人性”的方式与机器智能互动?——情感机制与交互效率

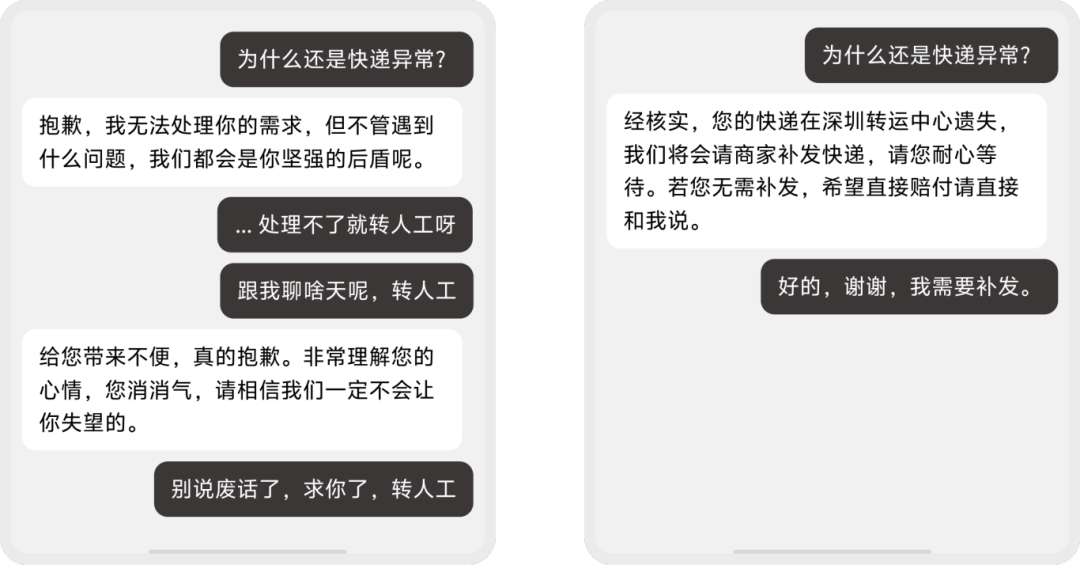

你是否有这样的经历?跟“智能客服”沟通时,在它无法理解诉求时,我们通常气急败坏地向其表达不满;在能完成诉求时对其说“谢谢”。

左图:用户在智能客服无法理解诉求时,愤然表达不满情绪。

右图:用户在智能客服完成预期时,礼貌表达感谢。

人类的情感表达总是不可避免。为什么我们即使知道 AI 就是一个没有情感的“概率机”,也会不自觉地把“TA”拟人化?是因为我们习惯于人类对话的社交模式。在与 AI 对话时,也会下意识地把 AI 当作可社交的对象,同时也在潜意识中期望它能遵守我们熟悉的社交规则。AI 在我们现如今的生活中通常充当一个效率工具,人类的情绪表达好像毫无作用。

难道,情感在 AI 与人的互动中没有价值吗?

马文·明斯基认为:情感,也是一种思维方式。他在《情感机器》中提到,人类大脑拥有多种解决问题的方式,比如逻辑推理、空间想象等。不同的“情感状态”,比如“恐惧”,会迅速改变大脑的运行模式——激活那些最适合应对当前紧急状况的“快思”类思维资源,以执行躲避危险的任务。

在这套理论中,明斯基认为一个“智能”的系统需要类似情感的机制——它不是为了让机器“感受”喜怒哀乐,而是为了让机器能够更灵活、更智能地思考和解决人类在社会沟通中经常被忽略或未描述的“场景”问题。

遗憾的是,用户所在物理世界中的大量“情绪”数据,暂时无法被机器直接感知和理解。然而,人类却习惯通过“情感”激活特定思维资源,来解决场景问题。

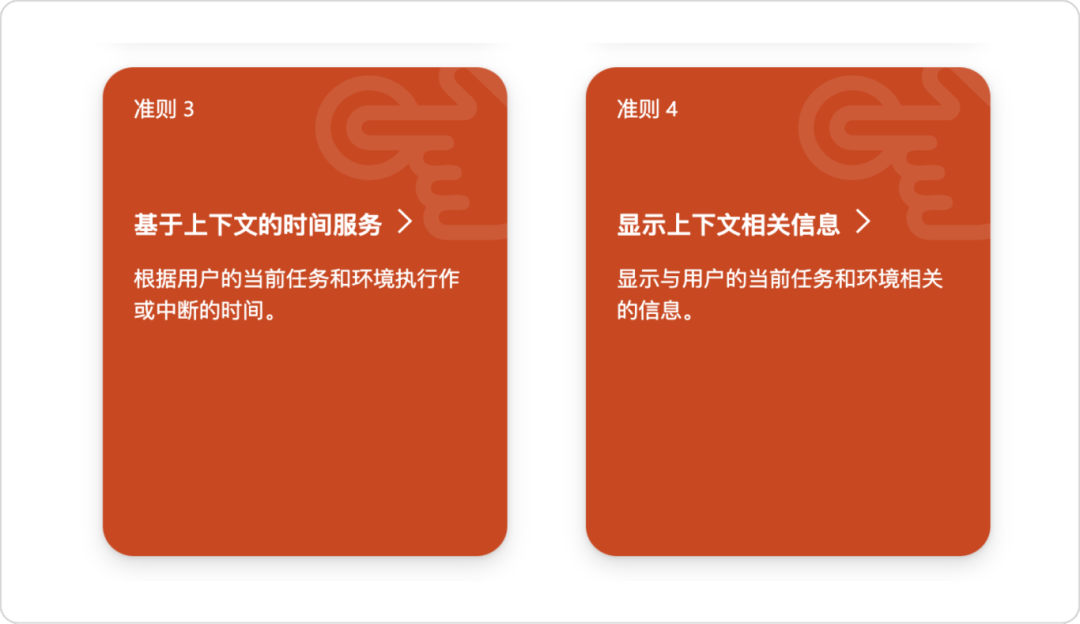

面对机器在这方面的局限时,HAX 原则试图通过“场景预设”和“社会规则建模”的方式,来模拟人类的“情感思维”。比如,G3、G4 要求 AI 通过数据建模的方式,理解用户所处的上下文和环境,预设不同场景下的响应模式。这样,用户就无需将上下文场景或情绪告知给 AI。这也是从“个体”的角度出发,用类似于模拟人类情感的快速响应机制,使交互更符合用户直觉的思维习惯。

图片来源于微软HAX Toolkit中的G3、G4 (文本经谷歌网页翻译)

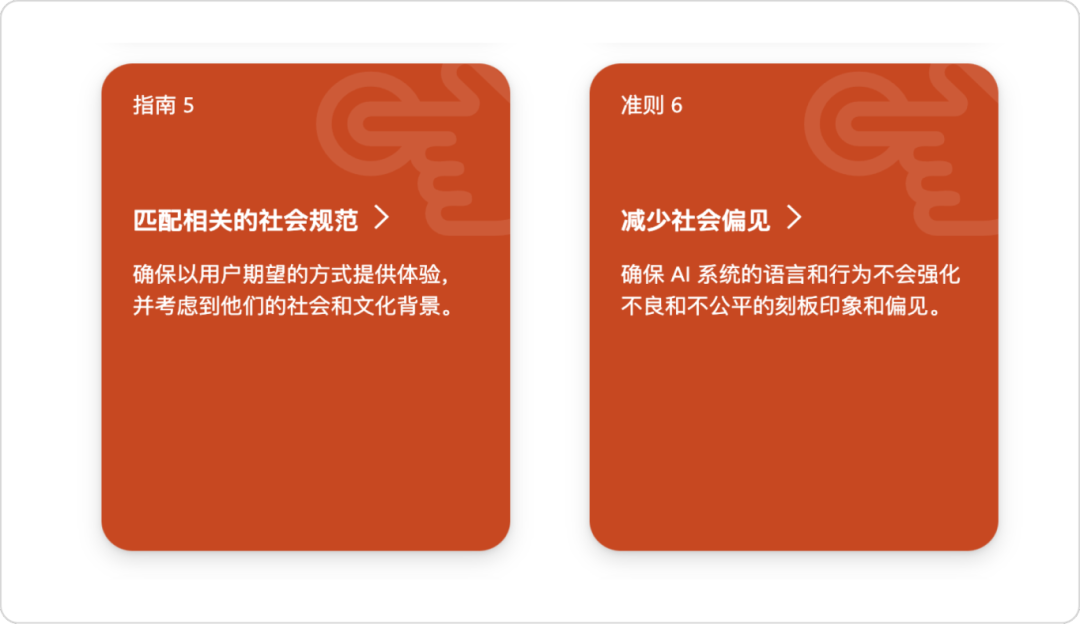

G5、G6 阐述 AI 需符合社会伦理、避免刻板印象,这不仅是道德层面的要求,更强调人类作为群居动物在社会中的“互动共识”。试想,AI 若反馈违背社会规范,充满刻板印象的虚假信息,那将引发用户的不信任和抵触,从而降低了交互效率。

图片来源于微软 HAX Toolkit 中的 G5、G6 (文本经谷歌网页翻译)

无论是个体环境,还是群体共识,HAX 设计原则从理解到响应的机制,与情感作为思维的方式不谋而合。但这并不意味着 AI 需要模拟情感本身,而是作为智能工具模拟“情感思维”机制,以解决特定场景中的效率问题。

以信任构建互动关系

无论是提醒人类以“慢想”思维介入交互过程,还是模拟情感思维,帮助人类解决场景问题。HAX 原则都在以“以人为本”的视角,去解决人类与机器各自存在的局限性,这也是构建信任关系的基石。

有篇论文这样定义信任:“信任是主体对客体执行“特定行为”的结果期望,且愿意承受其行动带来的风险的心理状态。”

——Trust in Human-AI Interaction: Scoping Out Models, Measures, and Methods

那么,为了提高人与 AI 的交互效率,获取用户最大的信任是正确的吗?

显然不是。

过度的信任可能导致 AI 被滥用,而信任不足又会使人放弃使用。对于这样一个智能伙伴来说,若我们想要更高的效率,或许需要依靠一个信任校准工具,将 AI 的真实能力水平与用户的信任程度动态匹配。

HAX 的 18 条原则之间其实是相互关联的整体。从交互前让 AI 校准用户期望,到交互过程中以人的思维给予反馈,最后,赋予用户最终的掌控权以巩固信任。因此,“HAX Toolkit”本质上也是一个信任校准的工具箱,以引导用户建立人与 AI 可持续的健康关系。

02 殊途同归的 AI 设计哲学

微软的 HAX 并非独一无二,在推导其背后的设计思考后,我们将其放置到 AI 行业中,对比不同公司的设计哲学。我们选择了微软、Google、Apple、IBM 这四个行业差异大、商业模式不同且企业文化不同的公司,看看他们对于 AI 秉持的态度。

微软

微软是基于六个负责任的 AI 价值观(公平、可靠与安全、隐私与安全、包容、透明、问责),核心以信任为基石,构建人机“伙伴关系”。而 HAX 原则是在体验和互动层面,将这些价值观落地到具体交互界面的实践指南 。

图片来源于微软 HAX Toolkit

谷歌

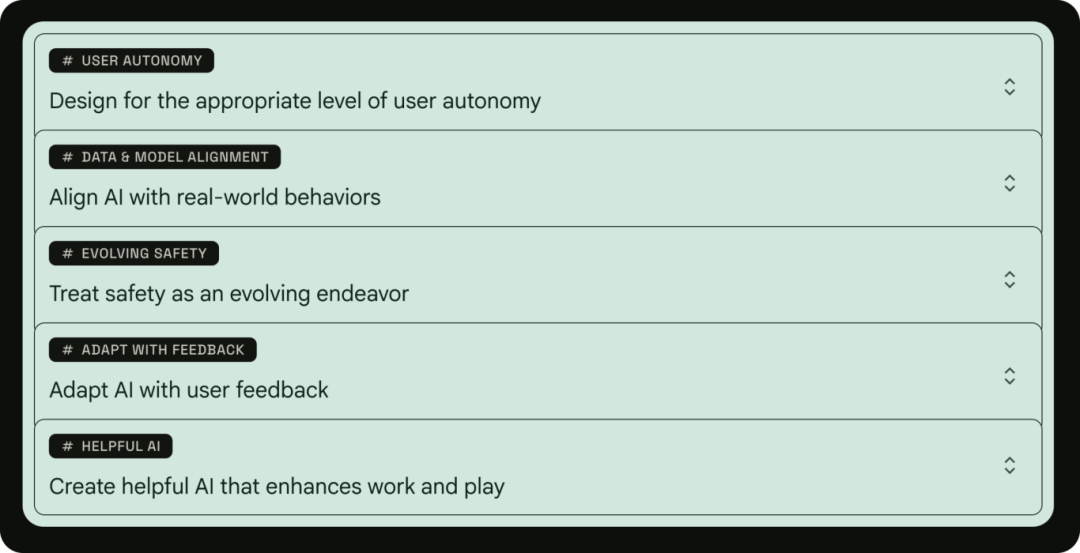

谷歌的“人与 AI 研究”(PAIR)项目和指南,强调 AI 的有用性和对用户的辅助。其设计原则聚焦于用户自主权、数据与模型的现实对齐、以及通过反馈不断适应 。

谷歌 PAIR 网站上的设计原则。

苹果

苹果在其《人机界面指南》(HIG)中,将用户控制、隐私保护和负责任的设计置于最高优先级。其核心理念是确保人类“始终掌控决策权” 。此外,苹果也提供非 AI 的备用方案来保证包容性,他们在未解决用户隐私与数据处理问题之前,始终推崇端侧模型。

苹果 HIG 中关于生成式 AI 的介绍。

IBM

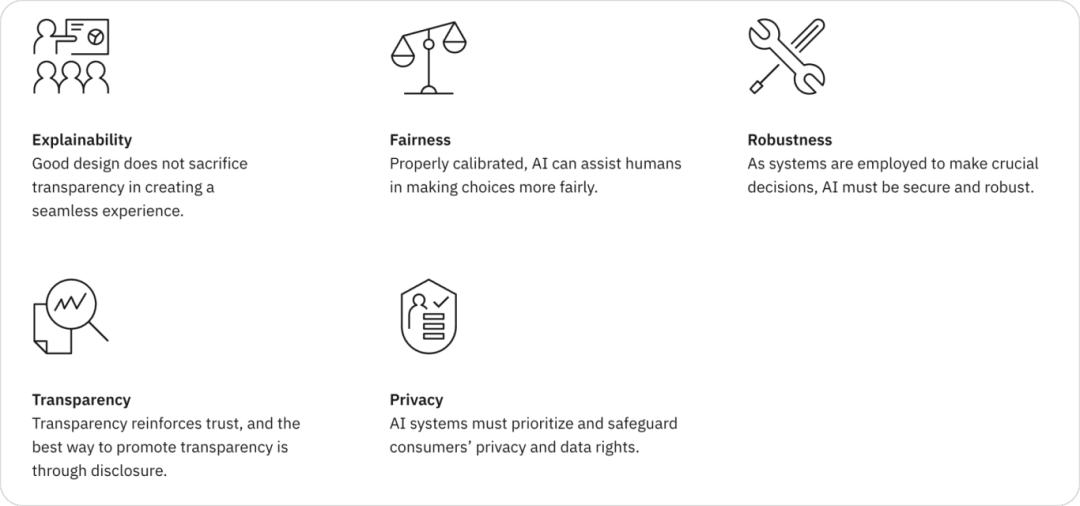

IBM,则是以企业为中心的视角,将 AI 的功能定义为“增强人类智能”,也强调信任支撑(可解释性、公平性、稳健性、透明度、隐私),构建可信赖的企业级系统。

IBM 关于 AI 的设计原则描述。

或许也都是因为人的生理和思维模式特征与 AI 的技术局限性,不同公司都有针对 AI 研究出匹配的设计原则,且似乎都期望建立一个“可控”和“有效”的 AI。微软 HAX 中关于灵活调用、高效控制的一系列指南(G7, G8, G17)并非一家之言,与苹果的“让人们保持控制主权” 、谷歌的“为适当的用户自主权而设计” 也都出自“可控”的设计哲学。

尽管他们在侧重点和设计实践中皆不相同,但都是希望解决同一个问题——如何赋予用户随时让“慢想”思维模式介入交互的最终控制权。

03 可实践的 HAX 原则概览

基于前两部分的理论基础和行业洞察,我们在较为宏大的技术发展背景下,来推测微软 HAX 原则产生的原因。这些原则并非假大空,而是在人、机、环境三者的复杂交互中,洞察了具体问题,并提供了可实践的操作指南。微软将它们分为初始、互动、犯错、演化四个时间阶段。

初始阶段——互动基础

微软是基于六个负责任的 AI 价值观(公平、可靠与安全、隐私与安全、包容、透明、问责),核心以信任为基石,构建人机“伙伴关系”。而 HAX 原则是在体验和互动层面,将这些价值观落地到具体交互界面的实践指南。

GPT 在对话页面输入框的底部常驻的提示。

【G2:明确系统能力的可靠性。】则直接回应了 AI 的概率性本质。如 GPT 会坦诚地在对话页面说明“GPT 可能会犯错”,引导用户采取批判的态度使用产品,而非盲目接受。这两条原则是卡尼曼针对“认知陷阱”粗暴、但有效的解法。它们通常作为校准信任和激活“慢想”系统的第一步,也是在人与 AI 交互前,塑造用户认知的关键一步。这与苹果“在使用功能前设置用户期望” 和谷歌“心智模型+期望” 的理念不谋而合。

交互中——情景感知

根据马文·明斯基的理论来看,这部分总体而言,是通过模拟“情感思维”机制,来减轻 AI 与个体、群体在交互中的认知负担,并提升信息获取效率。

【G3:基于上下文的时间服务(根据用户当前的任务和环境来确定何时采取行动或中断)】、【G4:展示上下文信息】强调 ,AI 通过理解用户的上下文和环境信息,自动调整响应,避免用户需要输入额外的情景信息,从而让交互更加自然、高效。

【G5:匹配相关的社会规范】、【G6:减少社会偏见】的核心,要求 AI 遵循社会规范、避免偏见,从而确保与用户的互动符合伦理和社交共识,减少不信任和抵触,提升交互的顺畅性。同样的,确保 AI 的反馈是符合伦理道德和包容的,也是各大巨头的共识。

犯错时——掌控与修正

这组原则涵盖了用户控制和错误处理的实时互动环节。能够轻松地唤醒【G7:支持高效地调用】、忽略【G8:支持高效地忽略 】或纠正【G9:支持高效地纠错】AI 的建议,以此增加用户对主体掌控感的心理暗示。

这种自主性是将系统的决策权交还给用户的“慢想”系统。让用户从被动的建议接收者,转变为一个主动的指挥者。对用户掌控感的执着,在苹果的 HIG 中体现得尤为突出 。

至于【G11:明确解释系统的行为】,也经过 CHI、Nature 等期刊论文的反复论证——AI 的可解释性是非常必要的。一个易懂的解释可以让技术透明化,也能让用户在了解技术原理后做出判断,从而激活人类的“慢想”思维模式。

长期互动关系的进化——记忆与适应

除了像 Mebot 这类一开始就以用户记忆为核心打造的 AI 产品之外,如 Gemini、GPT 近期也新增了基于用户搜索和对话的记录来生成个性化结果的功能。

个性化的功能本身,本质是提高工具效率的方式。

当 AI 的交互结果依赖于用户的记忆或个性化数据时,用户与 AI 之间的长期动态演进关系,就成为了一个必须考虑的体验难题。

人脑与机器在记忆机制上有显著差异,特别是在遗忘方面。人脑的记忆具有选择性和情景化,而机器的记忆则是完整的、文字化的、数据结构化的。

尽管如此,人类的记忆并非缺陷,反而是一种功能,可以帮助人类归纳、概括并排除无关细节。

AI 在记忆机制上,则有正反两面。

一方面,AI 的精准记忆【G12:记住近期的互动】 、【 G13:从用户行为中学习】确实可通过生成个性化结果的方式,以提高用户完成任务的效率。但另一方面,AI 往往会基于某次用户的偶然行为,生成“过度拟合”的结果。例如,我偶尔吃一次素食餐厅,就被漫天的素食、减肥推荐的广告笼罩。

这种记得太牢,但对情景理解不够的场景,你是否也似曾相识?

同时,这种突兀的推荐,也会导致用户产生严重的隐私担忧,苹果和 IBM 的 AI 设计原则中也都有对应的解法 。

HAX 原则为解决这个问题,强调 G13 必须与 G14、G17 整合成一个动态可控的进化体系。

【G14:谨慎地更新和适应】可以防止 AI 的行为变得难以预测,从而破坏用户原有的信任和认知。

而【G17:提供全局控制】则赋予了用户“让 AI 遗忘”的权力,不仅解决了用户的隐私担忧,也确保了人类在互动关系中的主导地位。

微软 HAX 原则的核心是打造 “能力清晰、可控且能进化” 的智能伙伴。设计思路源于对人类局限和优势的理解,目标是让 AI 技术在与人合作中不断校准信任,优化效率,最终形成符合人类认知特性的交互模式。

04 成为成熟的 AI

从史前智人高举的骨棒,到 HAL9000 的红色魅眼。我们与“工具”的关系正经历着一场认知和范式的变革。回到开头的那个问题:成熟的 AI 会是软件吗?或许,这个问题的价值不在于“成熟的 AI 是否会被定义成软件”,而在于“如何让 AI 变成熟”。微软的 HAX 与各家巨头的 AI 设计原则给出了殊途同归的解法,他们并非要束缚 AI 的发展,而是在人与机器的认知能力局限中,找到校准信任的度量尺,从而让老百姓放心与之共处。

参考文献

- HAX Team(2019). Hands-on tools for building effective human-AI experiences. Microsoft. https://www.microsoft.com/en-us/haxtoolkit/

- HAX Team(2019). HAX Design Library. Microsoft. https://www.microsoft.com/en-us/haxtoolkit/library/

- Takane Ueno, Yuto Sawa, Yeongdae Kim, Jacqueline Urakami, Hiroki Oura, Katie Seaborn(2022). Trust in Human-AI Interaction: Scoping Out Models, Measures, and Methods.

- Kahneman, D. (2011). Thinking, Fast and Slow. Doubleday Canada.

- Kahneman, D. (2011, October 19). The two systems of thinking. Scientific American. Retrieved from https://www.scientificamerican.com/article/kahneman-excerpt-thinking-fast-and-slow/

- Marvin, Minsky. (2006). The Emotion Machine Simon & Schuster. ISBN 0-7432-7663-9.

- Li, Y. et al. (2024) ‘Developing trustworthy artificial intelligence: Insights from research on interpersonal, human-automation, and human-ai trust’, Frontiers in Psychology, 15. doi:10.3389/fpsyg.2024.1382693.

- Responsible AI transparency report: Microsoft (2025) Corporate Responsibility. Available at: https://www.microsoft.com/en-us/corporate-responsibility/responsible-ai-transparency-report/

- Ai ethics (2025). IBM. Available at: https://www.ibm.com/artificial-intelligence/ai-ethics/

- Generative AI (2025). Apple Developer Documentation. Available at: https://developer.apple.com/design/human-interface-guidelines/generative-ai/

- People + ai guidebook (no date) Google. Available at: https://pair.withgoogle.com/guidebook/

图源来自网络公开资料,若涉及版权请联系修改。

本文由 @HAI Design 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益