AI产品经理不知道怎么选大模型?看这一篇就够了(上篇)

大模型选型已成为AI产品经理的集体焦虑,参数军备竞赛与榜单神话背后隐藏着无数陷阱。从迷信参数盲目选型到完全甩锅技术团队,本文深度剖析四大常见认知误区,揭示那些让产品经理付出惨痛代价的决策陷阱。

最近和好多AI产品经理聊天,大家都在问同一个问题:到底该怎么选大模型

市场上的大模型琳琅满目,吹的天花乱坠,每个参数都以亿为单位起步,性能榜单天天刷新

更要命的是,大模型江湖瞬息万变,几乎隔几周就冒出个“某某模型超越某某模型”“某某模型登顶榜单”的新闻,看得人眼花缭乱。微信群里同行们天天在讨论:“你用ChatGPT-5.2了没?Gemini-3-Pro怎么样?国内某模型听说也挺猛哦!”弄得我这种非技术出身的PM压力山大,生怕决策慢一步就落伍于时代。这种急迫感有时候反而容易让我冲动下决定,走不少弯路

更别提来自老板和客户的压力了。有段时间我们老板隔三差五就催:“听说某某模型很厉害,咱们咋还不用?”客户那边也天天问:“你们产品AI升级了吗?”弄得我只能硬着头皮含糊几句,心里直犯嘀咕:到底选哪个模型才能不辜负期待呢

作为产品经理,看着这么多模型,看参数看晕了,听技术天花乱坠也听懵了

说真的,我自己当初踩过不少坑,走过不少弯路

我见过有人选模型就跟拼配置似的,看谁的参数大、显存占用高就选谁;也见过盯着leaderboard(榜单)一通猛看,排行榜第一名不拿下心不甘;更有甚者,直接甩手把“大模型选型”这活儿全丢给技术同事——仿佛这是技术的事,产品不用操心。还有人觉得,大模型嘛,无非就是个新功能,集成一下就完事儿,没啥复杂的;或者干脆相反,只顾着模型本身的性能,完全没考虑咱自家业务适不适合

结果呢?一个个踩坑翻车现场,个中辛酸只有经历过的人才懂

我也不怕直说,当年我刚入行第一次负责大模型选型的时候,真是又兴奋又忐忑,结果搞出来的东西……唉,血泪教训,一言难尽啊

所以我特别想把这些弯路都摊开来聊一聊

如果你是AI产品新人,或者哪怕是老PM了但没碰过大模型选型的活,这篇文章也许能让你少踩坑

今天这篇是 上篇 ,先来说说那些常见的认知误区——就是我刚刚提到刚接触AI行业的那些“大坑”

了解了这些,你至少能知道 哪些路是死路,千万别走

至于到底该怎么正儿八经地选出合适的大模型,我们下篇再细聊方法论

好了,废话少说,咱们直接开整

PART 01 常见误区举例

误区一:看参数选模型

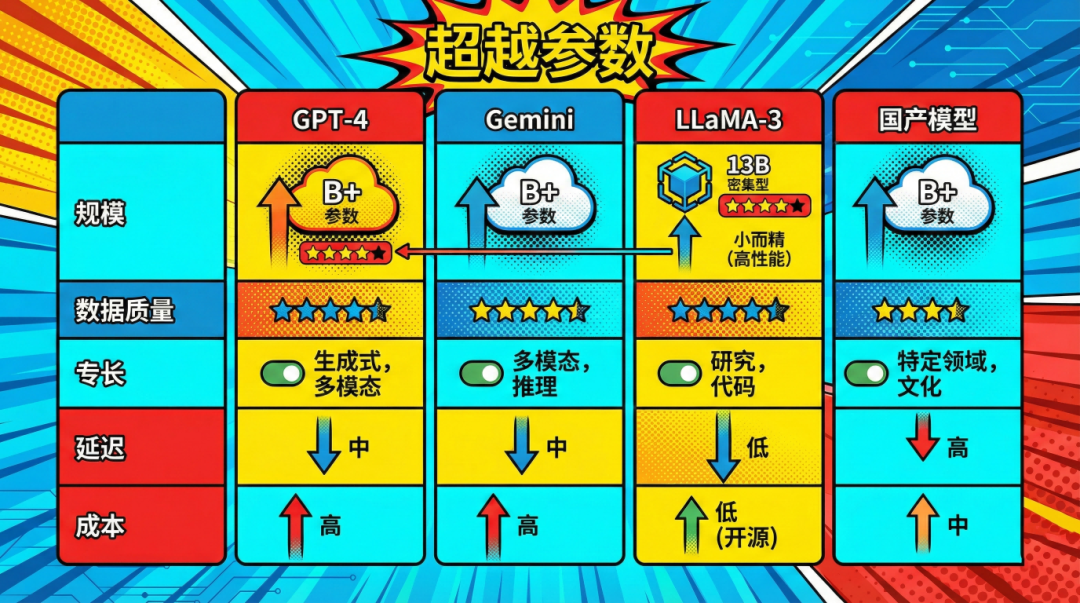

“这个模型多少参数?”这是很多AI产品经理张嘴第一句话。我当初也一样,听说GPT-4有多少多少亿参数,眼珠子都瞪圆了,心想这么大的模型不得吊打全场?后来别的模型出来,什么1300亿、720亿、7亿……一听这数字,下意识就觉得“小儿科”不值一提。参数越多越好,参数少肯定不行,在我脑子里这个“定理”一开始根深蒂固

说个当时的趣事吧。朋友团队那会儿做一个智能客服系统,我朋友拍着胸脯跟老板说:“咱直接上当时参数最大的模型,效果绝对好!”老板也不懂,就批了预算让他搞

老板 :参数这么大的模型效果肯定杠杠的吧

朋友 :(拍胸脯)没问题,您等着看

朋友兴冲冲拉着技术同事选了个参数量最大的开源模型,觉得有这么个“巨无霸”撑腰,客户问题回答肯定妥妥的。结果上线之后,噩梦开始了。他当时脸都绿了

首先,那个模型又慢又卡,每次回答用户问题都要好几秒,人家等得直发火。更惨的是,回答还牛头不对马嘴,跟没听懂问题似的。当心态直接从“豪情万丈”跌到“悔不当初”。技术小哥后来私下和他说:“哥,这模型其实不适合咱这场景,它是通用模型,没针对客服对话优化,再说参数太大,我们算力也跟不上啊。”到这时这才醒悟过来:原来参数大≠好用

回头想想,我之前也犯过这种鬼迷心窍,一门心思迷信“大参数 = 高能力”。但实际上,模型能力好不好,参数数量只是一个因素。有些模型参数没那么夸张,可人家训练数据质量高、架构牛,照样能把大模型按在地上摩擦。更别说针对垂直领域做过优化的小模型,在特定任务上常常比通用的大模型表现更亮眼

你可能也注意到,过去几年行业里有点儿“参数军备竞赛”的味道:动辄发布个几千几万亿参数模型,那家不甘示弱搞出更高参数的噱头。听起来是很震撼,但很多时候,这些数字更像营销话术,并不能直接说明实际效果。就好比相机像素飙到上亿,可照片质量还得看传感器和算法;模型参数炸上天,如果训练数据杂乱或模型架构有缺陷,照样出不了好结果。我们作为产品经理可不能光被这些表面指标忽悠,得擦亮眼睛看本质

再说了,参数越大意味着啥?意味着算力、内存、成本都蹭蹭往上涨。一个超大模型跑起来,可能每次调用费用吓死人,用户体验卡成PPT,公司还得搭服务器供着,性价比极低。如果产品需求并不需要那么顶尖的能力,选一个小而美、高效够用的模型,其实更明智。这方面我后来也有体会:宁可选一个适合我们场景的中等模型,也别一味贪大求全去供奉“性能怪兽”

后来痛定思痛,他们干脆换用了一个参数只有原来十分之一、但针对客服场景做过微调的模型,结果回答准确率和速度都比之前好了不少。那次之后在复盘会上,他总结到,再也不敢光看参数选模型了。于是整个产品团队开始关注模型的实际效果指标,还有使用场景的匹配度。有时一个几十亿参数的模型,经过精调,完全可以秒杀那个上千亿但未经调教的“大块头”。反之,你盲目堆参数,最后可能就是花大价钱请了个“笨巨人”,占着资源不干活,得不偿失

总之,参数大小只是手段,不是目的。用户不关心你后台用了几个亿参数,用户只关心产品好不好用。我们心里也得有杆秤:模型牛不牛,不光看块头,更要看跟需求的契合度。别让自己沦为参数迷信者,那样只会被营销噱头牵着鼻子走

误区二:只看榜单选模型

“榜单上第一的模型肯定最好,用它准没错!”很多人选模型就跟追星似的,看哪个模型拿了冠军、破了记录,就趋之若鹜。我也不得不承认,我当初也干过这种事儿。看到某个大模型在学术benchmark上成绩爆表,什么NLP九项测试吊打人类平均水平,心里那个激动:这不拿来做我们的产品简直天理难容

结果呢?现实给了狠狠一巴掌,真是猝不及防给他上了一课。举个例子吧,我有个朋友做机器翻译产品的,前阵子看到一个新模型在权威翻译榜单上夺了冠,英文翻中文据说超越了人类专业译者水平。他二话不说就让团队把这个模型用上了。上线以后才发现,翻一般文章还行,可一遇到他们那个细分领域的专业术语,翻译得一塌糊涂。客户反馈“这翻译啥玩意儿”,搞得他们灰头土脸,只能又把原先那套FAQ知识库请出来救火。最后才搞明白:那个模型在公开评测集上确实牛,但针对他们行业的数据几乎没见过,压根不懂那些专业词汇,榜单第一也救不了场

还有一次,我自己也差点掉坑里。当时公司想上一个对话机器人功能,业务一拍脑门:“听说X模型在对话理解排行榜上评分最高,赶紧拿来用!”幸好我多了个心眼,仔细研究了下发现,那个模型的确在学术数据集上表现很好,但它体积巨大难以部署,而且对话时经常胡编乱造(因为压根没针对我们的业务知识进行训练)。如果真上了,不仅用户体验糟糕,算力成本还得吓死人。后来我们冷静下来,改选了一个虽然榜单排名没那么耀眼,但更轻量、对业务内容有定制优化的模型,结果效果反而更好

另外还有个问题是,很多榜单衡量的都是模型在理想状态下的表现,可现实环境千差万别。特别是语言和数据差异,比如不少顶着榜一光环的模型是在英文数据上训练评测的,拿到中文场景里水土不服是常有的事。我就碰过这种情况:模型在英文对话数据上效果爆炸好,但换成我们中文用户的日常用语,它经常闹笑话,用词别扭不说,有些口语俚语压根听不懂。这要单看榜单成绩根本发现不了,非得到实际场景里才现出原形

还有那些比赛排行榜,说白了就是实验室里的“奥林匹克”。冠军固然厉害,但未必适合日常应用。就像奥运百米飞人跑得再快,你让他每天在闹市区给你送外卖,未必比得过骑电动车的小哥。模型也是一样,道理很简单: 最顶尖的不一定是最合适的 。产品选型追求的是解决特定问题的最优解,而不是炫耀式的性能指标

再一点,追榜单容易陷入疲于奔命的怪圈。你今天刚用上榜一模型,下个月人家新论文一出,又冒出个性能更牛的,你总不能见一个换一个吧?频繁换模型不仅开发成本高,用户体验也跟着折腾。与其盲目追新,不如踏踏实实选个稳定可靠、经过验证适合自己的模型长久打磨。长期来看,这才是对产品负责的态度

当然,我不是说榜单没参考价值。它可以作为一个初步筛选依据,让你知道目前业界顶尖模型有哪些。但 绝不能迷信榜单 。就算一个模型拿了无数第一名,你也得看它跟自己需求契不契合、有没有实践验证、能否落地。选模型不是选冠军,而是选 适合 你的那个。别最后搞成“高分低能”,数据上好看,业务上翻车

误区三:把选型交给技术

“选模型这么专业的事,我不懂,让技术选吧。”——相信不少产品经理都有过这种念头。毕竟大模型听起来太技术了,参数、算力、架构各种术语满天飞,很多PM一看就头大。我当年也有过这种想偷懒的想法,觉得自己反正不是搞算法的,不如全权交给懂技术的同事处理,省心省事。结果差点摔大跟头

时间回到刚工作那会,那次我们要给产品接入一个文本生成模型。我一开始还兴致勃勃研究了几天,后来越看越迷糊,各种论文看不懂,社区讨论更是天书一样。正好团队有个新来的算法工程师,对大模型如数家珍。我心想,有行家在,那干脆让他全权决定吧。我就跟他说:“模型你帮忙选吧,你专业你懂行,咱们听你的”

工程师小哥也挺高兴,爽快接下了。过了两周,他神神秘秘跟我说:“我选了个特牛的模型,最近刚发布的SOTA,我们赶紧用!”我一听SOTA俩眼一抹黑,反正不懂就全盘信任了。结果integration(集成)的时候问题来了:首先,那模型是研究界的新成果,代码不够成熟,各种bug,把后端工程师折腾惨了;其次,它对算力要求极高,我们线上服务器压根跑不动,部署了个阉割版上去效果大打折扣;更离谱的是,后来才发现那个模型的开源协议不允许商用,我们差点踩雷!好在及时刹车,不然后果不堪设想。这要真上线商用,被律师找上门,锅还不是得产品来背

那次项目搞得一波三折,最后临阵换模型,疲于救火,浪费了好多时间,那段日子大家都焦头烂额。总结教训,我真是后怕——当初要是稍微多参与把把关,也不至于差点掉坑里。 把选型完全丢给技术,产品自己撒手不管,这是不负责任的行为 。技术同事当然在模型评价上很有发言权,但他们也可能有自己偏好的技术路线,或者没顾及到商业化落地的种种限制。这时候如果产品经理没有参与决策,出问题了你都懵逼不知道咋回事

值得一提的是,走向另一个极端也不妙。有的产品经理也许自以为懂一点AI,就不听技术团队的建议,凭主观偏好拍板选型,这同样可能踩坑。曾有同行跟我吐槽过,他们产品负责人迷上了某个“据说很牛”的模型,不顾工程师劝阻硬要上,结果发现压根跑不起来,浪费了大把时间,还挫伤了技术同事的积极性。可以说,不管产品还是技术,一方独断专行都容易出问题

最理想的情况就是双方各司其职又相互配合。产品提业务需求和约束,技术提解决方案和可行性建议,大家一起评估权衡,最后达成共识。这过程里,产品经理不懂就虚心请教,多问几个“为什么选这个而不选那个”,技术同事也应该多解释、多科普,让产品了解选择背后的逻辑。这种“双向沟通”,远比各自闭门造车要高效可靠。毕竟目标是一致的:选出既满足业务又技术可行的方案,而不是搞内耗

当然,我不是让产品经理去僭越做技术的决定,而是说 选型是产品和技术的共同责任 。产品经理更懂业务需求和用户体验,技术更懂模型原理和性能、实现方案。双方必须多沟通,多碰撞,才能选出在技术上可行、业务上可用的方案。产品经理至少要对关键选型因素心里有数,比如模型的成本、响应速度、输出质量、可控性等等,不能全程当甩手掌柜。不然后期出乱子,你想补救都插不上手

说白了,大模型选型这事,产品经理既不能缺位,也不能越俎代庖。别怕自己技术不如专业的,承认不懂没关系,但一定要参与、要提要求、要问清楚坑在哪里。只有这样,才能和技术伙伴一起踩下刹车、选好道,避免一条路跑到黑

误区四:把大模型当成一个功能

不少产品经理一听说要上大模型功能,第一反应是:“哦,增加个AI功能嘛,小菜一碟。”仿佛大模型只是产品功能列表里新添的一行checkbox,勾上就完事儿,觉得不就是调用个接口返回内容吗,有啥复杂的

后来真干起来才发现,大模型可不像普通功能那样听话。举个经历,我负责过一个AI写作助手的项目。当时拿到模型API,我心想简单,前端一个输入框让用户输需求,然后调模型接口生成文本,展示出来,收工!结果上线一测试,问题一大堆:生成的内容风格前后不一致,偶尔还冒出不合适的用语;有时候用户提一点要求,它给跑题十万八千里;更离谱的是,有次它直接抄了一段网上的东西给吐出来,差点踩版权雷。那阵子我天天忙着救火,紧急加各种过滤规则、内容检测,还得设计个反馈机制让用户举报不良输出。我这才意识到,大模型生成内容不像普通功能那样可控,你得时刻想着“万一它说错话怎么办”

开发 :它又答非所问了,这AI也太不靠谱了吧

我 :要不我们再调调提示词试试,不然用户都要骂娘了

还有性能上的坑。当时没估计到调用大模型这么耗时,用户点一下等五六秒没反应,以为坏掉了。我们临时加了加载动画,用户还是嫌慢。最后不得不和技术一起优化请求链路,想尽办法降延迟,又是缓存又是提前生成示例的,折腾好几轮才勉强让体验过关。这在一开始设计功能时,压根没料到会这么麻烦,就因为把模型想得太简单了

现在回想,真是自己naive(天真)了,把一个AI模型当成普通小模块。其实它更像一个 活的东西 ,需要不断调教、反馈、约束,甚至需要制定一整套策略去管理它的行为。大模型输出的不确定性,注定了它不是甩个需求就能一次搞定的。产品经理如果抱着“加个模型功能”这种心态,上线后往往会发现现实在疯狂打脸

更重要的是,大模型往往会牵扯出一系列配套问题:比如隐私和安全,要不要给它设定防止乱说话的边界?用户教育,要不要告诉用户AI的局限让他们有心理预期?运营监控,要不要安排人盯着模型输出,及时干预?这些都是新增的工作量,绝不是接口接通就万事大吉那么简单

那次踩坑之后,我们后来总结经验,给这种AI功能配套了完善的“后勤”机制:比如建立内容审核和用户反馈渠道,一旦模型输出有问题可以第一时间处理;又比如定期根据用户提问来调整优化提示词,不断调教模型朝着我们希望的方向走;必要的时候,还可以考虑给模型做一些“减料”或“加固”——比如设定明确的回答边界,或者在模型外面再包一层规则检验。这些工作听着麻烦,但都是让大模型真正服务业务的保险措施。没有这些,你就真的只能祈祷模型乖乖听话,可一旦它哪天抽风,倒霉的还是我们自己的产品

还有一点挺有意思:引入大模型后,产品设计思路都会发生变化。过去做功能,我们大多追求确定性,流程怎么走、输出是什么心里有谱;可大模型输出每次都可能不一样,用户提问五花八门,这就逼得我们在交互上也做调整。比如要设计容错机制,万一AI答非所问怎么办?要不要给用户提示“这是AI生成,可能有错”?这些都需要重新考虑。所以啊,大模型功能真不是简单加在原产品上的“小插件”,它几乎是一种新物种,得用升级的产品思维去对待

总之,当你决定把大模型融入产品,就要做好打一场“持久战”的准备。一开始立项时多留点余地,把上面这些潜在的麻烦算计进去,后面落地才不至于手忙脚乱

好在经过这么多波折,我们的AI写作助手功能终于走上了正轨,用户反馈也逐步提升,算是没有白忙一场

所以现在我每次听到有人轻描淡写说“这个地方加个大模型功能就好了”的时候,我都会忍不住泼点冷水。 大模型不是一个简单的功能,而更像一项持续运营的能力 。它需要投入精力持续优化和监管,就像养宠物不是买回来就完事,你得一直照顾着。要有这个认知,才能在规划时预留足够的资源和时间,不至于后期手忙脚乱

误区五:只看大模型本身不看业务上下文

最后一个坑,可以说是很多AI项目翻车的根源:只盯着模型本身的牛X,不考虑业务场景的实际情况。简单来说,就是技术导向一头扎进模型优劣,却忘了想想:“这个模型放到我的业务里,水土合不合?”

我见过太多这样的例子。比如有团队看别人用GPT做客服问答效果很好,也不分析自己客服的问题类型,直接上来就接入一个通用大模型,结果发现用户问的很多细节它答不上来,反倒不如原先的搜索FAQ系统靠谱。还有些创业公司,听说某模型能生成漂亮的营销文案,就硬塞到自己的产品里,结果用户根本不买账,因为他们那个细分市场的调性跟模型生成的风格完全对不上。更有甚者,有的业务场景其实对精准度要求极高,一旦出错就有严重后果(比如医疗、金融),这种场景下还盲目上一个未经严格验证的大模型,简直是在玩火

我自己也差点犯过这毛病。记得有次我们想用AI给用户做个个性化推荐。我看中一个模型,擅长分析文本语义,评价很好,就想拿来用。后来多亏一个数据同事提醒我:“咱们推荐的核心依据其实是用户的行为数据,那模型再厉害,它不理解我们的用户行为模式也没用啊。”我这才如梦初醒:是啊,我们业务最重要的是用户行为数据,模型需要针对这些数据训练或调整才有意义。我之前光看到模型在通用语义任务上表现牛,就想生搬硬套,差点本末倒置

大模型本身很迷人,它的各种能力让人眼花缭乱。但 产品经理不能被技术牵着走 ,得始终记得自己的 指南针是业务需求 。每个模型都只是解决问题的工具,不是为了炫技而存在。如果一个模型不贴合你的使用场景,再牛的指标也没用。选型时,一定要把业务背景、数据条件、用户期望都考虑进去。比如你的用户群是中文为主,就别迷信英文榜单第一的模型;你的场景要求输出风格严肃正式,就别用一个以幽默见长的模型硬上;你的系统资源有限,那那些超大模型可能就自动排除……这些都是业务上下文,忽视不得

那业务上下文具体指什么呢简单列几项:

- 预览文章数据 :我们的训练/应用数据质量如何;是否需要先清洗、标注、积累数据

- 政策 :涉及隐私、安全和法律的要求有什么;选用的模型方案能否满足行业合规

- 用户 :目标用户是谁;他们接受什么样的AI产出风格,能容忍多少错误

- 资源 :团队技术实力如何;算力预算够不够支撑所选模型的部署和运行

- 指标 :业务想提升哪些核心指标;采用大模型能否真正带来这些提升,有没有更简单的替代方案

还有一个常见忽视点是数据和资源。很多团队盯着模型性能,却没考虑自己手头有没有足够的高质量数据来支撑。结果模型是拿来了,可喂进去的业务数据东拼西凑、噪声一堆,模型再聪明也巧妇难为无米之炊。要知道,大模型不是魔术师,它离了贴切的数据土壤,再牛的潜力也发挥不出来。所以在选型时,别忘了问问自己:我们的数据准备好了么?要不要先投入整理清洗数据、搭建配套的管道?这些可都是业务上下文的一部分

另外,各行各业的监管和风险也不容忽视。有些场景数据敏感,像金融、医疗领域,把用户隐私数据直接丢到外部大模型去用,就可能违反合规要求。如果产品经理只顾选模型,没跟法务、安全团队沟通清楚,到头来模型选好了才发现用不了,那就尴尬了。我身边就有真实案例:一家创业团队花了大力气接入某知名大模型,后来才发现因为数据出境的问题被监管部门叫停,前期投入打了水漂,团队负责人都快哭出来了。这教训足够惨痛吧

归根结底, 不要为了用大模型而用大模型 。就像一句老话:“手上拿着锤子,看什么都像钉子。”我们不能因为大模型很火很强,就硬往自己业务上套。反过来应该是:先认清业务的问题是什么,再决定用不用大模型,以及用哪个、怎么用。能用简单方案解决的,就别随便上复杂模型;真有瓶颈需要AI来突破,再去寻找最契合的方案。这不是保守,而是一种理性务实。技术为业务服务,而非相反,这一点永远别搞错了

说到底,大模型不是救世主,它再强也得落地到具体场景才能产生价值。我们要做的,是挑一个在 自己场景下 综合表现最优的方案,而不只是追逐技术的潮头。业务优先,技术其次,这个原则任何时候都不能丢

PART 02 写在最后

简而言之,如果你还以为参数越大模型越好、排行榜第一就绝对靠谱、选型完全可以甩给技术、把大模型当成随插随用的小功能,或者只顾埋头技术不看业务,那你可得悠着点——以上每一条都可能让你摔跟头

说了这么多,其实不管你承认不承认,这五大误区十有八九你我都踩过或者正在踩。毕竟AI大模型横空出世,谁都是摸着石头过河,踩坑在所难免。我自己当初真是每条都中招,现在回头看,真后悔当时没能早一点有人提醒我。这也是为什么我花这么多篇幅絮絮叨叨,把自己和身边朋友的踩坑经历都掰开了揉碎了讲给你听

如果你看完发现自己也中招了,先别灰心,也别觉得“完了全做错了”。能意识到问题就是进步嘛!这些坑踩过了,只要爬起来绕开,下次不犯就好。技术日新月异,谁还能没点认知误区呢,重要的是及时纠正方向

聊完了误区,你可能会问:那到底该怎么选型?避开这些坑之后,正道在哪里?别急,这正是我打算在 下篇 聊的内容。选大模型绝对是一门学问,涉及到方方面面:如何明确业务需求痛点、如何评估各种模型的优劣、怎么兼顾成本与性能、怎样规避风险等等一大堆问题。没有一种放之四海皆准的公式,但我会分享一些实战中摸索出的 方法论和思路 ,帮大家在纷繁选择中理清头绪,找到适合自己的路子

下一篇我们就具体聊聊这个“正道”到底怎么走,会有哪些步骤和坑点,再给大家几个实用的小建议。在这里先透露一个小例子:最近我带团队用新方法论评估了三个大模型选客服方案,最终选出一个最佳模型上线,果然比之前顺利许多。这套方法我们下篇细细道来,敬请期待!先消化一下上面的那些坑点吧。如果你中了一两个甚至全部中,也别不好意思,咱都是这么过来的。

好嘞,说了这么多,该去赶prd了,那咱下篇见~

本文由 @panda 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自作者提供

起点课堂会员权益

起点课堂会员权益

你朋友真多。。。

话又说回来了,我有一个朋友