闭源越跑越快之后,DeepSeek V3.2 如何为开源模型杀出一条新路

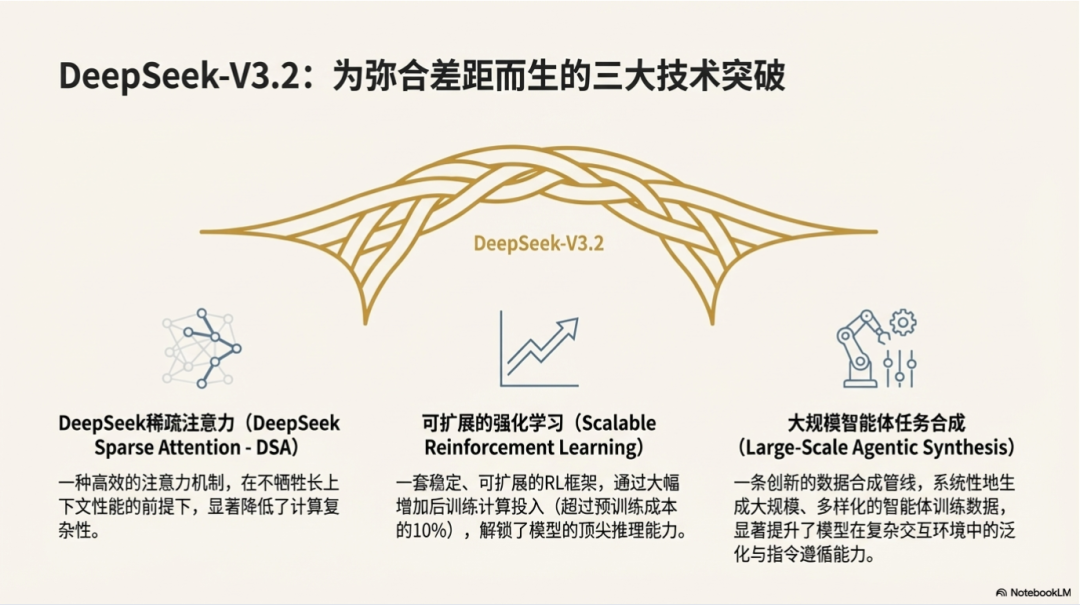

当闭源模型加速领跑,开源阵营如何突围?DeepSeek V3.2 以稀疏注意力架构、超10%后训练算力投入和大规模Agent合成数据,在成本压缩的同时逼近GPT-5级推理能力,为开源生态开辟了一条技术驱动的新路径。

过去一年多里,大多数权威评测仍然在反复强调同一件事:在最前沿的综合能力上,闭源模型的曲线更陡,开源想在所有维度上追平变得越来越难。DeepSeek 在技术报告中也承认:开源社区在进步,但 Anthropic、Gemini、OpenAI 这些闭源模型的性能曲线更陡,差距其实在拉大。在复杂任务上,闭源系统展现出越来越明显的优势。

目前开源模型有三个关键问题:

首先,在架构层面,当前主流仍高度依赖 Vanilla Attention 机制,这在长序列场景下会严重限制计算效率。这种低效对模型的大规模部署以及有效的后训练都构成了实质性障碍。

其次,在资源投入上,开源模型在后训练阶段普遍面临算力投入不足的问题,从而限制了其在高难度任务上的表现。

最后,在 AI Agent 场景中,相比于闭源系统,开源模型在泛化能力与指令跟随能力方面存在显著滞后,这削弱了其在真实部署中的有效性。

12月1号,DeepSeek发布了两款新模型:DeepSeek V3.2和DeepSeek V3.2 Speciale,针对这三个问题,提出了三个改进:

1. 引入了一种高度高效的注意力机制 DSA (DeepSeek Sparse Attention, 稀疏注意力),旨在显著降低计算复杂度。该架构有效缓解了效率瓶颈,即便在长上下文场景中也能维持模型性能。

2. 构建了一套稳定可扩展的强化学习(RL)协议,使得在后训练阶段可以大幅扩展算力投入。为后训练分配的计算预算超过预训练成本的 10%,从而释放出更高阶的模型能力。

3. 提出了一条新的数据流水线,用于在工具使用(tool-use)场景中培育具有泛化能力的推理。并推进到大规模的 agentic 任务合成阶段,在该阶段中构建了超过 1,800 个不同环境以及 85,000 个复杂提示(prompts)。这些大规模合成数据显著提升了模型在 agent 场景下的泛化能力和指令跟随能力。

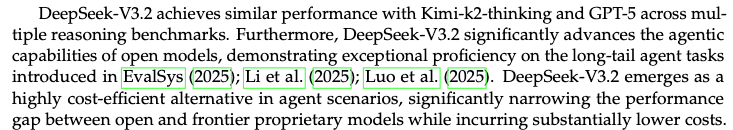

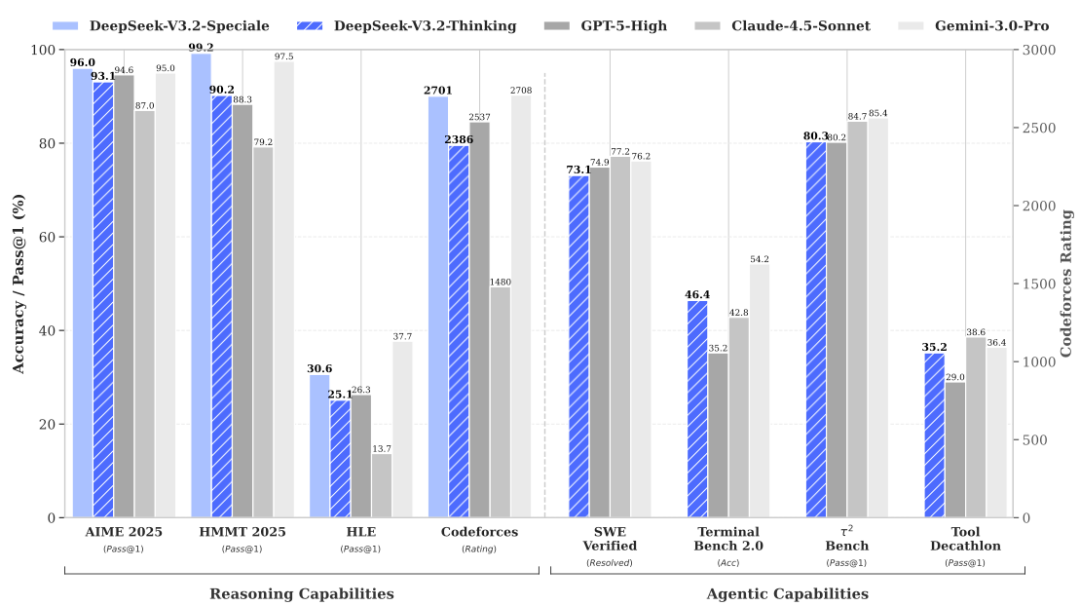

DeepSeek V3.2 在大幅压缩成本的前提下,推理能力做到了接近 GPT-5 的整体表现

效率黑科技:稀疏注意力(DeepSeek Sparse Attention)

1. 架构升级的唯一变动

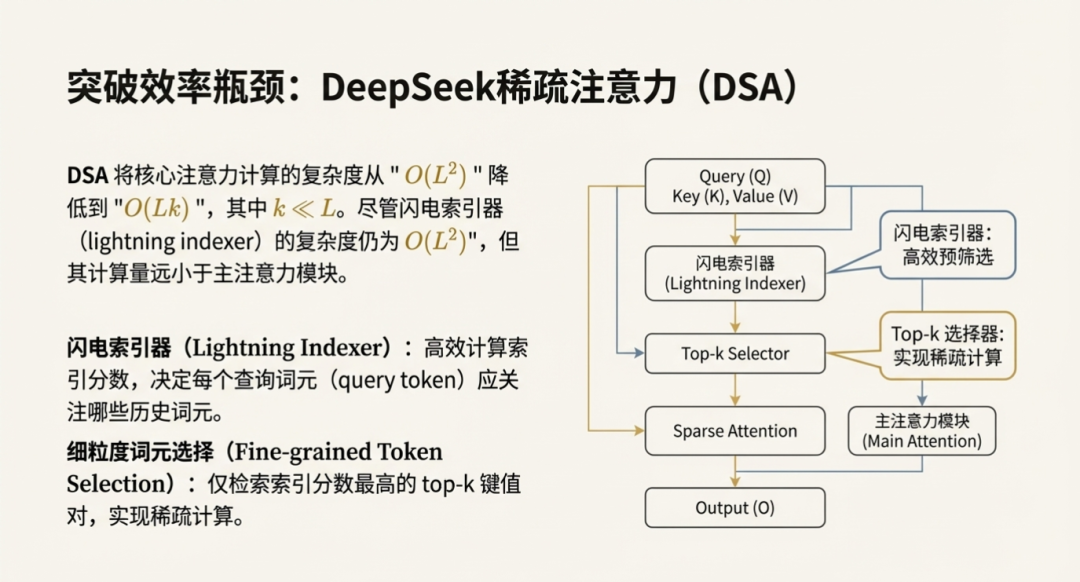

DSA 是 DeepSeek-V3.2相比前代 V3.1-Terminus 唯一的架构层修改。这一改进旨在解决标准注意力机制在长上下文场景下的计算瓶颈 。随着上下文长度(L)增加,传统机制的计算复杂度呈 O(L^2) 增长,这不仅降低了推理速度,也限制了后训练阶段强化学习计算量的扩展。

2. 两阶段稀疏化筛选机制

DSA 引入了一套包含两个组件的稀疏机制,将全量计算转变为选择性计算:

- 闪电索引:这是一个支持 FP8 计算的轻量级模块。它负责计算当前查询与历史 Token 之间的索引分数,从而确定哪些 Token 需要选中。

- 细粒度 Token 选择:根据索引分数,模型仅检索得分最高的 Top-k 个键值 (KV) 条目。主模型的注意力机制随后只对这些筛选出的条目进行计算,而非处理整序列。

3. MLA 框架下的实现方式

DSA 是在多头潜在注意力 (MLA) 框架下实例化的。为了最大化计算效率,它采用了多查询注意力(MQA) 模式,使潜在向量在所有查询头之间共享。这种结构设计优化了筛选路径和负载。

4. 复杂度降低与性能验证

该设计将核心注意力的复杂度从 O(L^2) 降低到了 O(L*k),其中 k 远小于 L 。2025 年 9 月的评估显示,DSA 在常规任务上相比密集注意力基线模型没有出现性能下降。在 AA-LCR 长文本推理基准测试中,其得分比上一代模型高出 4 分 。

后训练算力投入超过预训练10%

1. 算力策略重构:全能型混合训练

DeepSeek – V3.2 将后训练阶段的算力预算提升至预训练成本的 10% 以上,通过扩大后训练计算规模来实现性能突破。为了高效利用预算,团队摒弃传统分阶段微调,采用混合强化学习方案。

- 单阶段混合训练:将推理、智能体和人类对齐任务合并在同一个 RL 阶段进行。这种端到端的训练方式强制模型在同一套参数下平衡逻辑严密性与指令遵循能力,解决了传统多阶段训练中常见的灾难性遗忘问题。

- 专家蒸馏闭环:在进入 RL 之前,先训练数学、编程等领域的专家模型并将能力蒸馏给基础模型。混合 RL 阶段通过持续优化,填补了蒸馏留下的性能差距,使通用模型达到了领域专家的水平。

2. 底层算法优化与推理极限

为了支撑大规模 RL 的稳定性,团队对GRPO 算法进行了底层的数学修正,使模型能够承受高强度的训练压力 。

- 消除梯度噪声:针对原 KL 估计器在处理低概率样本时引入巨大噪声的问题,推导了无偏 KL 估计器;同时引入离策略序列掩码,直接屏蔽掉偏差过大且具有负优势的样本 。这些改进消除了系统性误差,保证了高强度更新下的收敛稳定性。

- Speciale 变体验证上限:基于稳健的算法,构建了DeepSeek V3.2 Speciale 版本,在RL 阶段移除了长度惩罚。实测显示,允许模型进行超长思维链推理后,其在IMO 2025 和 IOI 2025 中斩获金牌 ,硬实力追平闭源模型 Gemini 3.0 Pro。

对整个开源生态的意义

在 DeepSeek-V3.2 中,DeepSeek 团队沿用了之前的思路,在一个大家都以为只有巨头才能做大模型的时代,用新颖的思路和技术完成了弯道超车。Scaling law 的边际收益正在变得越来越小。要再复制一次从 GPT-3.5 跃迁到 GPT-4 那种量级的提升,已经很难只靠多堆数据和算力解决,谁能提出新的科学思路、训练机制和架构范式,谁才有机会打开下一段增长曲线。某种意义上,大模型又被拉回到了一个更偏“学术研究驱动”的时代。模型不是护城河,能力和落地才是。

DeepSeek 为整个开源社区做出了榜样和指引性的作用:如何在有限预算下重做架构、训练,重塑 Agent 体系,走出一条不依赖闭源的路。接下来这条路会延伸到哪里,无人能下定论,但故事远没有结束,让我们静待它在未来几年里,继续如何改写大模型的边界。

作者:Calvin、Roman、Laura

本文由人人都是产品经理作者【深思SenseAI】,微信公众号:【深思SenseAI】,原创/授权 发布于人人都是产品经理,未经许可,禁止转载。

题图来自Unsplash,基于 CC0 协议。

起点课堂会员权益

起点课堂会员权益

你好