从 OpenClaw 到记忆主权:把 AI 协作变成可迁移的个人资产

OpenClaw 的爆发式增长背后,隐藏着数字记忆主权的深刻变革。当AI助手从临时对话进化为长期协作伙伴,我们正面临一个关键抉择:是继续将记忆碎片化存储在云端平台,还是构建属于自己的认知资产工程体系?本文深度解析记忆层如何重塑人机协作本质,并揭示从工具效率到认知复利的价值跃迁。

2026 开年到 2 月初,OpenClaw 这波增长基本是按天在跳。1 月底刚冲过 10 万 Star,到了 2 月 7 日已经接近 17.1 万,这个速度确实很夸张。

大家最先讨论的,几乎都是同一层:它会不会操控电脑、会不会自动化流程、会不会自己写脚本、会不会变得更像“全能执行助手”。

这些都重要,但如果只停在这里,我觉得会看浅了。

我真正被击中的,不是 OpenClaw 多了几个按钮,不是它又打通了多少工具,而是我突然意识到:

你以为你在部署一个工具,其实你在决定自己的数字记忆到底归谁。

这句话听起来有点重,但我越来越相信它。

过去我们也有记忆:笔记、文档、邮件、聊天记录、历史项目、复盘结论。问题不是“有没有”,而是这些东西大多是静态存档。它们存在,但很难在关键时刻进入行动回路,更难随着时间持续校准。

OpenClaw 让我看到的,是另一种可能:

- 记忆不是只放在那里

- 记忆会被持续读取和调用

- 记忆会进入任务、决策和协作

- 记忆会随着你一起生长

一旦这个机制跑起来,事情就不是“工具升级”了,而是“认知资产开始工程化沉淀”。

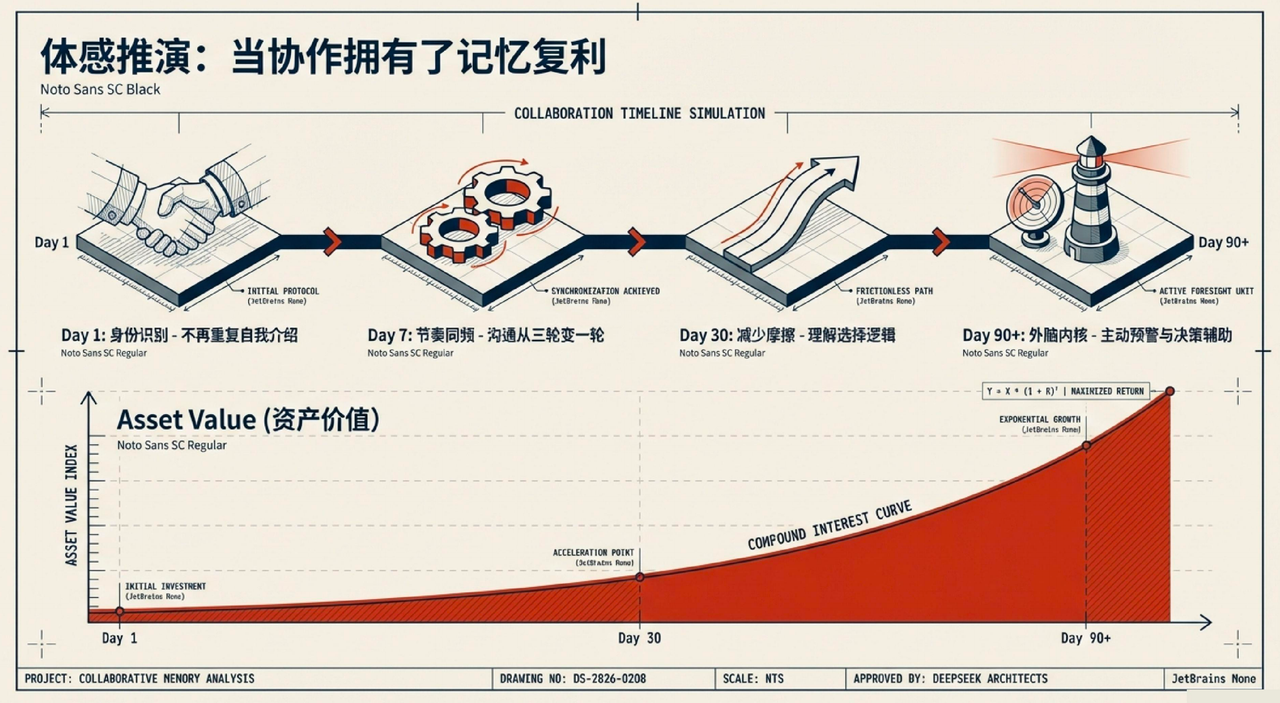

一、先讲体感:如果对话不再只是对话框,而是长期协作,会发生什么

我想先邀请你做个小小的想象。

如果我们和模型的关系,不再是“问一次、答一次、下次清零”,而是一个长期连贯的协作关系,会发生什么变化?

第1天:它先记住你是谁

第1天,它知道你叫什么、你在做什么项目、你偏好什么样的沟通方式。

这时候最直接的变化是:你不需要每次都重复自我介绍,也不需要每次都从背景重新开讲。

它不再是一个“每次对话都会失忆的助理”,而是开始积累关于你的基本记忆:你做什么、你关心什么、你接下来想做什么。

第7天:它开始摸到你的节奏

第7天左右,它会开始分得更清楚:

- 你什么时候只要结论

- 你什么时候需要完整推理

- 你什么时候要快速决策

- 你什么时候要一步步求证

很多原本要来回三轮才能对齐的沟通,会慢慢压缩到一轮。

而且它给你的产出,也更容易接近“你真正需要的那个版本”。

第30天:从“省时间”转向“减少摩擦”

到第30天,变化会更明显:这不只是节省时间,而是开始减少协作摩擦。

因为我们每做一件事,都会和它讨论,它也会持续记住我们的偏好和判断方式。

同样是做方案,它会逐渐看懂你在不同场景下的选择逻辑,慢慢理解你大概率会往哪个方向推进。

这就是我常说的“复利工程”:每一次协作都在给下一次协作打底。

第90天:它开始从助手变成“军师”

第90天之后,它更像是一个能参与决策讨论的协作者。

当它手里积累了足够多关于你的长期信息,它会更知道你在做重大判断时通常怎么想,也会记住你在执行任务时出过哪些错、为什么改过方案。

所以当你准备做判断时,它能给出真正有价值的提醒:

- 你之前在某类项目里犯过什么错

- 你上次为什么改过方案

- 这次推进时有什么地方要提前注意

你跟它聊“下一步怎么走”“这次应该怎么出手”,它不再只给一个泛化的方法答案,而是会更从你的视角出发,告诉你该怎么出手,甚至直接帮你执行。

一年后,如果你持续喂养这套记忆,它会更像一个“外脑内核”。

你可以换模型、换框架、换工具链,但只要记忆层连续,你的判断脉络不会断。它记得你如何思考,如何取舍,如何修正自己。

所以我现在不会用“效率工具”来定义这件事。

我更愿意叫它:

个人认知资产的长期建设。

而且这个过程会反过来改造你。

以前很多经验只停在“我大概记得”;现在你会更主动把关键判断写清楚,因为你知道它会被长期继承。以前项目结束就翻篇;现在你更愿意花十分钟复盘,因为这十分钟会变成未来很多决策的前置资产。

你会从“临场发挥型工作者”,慢慢变成“可复用能力建设者”。

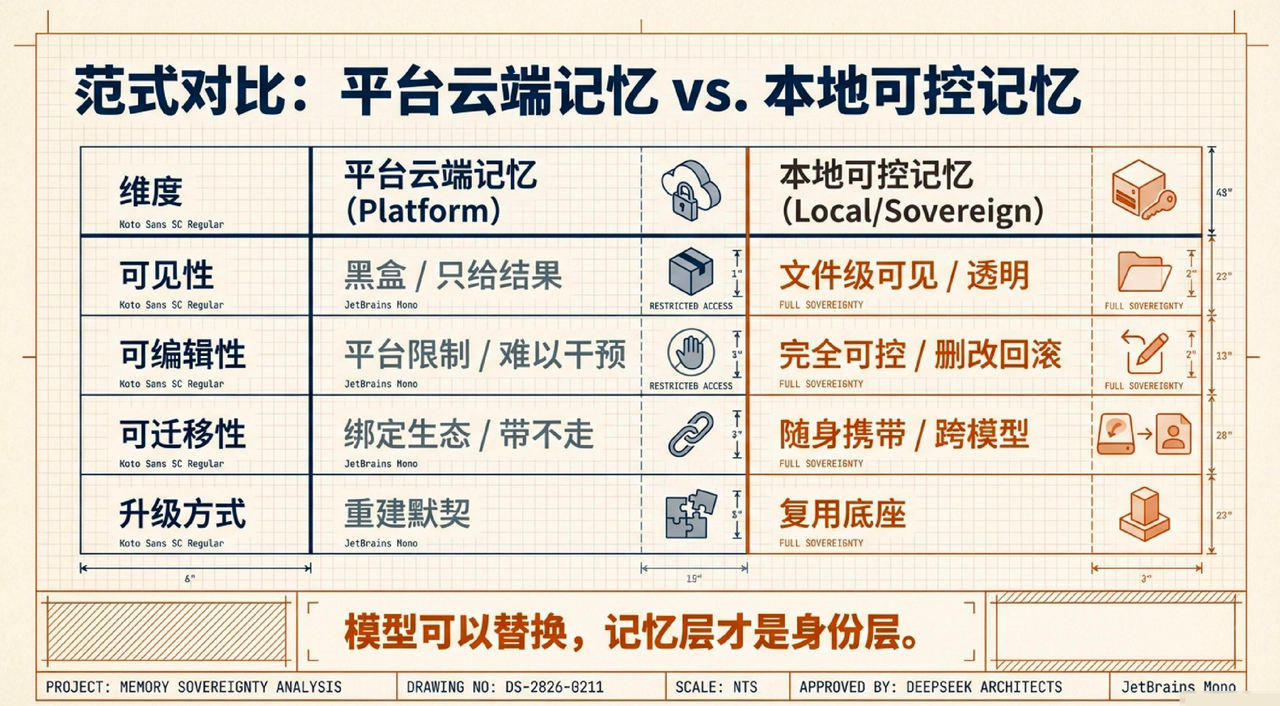

二、记忆主权到底在问什么:不是口号,是三个问题

“记忆主权”这个词很容易被喊成口号。

我自己的判断是,它至少要回答三个非常具体的问题:

- 我能不能看见它到底记了什么?

- 我能不能改、删、回滚?

- 我能不能把它带走,迁移到下一个模型和环境?

这三个问题如果答不上来,“主权”基本就是伪命题。

因为记忆不是越多越好。

错误记忆、过时偏好、被污染的信息,都会变成负资产。你需要像维护代码一样维护记忆:有版本、有回滚、有清洗。

这里我特别在意一个架构思路:

记忆在本地,大脑在云端。

你可以把推理和生成能力交给不同模型去做(GPT、Claude、Gemini 或未来更强模型),但“这个 AI 是不是你的 AI”,最终看的是它接入的记忆层是谁的。

如果记忆层在你手里,每次换大脑都是升级。

如果记忆层不在你手里,每次换大脑都像重训一个新人。

我现在越来越相信一句话:

模型可以替换,记忆层才是身份层。

下面这张表,是我结合当前数字分身实践(Memory MCP + md 双写)总结出来的差异。

所以我现在不太纠结“当下谁更强”,而更关心“我的记忆底座有没有在持续变厚”。

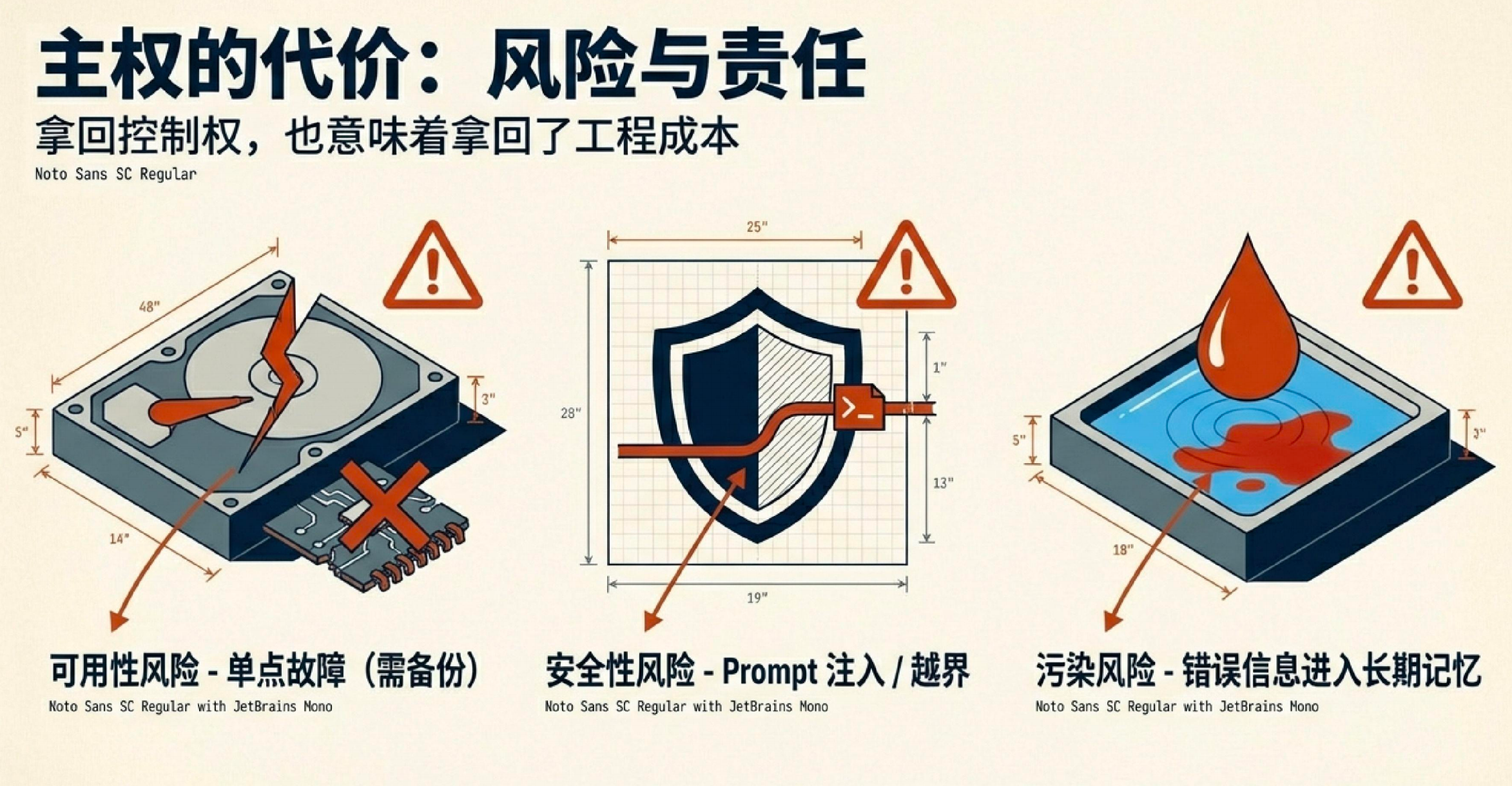

三、主权的另一面是责任:你拿回控制权,也拿回工程成本

我很喜欢“主权”这个词,但它绝对不是轻松的词。

把记忆拿回本地,确实更自由;但维护责任也同步回到你身上。

最容易踩的坑,通常有三类。

1. 可用性风险:你以为它会一直在

没有备份的本地记忆,就是单点故障。

硬盘问题、误删、系统崩溃,都可能让几年积累直接蒸发。以前风险由平台兜底,现在风险由你兜底。

2. 安全性风险:你以为本地就天然安全

本地不是绝对安全,本地只是风险形态变化了。

尤其是高自主 Agent,具备下载、执行、调用工具链的能力。权限边界没设计好,它既可能高效放大收益,也可能高效放大风险。

更现实的一点是,它还可能被线上内容里的 prompt 注入带偏。比如在下载或调用某些 skill、插件、脚本时,如果来源不干净,系统可能会误改你的本地文件、偏好配置,甚至把异常信息写进长期记忆。

3. 记忆污染风险:最隐蔽、最容易被低估

当系统可自动读写记忆,低质量信息和错误信息会进入长期层,并在后续任务中反复出现。你会感觉“它越来越像你”,但也可能“它越来越像一个被带偏的你”,最后直接影响你的判断和执行,导致关键任务出差错。

所以我的态度一直不是“要不要用”,而是“怎么可控地用”。

我现在坚持三件基础动作:

- 备份:本地一份 + 异地一份 + 版本化

- 隔离:记忆写入与高风险执行分开,默认最小权限

- 审计 + 周对齐:保留变更轨迹,至少知道何时、为何、改了什么;每周和它对一次记忆,看看最近变化、记忆顺序和关键偏好是否还对,把这个过程当作一次轻量复盘

这三件事不炫技,但决定了你的记忆系统是资产,还是未来的大坑。

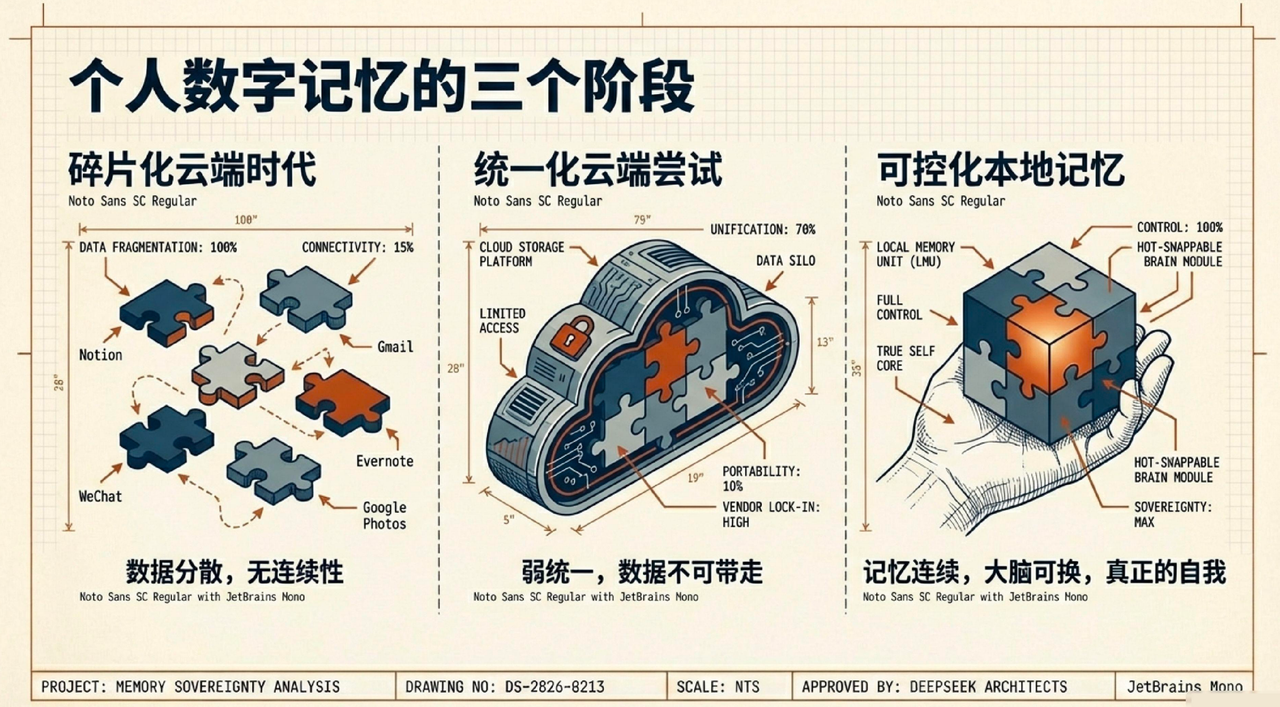

四、从碎片到可控:个人数字记忆的三个阶段

把时间线拉远一点看,我们其实正在经历个人数字记忆的一次根本性变迁。

第一阶段:碎片化云端时代

你的邮件在 Gmail,照片在 iCloud,笔记在 Evernote,文档在 Google Drive,聊天记录在微信和 QQ,工作资料又在飞书、钉钉、腾讯文档。

每个平台都掌握你的一部分记忆,但没有任何一方,包括你自己,拥有完整图景。你的数字生活像一面摔碎的镜子,每一片都在不同地方。

结果就是:数据越来越多,但可用连续性越来越弱。

第二阶段:统一化云端尝试

AI 开始扮演整合者,你开始习惯把资料丢给 AI 做总结、做归纳、理思路。体验确实更好了,你不用每次都从头翻一遍。

而且在持续对话中,它也会慢慢记住一些你的偏好。比如 Claude Projects 会记住项目背景,OpenAI Memory 会跨对话延续一些习惯。

但问题同样很现实:这些记忆大多还是在云端平台里。你能看到结论,不一定能审计来源;你能使用能力,不一定能迁移资产。很多时候你还是得先自己把资料找出来,再喂给它。

这一步是进步,但更像“弱统一”。

第三阶段:可控化本地记忆

第三个阶段,就是现在开始的可控化本地记忆。

OpenClaw 不只是一个聊天窗口,它是一个能自主操作的 Agent。它可以在你授权的范围内,去邮箱、飞书、钉钉、腾讯文档等地方,做长期脏活:读取、整理、归类、关联、校准、写回。

真正的变化是,你不再靠手动复制粘贴把碎片凑起来,而是有一个懂你的协作伙伴,持续把散落记忆串成一条线。

而且记忆是连续的。只要换个更好的大脑,你的个人助理就会跟着升级。记忆不丢,理解不断。

一句话总结是:

以前你在不同平台留下痕迹;现在你有机会在统一记忆里形成自我。

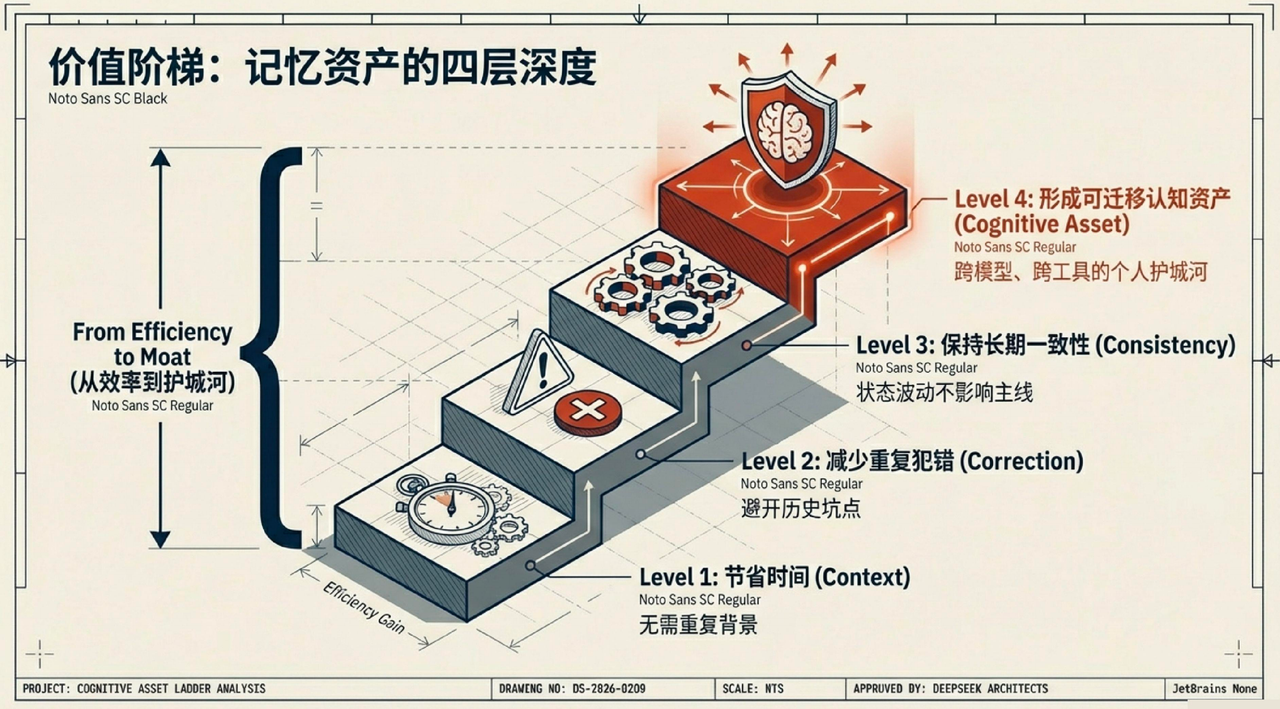

五、为什么我越来越看重“记忆深度”,而不是“工具强度”

工具能力会迅速同质化,这是大趋势。

今天某个 Agent 能做的自动化流程,明天很可能有十个替代品都能做。价格会下降,门槛会降低,差异会收敛。

如果你只买“工具能力”,护城河很薄。

真正难复制的是你的长期记忆网络:

- 你怎样决策

- 你为什么犹豫

- 你在什么约束下会改变策略

- 你在哪些问题上绝不妥协

这些不是 API 文档能替代的,只能靠时间沉淀。

所以我现在更愿意把价值分成四层:

四层叠加,才是记忆的复利。

这也是为什么我会强调:

现在开始积累,比等“完全成熟”再做更重要。

记忆资产本质上是时间函数,晚一天就是少一天复利。

六、上下文窗口会限制模型,但不会限制你搭底座

很多人会说:模型还不够稳定、长上下文还会掉质量、复杂任务还会漂。

这些都是真的。

但这并不构成“先不搭记忆系统”的理由,反而恰恰说明底座要先搭。

我的理解是:

- 模型上下文像短时工作记忆,能力强但窗口有限

- 你的记忆体系像长期记忆,增长慢但可持续累积

- 模型能力会持续变强,窗口会变长,长文处理和注意力也会越来越稳

只要长期记忆层是可结构化、可检索、可调用的,每次模型推理都能站在更高起点。

你甚至可以假设,未来某一天,它真的能检索你整个人生信息,还能准确讲出很多关键节点。

但问题是,你不可能等到那天,再从你的碳基大脑里把过去所有信息一次性“吐”给它。这件事不现实,也不可靠。人的记忆会漏、会错、会重写。

所以关键不是“等它足够强再开始喂”,而是“从现在开始持续积累”。

因为模型会持续升级,而你现在修好的“路网”会持续吃到升级红利。

车会换,路不会白修。

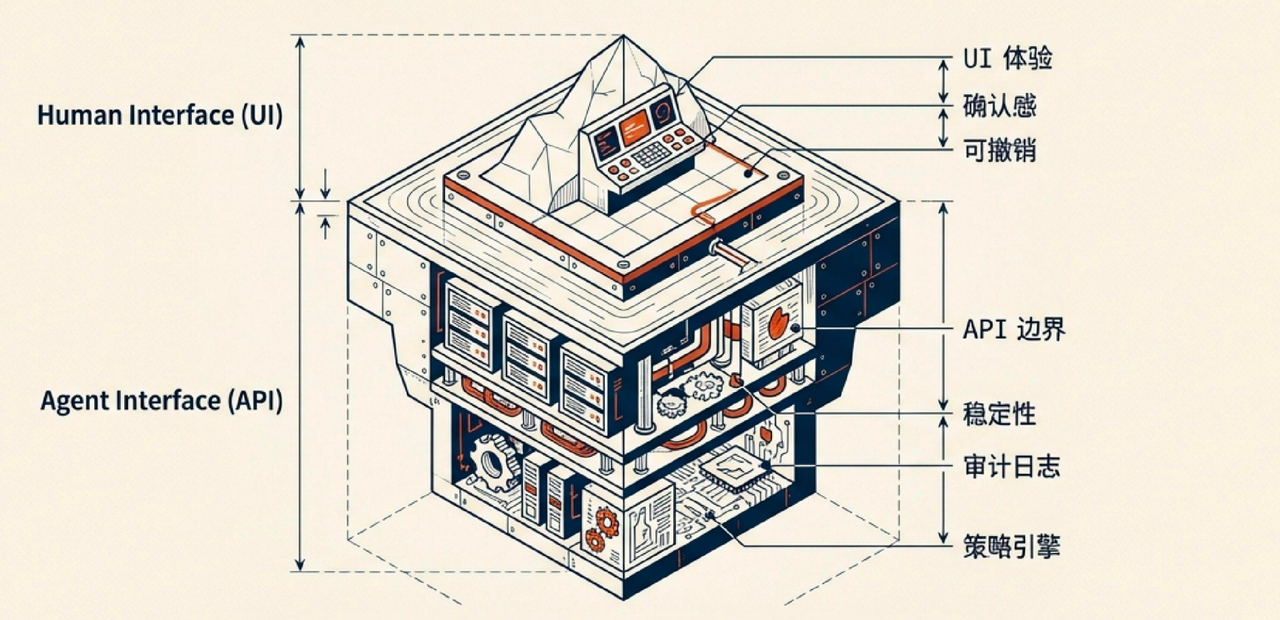

七、当 Agent 成为入口,应用层到底怎么变

我不认同“App 会消失”的极端说法。

人一定还需要 UI,尤其在高风险事务上:可见、可确认、可撤销,这些能力不会过时。

但应用层重心确实会后移。

过去很多产品围绕“人如何一步步点完流程”;未来会越来越多围绕“Agent 如何安全、稳定、可审计地调用能力”。

你会看到前台变轻、后台变重:

- API 能力边界

- 权限系统

- 策略引擎

- 审计日志

- 回滚机制

这些会从“支撑层”变成“竞争层”。

因为 Agent 能理解整套能力,不会像普通用户那样只用到 20% 功能。只要授权,它会把能力组合调到更深层。

这会倒逼产品从“好看好上手”,升级到“可编排、可治理、可托管”。

这里还有一个容易被误判的点:模型变强,不等于每个人都要从 0 到 1 重新造一套产品。

多数场景更现实的路径是:复用成熟产品 + 少量定制。如果一个产品已经能覆盖 80% 到 90% 的需求,你补一点接口、规则或配置,通常比重建一套系统更省力、更稳,也更符合算力和维护成本的现实约束。

所以未来的产品,不会只是“给人用”或“给 AI 用”二选一,而是要同时服务两类使用者:

- 人类用户关注 UI 体验、确认感和可控性

- Agent 用户关注可调用性、稳定性和策略边界

分发逻辑也会变化。过去是人自己看广告、搜关键词、比产品;未来会越来越多变成 Agent 作为“代理人”,按你的偏好主动去筛选最适合的工具。

这也会推动产品进一步细分:在特定场景里做得更深、更准,才能被人和 Agent 同时选中。

对应地,产品经理角色也会变化:

- 不只是设计用户路径

- 还要设计 Agent 路径

- 不只看转化效率

- 还要看权限边界、异常兜底与策略冲突

一句话:

产品会从“让人会用”,走向“让人和 Agent 都能安全地用”。

八、为什么这会加速“个人公司”

过去“一人公司”很多时候更像口号,核心瓶颈是带宽。

你再努力,也会被重复沟通、重复执行、重复复盘消耗掉大量时间。

一个有长期记忆的 Agent,不只是多了执行手,更关键是它在守住业务上下文:

- 不用每次从零写背景

- 不用每次重讲品牌语气

- 不用每次重复决策原则

它记得你过去怎么做,也能按同一套标准继续推进。

这会把“临时爆发”慢慢改造成“稳定产能”。

你可以把这个结构理解成:你是这家“一人公司”的 CEO,你的主 Agent 是总控台,下面再按岗位拆出一组子 Agent,像小员工一样各自处理不同任务,然后把结果回流给你。

我甚至认为,很多小团队未来的扩张顺序会变:

先扩“记忆化 Agent 编队”,再扩人。

但这不代表真的“只有一个人”。现实里我们仍然需要团队,也仍然要招人。只是未来你招来的,可能本身也是“超级个体”:每个人背后都有自己的 Agent 系统。

这样一来,协作会变成两层并行:

- 线下是人和人协作

- 线上是各自 Agent 和各自 Agent 协作

这会明显加快信息对齐和协同效率。比如你忙的时候,Agent 可以先帮你处理物业消息、员工沟通、常规回复,晚上再把关键信息回流给你,让你只抓决策层和优先级。

所以核心不是“人被替代”,而是把人的精力从高频低价值沟通里释放出来,回到真正重要的判断和创造上。

九、未来判断:记忆元年、DeepSeek 时刻与 AGI 前置准备

这一章我分三步讲,读起来会更顺:先看事实,再看趋势,最后落到行动。

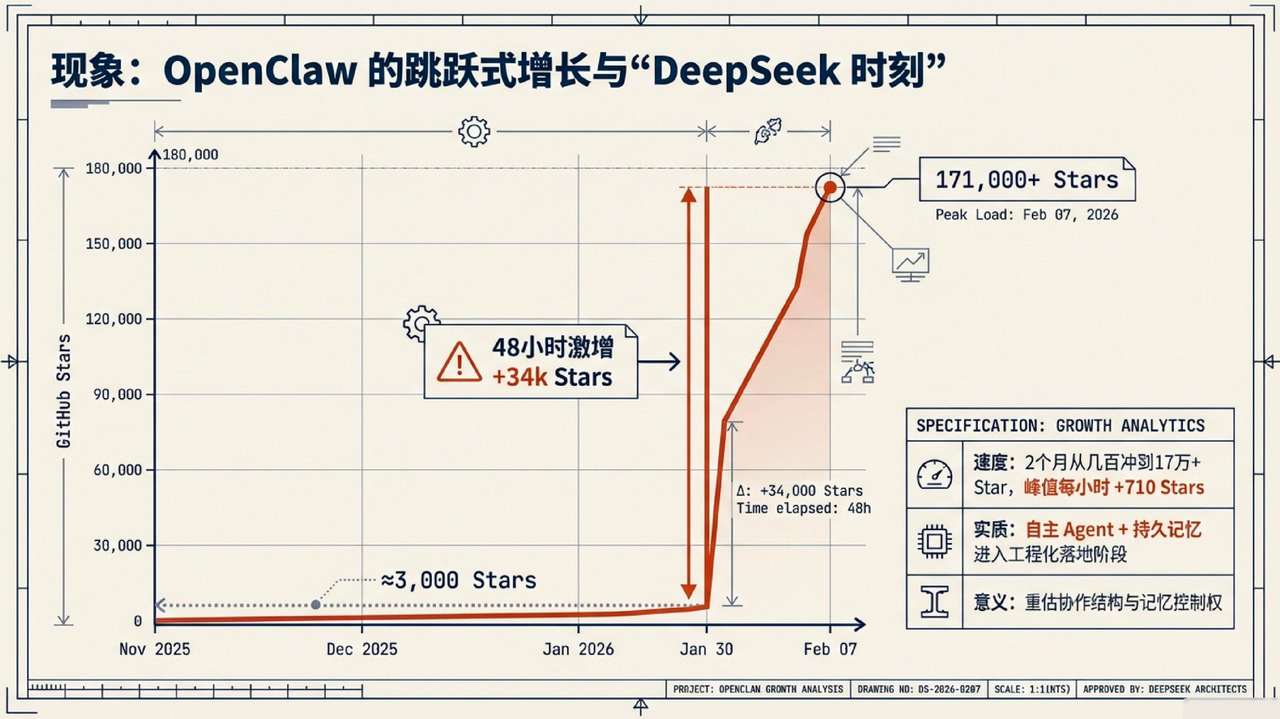

1) 先看事实:OpenClaw 的增长不是“快一点”,而是“跳跃式”

但 OpenClaw 这波增长,确实把“自主 Agent + 持久记忆”这个方向推到了台前。公开里程碑看下来,速度非常夸张:

- 2025-11 底:项目开源发布(原名 Clawd),仅几百 stars

- 2026-01-12:约 3,200 stars

- 2026-01-25:正式推广启动,单日冲至约 9,000 stars

- 2026-01-30:改名为 OpenClaw,48 小时内净增约 34,168 stars,突破 106,000 stars

- 2026-02-02:约 145,000 stars

- 2026-02-07:GitHub 仓库显示约 171,000 stars

换句话说,从“开源发布”到“17 万星”,只用了两个月;从“千星级”到“10 万+”,只用了 18 天。最疯狂的 48 小时(1 月 28 日到 1 月 30 日),日均增速折算到每小时约 710 stars。

这种增长不是按月在爬,而是按天在跳,按小时在冲。(注:以上为公开记录与社区统计口径,具体数字会随时间变化)

2) 再看趋势:为什么它很像一个 DeepSeek 时刻

如果让我非常主观地分期:

- 2023:对话能力被大众看见

- 2025:行动能力开始规模落地

- 2026:记忆能力可能成为新分水岭

我说“可能”,是因为技术演进从来不是单线程。机器人、端侧推理、世界模型都可能同步爆发。

我也愿意把这一刻称作一种“DeepSeek 时刻”,但维度不完全一样。

DeepSeek 让人重估的是模型能力与开源路径:原来模型不一定只能依赖中心化巨头。

OpenClaw 这类探索让我重估的不只是记忆控制权与协作结构,还有一件更硬核的事:自主执行正在进入真实世界。

它不是单纯会聊,而是能在授权后 24/7 执行任务、调用工具、自己组合流程,甚至在一些场景里做“自我叠加式”迭代。这个点,才是很多人既兴奋又害怕的来源。

更现实的是,如果你用的是云端模型,这些高频任务轨迹会持续沉淀成新一轮优化素材(是否用于训练取决于各家策略和开关)。这意味着“能操纵电脑”的能力,会在真实使用里加速被打磨。

从这个角度看,它和机器人领域有点像:以前总说能力上不去是因为数据不够,现在一旦开始规模部署,数据飞轮就会转起来。当然,风险也同步放大。前面提到的恶意 skill 事件已经说明了:这不是实验室问题,而是现实攻防问题。

至少在我观察里,持久化记忆这件事,已经从概念讨论进入工程问题:

- 记忆能否长期持久化

- 能否控制写入污染

- 能否跨模型迁移

- 能否被用户审计和治理

如果这些问题开始被大规模正面回答,我认为“记忆元年”这个判断就站得住。

3) 最后落行动:AGI 来不来,都要先做前置准备

很多 AGI 讨论容易变得很玄,但我自己的结论非常务实:

现在最值得做的,不是幻想它能替你做多少事,而是提前准备好一套高质量、可迁移、可治理的个人记忆资产。

因为那会是你和更强智能的对接层。没有这层资产,再强的大脑也是“陌生的强者”,协作仍然要从零开始。

有这层资产,你是在升级一个已经懂你的系统。不然就会出现一个很尴尬的情况:模型变强了,但你还要从零开始“重新介绍你自己”。

这就是我说的“本金逻辑”:

- 存钱是为了未来有选择权

- 存记忆是为了未来有认知主权

十、我自己在执行的最低可行方案(可直接上手)

这不是教程,但我可以给出我现在在做的最低可行动作,都是能立刻开始的。

1. 先分层:长期记忆与临时对话分开

把稳定偏好、长期目标、关键项目脉络、重要关系约束单独管理,不和日常一次性聊天混在一起。

2. 再设门槛:默认不自动写入长期层

情绪性表达、未经验证信息、短期时效内容,不自动入库。宁可慢一点,也不要脏。

还有一个小习惯很关键:重要信息要显式下指令让它写入。不要默认它“自己会懂”。像偏好变化、关键截止日期、阶段性决策,最好明确说一句“这条记进长期记忆”。

3. 固定节奏:每周一次轻量审查

删过期、纠错误、补标签、标时间。记忆系统不怕小,怕失控。

4. 先把备份做起来

哪怕只有几十条核心记忆,也请尽快版本化备份。越早做,成本越低。

5. 记忆资产与模型解耦

模型可以持续试错和切换,但记忆结构不要绑定单一产品。

模型是流动的,记忆资产必须稳定。

再补一条实践经验:敏感信息尽量按场景隔离。工作和个人可以分开管理,至少在习惯上分清“什么能长期存、什么只短期用”,这样更安全,也更不容易把记忆层弄脏。

这五步看起来普通,但会直接决定一年后你拥有的是“方便工具”,还是“可迁移的个人记忆系统”。

十一、回到开头:我为什么写这篇

我写这篇,不是想证明 OpenClaw 已经完美。

它当然不完美:有门槛、有维护成本、有安全挑战,也有现实边界。

但这些都不影响它的意义。

它把一件过去很抽象的事,变成了普通人可触达、可验证、可治理、可迁移的现实问题:

个人记忆主权,不再只是理念,而是可以工程化建设。

所以我现在不太焦虑“哪个工具今天最火”,也不太执着“每个热点都要追”。

我更在意的是:

我的记忆底座有没有在持续成长。

因为热点会换,模型会换,平台会换。

但如果记忆层在成长,你就在持续拥有未来。

最后我把这篇收在一句最简单的话上:

你可以继续把记忆托付给平台。

你也可以从今天开始,把记忆变成自己的长期资产。

我已经在做后者。

本文由 @ChenXiaowu 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益