Seedance2.0 重塑AI短剧的生产范式

AI短剧制作的游戏规则正在被彻底改写!Seedance 2.0导演级模型的横空出世,直接淘汰了传统工业组装式的工作流。这套统一多模态架构不仅能理解复杂剧本,更实现了从分镜设计到音画合成的全流程智能化。本文将深度拆解这场技术革命如何让创作者从工具切换的泥潭中解放,真正回归创意本身。

前段时间,我刚和几个在AI短剧赛道创业的朋友吃饭,准备年后合作一把,整个大的……

你说这玩意儿整的,大家道心直接破碎了… 和卡兹克一样的心情(当然,按体量来说,还是他更痛一些[狗头]),前段时间还在看他发的视频,其实他也还有另一个身份,是在影视行业做AI工业化的从业者。他说在剧组积累了非常多的经验,包括搭建了非常多的工作流全部付诸东流,一夜之间全部废弃。

我只能说,感同身受。

前两天热火朝天还在布局,筹划AI短剧的工作流和资源,突然用不上了。

这种感觉就像是农民累死累活一茬一茬收麦,甚至总结出了很多经验:刀口斜着朝下割的快、帽子里面塞个冰贴不怕中暑…..

然后扭头发现邻居老张的儿子在大棚下吃着冰棍,自动割麦机在地里自动收割 !

引用《黑神话:悟空》的制作人冯骥冯老师的一句话,

AIGC的童年时代,结束了。欢迎来到AIGC的青年时代。

这篇文章,我想结合我和朋友最近研究的一些资料,特别是关于传统AI短剧制作流程来聊聊AI短剧制作的过去、现在和未来。

现在这套流程已经是过去式了,可以称之为”传统”了……

01 传统AI短剧制作

在聊Seedance 2.0之前,我们得先搞清楚,以前的AI短剧是怎么做出来的。

很多人可能觉得,不就是找个视频生成模型生成几段视频,然后拼接再人工微调嘛。要是那么简单就好了。

实际上,一个稍微有点质量的AI短剧,背后是一套相当复杂和繁琐的流程,我称之为“工业组装”模式。这种模式的特点就是,每个环节都依赖不同的工具,然后靠人工一点点地拼接、调整,整个过程充满了不确定性。

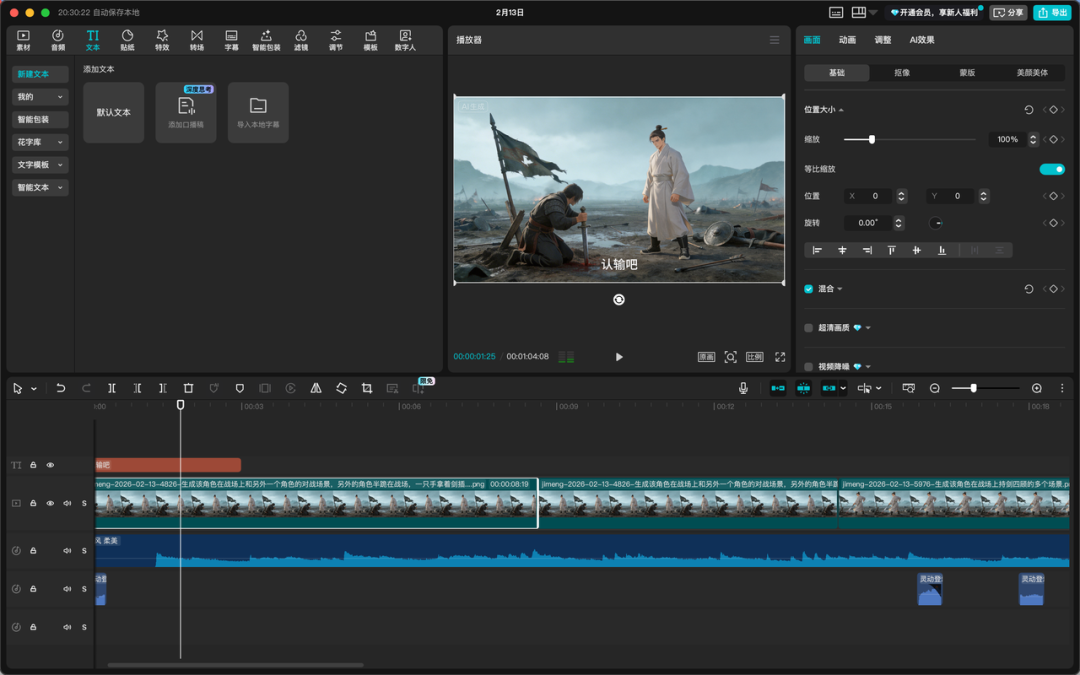

这里以单集制作为缩影,简单介绍下AI短剧的工作流程:

1.1 前期筹备:团队|剧本|设定

一个项目的启动,首先是团队的组建。

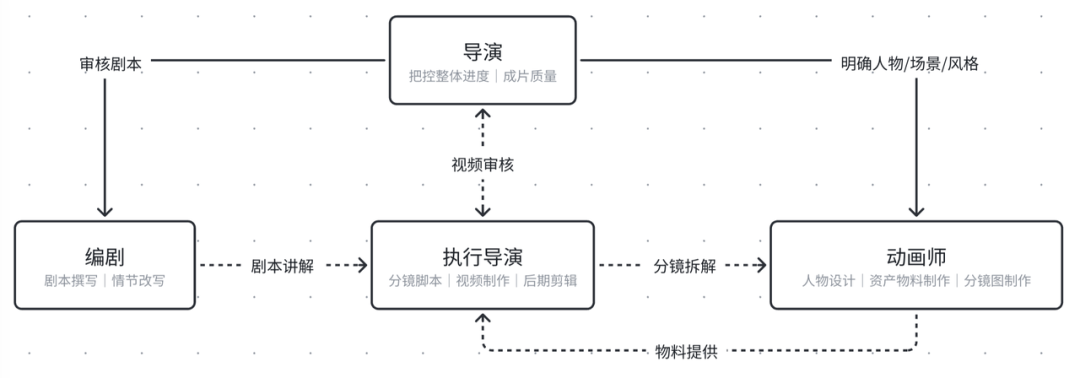

就算是做一个单集,也需要你有导演来把握整体方向,有编剧来构思故事,有执行导演来细化分镜,还有动画师来处理视觉元素。

如果想规模化生产,也就是所谓的工程化达到商用级别的精品漫剧,那更是需要一个庞大的剧本库和多个执行导演、动画师团队并行作业。这背后的人力成本和沟通成本,可一点都不低。

1.1.1 团队构成

–导演:核心大脑,负责整体风格、剧本审核和最终成片质量。

–编剧:故事的源头,负责将小说或创意改编成适合视频化的剧本。

–执行导演:将剧本转化为具体的镜头语言,制作分镜脚本,并负责视频生成和后期剪辑。

–动画师:负责角色设计、素材制作,甚至需要手动修正AI生成中的瑕疵。

这配置几乎就是一个微缩版的传统影视团队。AI在这里,更像是一个辅助工具,而不是创作的核心驱动力。

1.1.2 剧本 & 设定

剧本敲定后,就进入了资产准备阶段。

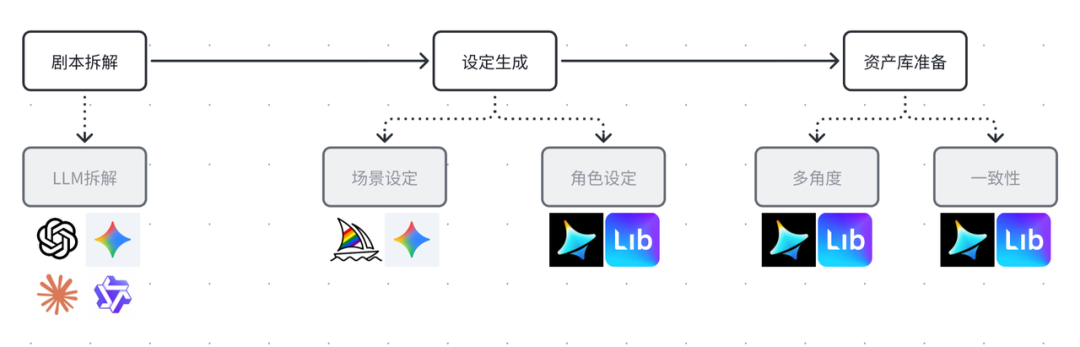

这个阶段的目标是建立一个完整的、可供后续视频生成的素材库。这个过程大致分为几步:

剧本拆解:首先,需要用大语言模型来分析剧本,把里面涉及的角色、场景、道具等元素都提取出来,形成一个详细的清单。

目前主流的几个模型基本都可以做到,之前评测下来 GPT 5.2 、Claude Sonnet 4.5 、 Gemini 3.0 Pro 、 Qwen 3 Max 这几个模型的表现都还不错。其中Claude Sonnet 4.5 拆解的更全面,提取的角色人设更为完整。

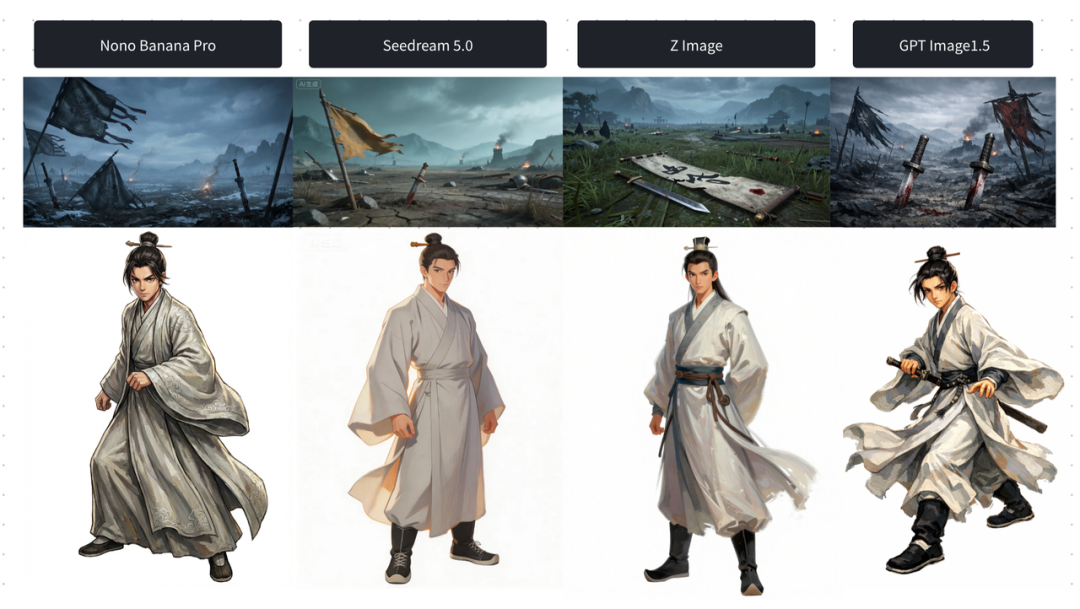

设定生成:明确场景 & 角色的视觉表现。创作者往往需要在多个模型之间反复横跳来测试比较。

比如,用Midjourney生成场景概念图更精细,用即梦生成人物角色更符合国人审美、nano banana生成打斗场景更稳定。

但这也仅仅是我们测试下来的体感,这种东拼西凑的方式,不仅效率低下,而且对创作者的技术要求非常高。

有时候会反复切换模型来生成,并且比较最终输出的质量。所以有时候可能纯靠主观判断或者说靠单轮下来哪个模型突然就开智了……

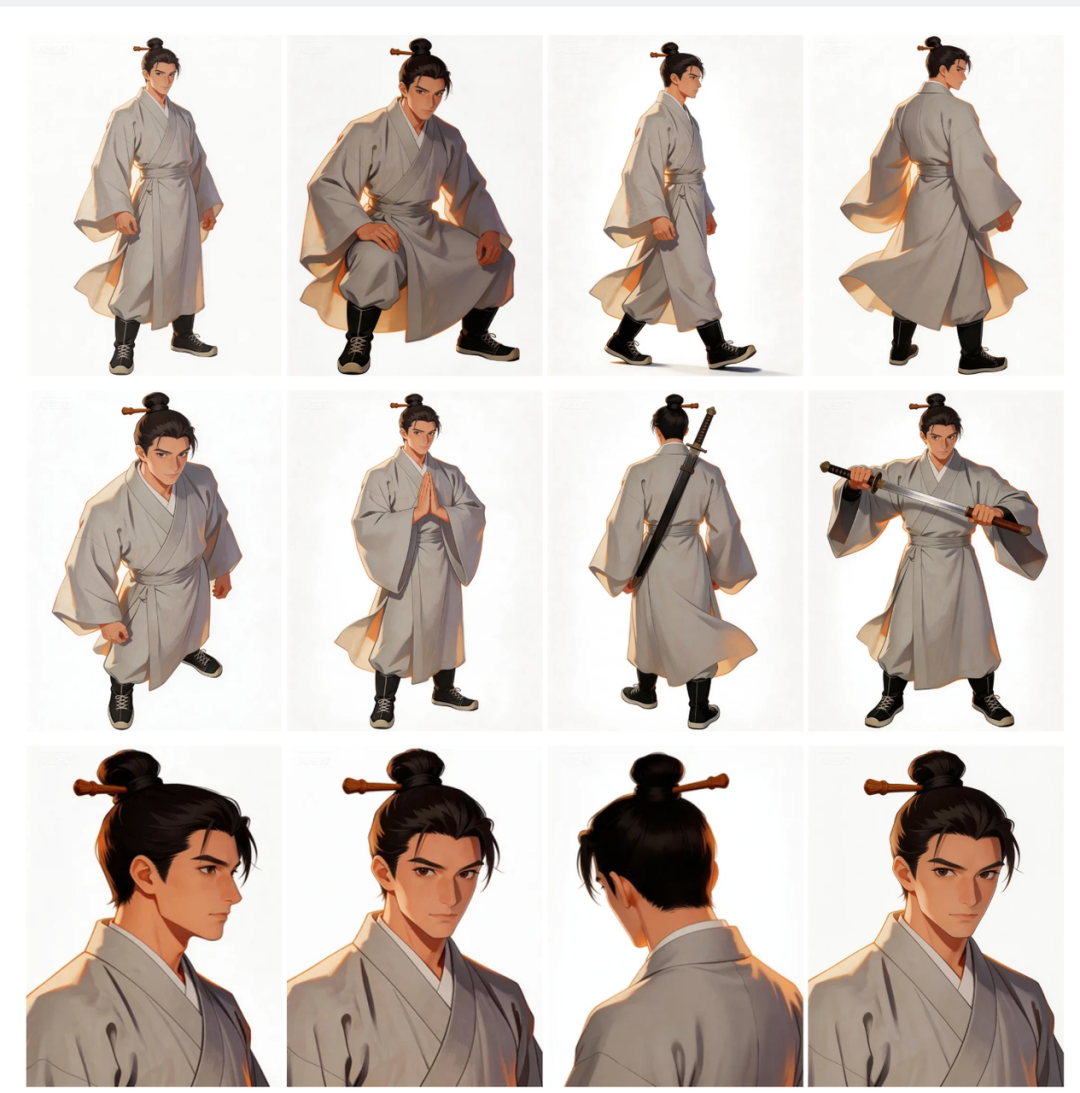

多角度资产图集:为了保证角色和场景在不同镜头下的一致性,你需要为每个主要元素生成多个角度的视图。

比如一个角色,你可能需要他的正面、侧面、四分之三侧面等各种角度的图像。这又是一个巨大的工作量,而且很难保证所有角度的图像风格完全统一。

tip:对于核心角色或者独特的艺术风格,为了追求更高的一致性,很多团队会选择训练自己的Lora模型。

这需要收集大量的参考图片,对模型进行微调。这个过程不仅技术门槛高,而且非常耗时,效果还不一定理想。

总的来说,传统AI短剧的前期准备,就是一个劳动密集型的过程。创作者需要像一个项目经理一样,在不同的工具和平台之间切换,手动管理大量的素材,并且祈祷每一次生成都能得到满意的结果。

这种离散的工作流,是AI视频创作初期最大的痛点。

1.2 中期制作:分镜图|片段视频

当资产库准备就绪,就进入了中期制作阶段,这个过程同样充满了挑战,核心就是如何保证“一致性”。

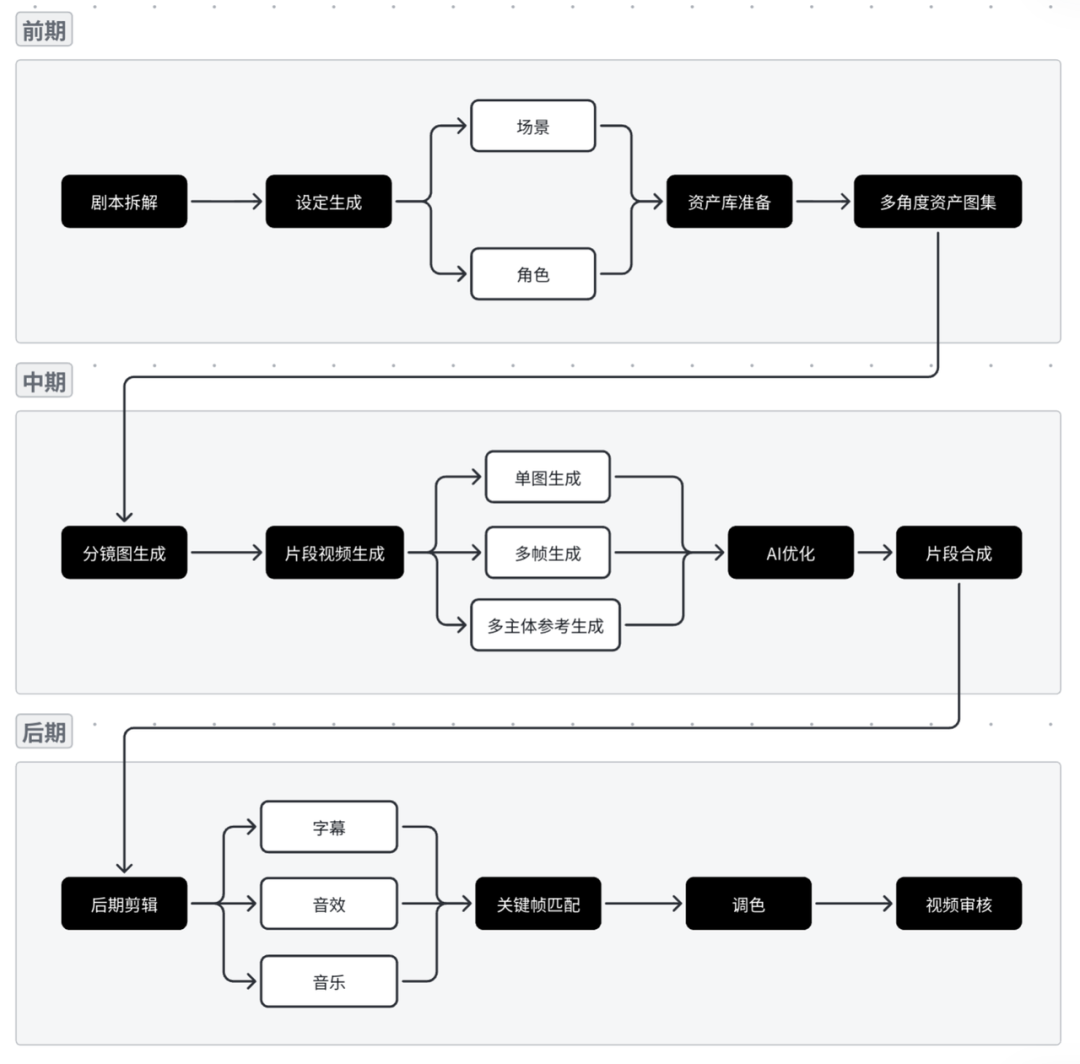

1.2.1 分镜图生成

在生成视频之前,执行导演需要根据剧本绘制分镜脚本。然后,动画师或AI绘画师再根据分镜,生成每一帧或关键帧的图像。

这个过程需要反复调整,确保美术风格、色彩、光影在不同镜头之间是统一的。比如,一个角色从室内走到室外,光线变化要自然;一个场景从远景切到近景,细节要保持一致。

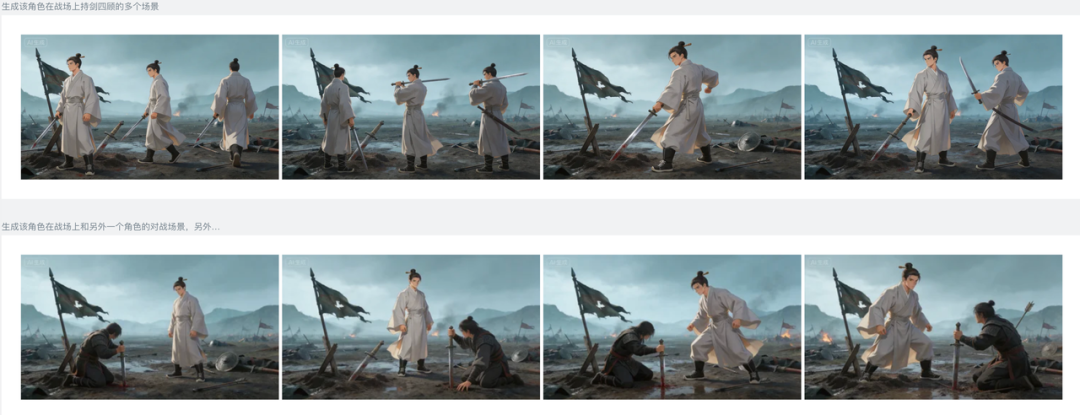

对于一些复杂的镜头,比如需要多个角色互动的场景,就需要进行多参考素材整合。这意味着你需要把不同角色的图像、背景图像等拼合在一起,作为生成视频的参考。

而这个步骤需要反复检查这些素材的画风是否一致,因为参考图的风格会直接影响最终的视频效果。这又是一个需要大量人工干预和调整的环节。

1.2.2 视频生成

把静态图片变成动态视频,是整个流程中最核心,也是最“玄学”的一步。目前主流的文生视频或图生视频模型,虽然能力越来越强,但仍然存在很多不确定性。三种目前主要的生成方式:

单图生成:这是最简单的方式,输入一张图片和一段描述,让AI把它“动”起来。但问题是,普通模型的生成质量往往不高,画面容易出现抖动、闪烁、人物变形等问题。想要效果好,就得用更高级的Pro版本,但那也意味着更高的成本。而且,不同的模型有不同的脾气,比如有的擅长风景,有的擅长人物,创作者需要不断尝试,找到最适合的模型。

多帧生成(首尾帧/序列帧):这种方式给了创作者更多的控制权。你可以提供一个开始的画面和结束的画面,让AI去补全中间的过渡。或者提供一系列关键帧,让AI把它们串联成流畅的动画。这种方式虽然能更好地控制画面的走向,但前期准备工作量巨大,成本也最高。所以,通常只在一些关键的转场或者需要精确控制的镜头上使用。

多主体参考生成:这是目前比较前沿的技术,允许你同时输入多个角色和背景的图片,然后用文字描述他们之间的互动。比如,“@角色A 和 @角色B 在 @场景C 中对话”。这种方式在效率和质量之间找到了一个平衡点,但最大的问题是不稳定性。AI对复杂指令的理解还不够精准,生成的结果往往需要多次尝试才能满意。

这个阶段就像是在开盲盒。你精心准备了半天,最后生成出来的视频可能完全不是你想要的样子。

人物的动作可能不自然,物理效果可能很奇怪,角色的脸可能在不同镜头里变来变去。这就需要创作者不断地调整提示词、更换参考图,反复生成,直到得到一个满意的结果。

这个过程不仅耗费时间,也消耗大量的计算资源。

1.3 后期调整:AI优化|剪辑合成

AI生成的视频片段,往往还只是半成品。接下来,就需要进入后期修补阶段。这个阶段的工作,就像是给一个粗糙的模型进行精雕细琢。

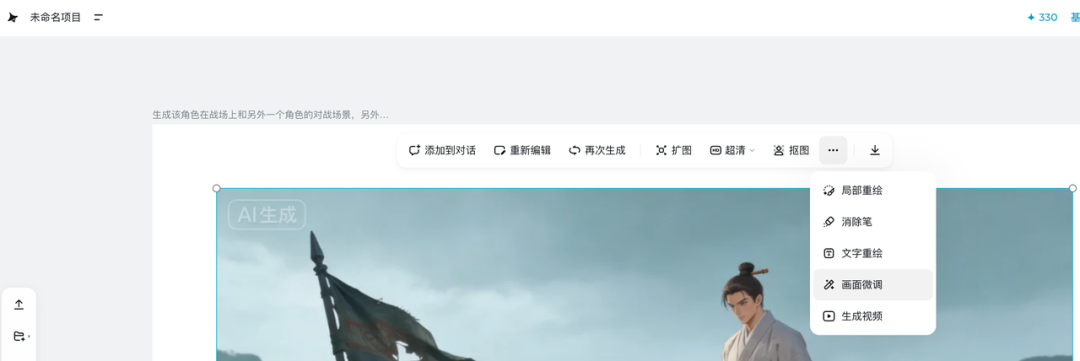

首先是AI专项优化。比如,视频的帧率可能不够高,需要用AI补帧工具来让画面更流畅;画质可能不够清晰,需要用AI超分辨率工具来提升细节;角色的口型可能和配音对不上,需要用AI对口型工具来修正。

这个环节涉及的工具非常多,而且很杂,最好能有一个整合性的平台来统一处理,但目前这还只是一个理想。

最后,所有的视频片段、配音、音效、背景音乐,都需要在视频剪辑软件(中进行最终的合成、调色和剪辑。

这一步和传统影视制作的流程基本一致,也意味着AI目前还无法完全取代传统后期制作的岗位。

核心范式总结

总结一下,传统的AI短剧制作流程,就像一个复杂的工业组装线。

创作者需要像一个项目经理一样,在不同的工具和平台之间来回切换,管理着一堆零散的素材和参数。

这个过程不仅技术门槛高,而且充满了不确定性。你可能花了很多时间和精力,最后得到的结果却不尽如人意。

创作者的大部分精力,都消耗在了技术实现和流程管控上,真正用于创意本身的时间反而不多。

这种离散和不可控的特性,是目前AI视频创作面临的最大挑战。

换句话说,分镜和故事的创作是串联整个短剧的核心,而这两个东西需要大量的前置筹备,浪费精力人力。

而Seedance 2.0的出现,直接打破这种桎梏

02 Seedance 2.0 — 导演级视频生成模型诞生

它不再是一个简单的Tool架构,而是具备导演能力的Agent模型,它可以读懂用户的隐性需求,换句话说它可以看得懂剧本,这本身就很恐怖。

2.1 市场反响

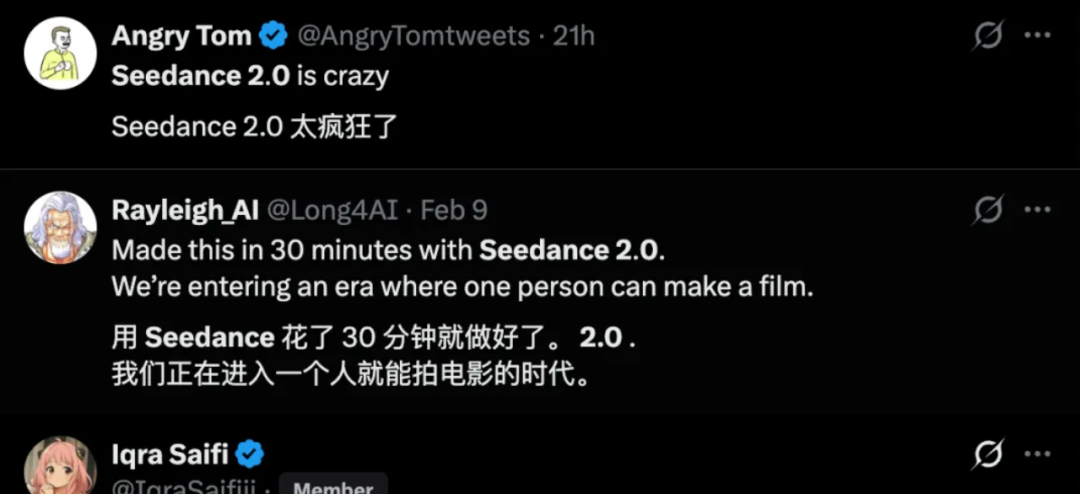

Seedance 2.0的发布,在AI圈和影视圈都引起了非常大的轰动。国内外的创作者们纷纷惊叹于它的强大功能。

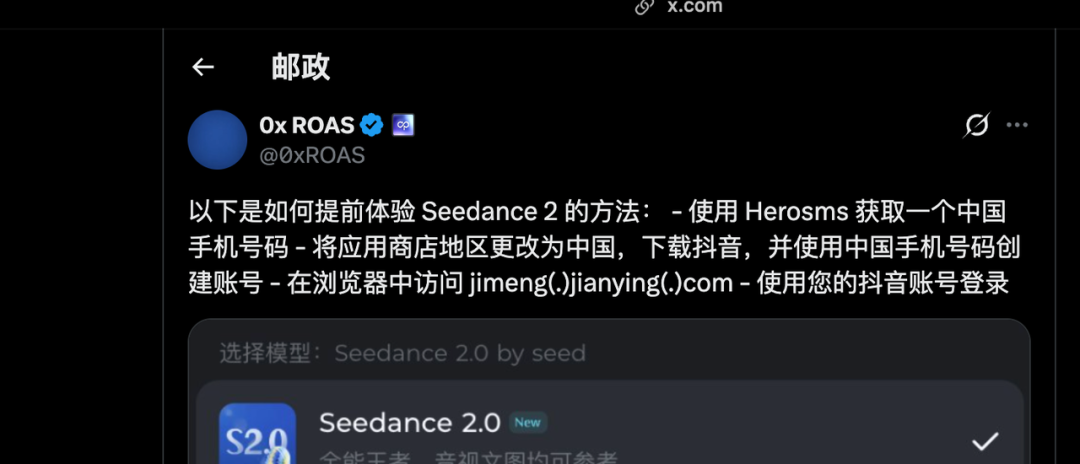

很多海外的创作者甚至想方设法“翻墙”来体验这个来自中国的AI模型,甚至在X上你可以看到很多海外的朋友还在教怎么才能用Seedance 2.0 的方法。

“先获取一个中国手机号码……” 我只能说,太TM爽了。

2.2 技术拆解

那么,Seedance 2.0到底强在哪里?它的核心优势在于其创新的统一多模态架构。

简单来说,就是它能同时理解和处理多种不同类型的信息,比如文字、图片、视频,甚至音频。这让它能够更全面地理解你的创作意图。

具体来说,这个架构有几个关键的突破:

统一多模态输入:你可以同时给Seedance 2.0提供图片、视频、音频和文字描述,它能将这些信息融合在一起,生成一个统一的、连贯的视频。这就像给导演提供了全方位的素材,让他可以自由地进行剪辑和创作。

双分支扩散变换器:这是Seedance 2.0的黑科技之一。它能够同时处理视觉和听觉信息,实现真正的音画同步。这意味着你可以用一段音乐来驱动视频的节奏和情绪,让画面和声音完美融合。

单指令生成连贯多场景:传统的AI视频生成,往往只能生成一个单一的镜头。而Seedance 2.0可以根据一段复杂的文字描述,生成包含多个场景、多个镜头的连续视频。这极大地提升了创作的效率和自由度。

物理引擎升级:Seedance 2.0在物理模拟方面也取得了重大突破。它能更好地理解和模拟现实世界中的物理规律,比如重力、碰撞、流体等。这使得生成的视频更加真实可信,减少了那些反物理的诡异画面。

2.3 如何使用

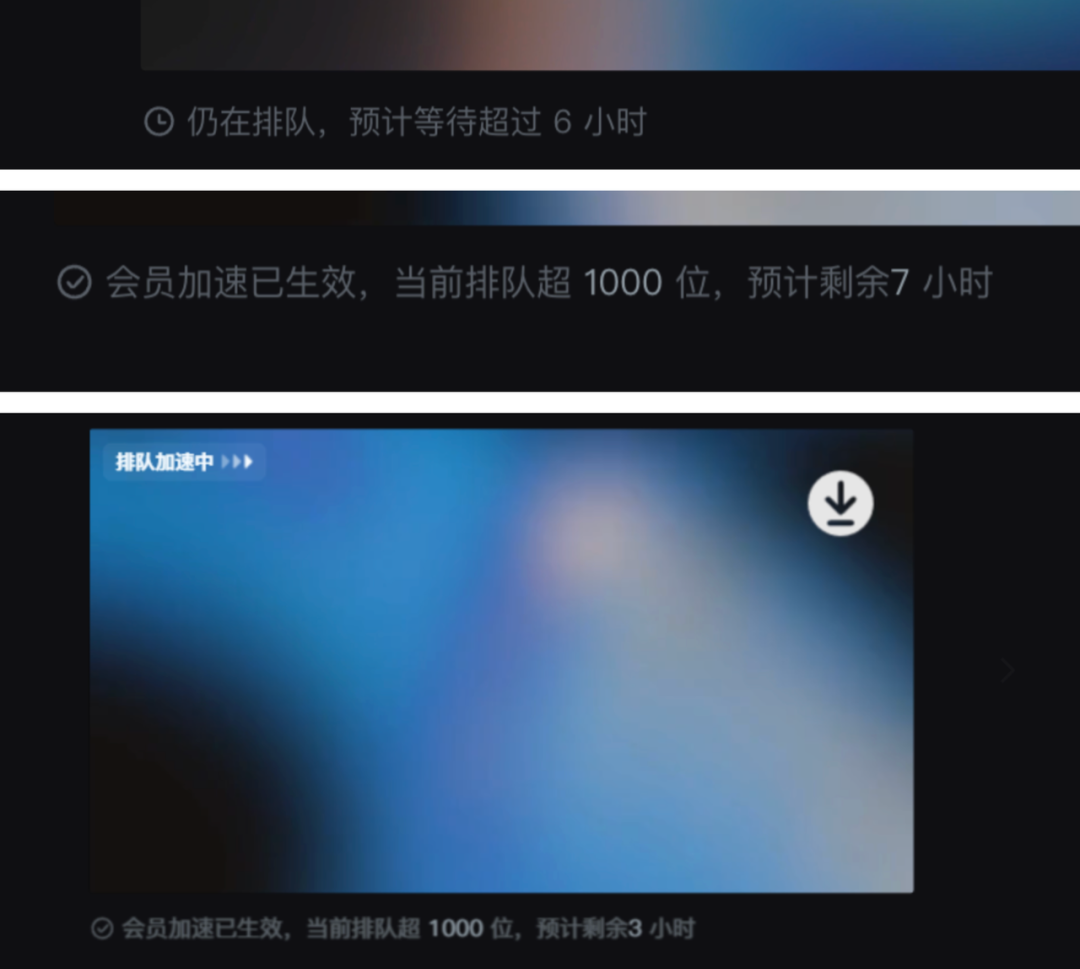

Seedance 2.0 目前已经在官网上线了,所以可以在即梦官网直接体验,但是确实太火爆了,所以导致即便你有会员也还是要排队。动辄几个小时你就等去吧……

不过不是只能在即梦官网上用,我大概搜集了一下,目前有几个渠道都是可以用的:

- 即梦AI:即梦官网平台,每次正式上线肯定是上官网。但是每次正式上线前的预热,可能会经过众测、内测、灰度、pre等等,基本上大家可能在正式上线前就已经急疯了…

- 豆包App:为了让更多人能够轻松上手,Seedance 2.0也集成到了豆包App

- 火山方舟:可以在火山方舟上体验,但是很遗憾目前不支持接api。明确说了Seedance 2.0 仅开放体验中心免费体验,预计2026-02-24 18:00:00 后可支持API接入。

- 小云雀App:这也是字节的产品,而且在Seedance 2.0刚出来的时候,这个App就上了。甚至比其他渠道还要快,包括Seedream 5.0 还没推出宣传的时候,这个App也悄无声息就上了?!所以我觉得可能字节在发布新模型时都会先在小云雀上做试点测试,可以下一个。

2.4 使用技巧

Seedance 2.0的出现,让AI视频创作的交互方式发生了根本性的变化。我们不再是简单地用文字描述我们想要的画面,而是可以像导演一样,用更直观、更精准的方式来“指挥”AI进行创作。

多模态参考:这是Seedance 2.0最核心的功能之一。你可以使用“@”符号来引用上传的图片、视频或音频素材,并明确指定它们在生成视频中的作用。比如,你可以说“让@图片1中的人物,做出@视频1中的舞蹈动作,背景音乐使用@音频1”。这种“所见即所得”的创作方式,极大地降低了创作门槛,也提高了创作的效率和可控性。

有首帧/尾帧图?还想参考视频动作?→ 提示词中写清楚,如:“@图1为首帧,参考@视频1的打斗动作”

想延长一个已有的视频?→ 说明延长时间,如“将@视频1延长 5s”,注意:此时选择的生成时长应为“新增部分”的时长(例如延长 5s,生成长度也选 5s

想融合多个视频?→ 提示词中说明合成逻辑,如:“我要在@视频1和@视频2之间加一个场景,内容为xxx”

没音频素材?可以直接参考视频里的声音

想生成连续动作?→ 可以在提示词中加入连续性描述,如:“角色从跳跃直接过渡到翻滚,保持动作连贯流畅”@图1@图2@图3…

更多的使用方法,我这里就不做赘述,也不借花献佛了。直接去看 字节官方所给的使用手册

这里我放一些官方跑的case,大家可以感受一下。

即便抛去音乐音效不说,这画面质感以及运镜转场的丝滑,真的是达到了商用级别!!而且每一个都是直出的,并没有经过剪辑。Seedance 2.0 可以支持最长15s的视频生成,有效地利用首尾帧和视频延长技巧,那难以想象一个成片的制作成本到底有多低!

03 范式重塑 — 生产范式重塑

过去那种繁琐、低效的工业组装模式,瞬间被Seedance 2.0 这种高效、智能的一体化创作模式所取代。

3.1 流程的极致简化:从流水线到创作舱

在传统的AI短剧制作流程中,创作者需要像一个工匠一样,在不同的工具和平台之间来回切换,手动拼接、调整每一个环节。而Seedance 2.0则像一个集成的创作舱,将剧本构思、分镜设计、素材生成、视频剪辑等多个环节融为一体。

现在,创作者只需要在一个平台上,通过简单的文字描述和素材引用,就可以完成从创意到成片的整个过程。比如,你可以直接在提示词中写下整个故事的脚本,指定每个场景的画面、角色的动作和表情,甚至配上背景音乐。Seedance 2.0会根据你的指令,自动生成一段完整的、连贯的视频。

这种流程的简化,不仅仅是节省了时间和成本,更重要的是,它让创作者能够更专注于创意本身,而不用被繁琐的技术细节所困扰。

3.2 创作角色的根本转变:人人都是导演

在传统的AI短剧制作中,往往一个单集的创作,最少需要导演、编剧、执行导演和动画师才能完成。而现在不需要你掌握各种复杂的软件和技术,就能将自己的想法变成现实,真的实现了人人都是导演的地步。

3.3 产能与成本的革命:个人工作室的“好莱坞”时刻

Seedance 2.0的出现,也预示着一场内容生产的革命。过去,制作一部高质量的短片,需要一个庞大的团队和昂贵的设备。

而现在,一个有创意的个人,借助Seedance 2.0这样的工具,就有可能在自己的电脑上,创作出媲美好莱坞大片的视觉效果。

这无疑将极大地释放个人创作者的生产力,带来一场内容的“大爆炸”。我们可以预见,未来将会有更多元化、更具个性的AI短剧作品涌现出来,丰富我们的文化生活。

当工具一步到位,人的价值何在?

Seedance 2.0的出现,似乎让这个问题变得更加迫切。

我们必须承认,Seedance 2.0这样的AI工具,在“如何做”的层面,已经展现出了惊人的能力。它能够高效地处理繁琐的技术细节,将创作者从重复性的劳动中解放出来。

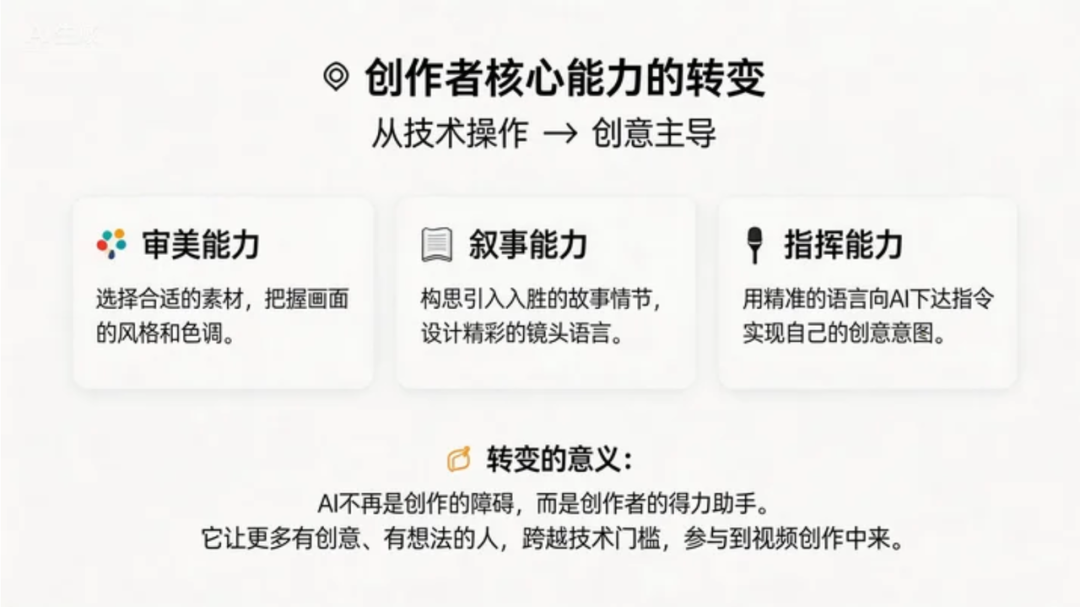

但这并不意味着人类创作者将被取代。恰恰相反,我们的角色正在发生进化。我们不再是单纯的执行者,而是成为了“AI操盘手”。我们的价值,体现在以下几个方面:

创意与审美:AI可以生成画面,但无法凭空创造出独特的创意和审美风格。这仍然是人类创作者的核心竞争力。

叙事与共情:好的故事能够触动人心,引发共鸣。这种能力源于我们对生活、对人性的深刻理解,是AI难以企及的。

判断与决策:在创作过程中,我们需要不断地做出选择和判断,从无数种可能性中,挑选出最优的方案。这种决策能力,是AI目前还无法替代的。

伦理与边界:随着AI能力的增强,如何负责任地使用这项技术,也成为了一个重要的问题。人类创作者需要把握好伦理的底线。

所以很遗憾的就是Seedance 2.0 当前已经不支持上传任何含有写实人脸的素材。但仔细想想这样也没错,生成的视频连我难以辨认真假了,换句话说,如果不是从业AI的人呢?如果你的父母看到AI生成的视频是否还会怀疑?想想都后怕。

Seedance 2.0的出现,标志着AI视频创作进入了一个新的时代。它将创作的门槛大大降低,让更多人有机会参与到这个领域中来。这是一个技术平权的时代,也是一个内容为王的时代。

最终,决定一个作品好坏的,不再是技术本身,而是故事的核心、情感的表达和创意的闪光。我们应该拥抱技术,利用它来更好地表达自己,创作出更多有价值、有温度的作品。

本文由 @小普 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益