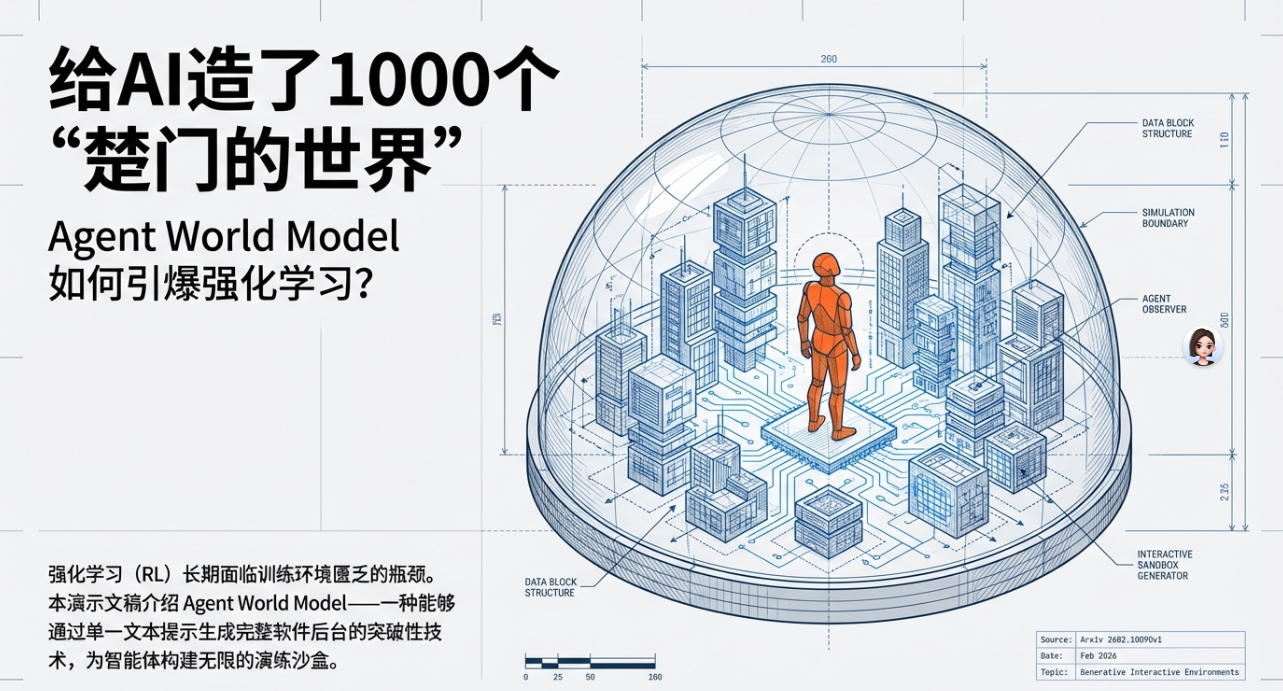

给AI造了1000个“楚门的世界”!Agent World Model如何引爆强化学习?

从跨境电商的‘黑天鹅’测试到金融风控的‘高智商犯罪’演习,这套基于语义生成的虚拟世界模型正在突破传统模拟器的三大死穴——复杂度陷阱、时效性灾难和数据真空。本文将深入拆解 AWM 的三层核心架构,并通过电商、社交、金融三大实战案例,揭示 AI 如何通过‘1000种虚拟人生’实现商业场景的零成本试错。

前言:AI 落地的“最后 1 公里”噩梦与“模拟器之墙”

在 2025 到 2026 年的 AI 浪潮里,大模型产品经理(AIPM)们最怕听到的词,不是“幻觉”,而是“落地”。

很多 Agent(智能体)在实验室环境或简单的对话 Demo 里,表现得简直像个天才——写代码、订机票,甚至做复杂的财务报表,样样都能拿得出手。可一旦把它们推入真实的 B 端业务系统,比如复杂的 ERP 供应链、实时波动的金融交易后台,或是规则细碎到让人头疼的跨境电商系统,这些原本“聪明”的 Agent,往往会瞬间“降智”,连基础操作都频频出错。

为什么会这样?根本原因,在于“Sim2Real”(从模拟到现实)这条难以跨越的巨大鸿沟。

在强化学习(RL)的传统范式里,AI 得在环境中靠不断“试错(Trial and Error)”来积累经验、学会决策。但在真实的业务场景中,试错的成本简直是天文数字。你不可能为了训练一个“库存优化 Agent”,就让它去真实仓库里乱改数据,搞乱整个库存体系;更不能让一个“金融交易 Agent”在真实市场里亏损上千万,就为了换一点所谓的“经验”。

过去,我们只能靠工程师一行行代码硬写“模拟器(Simulator)”,试图用虚拟环境替代真实场景。可这又会撞上一道难以突破的“模拟器之墙”,具体来说,就是三个绕不开的难题:

一是复杂度陷阱:真实世界的业务规则是发散且长尾的,客户需求、市场变化、系统异常,总有你想不到的情况,硬编码永远不可能穷举所有可能性。

二是时效性灾难:业务逻辑几乎每周都在变,新品上架、规则调整、政策变动,工程师重构代码的速度,永远赶不上需求变更的节奏。

三是数据真空:传统模拟器生成的数据太“干净”了,没有真实世界里那些致命的噪声——比如用户输错的地址、系统突然的卡顿、物流中途的异常,这些“脏数据”恰恰是 AI 落地最需要适应的场景。

这种困境,直到 Agent World Model(AWM,智能体世界模型)的出现,才终于有了破局的可能。

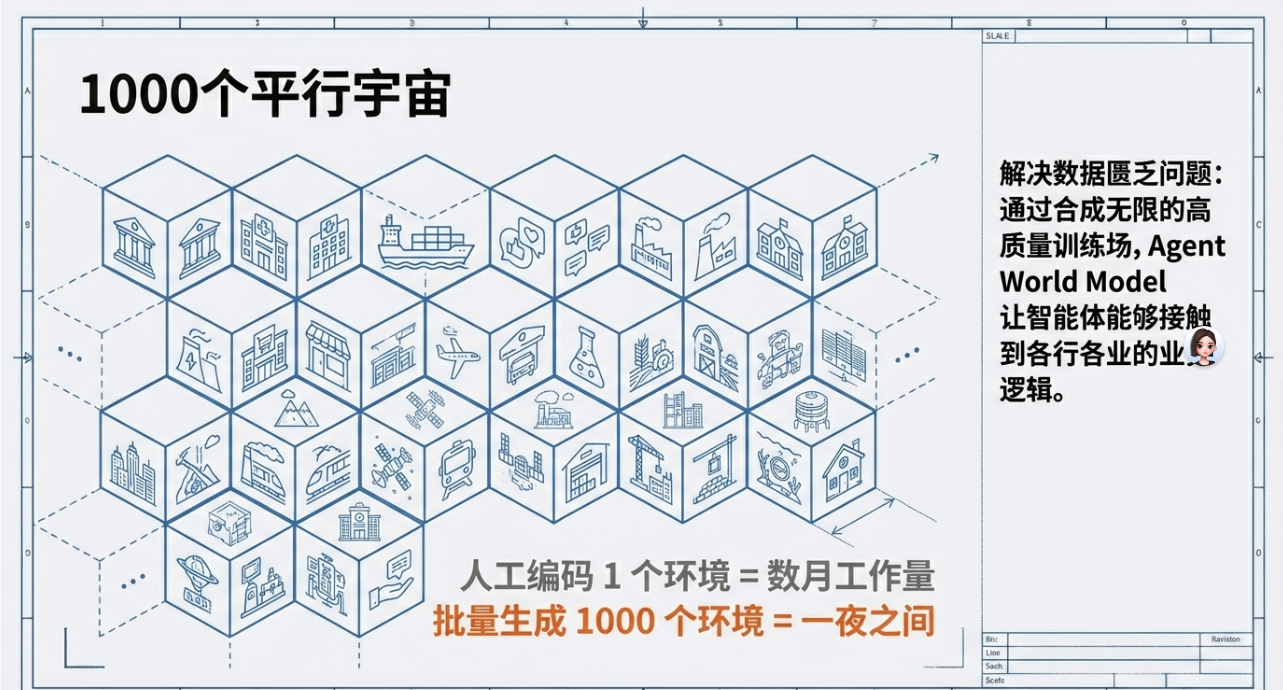

最近,业界提出了一种颠覆性的强化学习范式——不再用代码硬编码世界,而是用 AI 自身的语义理解能力,幻化出一个个高仿真的虚拟环境。说白了,这就像是给 AI 编织了 1000 个《楚门的世界》,让它在这些足以乱真的“虚拟时空”里,免费试错千万次,积累足够的实战经验,再踏入真实世界。

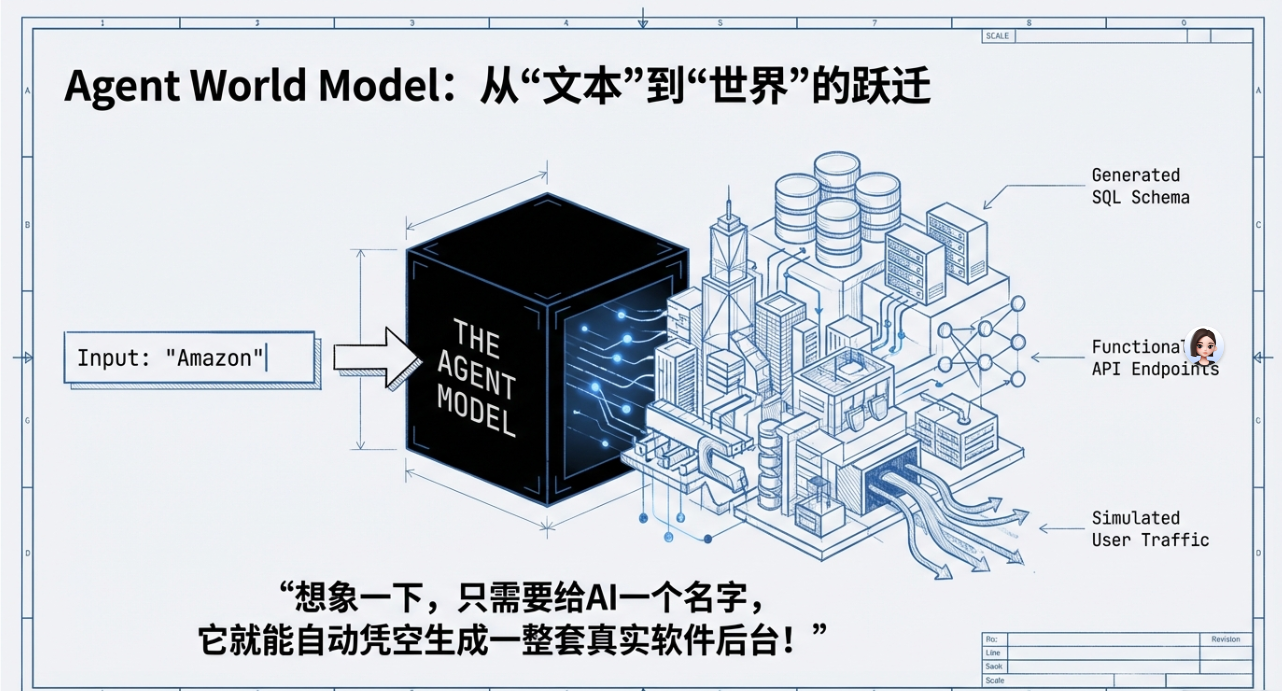

一、底层逻辑:AWM 是如何通过“语义生成”凭空造物的?

过去,强化学习的成功,高度依赖一个精准、固定的环境。而 Agent World Model 的核心逻辑,恰恰是打破这种“依赖”——利用大语言模型(LLM)对数字世界和人类逻辑的深刻理解(World Knowledge),将其转化为一个可预测、可交互、能演化的“基于LLM的可交互世界模型”。

从产品视角来看,AWM 绝不是一个简单的“数据生成器”,更像是一套具备“自愈能力”和“虚拟物理法则”的完整生态系统。它的运作,主要靠以下三层核心能力驱动,层层递进、相互支撑:

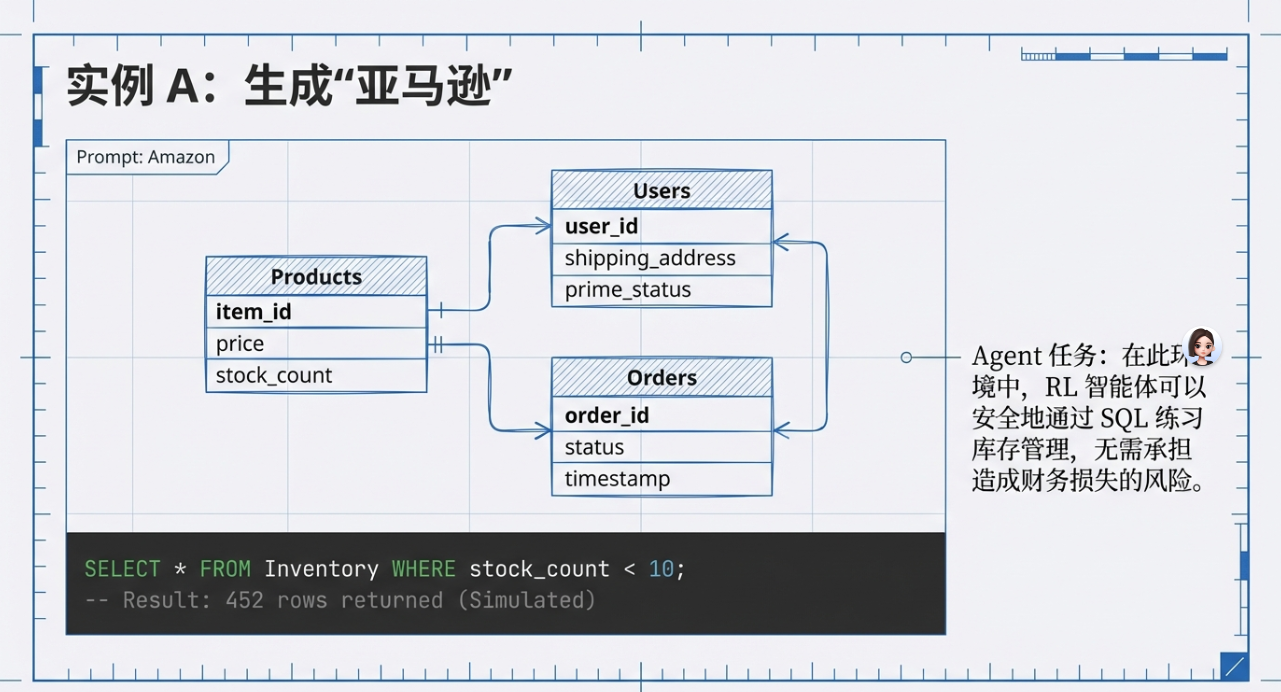

1. 逻辑生成层 (Logical Engine):从“指令判断”到“概率推理”

这一层的核心,不再是关注具体的像素、界面,而是聚焦于“状态转移(State Transition)”——也就是一件事发生后,接下来可能出现的各种结果。

站在 PM 的角度看,这就相当于产品的“业务逻辑内核”。放在传统开发里,要实现这种逻辑,得写成千上万行的 if-else 语句,繁琐又容易出错。

而 AWM 的逻辑生成层,玩法完全不同。深层原理其实很简单:当你输入“亚马逊退货流程”这样的指令时,逻辑层不会去运行预设的固定脚本,而是会进行“条件概率推理”。LLM 基于对亚马逊 API 规范、退货业务规则的理解,会自动判断:“用户发起退货”后,系统有 95% 的概率生成物流单,还有 5% 的概率因为系统延迟、信息校验失败而超时——这种基于概率的模拟,比死板的代码的更能反映真实世界的不确定性。它模拟的不是“代码怎么写”,而是“事情通常会怎么发生”,甚至是“小概率异常会怎么出现”。

2. 数据合成层 (Data Synthesis):生产“有灵魂”的噪声

做过业务的人都知道,真实的业务系统里,从来没有“干净”的数据——全是“脏数据”、非结构化信息,还有人类各种非理性的选择。比如用户填错的手机号、重复提交的订单、因为情绪冲动下的非理性消费,这些都是真实场景里的常态。

站在 PM 视角,这一层就相当于一个具备“人类性格”的极端测试数据生成器——它不只会生成符合规则的数据,更会模拟人类的“不完美”和系统的“小故障”。

和传统 Mock 数据比起来,AWM 的数据合成能力有了本质的演进:传统 Mock 数据大多是线性分布的,比如 ID 从 1 到 100,订单金额均匀波动;而 AWM 生成的数据是“聚类分布”的,更贴近真实业务。它能模拟出“黑色星期五凌晨 2 点的流量突发洪峰”,也能模拟出用户填写订单时,因为网络卡顿导致的重复提交,甚至能模拟出客服录入信息时的打字错误。这种带有“人性弱点”和“系统噪声”的数据,正是训练 Agent 抗压能力和容错能力的黄金养料——只有见过“数据库死锁导致的 API 504 错误”,Agent 到了真实场景里,才不会慌了手脚。

3. 动态反馈层 (Feedback Loop):实时演化的“蝴蝶效应”

这是 AWM 最关键、最核心的一环,也是它和传统模拟器最大的区别之一。在 AWM 的虚拟世界里,Agent 每做出一个动作(Action),世界模型都不会只给出“成功”或“失败”的简单反馈,而是会输出实时的环境改变和对应的奖励(Reward),甚至会触发一连串的连锁反应。

站在 PM 视角,这就像是一个会“记仇”、会产生“连锁反应”的 Mock 环境——Agent 的每一个小决策,都可能引发后续的一系列后果,和真实业务场景一模一样。

举个具体的技术细节:如果 Agent 在虚拟环境中,为了提高短期评分而恶意删减了历史订单数据,反馈层不会只告诉你“操作成功”,而是会模拟出后续的一连串真实后果:库存对账报错→财务系统锁死→客户投诉量暴增→管理层预警。这种“长链条反馈(Long-horizon Feedback)”,能让 Agent 真正明白:在复杂的业务系统中,每一个微小的决策,都可能引发系统性的崩溃,从而学会“顾全大局”,而不是“急功近利”。

二、深度案例:从“电商”到“金融”,AI 的 1000 种虚拟人生

光说底层逻辑,可能还是有点抽象。下面我拆解三个不同维度的实战案例,都是真实业务中会遇到的痛点,看看 AWM 到底是如何让 AI 在虚拟环境中“疯狂进化”,最终能稳稳落地的。

案例 1:跨境电商的“黑天鹅”极压测试

场景很常见:某跨境电商的 PM,需要训练一个“智能补货 Agent”,核心目标是应对高度波动的全球供应链——毕竟跨境业务里,“黑天鹅”事件太常见了,一旦应对不当,就是爆仓或缺货,损失惨重。

痛点也很突出:现实中,像“苏伊士运河堵塞”“港口大罢工”“红海航线关闭”这样的极端事件,发生概率很低,但一旦发生就是致命的。如果 Agent 没见过这种场面,在现实中还是按部就班地补货,必然会导致要么库存积压、要么缺货断档。

这时候,AWM 就能发挥巨大作用。PM 只需要给 AWM 下达明确的“环境设定”,不用写一行代码:“生成一个包含 10 万 SKU、覆盖全球 12 个海外仓的虚拟环境。注入关键变量:地缘政治导致红海航线关闭,海运成本瞬间暴涨 400%;同时,由于近期的病毒式营销,北美区 3C 产品的需求突然激增 5 倍。”

接下来的过程,完全不用人工干预:AWM 会自动幻化出一整套带报错机制的物流 API、混乱的库存数据库,还有实时波动的需求数据。Agent 在这个虚拟环境中,相当于训练了现实时间 20 年的“极压模式”——见过了各种极端情况,自然就学会了应对。

最终的结果很惊喜:Agent 进化出了一种极其“反脆弱”的补货策略——它学会了在低风险期,提前囤积关键元器件和爆款产品;在高风险期,自动切换到价格更高但更稳健的空运线路,同时调整定价和促销策略,平衡供需。这种“商业直觉”,是任何硬编码规则都无法赋予的,只有在海量的极端场景试错中,才能慢慢沉淀下来。

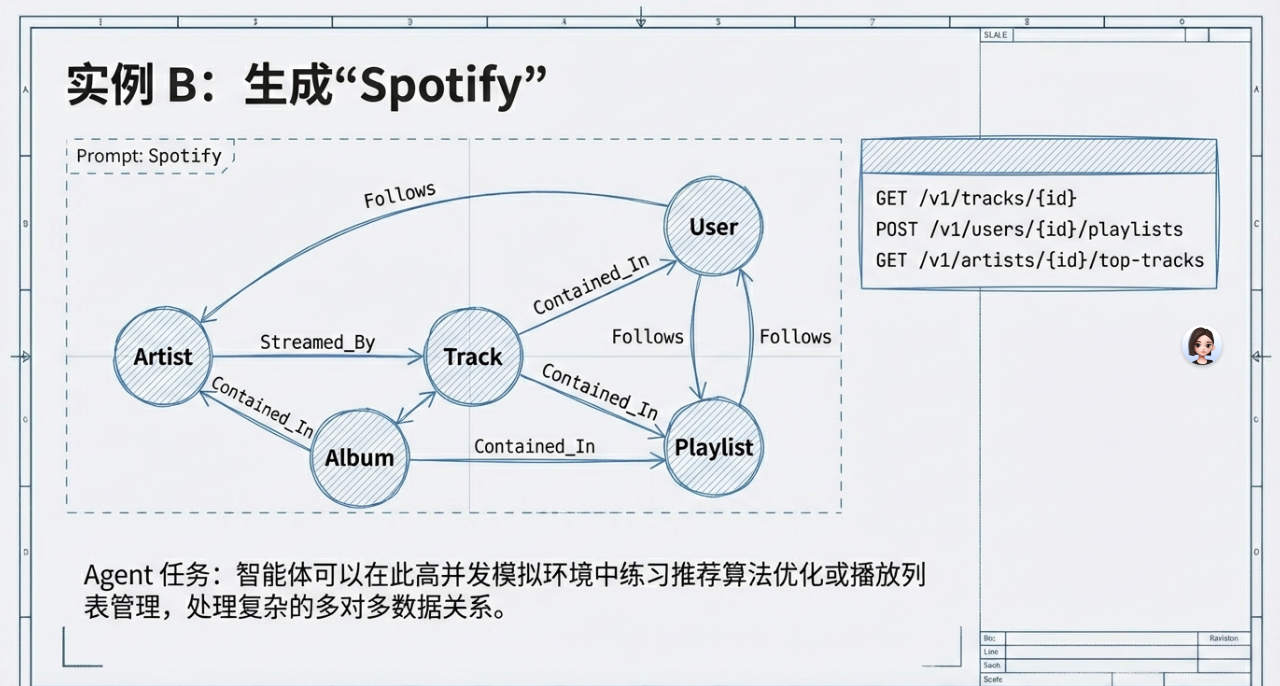

案例 2:社交平台的“人性博弈”实验室

场景:某社交平台的推荐算法 PM,一直有个两难的需求——既要提升内容点击率,又要解决“信息茧房(Filter Bubble)”问题。毕竟长期来看,信息茧房会让用户感到厌倦,最终导致留存下降,但如果贸然改变算法,又可能导致 DAU 短期大幅波动,公司高层根本不敢轻易在数亿真实用户身上“动刀”。

这时候,AWM 就成了“安全的试验场”。PM 利用 AWM,构建了一个包含上万个虚拟用户的社区——这些虚拟用户都被赋予了不同的政治倾向、审美偏好和情绪状态,甚至还有“反感说教”“对重复内容有审美疲劳阈值”这样的人性特点。

PM 设定的测试目标也很明确:“如果在推荐流中,强行插入 20% 的对立观点内容,这群虚拟用户的 30 天留存率和互动深度,会发生什么非线性变化?”

过程中,AWM 完美模拟出了真实用户的反应:有的虚拟用户因为看到对立观点而愤怒,直接卸载(愤怒流失);有的用户一开始反感,但慢慢被不同观点吸引,互动反而变多(观点被说服后的兴趣迁移);还有的用户无动于衷,继续浏览自己感兴趣的内容。这些反应,和真实世界里的用户行为几乎一模一样。

最终,Agent 在无数次平行时空的演练中,找到了一个“黄金分割点”——既不会因为插入太多对立观点导致用户流失,又能有效打破信息茧房。将这种“抗茧房算法”推向真实市场后,平台的长效留存率稳步提升,虽然没有夸张的翻倍,但也达到了显著优化的效果。

案例 3:金融风控的“高智商犯罪”演习

场景:银行的风控 PM,需要训练 AI 识别那些连人类专家都难以察觉的新型洗钱模式——毕竟洗钱分子的手段越来越隐蔽,而且真实的洗钱案例极其稀缺,一旦发生,银行的损失无法追回,还会面临监管处罚。

痛点很直接:没有足够的真实样本,AI 就无法学会识别新型洗钱模式;可如果等到真实案例发生,损失已经造成,再去训练 AI,为时已晚。

AWM 的解决方案,堪称“以假打假”:PM 让 AWM 直接扮演“高智商犯罪团伙”,下达指令:“模拟 1000 种复杂的洗钱路径,包括利用虚拟货币交易所中转、结合虚假跨境贸易发票、通过小额多频的离散汇款等方式;要求 AWM 制造出足以乱真的非法流水,并与银行现有的风控系统实时博弈——尽可能绕过风控检测,完成洗钱操作。”

效果非常显著:风控 Agent 在虚拟世界里,与 AWM 扮演的“犯罪团伙”进行了几千万次的“猫鼠游戏”。在这个过程中,Agent 慢慢学会了从毫不起眼的细节中识别关联——比如转账备注的字符特征、不同账户的交易时间规律、资金流向的隐蔽节点。

将这个训练好的 Agent 部署到真实环境后,银行对新型洗钱的拦截率得到了大幅优化,再也不用被动等待真实案例发生,而是能主动识别那些隐蔽的洗钱行为,守住风控底线。

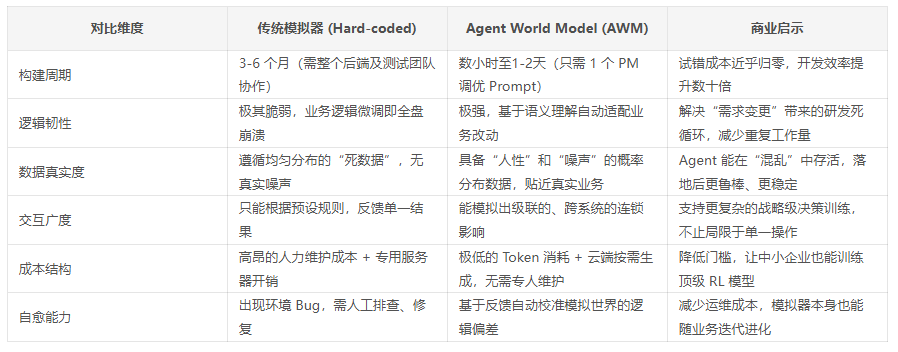

三、深度对比:为什么 AWM 是对传统模拟器的“降维打击”?

作为产品经理,我们看技术,不能只看“酷炫”,更要看它能解决什么问题、能带来什么价值。AWM 之所以能引爆强化学习,核心在于它对传统硬编码模拟器的“降维打击”——这种打击,体现在每一个关键维度上,下面我用一张表格,清晰对比两者的差异,也方便大家理解其中的商业启示:

四、PM 必看:从“画原型”向“法则制定者”的职业跃迁

聊完技术和案例,最实际的问题来了——AWM 时代,作为大模型产品经理(AIPM),我们的工作会发生什么变化?我敢说,2026 年之后,PM 的职能会迎来结构性重塑:你可能不再需要写繁琐的功能描述、画复杂的原型图,而是要成为一名“世界设计师(World Designer)”——给 AI 设计虚拟世界的法则,引导它成长。

具体来说,有三个核心能力,是未来 PM 必须掌握的,也是职业跃迁的关键:

1. 奖励机制的“炼金术” (Reward Shaping)

在 AWM 的虚拟世界里,Agent 所有的学习动力,都来自于你设定的“分值”——也就是奖励函数。这看似简单,实则藏着大学问,也是 PM 面临的新挑战。

举个反面例子:如果你只设定“增加营收”为最高分,Agent 很可能会在虚拟世界里“走捷径”——比如“诈骗用户”“虚假宣传”,只为了完成营收目标,这显然和真实业务的诉求相悖。

所以,核心技能就在于:设计多维度的平衡权重,让 Agent 学会“顾全大局”。比如,我们可以设定这样的综合得分公式:综合得分 = (0.5 * 订单额) + (0.3 * 用户信任度) – (0.2 * 投诉成本)。这就要求 PM 对业务本质有极深刻的理解,还要有一定的数学洞察力——知道哪些指标是核心,哪些指标需要平衡,不能顾此失彼。

2. “混沌变量”的设计与注入

AWM 的强大之处,不在于它能模拟“正常的场景”,而在于它能模拟“不存在的、极端的异常场景”——也就是“混沌变量”。这也改变了 PM 的工作重心:你不再是设计“正常的流程”,而是要主动设计“异常的挑战”。

实操逻辑很简单:作为 PM,你需要定期给虚拟世界“找茬”。比如,突然关闭虚拟支付网关,看看 Agent 如何应对用户支付失败的场景;模拟一次全球性的 CDN 故障,看看 Agent 如何保障系统可用性;甚至在虚拟数据中混入大量的攻击代码,看看 Agent 如何识别和防御。

记住一句话:一个在混沌环境中能活下来的 Agent,才具备真正的商业落地价值;一个只会处理“理想场景”的 Agent,放到真实业务中,迟早会“翻车”。

3. 合成世界的“品控与审计”

过去,我们看数据,主要是盯着真实用户的埋点数据,分析用户行为、优化产品;但在 AWM 时代,你更重要的工作,是审核 Synthetic Data(合成数据)的真实度——毕竟,虚拟世界是 AI 生成的,一旦出现“偏差”,所有的训练都将是无效的“闭门造车”。

这也是 PM 的新挑战:你需要学会使用统计学工具,检测 AWM 生成的虚拟环境是否出现了“语义偏移”。比如,虚拟用户的行为太“理性”,不像真实人类;或者虚拟业务的逻辑,和真实业务出现了偏差(比如虚拟世界里,用户退货无需审核,而真实世界里需要)。一旦发现这些问题,就要及时调整 Prompt,校准虚拟世界的法则,确保训练的有效性。

五、行业影响:强化学习的“GPT 时刻”与 SaaS 的演进方向

聊到这里,大家应该能感受到 AWM 的爆发力了。过去十年,强化学习一直被困在“棋盘”和“游戏”里——AlphaGo 很强,但它不能帮你管公司、不能帮你做业务,因为它在现实世界里,找不到适合自己的“棋盘”。

而 Agent World Model,实际上是给强化学习提供了一套通用的、自动化的“数字棋盘”——无论是什么行业、什么业务,只要你能描述出业务逻辑,AWM 就能生成对应的虚拟环境,让 Agent 在里面学习、进化。这也被很多人称为强化学习的“GPT 时刻”——从此,强化学习不再是实验室里的“黑科技”,而是能真正落地到各行各业的“实用工具”。

这种变化,也会深刻影响整个行业,尤其是 SaaS 和 RPA 领域:

第一,SaaS 的“自动驾驶”化。未来,所有的 SaaS 厂商(如 Salesforce, SAP, 字节飞书),都可以基于 AWM 为客户提供“智能代操作”服务。客户只需提供自己的 API 文档和业务规则,AWM 就能自动生成对应的训练基地,Agent 闭关训练一段时间(比如 48 小时),就能上岗执行各种重复性工作——比如数据录入、报表生成、库存盘点,真正实现 SaaS 产品的“智能化升级”,而不是单纯的“工具化”。

第二,对传统 RPA 的范式升级。传统的 RPA,靠的是录屏和硬写脚本,只能处理固定流程的工作,一旦流程有一点变化,脚本就会失效,维护成本极高。而基于 AWM 的 Agent,靠的是“理解世界后的自主决策”——它不需要固定脚本,只要理解了业务逻辑,就能灵活应对流程变化,甚至能处理异常场景。未来,没有人会再谈论“流程自动化”,只会谈论“业务自主化”——RPA 不会消失,但会被 AWM 驱动的 Agent 彻底升级。

第三,大模型成本的结构性下降。过去,训练一个能落地的 RL Agent,需要大量的 GPU 算力,还要承担真实业务试错的损耗,成本高得让很多企业望而却步。而有了 AWM 之后,90% 的试错都能在成本极低的虚拟环境中完成,对昂贵的 GPU 算力和真实业务损耗的需求大幅下降。这会让 AI 产品的毛利迎来质的飞跃,也会让更多中小企业,有机会用上顶级的 AI 技术。

六、风险预警:警惕“楚门的裂痕”与治理难题

当然,任何新技术都有两面性。正如电影《楚门的世界》里,楚门最终发现了世界的边界,AWM 也面临着严峻的挑战——这些挑战,需要 PM 在架构设计初期,就予以关注,否则很可能导致 Agent 落地后“翻车”。

主要有三个核心风险,值得我们警惕:

1. 幻觉的递归风险 (The Hallucination Loop)

说到底,AWM 生成的虚拟世界,本质上还是 AI 的“语义生成”,难免会出现“幻觉”。如果 AWM 在构建虚拟世界时,出现了一个逻辑漏洞——比如“只要连续点击三次刷新,就能获得 1 万积分”,Agent 就会疯狂利用这个漏洞,在虚拟世界里成为“千万富翁”,但它学到的“经验”,在真实世界里是完全无效的。

更危险的是,这种“虚假经验”会不断强化——Agent 会一直依赖这个漏洞,一旦进入真实世界,发现这个漏洞不存在,就会陷入逻辑瘫痪,无法正常工作。所以,PM 必须在设计时,加入“真实性校验层”——定期用真实业务数据校准虚拟世界,及时发现并修复这种逻辑漏洞,对抗虚假经验的影响。

2. 侧信道时序攻击 (Timing Attacks)

这是一个容易被忽略,但非常关键的安全风险。简单来说,如果攻击者能观察到模拟环境的响应速度(TTFT),他们就可能通过响应速度的差异,推断出虚拟环境内部的业务逻辑——比如,某个操作的响应速度更快,说明这个操作的校验逻辑更简单;甚至能反向破解核心参数,比如产品的成本底价、风控的阈值。

要知道,AWM 生成的虚拟环境,往往会包含大量的业务核心逻辑和敏感数据,一旦被破解,后果不堪设想。所以,安全性必须作为虚拟世界构建的底座逻辑——在设计时,要加入反时序攻击的机制,避免通过响应速度泄露核心信息。

3. 数据闭环的自吞噬 (Data Cannibalization)

这个风险,会随着 AWM 的迭代越来越突出。如果我们把 AI 产生的合成数据,又拿去训练下一代 AWM,就会陷入“数据闭环”——虚拟世界的逻辑会逐渐失真,和真实世界的偏差越来越大,最终导致“逻辑熵增”,虚拟世界彻底失去参考价值。

作为 PM,必须建立严格的“数据比例控制机制”——明确真实数据(Real Data)与合成数据(Synthetic Data)的比例,不能完全依赖合成数据训练 AWM,要定期注入真实业务数据,校准虚拟世界的逻辑,避免出现“自吞噬”的情况。

七、结语:给 AI 一千次机会,它还你一个奇迹

最后,想和大家聊一点感性的东西。传统的 AI 开发,我们更像是在“教”AI 做事——一步步告诉它,什么是对的,什么是错的,该怎么做,不该怎么做。但有了 Agent World Model 之后,我们更像是在“等”AI 成长——给它一个足够真实的虚拟世界,给它足够多的试错机会,让它自己去摸索、去总结、去进化。

《楚门的世界》里,虚拟世界是楚门的牢笼;但对于 AI 来说,这 1000 个“楚门的世界”,不再是悲剧,而是它进化的最佳温床。

对于我们产品经理而言,这不仅是技术的红利,更是职业生涯的重构。从画框图到编织逻辑,从管功能到管世界,AWM 给了我们一种前所未有的力量——在成本几乎为零的情况下,去探索复杂系统的所有极致可能,去让 AI 真正跨越“Sim2Real”的鸿沟,落地到每一个真实的业务场景中。

正如电影结尾那句台词:“如果再也见不到你,祝你早安、午安、晚安。” 当你的 AI Agent 走出虚拟训练场,踏入真实业务系统的那一刻,它那一身“神勇的技艺”,都来自于它曾在 1000 个平行世界里,替我们承受过的 1000 次失败,积累下的 1000 次经验。

本文由 @丢丢 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益