这3招使用Deepseek-R1满血版的平替办法,推荐你收藏好

Deepseek-R1满血版凭借其强大的性能和广泛的应用场景,吸引了众多用户的关注。然而,服务器繁忙的问题也成为了许多用户使用过程中的痛点。本文将为你介绍三种实用的平替方法,帮助你在不进行本地部署的情况下,更高效地体验Deepseek-R1满血版的强大功能。

Deepseek大家都用起来了吗?近日呀,我问了Deepseek一个问题,“针对Deepseek异常火爆的近况,模仿鲁迅的口吻写一句总结。”

然后,我得到了以下的答案——

“服务器繁忙,请稍候再试。”

应该是如今广大Deepseek使用者们最为熟悉的话语了。多少人想要一睹Deepseek真容,却又被这冰冷的话语拒之门外。如果你也有同样的困惑,不必担忧,这里,我给各位朋友推荐3招平替办法。

一、为什么Deepseek总是服务器繁忙?

首先,我们先说明一件事,就是为什么Deepseek总是“服务器繁忙”?可能有些不太了解的朋友会怀疑,是不是我的使用方式不对,是不是它有选择性地拒绝向我们这些普通人提供服务,又或者背后有什么其他的监管原因不让答复?这里我倒是得给Deepseek喊一声冤枉,其实背后的真实原因很简单,就是字面意思,“服务器繁忙”。

据资料显示,Deepseek彻底破圈短短一个月的时间,其DAU(每日活跃用户)以堪称恐怖的速度猛增到2000万的量级,远远甩开一众AI产品。尽管Deepseek以其低算力依赖著称,但是架不住用的人多呀。而Deepseek储备的算力资源还要支持业务研发、模型训练,加之近期还有跨境的恶意网络攻击,这就让能提供给日常服务的算力更加捉襟见肘了。

那么我们作为使用者,有什么解决办法呢?外网流传的,有3招。

- 等:就是等待Deepseek慢慢将算力补上。

- 错峰:基于我15年的产品经历,凌晨1点-6点,是互联网大盘用户活跃的低谷时段,此时使用Deepseek就会比较顺畅。

- 本地部署:由于Deepseek是开源的,因此可以将它部署到自己的电脑或手机上使用。

“哈?这算哪门子的3招解决方案,日内瓦,退钱!”

别急别急,这是外网流传的老3招,而我要介绍的是新3招(就是,皮这一下很开心,哈哈)。但是,要介绍新3招之前,我想要重点批判一下“本地部署”这一招。

(顺利说一下,针对接下来的两个主题,我之前都拍成短视频发布出来。)

二、为什么我非常不推荐普通人本地部署Deepseek

本地部署Deepseek,这是之前网上广泛流传的一种针对Deepseek服务器繁忙的解决办法。更有甚者,这些本地部署Deepseek的教程,在电商平台上少则十元,多则二、三十元的价格挂单出售。看到此情此景,只能感慨一句,“你买,你就上当了!”

我们先说一下这方案是怎么来的。原理也很简单,Deepseek不是云端算力不足嘛,而且它又是开源的,那么我们只要把它部署到本地来运行,不就可以一举解决Deepseek算力不足的问题了吗?

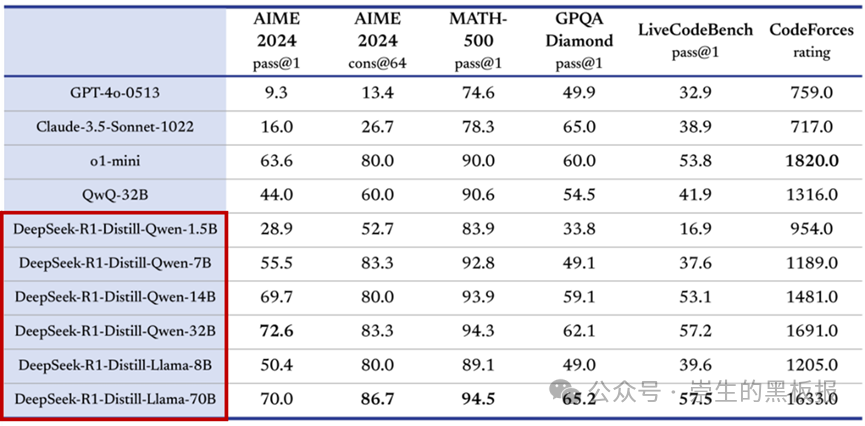

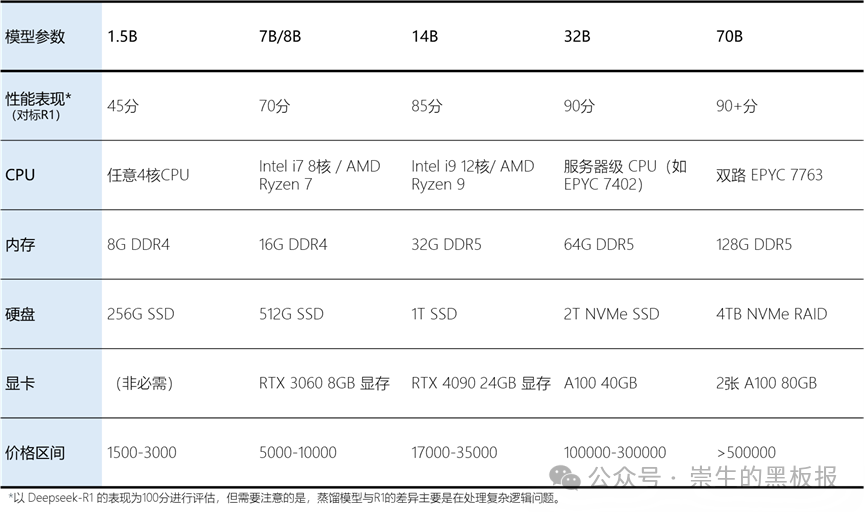

这就是只知其一不知其二了,Deepseek,或者说更准确说是Deepseek-R1满血版本,它是需要非常大的算力支撑的。那些所谓教程教给你的,能够部署到你的电脑或者手机上运行的,都是Deepseek官方通过蒸馏获得的参数规模更小的模型(见下图)。

尽管Deepseek已经是足够强大的AI模型,但不同参数的模型之间,其性能表现和算力诉求,差别是很大的。基于不同参数的模型的性能表现及其最低运行配置,我独家整理了一张表格,来给大家进行参考。

从上表可以看出,普通人家用电脑的极限,也就勉强能支撑Deepseek-R1蒸馏而成的14B模型运行。我估计除了PC游戏发烧友以外,广大人民群众应该没几个人能够拥有这样一套豪华配置。且不说有没有的问题,我们以数万元的代价,即使能让14B模型顺利跑起来,它也就只有R1满血版本85%的性能表现。其他更小的模型的表现就更不必说了。还有还有,我还没有算上本地部署的Deepseek不具备“联网搜索”能力,也无法第一时间获得Deepseek的更新等等不足之处。

如果只是为了解决Deepseek频频服务器繁忙的问题,那么我是非常不推荐大家采用本地部署这样一套解决方案的(除非你是对研究AI感兴趣,那就另说),原因就是性价化实在实在是太低了。

否决了“本地部署”,那么,我推荐大家收藏好的3招平替办法究竟是什么呢?来,我们接着往下看。

三、推荐大家的3招平替办法

来了来了,本文精华来了,以下3招,均可以让你享受到Deepseek-R1满血版本的服务,而且都有一些增强能力给到大家,我们来详细看下。

第1招:使用国内各大已经接入Deepseek-R1满血版本的AI产品

Deepseek作为一个开源的AI大模型,尽管我们的设备无法满足满血版本R1模型的所需算力,但是对于各大AI产品服务商就不是问题了。年后已有多家国内AI产品宣布接入满血版本的Deepseek-R1模型,都有Web版本,打开浏览器即可使用(也陆续更新到其APP当中)。这里我给各位进行了汇总(如有遗漏,朋友们可以在评论继续补充分享)。同时我也相信,后续还会有更多AI产品接入Deepseek。

秘塔AI

由秘塔科技推出,主打长文本解析与多轮对话,擅长文档深度分析与高效信息检索。

秘塔AI于2月2日就宣布接入满血版Deepseek-R1模型,应该也是全网第一家接入Deepseek-R1模型的AI产品(如有其他更早的AI产品请朋友们评论区指正)。在秘塔自身的知识/学术文献搜索能力基础上,融合了Deepseek的推理能力。

地址:https://metaso.cn/

天工AI

由昆仑万维开发,以多模态生成能力为核心,支持文本、代码、图像创作及智能搜索联动。

天工AI于2月8日宣布接入满血版Deepseek-R1模型,实现在财经、学术领域深度信息的快速搜索、深度分析、智能整理。

地址:https://www.tiangong.cn/

知乎直答

来自知乎,基于海量社区知识库生成专业领域回答,强调高可信度内容输出。

知乎直答于2月11日宣布接入满血版Deepseek-R1模型,在知乎社区原有的内容、专业知识的基础上升级了推理能力。

地址:https://zhida.zhihu.com/

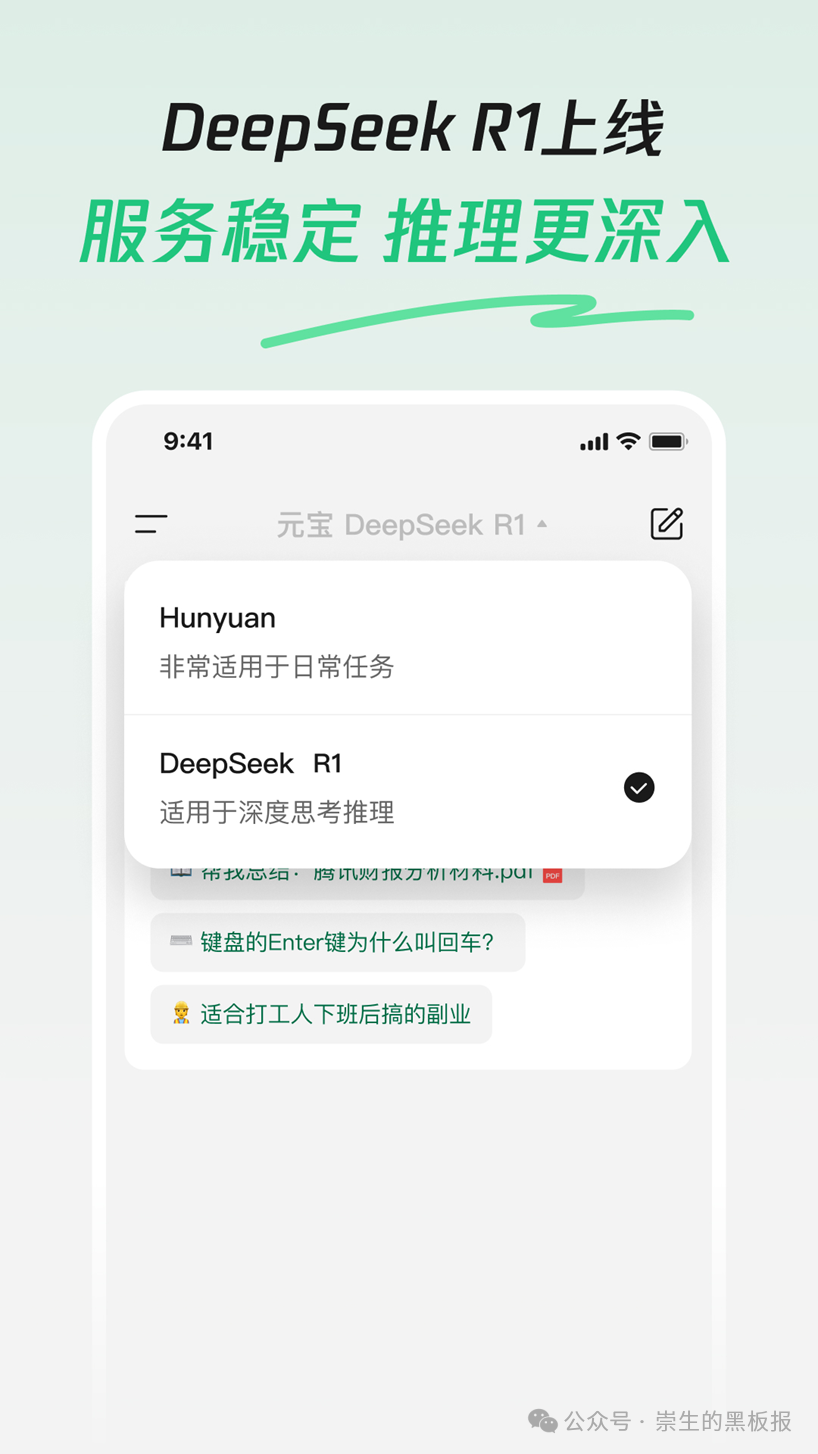

腾讯元宝

由腾讯打造,基座大模型为腾讯混元,提供多模态交互、文件解析及社交场景智能服务。

腾讯元宝于2月13日正式发布更新版本,接入满血版Deepseek-R1模型。相信凭借腾讯背后充足的算力资源,可以保证Deepseek-R1的流畅体验。

地址:https://yuanbao.tencent.com/

第2招:通过Coze搭建以Deepseek-R1为模型基座的智能体

Coze由字节跳动推出,一直是我最推荐使用的智能体搭建平台,其智能体搭建所需的各项能力均非常齐全,而且此前Coze也已经接入了多款国内AI大模型。

Coze于2月7日宣布接入满血版本的Deepseek全家桶。全家桶除了R1满血版本,还有所得的7B、32B版本、Deepseek-V3都已接入。

Coze平台上的Deepseek区别于前面的AI产品就在于它是将Deepseek用于智能体搭建。不过,Coze平台上的Deepseek全家桶尚未支持Function Call,也就是其中的插件、工作流、知识库等等能力都不支持。但我们依然可以借助人设来搭建属于自己的智能体(比如近期流行的“赛博算命”)。不过它将Deepseek的思维链给隐藏起来了,这一点让我不太满意。我个人一直认为,Deepseek的思维链是非常值得参考的内容。

第3招:使用各大云平台提供的Deepseek-R1服务

除了各大通用型AI产品开始接入Deepseek-R1大模型以外,诸如百度云、阿里云、华为云、火山云、腾讯云等各大云平台,都陆续宣传上架Deepseek全家桶。并且各大云平台都推出了对应的“开发者大礼包”,支持开发者免费部署调用。

最后,我们简单总结一下

秘塔、天工、知乎直答、腾讯元宝这几款AI产品也有自己的其他特色功能(比如学术搜索、多模态能力等),接入Deepseek之后更是如虎添翼,而且它们都具备联网搜索能力,其交互体验也相当友好。适合有日常使用诉求的人群,是Deepseek平替的首选。

Coze作为智能体平台,最大的差异化就是支持使用Deepseek搭建智能体,适合有固化场景的人群使用。

各大云平台涉及到AI模型的部署调试,更加适合懂技术的研究人员或者深度爱好者尝试。

最后的最后,说点个人愿望。Deepseek推动了整个行业大踏步前进,但更让人向往的,不是Deepseek的一枝独秀,而是中国AI的百花齐放。希望各大AI厂商继续努力,为用户打造更多优质、好用的AI产品吧。

作者:产品经理崇生,公众号:崇生的黑板报

本文由 @产品经理崇生 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自 unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

起点课堂会员权益

起点课堂会员权益