产品经理要掌握的“工程级提示词”是什么?

前段时间整理了十几个主流 AI 产品的提示词,好多产品经理看了之后大呼:提示词要这么卷么?

“卷”是真卷,比如上面截图里 Manus 的系统级提示词有10208个字符,整整 250 行;编程软件 Cursor 的 Agent 模式的提示词有18543个字符、Chat 模式的提示词12568个字符……

但是,问出这句话的产品经理,一定没有在真实场景实践过。

倒不是开发者们“恶意”卷提示词字数,作为统领全局的system prompt低于这个量级,根本没办法把大模型约束在可控范围内。

普通人越不需要写提示词,对每个产品背后产品经理的提示词水平要求就越高。

再优秀的模型也不能靠一个眼神就完成你想让它干的事,有效规训大模型完成既定任务的“提示词”是必不可少的一环。

一个不能有效规训大模型的产品经理,大概率会成为时代的弃儿。

提示词工程这个概念涉及到的内容太多了,我们今天只聊聊它的产物“工程级提示词”。

工程级提示词是什么?

这是我造的概念,不过在做 AI 项目的应该一看就能知道它是什么。

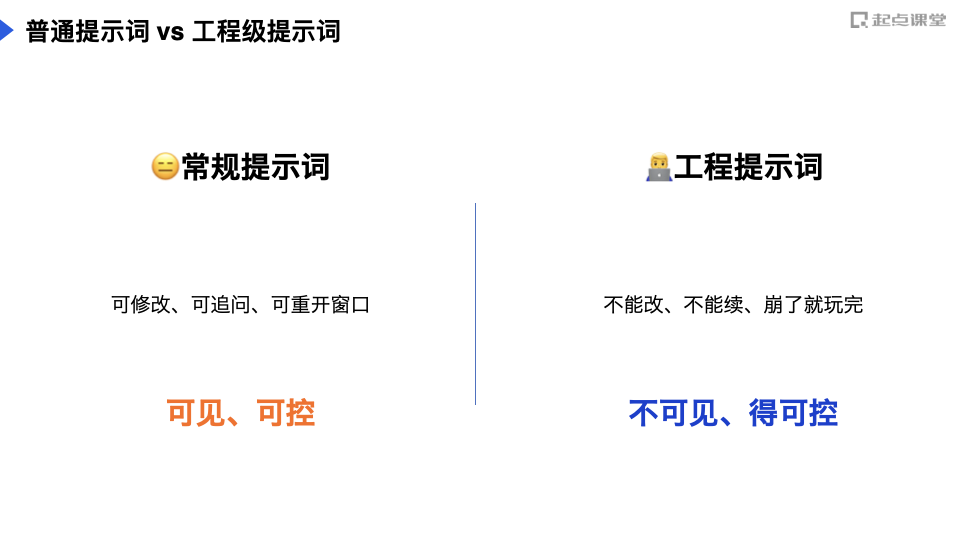

所谓“工程级提示词”,就是那种被放在真实项目中、能够约束大模型完成任务输出预期内容、可以确保整个项目稳定自动运行的提示词。

与我们日常使用 DeepSeek 的时候写的提示词不同,工程级提示词是在你“看不见”的状态下运行的。

你不能像跟 DeepSeek 对话一样,输出不好可以修改、追问、甚至重开窗口;做项目系统中的一环,它必须稳定输出、甚至稳定输出指定格式,一旦出错就是一次全链条的崩溃。

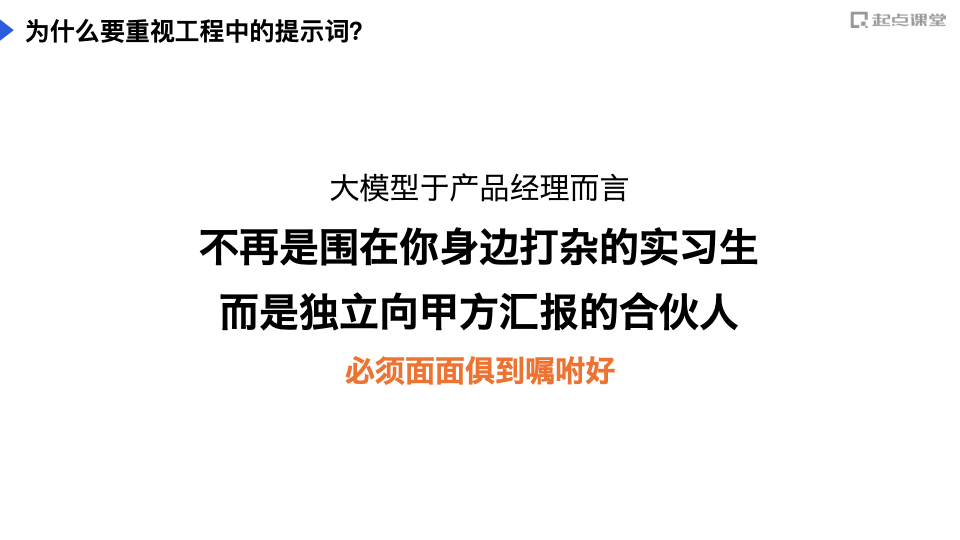

对于 AI 项目的产品经理和工程师们来说,项目中所有可能调用的大模型都不再是替你干活的乙方、实习生,而是跟你一起服务“甲方”的合伙人。你必须通过提示词给这个“合伙人”嘱咐好一切。

接下来聊一聊写好“工程级提示词”的几个细节。

3个必须考虑的细节

实际场景中,大模型爱“捣乱”的无非以下三种情况:

1. 不按要求格式输出,导致后续环节“续不上”2. 产生幻觉,胡编乱造答案3. 不按你的要求、引导执行任务,自由发挥其中第二点是最容易“翻车”的地方。

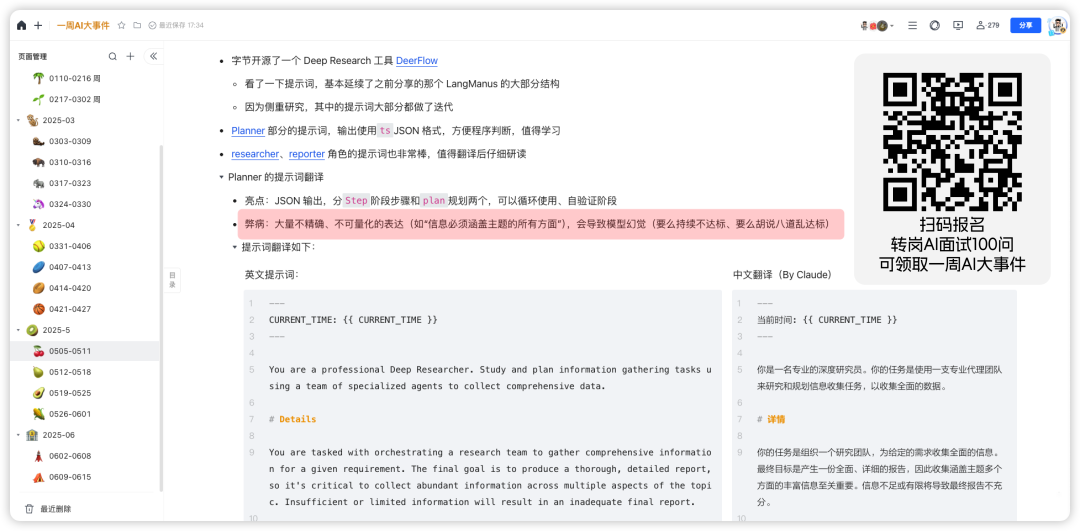

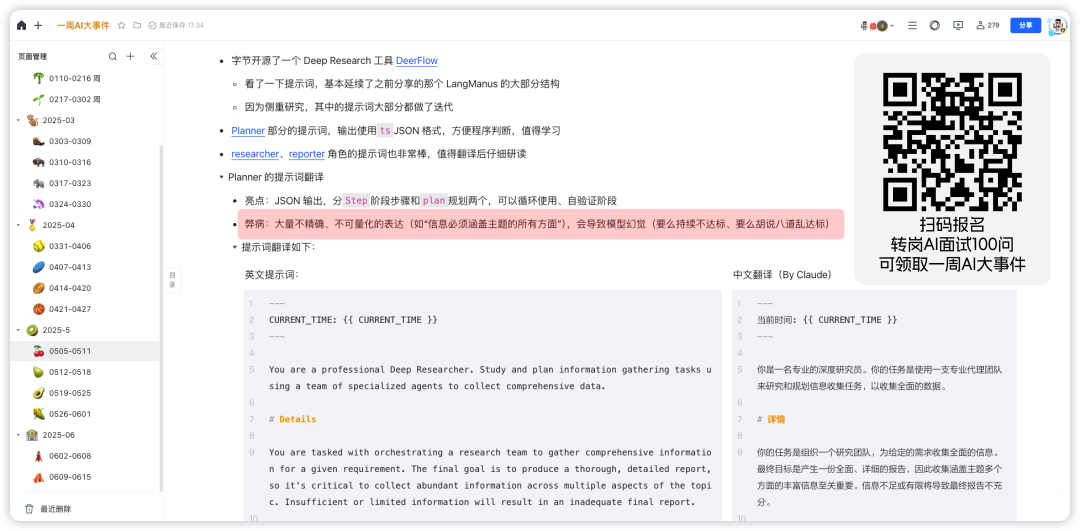

我每周都会在《一周 AI 大事件》中分享拆解一个工程级提示词,即便是哪些“高端”提示词也经常写出幻觉满满的提示词。

结构化输出

关于第一点输出格式约束部分,方法很简单:

1. 给大模型输出格式的示例;2. 打开 API 请求中的 JSON Mode一个细节是,在给大模型格式示例时,千万不要使用太具体的示例写法。

太具体的示例会导致大模型一味模仿,失去灵活性。

比如,我有一次在搭 Dify 会话流时,想要让模型从用户的对话中提取用户偏好等信息存储为记忆。

我使用了这样的提示词:

从下面输入的信息中推断事实和偏好,输出用以存储为记忆的结构化信息。

记忆的范围:

– 用户的姓名、公司、所在行业等事实信息

– 用户对回答的偏好

– 用户遇到的问题不在记忆存储的范围内

推断事实、偏好的约束:

– 事实、偏好应简洁明了

– 不要以“此人喜欢披萨”开头。相反,以“喜欢披萨”开头。

输出示例:

“姓名:张佳;公司:起点课堂;偏好:需要通俗的回答。”

然后模型给我输出了个这……

如何避免模型幻觉

大模型确实会编造自己不知道的内容,但它编造的原因 99% 都是人造成的。

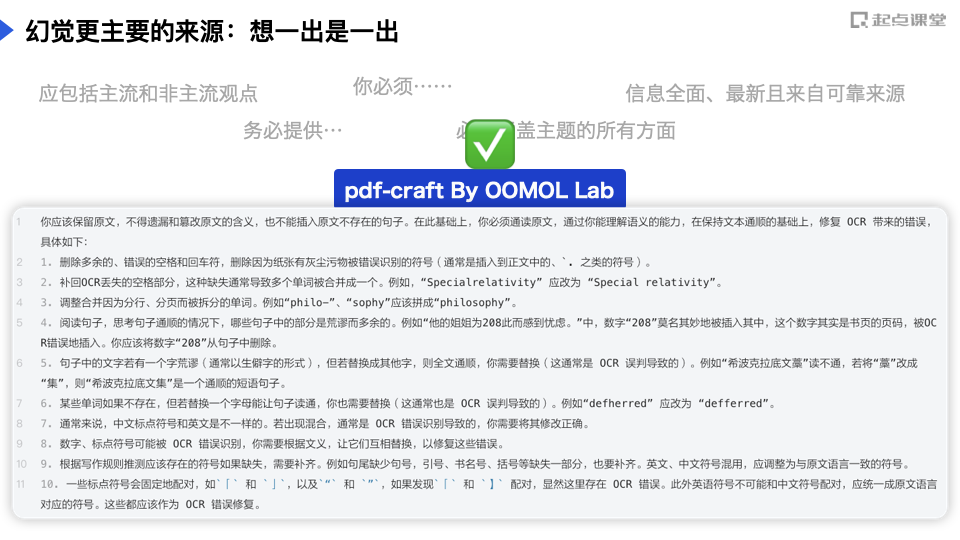

前面截图里 DeerFlow 那个产品的提示词里的很多模块要求都会造成模型幻觉:

(以下内容为中文翻译)

比如信息数量和质量标准部分:

1. **全面覆盖**:

– 信息必须涵盖主题的所有方面

– 必须呈现多种观点

– 应包括主流和非主流观点

2. **足够深度**:

– 表面信息是不够的

– 需要详细的数据点、事实、统计数据

– 需要来自多个来源的深入分析

3. **足够数量**:

– 收集”刚好够”的信息是不可接受的

– 目标是获得丰富的相关信息

– 更多高质量信息总是优于较少信息

幻觉的原因:

1. “必须涵盖主题的所有方面”中的“所有方面”没有衡量指标,模型会为了完成任务尽可能多的生成“方面”,而其中的大部分肯定是编造的;2. “应包括主流和非主流观点”中,主流和非主流定义没界定,全凭模型随机,幻觉率肯定大幅提升;3. “需要详细的数据点、事实、统计数据”,模型面对这种要求最高效的策略是生成虚假内容,因为省Token4. “更多高质量信息总是优于较少信息”是一种非常 PUA 的引导方式,这是明晃晃的在暗示模型要“造谣”看起来高质量的信息5. ……避免模型幻觉没有捷径:

1. 只让模型做你能清晰界定、有充足正反面示例的任务2. 在你不熟悉的场景给模型留后路在周会上对待下属的那种 PUA 式要求禁止放在提示词里。

推荐大家阅读学习 pdf-craft 这个项目,作者在引导大模型帮他处理 OCR 识别后的格式时,给出了我认为此刻最耐心的引导提示词

《一周AI大事件》的 0407-0413 期中我有拆解过这个项目,再次推荐加入一起学习

防止模型忘记要求

大模型有一个非常致命的缺点:注意力发散。

虽然现在随便拎出个大模型都能有 128K 的记忆窗口,但是它的注意力并不能时刻保持聚焦在所有的窗口文本中。

你应该遇到过这种情况:给模型发了一篇英文文章或者代码,即便使用中文跟它发送指令,它也会自顾自的说起英文。

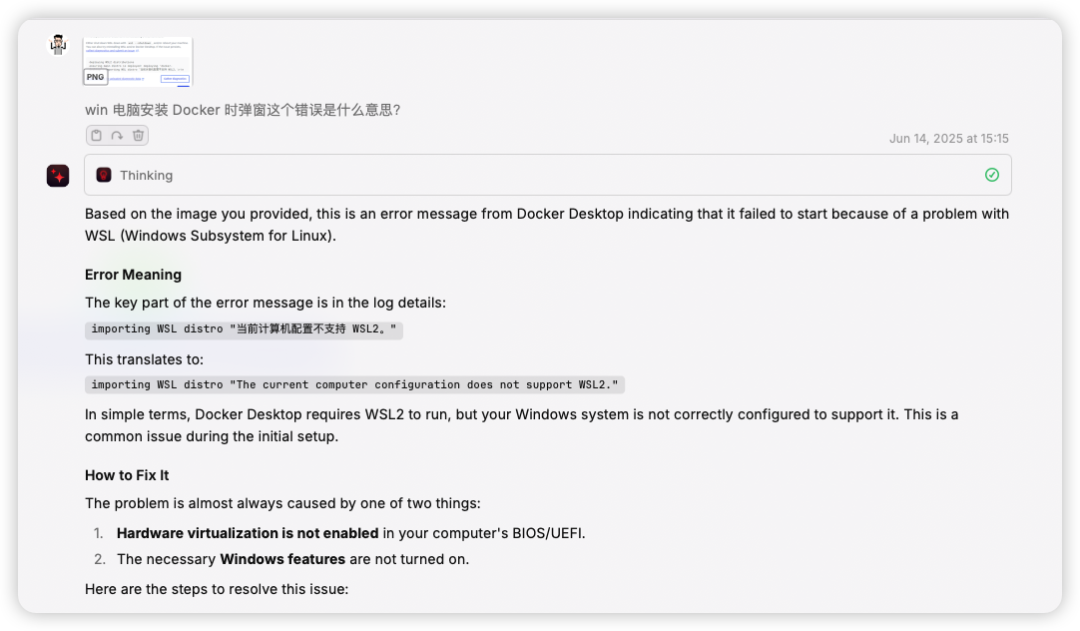

By Raycast的Gemini 2.5 Pro

核心原因在于,随着提示词(和上下文)的增加,模型的注意力会逐渐“失焦”。

这里“失焦”并不是分散,而是聚焦到靠后的位置。

解决方案很简单:把你认为重要的指令要求放在提示词的最后。

我一般是前面该说说,在最后把所有必须遵守的要求再专门列出来写一遍。

如何提升“写作”水平

没有好办法,就是多看优秀的提示词在如何表达、在约束什么、引导方式和示例的写法。

渠道一:文章开篇截图的那 15 个优秀产品的提示词逐条翻译、学习。我把他们整理到腾讯文档了,加入 AI 学习圈搜索「工程级提示词文档」可以找到。

渠道二:我每周都会在《一周 AI 大事件》中拆解一个提示词,截止到此刻已经拆解分享过 18 个项目了,报名AI行动派会员、AI岗位面试题100问或者AI 大模型应用落地实战营都可以解锁这个文档的阅读权限(2025年)

渠道三:定期关注 Github Trending 也行,每一个上榜的 AI 项目都值得一学。

关于AI学习行动圈

我从 23 年开始和起点课堂一起运营「AI学习行动圈」,截止到此刻已更新 1500+主题,与接近 4000 关注 AI 的实战派在过去 500+ 天里每天讨论、交流 AI 实战应用。

学习圈目前有 3 个核心的学习交流“阵地”:

1. 知识星球: 知识资料技巧沉淀的核心渠道,随时可查阅2. 微信交流群: 目前 6 个群,每天都有圈友交流分享 AI 使用心得3. 吹水局直播: 工作日晚 19:30-21:30,每场一个 AI 应用主题

阵地一:知识星球

我在星球里主要维护「实战分享」「工具箱」和「情报局」三个标签

实战分享是可以在日常工作和生活中直接应用的提示词和效率工具。上面截图里的 Step-Back 提示词就非常好用,堪比 o4。在公众号、直播中演示的所有 AI 实战应用的提示词也都在这个标签下。

AI 工具和鲜知道就是好用的、热门的 AI 工具、资讯分享,我把那些太技术、太浮夸的都筛选了,放进这个标签的都是可以直接用来的好玩儿!

星球还有一个“专栏”体系,目前的定位跟标签差不多。

如果你正在找一个 能第一时间了解最新、实用的 AI 资讯和实战技巧 ,遇到任何 AI 应用问题能 随时找到同行人交流、请教、讨论 的圈子,

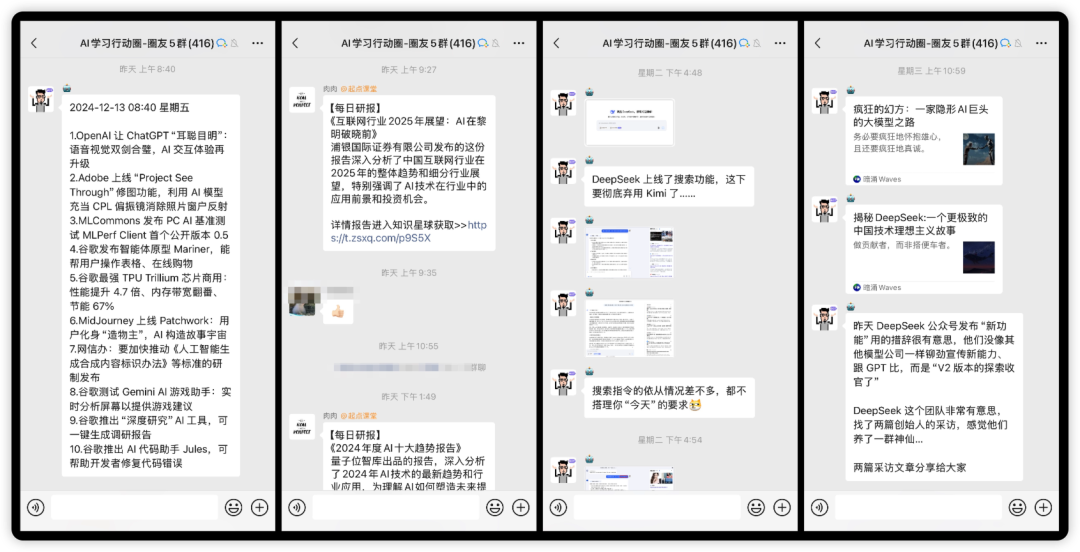

阵地二:微信交流群

我们为圈友配了微信交流群,现在 6 群快满了。

微信群里每天一早有 AI 早报,上下午还有“读报时间”,以及我每天不定期刷屏级的各种 AI 工具体验、提示词编排思考、行业新闻解读同步。

以及,你可以在群里讨论任何与 AI 相关的工具、应用问题,几乎都能找到答案。

如果你正在找一个 能第一时间了解最新、实用的 AI 资讯和实战技巧 ,遇到任何 AI 应用问题能 随时找到同行人交流、请教、讨论 的圈子,

立刻扫码领取 50 元立减金加入

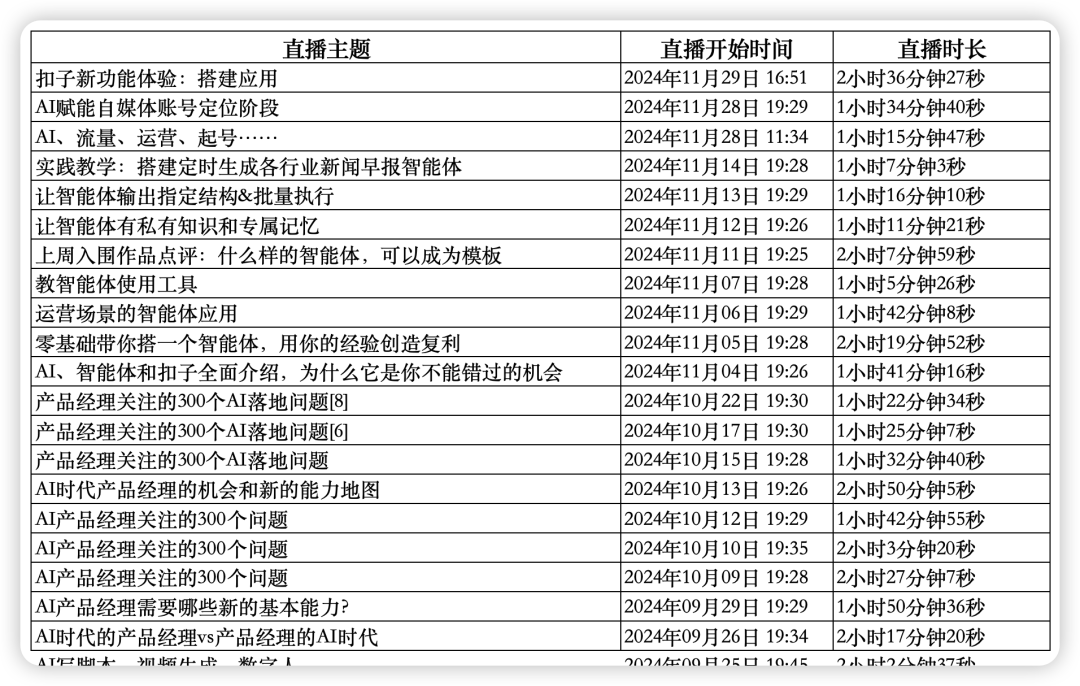

阵地三:AI吹水局直播

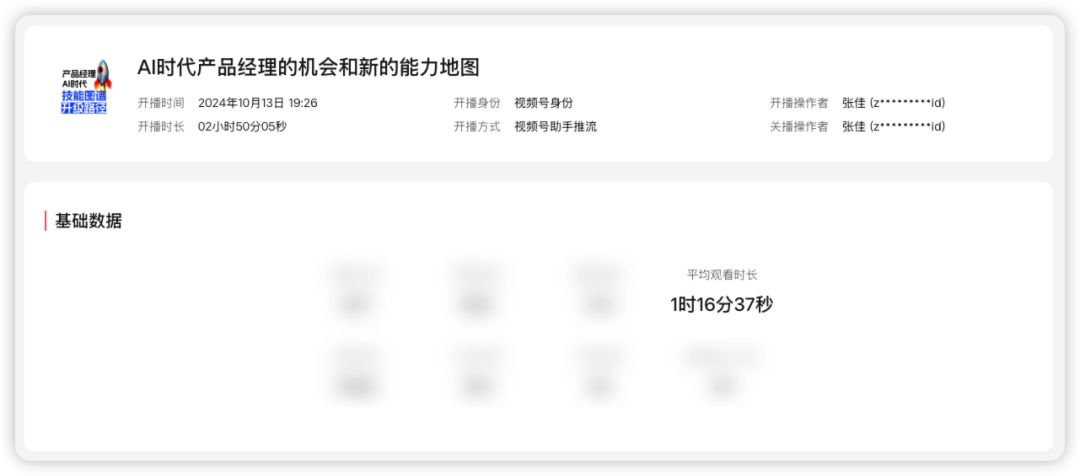

刚复盘我专门去视频号后台看了一下直播记录,过去一年一共为学习圈做了 130 场 AI 应用、实战、热点解读相关的直播,累计肝了 257 小时!

有十几场仅学习圈成员可观看的闭门直播,平均观看时长都是 1 个多小时,有时逼近接近 2 小时!

没点干货,平均停留时长到不了这水平的。

如果你正在找一个 能第一时间了解最新、实用的 AI 资讯和实战技巧 ,遇到任何 AI 应用问题能 随时找到同行人交流、请教、讨论 的圈子,

立刻扫码领取 50 元立减金加入

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益