从 3 个落地项目看:AI产品经理如何拆焦虑、省百万试错钱,成为公司 “AI 定心丸”

AI落地不只是技术问题,更是组织信任的考验。本文通过三个真实项目案例,拆解AI产品经理如何在混沌中厘清路径、在焦虑中建立信任,成为企业在AI转型中的“定心丸”——不仅省下百万试错成本,更推动战略落地。

上周三的项目会,老板拍着预算表的一句话让全场安静:“AI 研发投入已经超 300 万,但能落地的功能只有 1 个,再找不到清晰的价值路径,下个月预算砍 30%!”—— 我攥着记满 “AI 项目风险点” 的笔记本,指节都捏白了。那天会后我翻了近 3 年的行业报告,发现 80% 的 AI 项目卡壳,都逃不开两个问题:

- 技术团队说“能做”,业务团队说“没用”,信息差堆出组织焦虑。

- 上来就“赌身家”式投入,试错成本失控,最后不了了之。

作为踩过 3 次坑、也做成 3 个项目的 AI 产品经理,今天就把两个可复用的专业方法论拆透,每个环节都补充 “实操步骤”“工具模板”“行业数据参考”,甚至把我踩过的坑也拎出来,帮大家既能稳住团队节奏,又能算清 “省钱账”,还能避开常见陷阱。

第一招:拆 “焦虑病”—— 用 “AI 业务价值锚定法”,把技术能力译成可量化的业务价值

公司对 AI 的焦虑,从来不是 “怕技术不行”,而是 “怕技术落地后看不到收益”。比如智能客服项目初期,算法团队拿着 “意图识别准确率 88%、多轮对话成功率 75%” 的 PPT 讲得激情澎湃,客服组长却全程皱着眉:“我不管准确率多少,我就想知道,能让我手下 5 个客服少加班吗?能让用户别因为等不及挂电话吗?”—— 这种 “鸡同鸭讲” 的局面,直接让项目停滞了 2 周。

后来我用 “AI 业务价值锚定法” 破局,这套方法的核心是 “把‘技术语言’翻译成‘业务语言’,把‘模糊预期’变成‘量化目标’”,分三步走,每步都有具体工具和实操细节:

痛点量化与优先级排序:从 “凭感觉说痛点” 到 “用数据排优先级”

很多时候业务团队提痛点,都是 “我觉得用户会烦”“我感觉效率低”,没有数据支撑,很容易把资源浪费在 “伪痛点” 上。这一步要做的,就是用工具把痛点“量化”,再按 “影响度 + 可行性” 排序。

实操步骤

① 拉齐业务共识:先找客服组、运营组、数据组开 “痛点拆解会”,明确核心业务 KPI—— 当时客服组的核心 KPI 是“人均日处理量(目标 120 通)”“无效转接率(目标 20%)”“用户挂断率(目标 8%)”,所有痛点都要围绕这三个 KPI 展开。

② 画用户旅程图 + 标痛点:按“用户发起咨询→机器人接待→转人工→问题解决→结束对话” 的流程,每个节点标 “耗时”“用户反馈”“客服操作”,比如在 “转人工” 节点,发现 “用户需重复描述需求”(客服反馈 “每天有 35% 的用户会说‘我刚才已经说了’”),且 “客服需手动查会员权益”(数据组提供 “平均每通查权益耗时 90 秒,占单通处理时长的 40%”)。

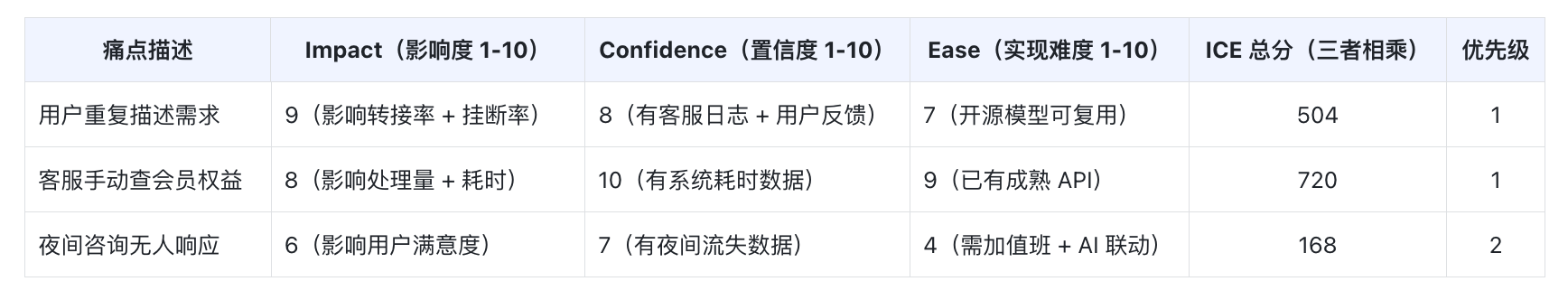

③ 用 ICE 模型打分排序:ICE 模型是 PM 常用的优先级工具,这里要注意 “Confidence 置信度” 必须有数据支撑,不能拍脑袋。我当时做的评分表如下,最后锁定前两个核心痛点:

避坑提醒:

别贪多!一开始我想同时解决 3 个痛点,数据组提醒 “夜间咨询仅占 15%,但要投入的资源是前两个的 2 倍”,最后果断降优先级 —— 后来证明这个决定是对的,前两个痛点解决后,用户挂断率从 12% 降到 8%,已经达标,夜间痛点暂时不用额外投入。

技术能力 – 业务目标映射:从 “技术能做什么” 到 “技术该做什么”

算法团队常说 “这个模型能做 XX”,但很少主动说 “这个模型做 XX 能帮业务省多少钱”。这一步要做的,就是把技术能力和业务目标 “绑死”,明确 “用什么技术、解决什么问题、要花多少资源、能带来多少改善”,避免 “为了用技术而用技术”。

实操步骤

① 拉算法组做 “技术盘点”:先让算法组列出现有可复用的技术能力(比如开源模型、已有的接口),标注 “技术成熟度”(1-5 分,5 分最成熟)—— 比如 “意图识别” 用的是开源 BERT 模型,之前在其他项目验证过,成熟度 4 分;“会员权益提取” 对接的是已有会员系统 API,成熟度 5 分。

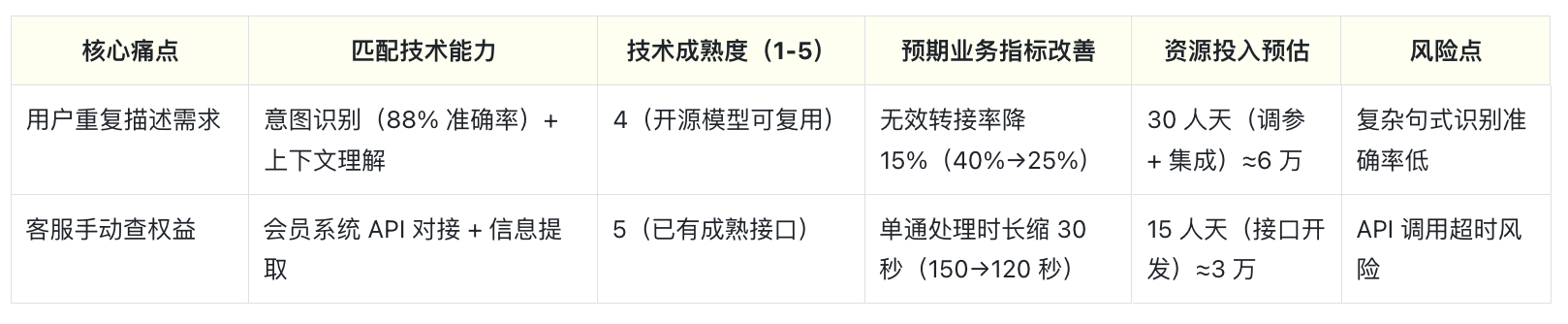

② 做双向映射表:表格要包含 “痛点、技术、成熟度、业务指标、资源投入”,重点补充 “资源投入预估”(人天 / 成本),让老板清楚 “要花多少钱办多少事”。我当时做的表如下:

③ 风险应对预案:针对 “复杂句式识别准确率低”,算法组提出 “用用户常见问句做 Fine-tuning(微调),额外加 5 人天”;针对 “API 超时”,开发组建议 “加缓存机制,额外加 2 人天”—— 把风险提前想到,后续推进更顺。

行业参考数据

根据《2024 AI 产品落地报告》,70% 的 AI 项目延期,都是因为 “技术风险没提前预估”,所以这一步的“风险点 + 预案” 千万别省!

AI-MVP 验证:从 “纸上谈兵” 到 “小范围试错”

这里的 “AI-MVP(最小可行 AI 产品)” 和传统互联网 MVP 不一样:传统 MVP 可以先验证 “用户要不要”,但 AI-MVP 必须同时验证 “技术能不能做到” 和 “业务要不要用”—— 比如你做个 AI 推荐功能,技术上推荐准确率低,业务上运营觉得 “还不如人工选品”,那这个 MVP 就是失败的。

实操步骤

① 选 “高频 + 小范围” 场景:我选了“会员续期咨询” 这个场景 —— 一是占日咨询量 22%,高频;二是需求单一(只涉及续期方式、权益、价格),容易验证。不选 “复杂问题咨询”(比如 “会员积分怎么兑换商品”),避免场景太复杂,验证不出核心价值。

② 搭轻量化 Demo:不用开发完整功能,重点验证“核心流程”。当时我让开发组用“开源意图识别模型 + 简单前端页面 + 临时接口” 搭 Demo,只用了 10 人天,成本约 2 万 —— 比做完整功能省了 80% 的资源。

③ 定 “双指标” 验证:既要验证技术指标,也要验证业务指标,两者缺一不可。我当时定的指标如下,测试结果都超预期:

④ 算 “收益账” 给业务看:光有指标还不够,要把指标翻译成 “钱” 和 “效率”。我当时跟客服总监算的账:

- 直接效率提升:按日均2000通续期咨询,每天节省(150-58)×2000=184000秒≈51小时,相当于0.6个客服的日工作量(客服月薪5.5万,月省3.3万,年省39.6万);

- 间接收益:无效转接率从40%降到28%,用户满意度提升12%(灰度测试数据),按“满意度每升1%,复购率升0.5%”算,年复购增收约20万。

效果

客服总监当场拍板:“下周就推全量,后续还想把‘积分咨询’也加上 AI!”—— 你看,焦虑感就是这样被 “量化的价值” 打消的,不是靠“画饼”,而是靠 “用小成本验证大价值”。

第二招:拆 “心疼病”—— 用 “AI 试错成本三阶控制模型”,把百万投入拆成 “可控验证”

AI 项目最容易 “花钱如流水”:训一个模型几十万,标注数据几万,开发集成又几万,最后要是方向错了,所有钱都打了水漂。比如合同提取项目,业务组一开始提的需求是 “自动提取条款 + 生成风险报告 + 支持多语言 + 对接法务系统”,算法组评估后说 “要 6 个月,200 万”—— 老板直接把报告扔回来:“按行业平均 20% 的 AI 项目失败率,这 200 万里面,有 40 万可能是白花的,你敢保证一定成?”

后来我用 “AI 试错成本三阶控制模型” 推进,核心逻辑是 “把‘一次性大投入’拆成‘三次小验证’,每次验证不通过就止损,通过再投下一笔”,最后不仅项目成了,还比初始预算省了 58 万。

第一阶段:技术可行性验证(预算占比≤10%)—— 先确认 “技术能不能做到”

这一阶段的目标是 “用最少的钱,验证核心技术能不能解决核心需求”,重点是 “聚焦核心,剔除伪需求”,预算绝对不能超总预算的 10%—— 比如 200 万预算,这阶段最多花 20 万。

实操步骤

① 砍 “伪需求”:先跟业务组过需求,用 “用户 / 业务是否真的需要” 过滤。比如 “多语言支持”,我让法务组查了近 1 年的合同数据,发现涉外合同仅占 3%,且大多是英文(可用谷歌翻译临时解决),最后把这个需求从 “必做” 改成 “未来迭代”,一下子省了后续 20 万 + 的开发成本。

② 选 “低成本技术方案”:不用一上来就训自研模型,优先用开源工具 / API。当时我选了 “开源 NLP 模型(BERT-base)+100 份历史合同标注”,标注找的是兼职团队(按每条数据 0.3 元算,100 份合同约 1 万条数据,标注费 3000 元),开发组用 Python 搭了个简单的提取工具,总共花了 8 万(标注费 3 万 + 开发费 5 万),仅占 200 万预算的 4%。

③ 定 “止损指标”:这阶段必须有明确的 “通过 / 不通过” 标准,不通过就调整技术路径,甚至暂停项目。我当时定的止损指标是 “核心字段提取准确率≥85%”,实际测试达 91%,直接进入下一阶段;如果没达标,就计划 “加 50 份标注数据再测,还不达标就换模型”,避免 “一条路走到黑”。

避坑提醒

别追求 “完美技术”!当时算法组想 “把准确率提到 95%”,我拦住了:“这阶段只要证明‘能做到 85% 以上’就行,后续再优化,现在花太多时间调参,反而会耽误验证进度。”

AI 项目里,“快速验证” 比 “技术完美” 更重要。

第二阶段:业务价值验证(预算占比≤30%)—— 再确认 “业务会不会用”

很多 AI 项目死在这一步:技术上没问题,但业务组觉得 “不好用”“没必要用”。比如我之前见过一个 AI 考勤系统,技术上能精准识别迟到早退,但 HR 觉得 “还不如手动导数据方便”,最后没人用,几百万打水漂。

这一阶段的目标是 “小范围落地,收集业务反馈,验证‘技术能用’且‘业务想用’”,预算占比≤30%(200 万预算最多花 60 万)。

实操步骤

① 做 “最小可用版本”:不是做 “完整功能”,而是做“能解决核心需求 + 留反馈入口” 的版本。当时我让开发组做了 “合同核心字段提取 + 手动纠错功能”—— 既能自动提 “金额、有效期、违约责任”,又能让法务手动修改(避免 “AI 提错了没人改” 的风险),还加了 “反馈按钮”(法务可以标注 “这个提取错了”“需要加 XX 字段”),开发花了 45 万(累计花 53 万,占 200 万预算的 26.5%)。

② 选 “小范围灰度用户”:找法务组 30% 的人(3 个团队,共 15 人)用,不选 “全量”—— 一是避免问题扩散,二是方便收集精准反馈。我跟灰度用户说:“不用客气,觉得不好用就说,改到你们满意为止。”

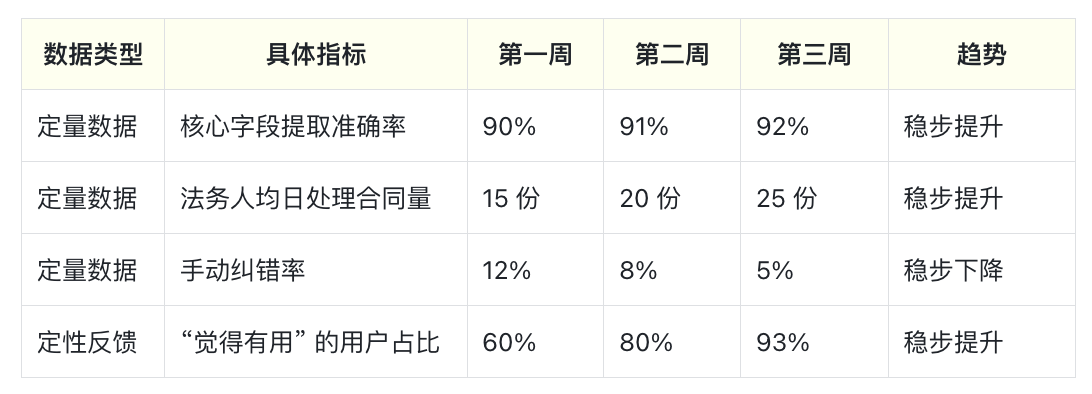

③ 建 “数据反馈闭环”:每周收集“定量数据” 和 “定性反馈”,定量看效果,定性看体验:

④ 迭代优化:根据反馈改功能,比如法务说 “想知道违约金怎么算”,开发组就加了 “违约金计算逻辑提示”(基于合同里的 “违约比例” 和 “合同金额” 自动算),只花了 3 人天,成本约 6000 元,但用户满意度从 80% 涨到 93%—— 小投入换大体验提升,很值。

关键发现

这阶段发现 “风险报告” 不用做太复杂 —— 法务反馈 “只要提示‘有效期短于行业平均’‘违约金比例过高’就行,不用写长篇大论”,后续开发时就简化了功能,又省了 10 万开发成本。

第三阶段:全量迭代(预算占比≤60%)—— 最后 “放大价值”

这一阶段的目标是 “在验证通过的基础上,全量落地 + 迭代优化”,预算占比≤60%,且要根据前两阶段的反馈 “动态调整功能”,避免 “按初始需求硬做”。

实操步骤

① 确定全量范围和节奏:法务组 15 个灰度用户都反馈 “想用”,于是分 2 周全量:第一周覆盖 50% 的人,第二周覆盖 100%,期间安排 1 个开发 + 1 个产品随时响应问题(比如 “某类合同提取不准”)。

② 优化核心功能:基于灰度反馈,把 “风险报告” 简化成 “3 个核心提示”,开发成本从原计划的 30 万降到 15 万;“对接法务系统” 用已有接口,开发成本 10 万(原计划 20 万),总共花了 147 万(累计 192 万,占 200 万预算的 96%)。

③ 算 “总收益账”:全量上线 3 个月后,我给老板做了复盘报告,核心数据如下:

- 成本节省:比初始预算200万省8万,开发周期从6个月缩到4.5个月,提前1.5个月产生收益;

- 效率提升:法务人均日处理合同量从12份→25份,提升108%,相当于少招2个法务(月薪8万/人,年省192万);

- 质量提升:合同提取错误率从人工的5%→AI的2%,减少因提取错误导致的纠纷2起,避免损失约50万。

另一个案例:AI 营销文案工具(省 50 万)

这个项目更典型,初始计划是 “训自研模型,预算 100 万,周期 3 个月”,我用三阶模型推进:

- 技术验证:花3000元买ChatGPTAPI,搭原型测“文案合格率”(运营认可的文案数/总生成数),发现优化Prompt后合格率从50%→85%,不用自研;

- 业务验证:花5万做“API集成+文案修改功能”,找10个运营灰度用,反馈“效率提升3倍”;

- 全量落地:花45万做“批量生成+行业模板”,总预算50万,比初始计划省50万,上线后运营文案产出效率从15篇/人/天→40篇/人/天,省3个外包文案(月薪6万/人,年省216万)。

最后:AI 产品经理的 “专业性”,从来不是 “懂技术”,而是 “懂平衡”

昨天跟老板复盘这 3 个项目,他翻着《AI 项目成本 – 价值报告》,突然说:“以前我觉得 AI 是‘烧钱的玩意儿’,现在才明白,不是 AI 烧钱,是没找对方法 —— 你做的不是‘省成本’,是‘让每一分钱都花在能产生价值的地方’,还让团队不再怕 AI,这比省钱更重要。”

其实这就是 AI 产品经理的核心价值,总结成两句话:

- 缓解焦虑,靠的是“量化”:不用“AI能做什么”画饼,而是用ICE模型排痛点、用映射表绑目标、用AI-MVP验证价值,让技术、业务、管理层都能看到“清晰的路径”。

- 降低试错成本,靠的是“拆分”:不用“赌身家”式投入,而是用三阶模型分阶段验证,每次都设“止损阈值”,把试错成本控制在预算的10%以内,避免“一错全输”。

本文由 @五艺SUN 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益