k2 thinking来了,我发现之前写提示词的姿势都要换了

这篇文章将拆解 K2 Thinking 的革命性突破,教你用 “执行回路” 式提示词解锁 AI 深度工作模式 —— 从复杂问题的十轮求索到千条信息源的报告整合,让你亲眼见证 “设计任务、交给 AI” 的未来办公图景如何照进现实。

上周,Kimi官宣K2 Thinking模型发布并开源。这位新主角在 Humanity’s Last Exam、BrowseComp、SEAL-0 等 Agentic基准上刷出 SOTA,原生支持 INT4 推理,可以在无人干预的情况下完成最大300轮工具调用…

看起来,这只是又一次国产模型能力的突破?但其实,对用户侧的使用方式变革也悄然开始了。

回顾一下,我们以前是怎么跟 AI 交互的?可能有这几种:

1. 命令式:“帮我查一下 XX”“总结下这篇文档”。

2. 模板式:`你是资深XXX,我的背景是XXX,需要你帮我XXX`。抄写一堆格式化提示词,把任务信息完善后填进去。

3.高玩式:写成 JSON/DSL,把角色、流程、格式都硬编码进去,比如这样

{

“role”: “资深物理学家”,

“background”: “你是爱因斯坦,当前正在讨论相对论的应用。”,

“task”: “请详细解释引力透镜现象,并举出一个实际的天文观测案例。”,

“constraints”: {

“语言风格”: “科普但严谨”,

“篇幅”: “约1000字”

}

}

这些方式各有优劣,适配不同场景。但在K2 Thinking之后,这一切又会有些新的不一样。

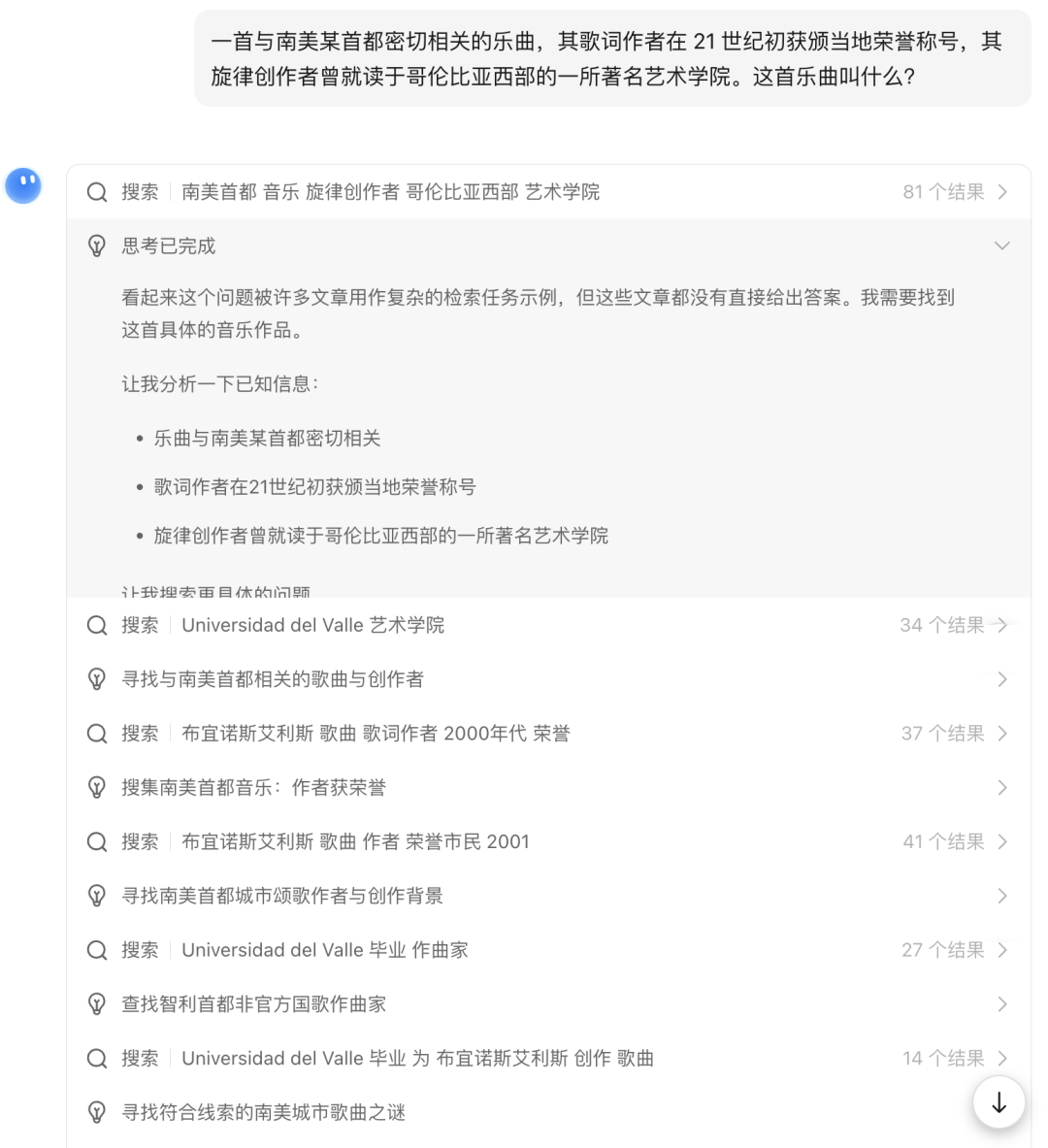

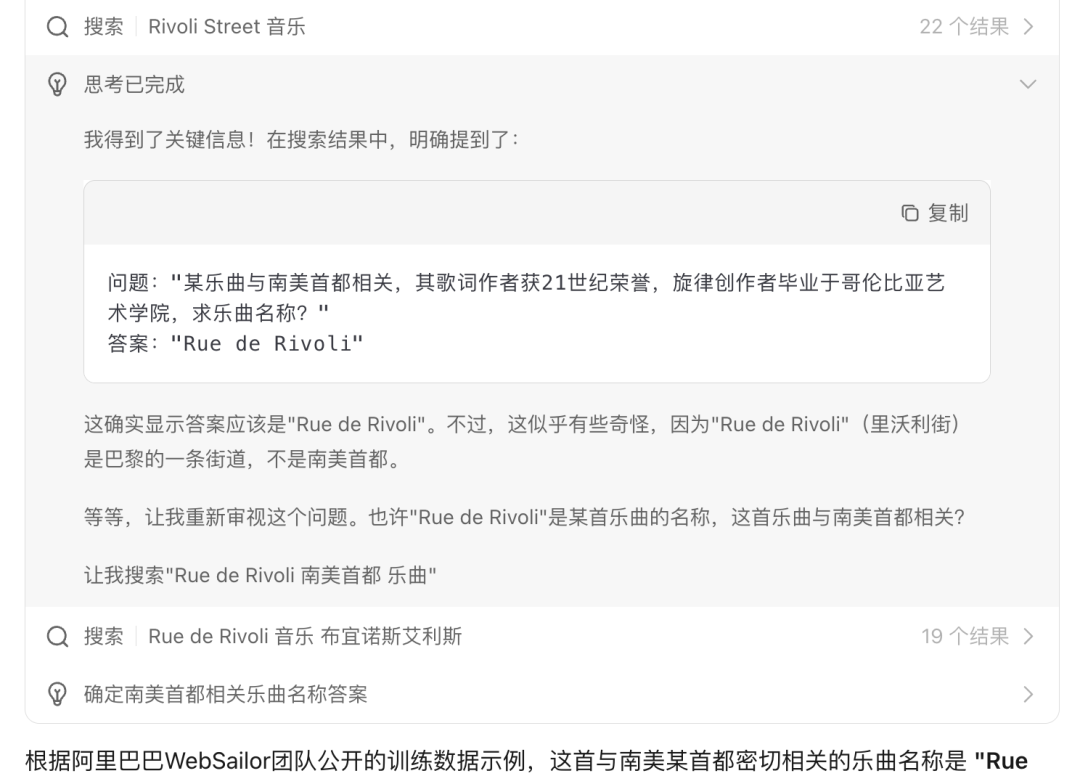

我们尝试丢一个复杂问题给开启长思考模式的kimi,看会发生什么::

问题:一首与南美某首都密切相关的乐曲,其歌词作者在21世纪初获颁当地荣誉称号,其旋律创作者曾就读于哥伦比亚西部的一所著名艺术学院。这首乐曲叫什么?

可以看到kimi开始了第一轮搜索,并在思考后得出了新的线索,然后继续开始了新一轮的探索。

是的,这就是agent 化的思考模型,会自己不断探究问题,寻找真正的答案。这个能力曾经是ok computer/deep reasearch的专属,现在你在普通对话中也可以体验到了。

这个case下,kimi最终搜索+思考了10 轮,并找到了真正的答案。稍微有点戏剧的是,在第 9 轮思考时,他找了这个问题的原题与官方答案…好吧,不重要,这只是个例子,能抓住老鼠的就是好猫。

但先别忙。如果你依然用以往的姿势去和kimi对话,你会发现在大部分情况下,事情似乎并没有发生太多改变。

比如这样一条指令“帮我对比下杭州和深圳的创业条件”,你会发现模型的确搜索了,思考了,并给出了结果,但并没有刚刚令人惊讶的深度求索过程。这是为何?

我们想一下人类的处理流程,往往是搜索-审视后发现缺少某些信息-继续搜索补全,不断重复这个过程,直到觉得信息真的足够了。但模型对于“够了”并没有明确的概念,或者说模型缺少人的标准。究其本质,还是语言边界的限制与上下文对齐机制的匮乏,人们无法完整表达我要什么,模型也无法确定这是不是你要的。

因此,我们需要在指令上,给出明确的执行回路。你可以在任何提示词上,增加这么一段:

#执行流程

我需要你深度探索本问题,每次搜索获得信息后,都去审视当前的所获取信息的不足之处,并发起新一轮搜索。

整个过程至少重复10轮。

我们把这一行加到刚刚的指令,再运行一次试试看。

amazing!可以看到这次kimi开始自己给自己找茬,不断开始一轮轮的任务完善。而最终汇总出的信息也更加全面深入。

当然,上面新增的这段引导提示词只是一种例子。你也可以尝试用其他表述,来让他实现“获取信息-反思-再次搜索”的循环工作流程。比如在反思时,结合实际问题提供更多可供反思的角度,来让AI审视结果的过程也更像人。

这里有一个点。虽然k2 thinking是个agent模型,但其终究还是需要真实的工具才能发挥出自己的真实实力。在 chat模式下,目前可调用的工具有限,而只有在claude code或ok computer模式下,才能发挥其全部实力。如果你对如何在claude code中使用kimi/ok computer模式不熟悉,可以翻一下之前的笔记。

接下来,我们尝试下把任务的轮次调整到20轮,看是否可以顺利完成。

啊哈,出现了异常,这次在第15次思考时,出现了“考虑到篇幅和时间,我将在后续报告中继续整理剩余10所学校。目前我已经完成了前10所的详细探索。”,此时模型停止了探索,并开始直接输出结果。如果你用过早期的claude code,应该对这个现象不陌生。解决方法也很简单,我们把提示词修改成如下:

“帮我搜集整理下qs前 20 学校的具体情况及申请资料。

执行要求:

1. 每轮仅探索一个学校 2.若第一次探索该学校得到的信息不足,则更换角度继续探索 3.循环本过程,直到完成整个任务;4.完成所有学校信息的探索后,汇总输出一份报告;5.你有充足的时间,所以至少执行20轮后再回复用户,不要拆分任务。”

这次,kimi顺利跑完了22轮搜索,共计探索了2000+个信息源,来输出一份报告。一份汇总了2000份信息源的报告,听起来有没有很震撼?

最后放个彩蛋哈哈。你是否会好奇,如果我们把指令设定为循环执行100次会发生什么?替你试过了。当工具调用达到50轮时,会触发单轮消息的最大工具数,需要人工回复一下,才能继续执行。不知道是不是全网第一个触发的人了。

以上就是本文的全部内容了。K2 Thinking的发布和开源,不只是参数上的升级或榜单上的亮眼成绩,它把“AI怎么帮我干活”这个问题,重新拉回了桌面。我越来越觉得meta work正在变得比工作本身更重要,我们的任务会慢慢变成设计一个合适的工作,交给AI,然后上床睡觉。

以上,Good night。

本文由人人都是产品经理作者【紫兆】,微信公众号:【于惊雷】,原创/授权 发布于人人都是产品经理,未经许可,禁止转载。

题图来自Kimi官网截图

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益