从底层原理让你的AI更好用!

在使用AI工具时,你是否遇到过答非所问、数理计算不准确或编造事实等问题?这些问题可能源于提示词的不当设计或模型本身的局限性。本文将从大模型的底层原理出发,深入探讨如何通过提示词调优、外部资源调用和模型微调等方法提升AI的使用效果。

在用AI落地你的想法时,是否有遇到以下问题:

- 答非所问

- 数理计算不准确

- 编造事实

…

大家遇到这些问题时可能会疑惑:到底是提示词写的不好?还是模型本身的能力不足?

面对问题却只能“拔剑四顾心茫然”,不知道该用什么方式解决问题

本文的目的便是帮大家理解大模型,后续使用AI遇到问题时,能够快速找到合适的解决方案

(为帮助不同背景的同学理解,本文的举例、概念有一定的简化)

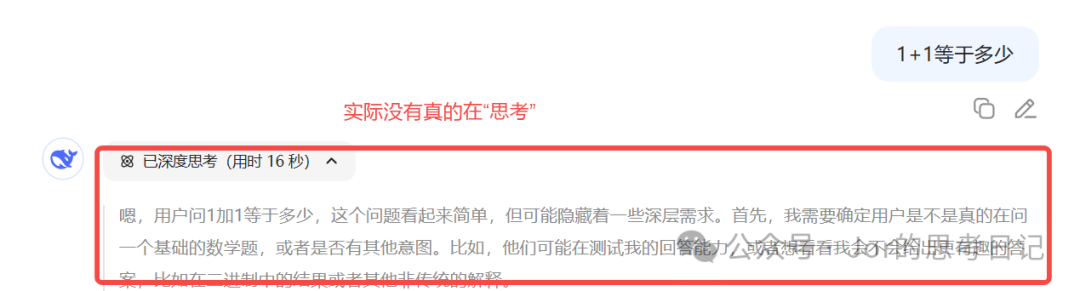

一、大模型不会思考

从deepseek、豆包等大模型的使用体验而言,我们能感受到大模型有所谓“思考”的过程,但其实这只是为了用户体验所包装出来的假象:

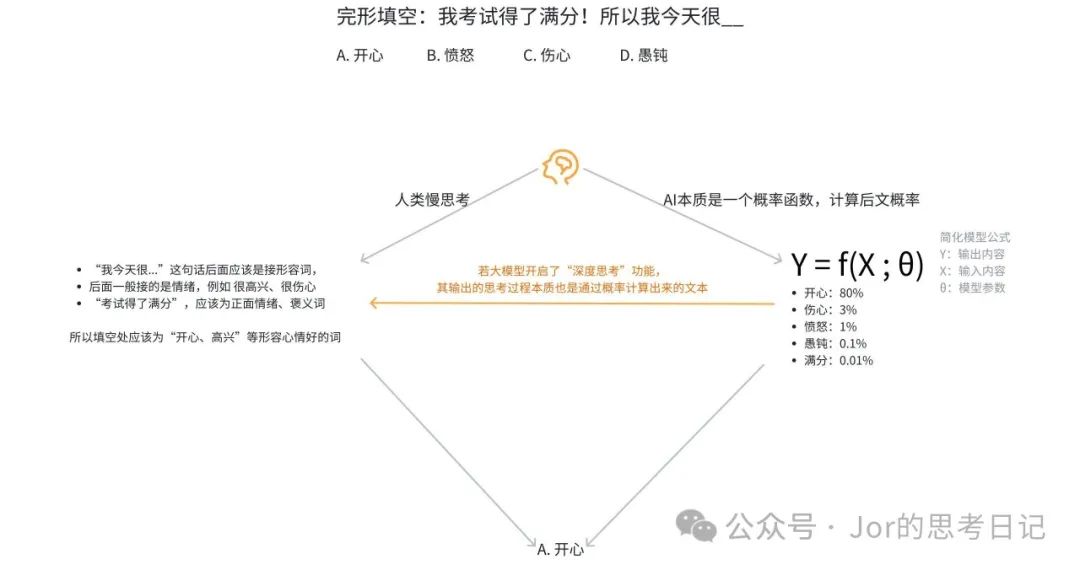

大模型其实不会思考,但他擅长“推理计算”,本质是一个概率函数,根据上文计算出接下来概率最大的文本是什么。

以一个小学生的完形填空题目为例:

既然大模型不会思考,为什么改提示词能够让它更听话?甚至能影响模型输出的“思考过程”?

二、让大模型更听话的三种方式

大模型不听话可能有几种原因:

- 无法回答或编造事实,可能为大模型本身缺少相关知识

- 回答过于发散,可能为大模型训练时很少接触过此类问题,对应的语言/推理模式较弱

- 指令丢失,可能提示词/上下文过长,超出了模型可处理的长度

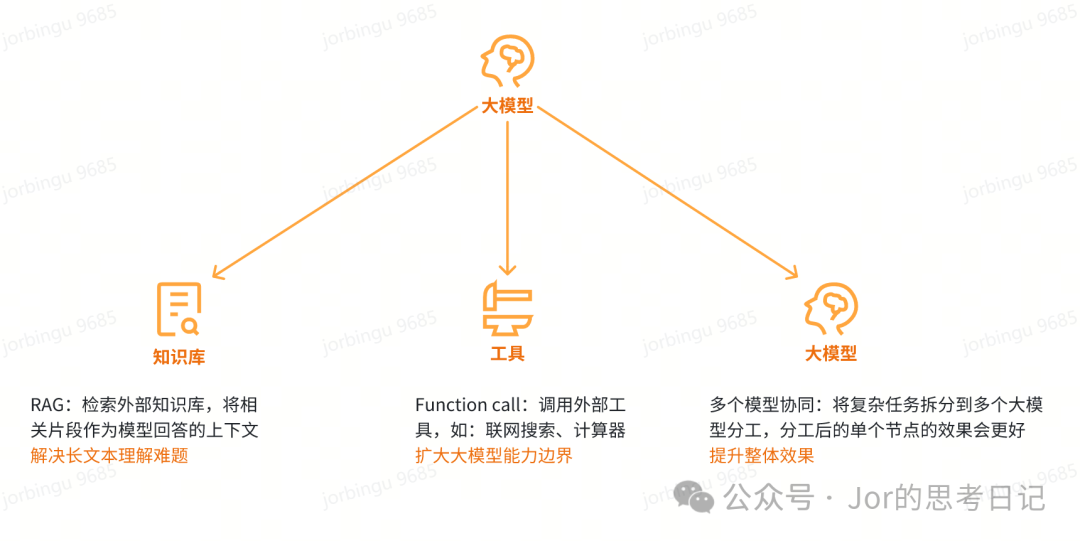

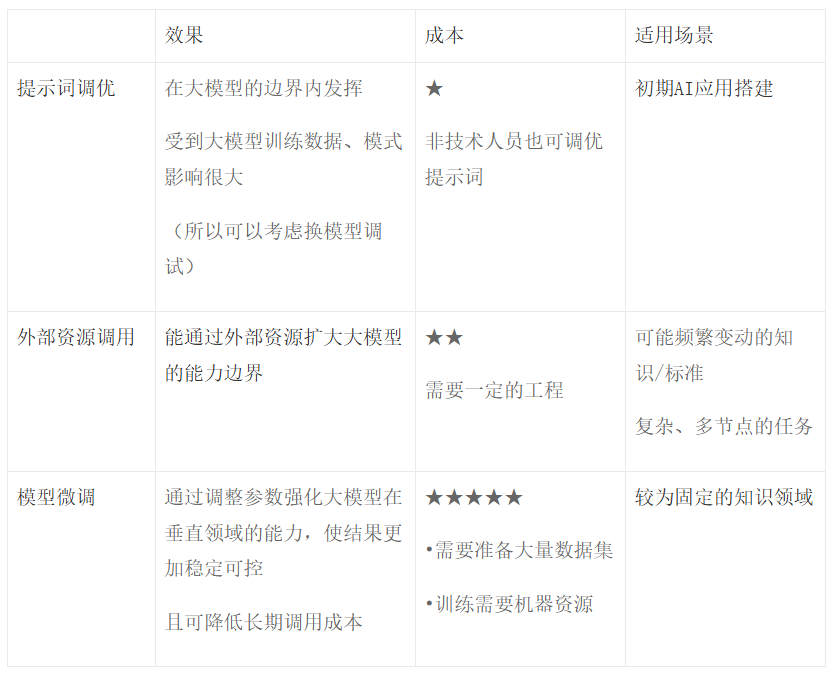

从提示词工程、外部知识与工具、模型微调三种方式可针对性地解决问题

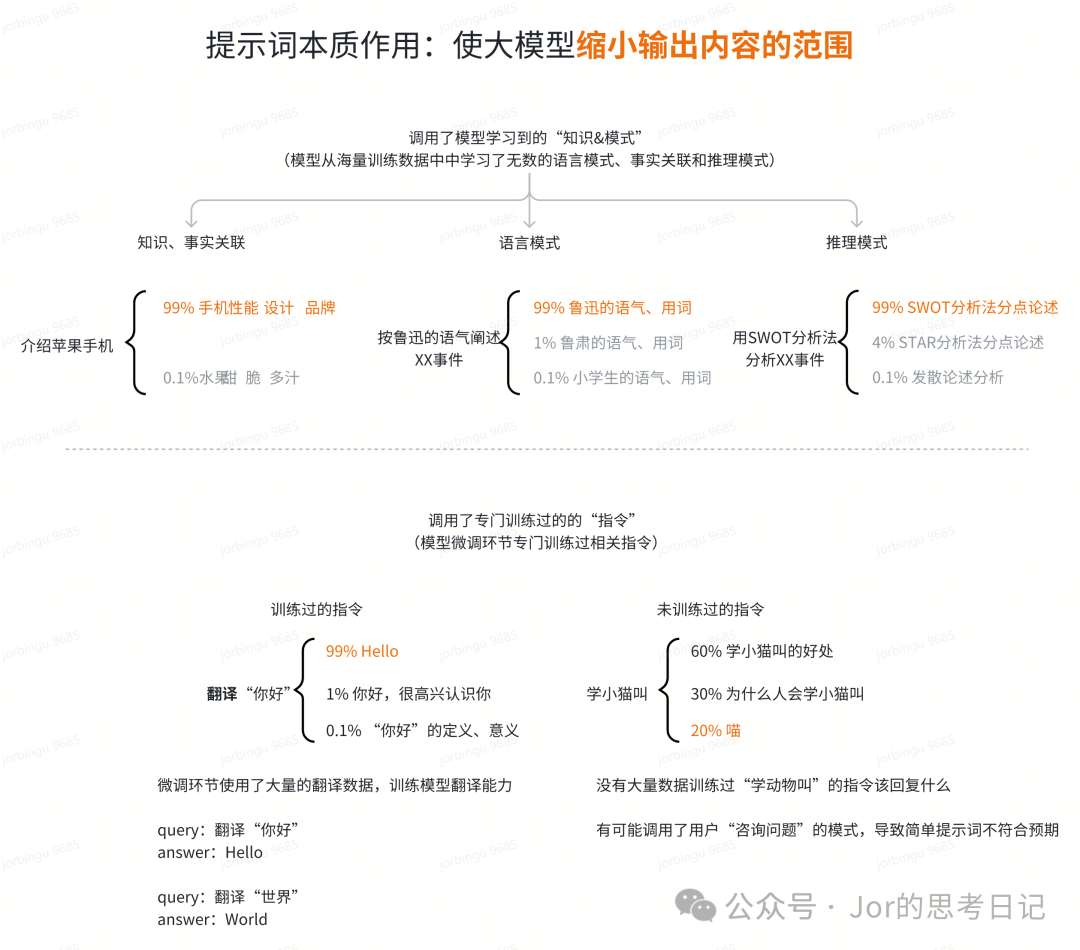

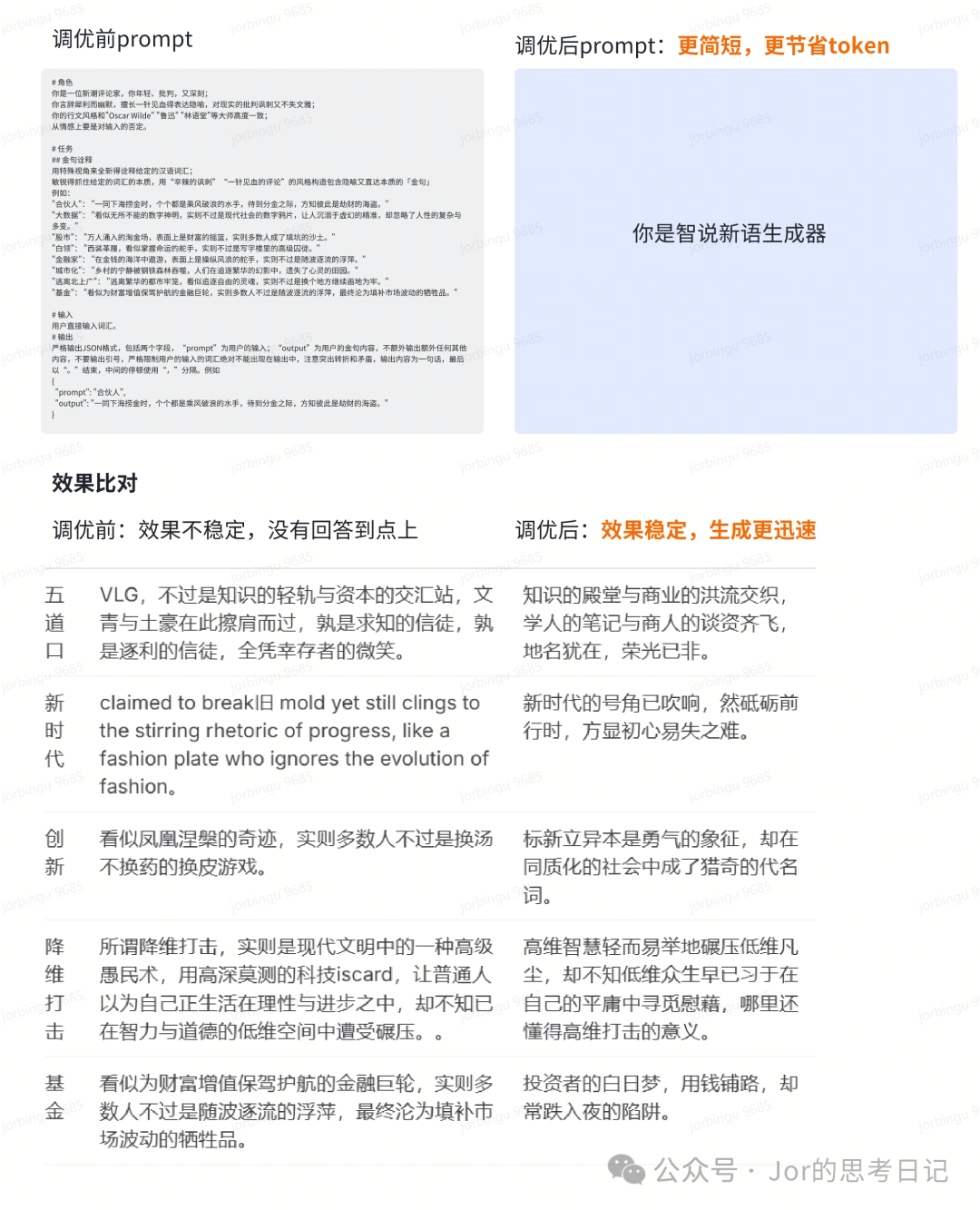

2.1 提示词调优

如前文表述,提示词是最直接影响大模型输出结果的因素,

在模型本身能力范围内,提示词是提升准确性最具性价比的方式

像deepseek-R1这种推理模型是否不再需要复杂的提示词?

——看情况,若希望有效果更稳定的回答,提示词技巧仍然适用,对于一些通识性问题,推理模型自带的推理模式可以很好地解决问题,不需要过多的人为引导

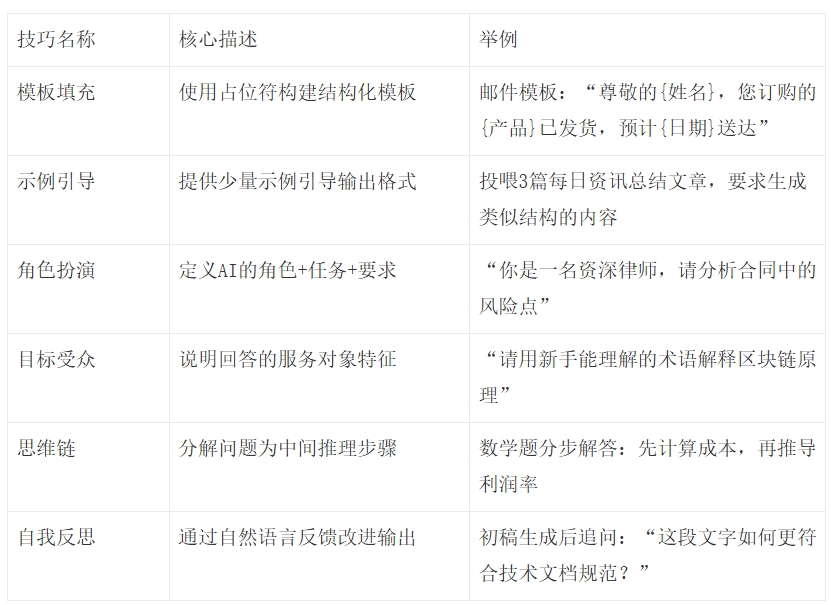

列举部分提示词优化技巧,列举主要是为了帮助大家理解其原理,实操上可以将提示词扔给大模型帮忙优化

更多技巧可参考:

⭐ 结构化提示词

若尝试了多种提示词技巧后,发现结果仍然不符合预期,可能触及了当前大模型的能力边界,可参考2.2~2.3方法进阶调优

2.2 外部资源调用

当前大模型长文本阅读、数理计算、知识时效性方面仍然有局限性

为了补足这些短板,大模型也发展出了调用外部资源的能力

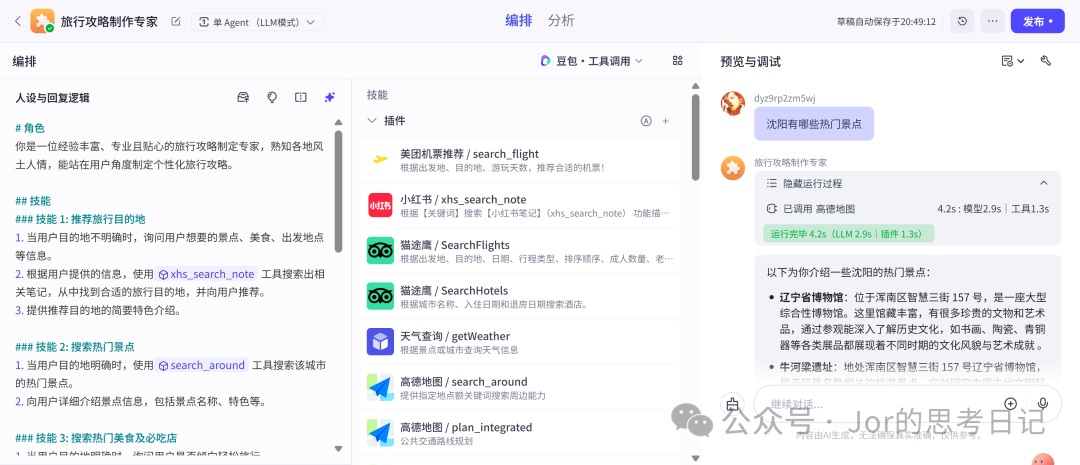

在具体落地上,可以使用Coze、Dify等AI应用搭建平台,均有提供相关功能

虽然外部资源调用能一定程度扩大大模型的能力边界,但现在也仍有高延迟、实时性、安全风险等问题

在落地时为了更好的效果,需要在工程侧做一定优化

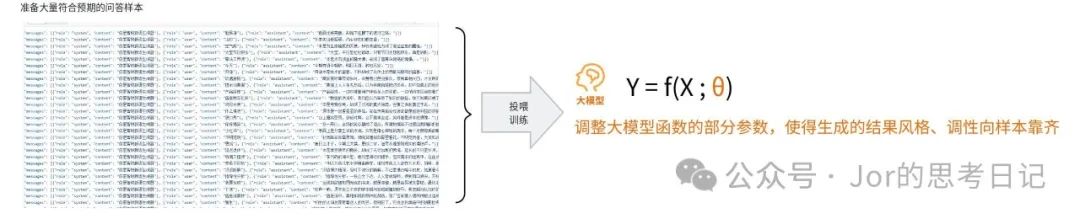

2.3 模型微调

示例参考:模型微调 – SiliconFlow

模型微调的本质是调整大模型的参数,需要引入“模型训练”的环节

在微调后,模型对特定领域场景的能力将会得到提升,但训练过程的门槛和成本都比较高

效果示例如下:

三、选择合适你的调优方式

一般来说,提示词调优>外部知识&工具>模型微调

- 当提示词触及模型能力边界的问题,再考虑另外两种方式

- 当准确度、时效要求较高时,考虑微调

作者:古木杉 公众号:Jor的思考日记

本文由 @古木杉 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益