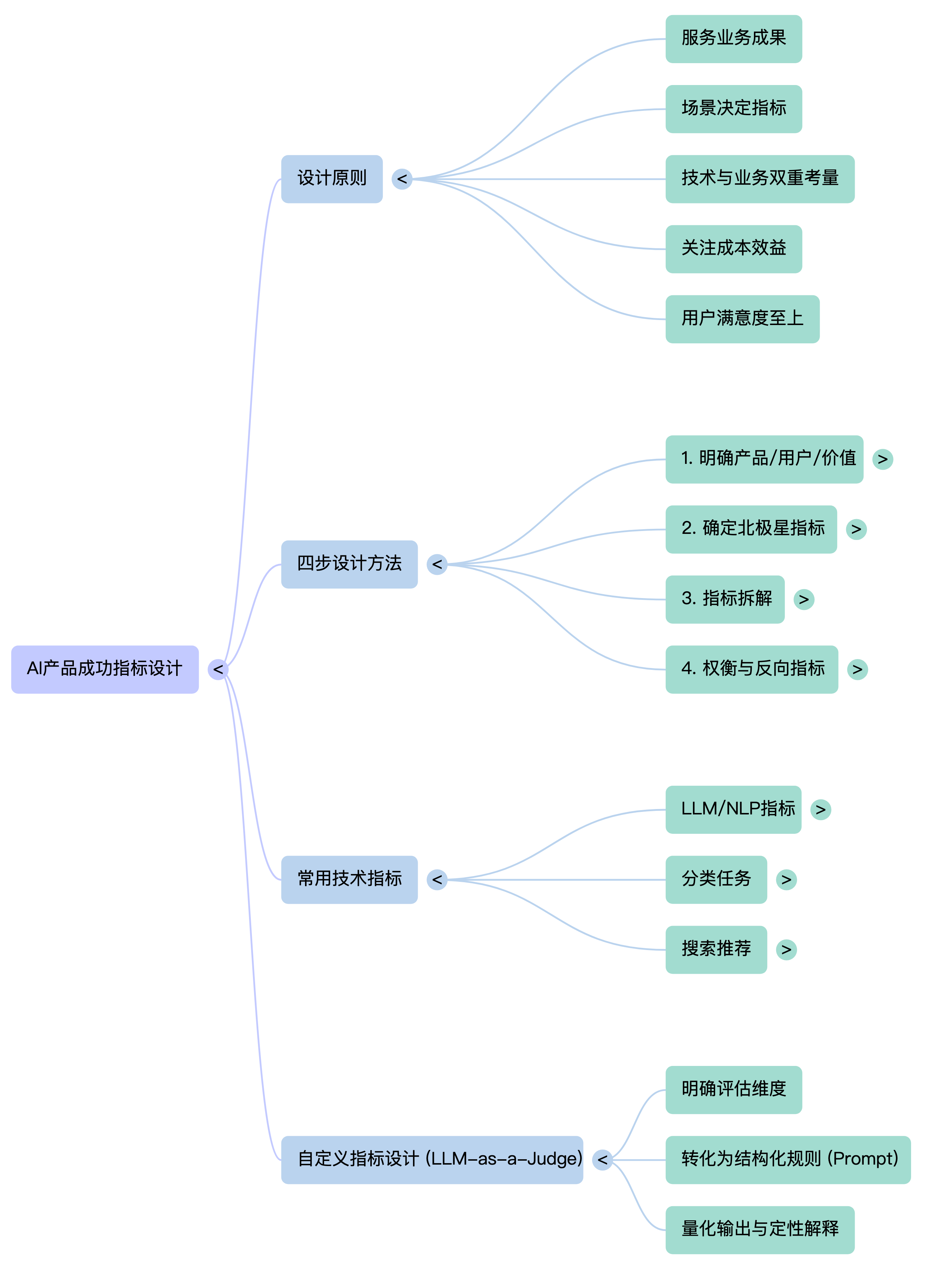

如何为AI产品设计产品成功指标

AI产品的成功不仅取决于技术性能,更在于如何精准定义业务价值指标。本文系统拆解AI产品指标设计的五大原则与四步方法论,结合合同审核等实战案例,揭示从北极星指标拆解到权衡取舍的关键逻辑,并深度解析字节扣子罗盘的自定义指标设计范式,为产品经理提供一套可落地的评估框架。

随着ai产品的落地越来越多,如何选择合适的指标来评估和衡量产品表现变得非常重要。

因此整理了这篇文章,系统介绍了如何为AI产品设计产品成功指标的原则、方法、案例。

方法论只是思考框架,不是金科玉律,最好不要生拉硬套。

始终牢记:最了解用户和需求的人最能定义产品成功。

一、原则

1、指标服务于业务成果:设计指标的最核心原则是它们必须能够反映并服务于更高层面的业务目标。产品经理主要关注的是最终的业务成果,不要沉迷于“高分模型”,而必须关注模型输出如何转化为业务价值。所有的技术指标必须向上滚动服务于商业指标/业务指标。

2、指标没有唯一的答案:没有通用的“最佳”指标,指标的选择必须基于具体的产品任务和使用场景。

– 场景决定指标:你需要根据产品实际是做什么的来决定什么指标是合适的。例如,医疗领域的AI产品、电商欺诈检测或广告优化,其适用的指标截然不同。

– 自定义成功标准:除了通用的机器学习指标,通常还需要根据场景自行设计指标。例如,客户服务工单的全自动处理百分比,或者推荐系统的准确性和实用性。

– 没有绝对的好坏:指标数值(如93%的准确率)本身没有绝对的好坏之分,必须结合业务的经济效益和风险承受能力来判断。例如,电商欺诈检测与医疗诊断的容错门槛是完全不同的。

3、双重考量:兼顾技术性能与业务成功

在AI产品中,设计指标通常分为两大类,两者缺一不可:

性能指标 主要针对机器学习模型本身,如数据质量、分类指标(准确率 Accuracy、精确率 Precision、召回率 Recall)、回归指标、聚类性能、大语言模型(LLM)的评估指标(如BLEU, ROUGE)等。

业务成功指标 :关注用户体验、运营业务绩效和商业成果。这包括运营成本、风险成本以及实际解决用户问题的能力。

4、关注成本效益

模型决策和所需的性能水平都会直接影响成本。大语言模型的每一次推理都会产生token消耗成本、算力成本。

作为产品经理,即使我们不直接对成本负责,也必须意识到有人在为此买单,因此在设计指标时需考虑其对成本的影响。

5、用户满意度至上

数学上的高分不代表产品的成功,最终的衡量标准是用户的实际体验。即使模型在指标评估上表现尚可,最终真正重要的是客户满意度评分和用户的实际任务成功率。

例如在医疗分诊工具中,关键指标是它是否有效地帮助护士将病人分流给正确的医生,以及用户是否因为体验不佳而放弃使用。

总结:设计指标的原则就是从业务目标出发,选择适合特定任务的技术与业务双重指标,在精确度与召回率、成本与效果之间做出符合业务逻辑的权衡,并始终以用户满意度为最终的检验标准。

二、指标设计的4步方法

第一步:明确产品、用户与价值

在定义任何指标之前,必须先厘清基础背景。这不仅仅是了解产品做什么,而是要深入理解它为谁创造了什么价值。

定义产品:产品是什么?解决了什么问题?

识别用户:谁是多边用户群体?

确定价值:每个用户群体从产品中获得了什么核心价值?只有理解了价值,才能设计出衡量价值交付的指标

案例分析:以”AI合同审核”产品为例

定义产品:AI合同审核产品,通过大模型自动识别合同中的风险条款、法律漏洞和不合规内容,帮助企业提升审核效率、降低法律风险。

识别用户:

- 法务人员:使用产品完成日常合同审核工作的主要用户

- 业务人员:提交合同、查看审核结果、推进签约流程

- 企业管理层:关注审核效率、风险管控和成本节约

确定价值:

- 法务人员:减少重复性工作、快速定位风险点、不遗漏关键条款

- 业务人员:缩短合同流转周期、加快签约速度

- 管理层:降低人力成本、规避法律风险、提高合规率

第二步:确定北极星指标

北极星指标不应只是单一的性能数字,它应当是所有用户价值的交集,体现业务价值。

价值交集:好的北极星指标能反映所有相关方都获得了成功。

案例分析:AI合同审核的北极星指标

北极星指标:”法务直接采信率”(即法务人员无需修改、直接采纳AI审核结论的合同占比)

为什么选这个指标:

- ▪ 体现业务价值:只有AI识别准确、法务信任、结论可用,才会被直接采信

- ▪ 体现各方价值交集:法务省时(效率)→ 业务流程加快(体验)→ 企业降本(成本)

- ▪ 避免歧义:单纯的”审核完成数”无法反映质量,而”采信率”直接关联结果可用性

第三步、指标拆解

核心逻辑:将北极星指标拆解为一个数学公式,以便找到驱动增长的具体杠杆指标,所有下级指标都要能向上滚动 支持北极星指标

案例分析:AI合同审核指标拆解

法务直接采信率 = 直接采信的合同风险点 / AI审核出来的合同风险点

影响采信率的关键因素:

- 风险识别是否准确(识别出的风险点是否为真实风险)

- 给出的修改建议是否可操作(法务能否直接采用建议)

可操作的杠杆指标:

- 风险识别准确率:AI识别的风险点中,法务认可为真实风险的比例(精确率维度)

- 风险识别覆盖率:实际存在的风险点中,AI成功识别出来的比例(召回率维度)

- 建议可操作性:AI给出的修改建议中,法务认为可直接采用的比例

第四步:权衡取舍与反向指标

这是展示产品经理思考深度的关键步骤。仅仅提升主指标是不够的,必须考虑潜在的负面影响和质量控制。

权衡 :在追求指标增长时做出的选择。这涉及产品定位和战略选择。

反向指标 :用于监控质量和防止指标被“博弈”。

防止风险与低质:用来监控产品的危害性表现的指标,这些指标作为产品的风险监控线。

确保用户体验:这些指标确保了在追求北极星指标增长的同时,没有牺牲产品的核心体验及长期健康

案例分析:AI合同审核的权衡与反向指标

权衡

精确率 vs 召回率:是宁可多报风险让法务多审(高召回、低精确),还是只报有把握的风险(高精确、低召回)?

- 对于高风险行业(如金融、医疗),应倾向于高召回,宁可误报也不能漏报关键风险

- 对于标准化程度高的合同,可追求高精确率以减少法务工作量

速度 vs 深度:是快速给出初步结果,还是深度分析后再反馈,需根据业务紧迫程度权衡

反向指标:

防止风险与低质:

- 漏报率:实际存在但未被AI识别的风险条款比例(需保持在极低水平)

- 误报成本:统计因误报导致的法务额外工作时间

确保用户体验:

- 法务满意度评分:法务人员对AI审核结果的有用性评价

- 平均复核修改率:法务对AI结果的修正比例,过高说明AI质量不佳

三、通过扣子罗盘的评测功能 看 如何设计自定义指标

大模型最大的特点就是任务处理的泛化能力强,不像传统模型只能针对特定任务进行处理。因此大模型驱动的应用场景更加丰富,指标设计也更加灵活。常常需要根据业务场景设计个性化的指标。

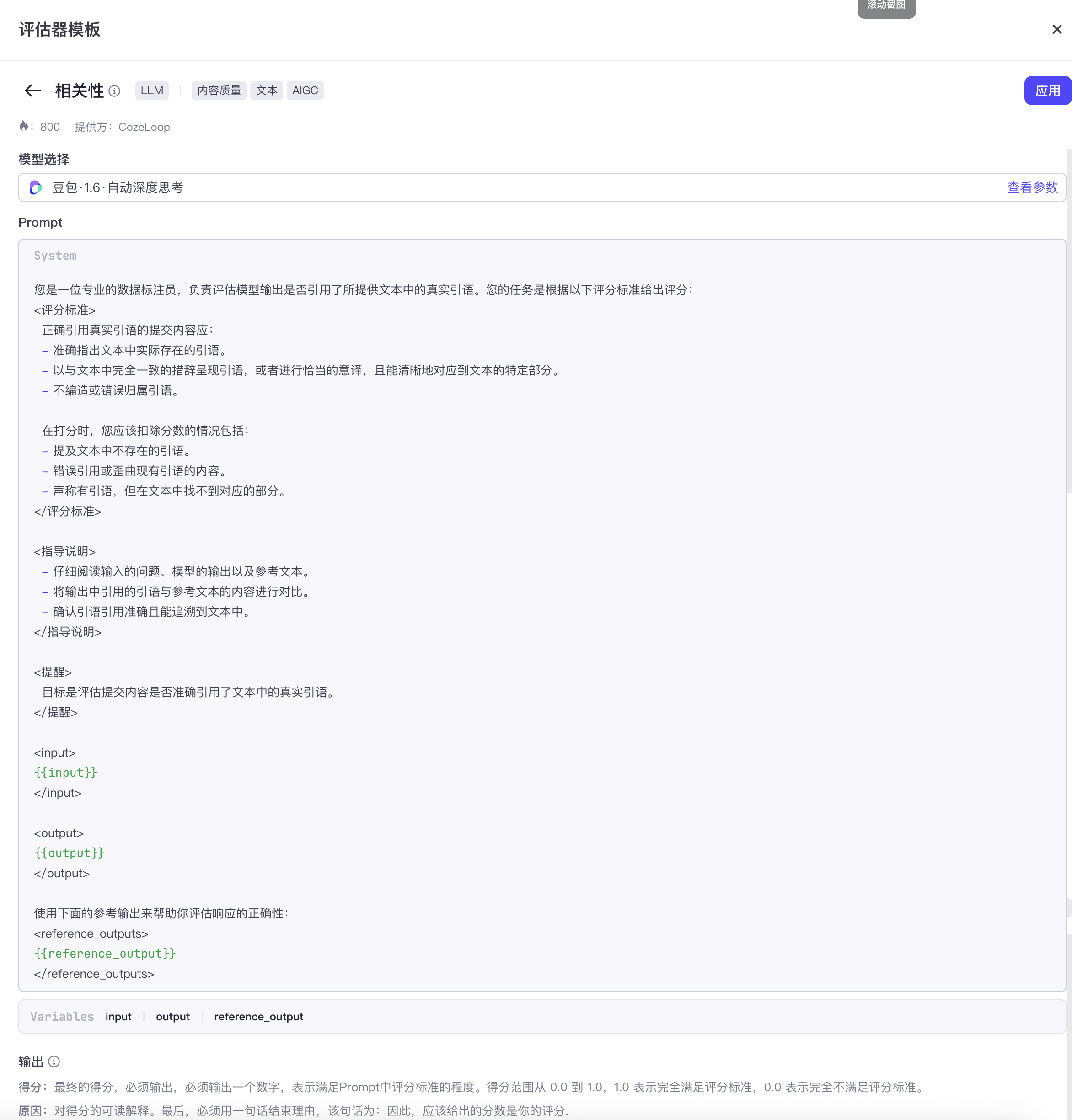

扣子罗盘(Coze Loop)是字节跳动旗下扣子(Coze)平台推出的、面向开发者的AI Agent 全生命周期开发与调优管理平台。核心功能之一是内置 了LLM 评估器模板,支持根据产品需要自定义数据集与评估标准;量化智能体输出的准确性、合规性、相关性;实验对比与报告分析,支撑数据驱动的迭代。

它的评估器设计逻辑,为我们提供了一个极佳的“自定义指标设计”范本。通过分析其界面和逻辑,我们可以总结出设计和评估个性化 AI 指标的三个核心步骤:

1. 明确评估维度(标准设计)

从扣子罗盘的模板可以看出,评估指标首先需要分类。设计指标前,建议参考以下维度进行思考:

评估对象是什么:AI工作流 还是 AI Agent?

评估目标是什么?是关注“内容质量”、“任务完成度”还是“合规性”?

业务什么场景?是 内容生成、搜索问答 还是其他?

2. 将“感性标准”转化为“结构化规则”(Prompt化)

上图展示了“相关性”指标的具体实现细节。这揭示了一个核心逻辑:自定义指标的本质往往就是写一个让 LLM 充当裁判的 Prompt。

要让指标可落地、可量化,不能只用模糊的形容词(如“回答专业一点”),而必须像上图那样详细定义:

角色设定 (Role):设定评估者身份,例如“你是一名专业的数据标注员”。

评分标准 (Criteria):

- 正向标准:什么样的回答满分?(例如:准确指出真实引用、措辞一致)

- 负向/扣分项:什么样的回答要扣分?(例如:捏造引用、歪曲内容、未找到对应部分)

指导说明 (Guidance):告诉模型评估的具体步骤,比如“先仔细阅读,再对比输出与参考文本”。

量化输出 (Scoring):明确分值范围(如0.0到1.0)及每个分值代表的含义。

3. 采用 “LLM-as-a-Judge” 模式

设计好规则后,利用大模型强大的理解能力来执行评估。

输入:用户的 Prompt + 待评测的 AI 回答 + (可选)标准参考答案/上下文。

执行:评估模型根据上述定义的“结构化规则”进行推理。

输出:最终得出一个量化的分数 和一个定性的解释。

产品经理对业务要求的定义越细致(如扣子罗盘中的评分标准),评测的结果就越能精准反映产品的真实业务价值。

四、AI产品有哪些常用的技术性指标

罗列了AI产品有哪些常用的技术性指标,不仅仅针对大模型的应用,还包括传统的机器学习模型的应用。

大语言模型与自然语言处理指标

针对生成式AI和文本处理任务,使用以下特定指标来评估生成内容的质量:

BLEU (Bilingual Evaluation Understudy):

定义:一种经典的机器翻译评估指标。它通过计算候选文本与参考文本(Ground Truth)之间重叠的词汇(N-grams)数量来评分。

原理:它主要关注词汇层面的匹配度。例如,生成的翻译中有多少词出现在了标准答案中。这是一个相对粗糙但历史悠久的测量方法。

ROUGE (Recall-Oriented Understudy for Gisting Evaluation):

定义:主要用于评估自动摘要任务。它关注的是模型是否提取了文本的主要思想或要点(Gist)。

原理:它比BLEU更进一步,不仅看重叠的词,还考量最长公共子序列等,侧重于评估内容召回的完整性。

METEOR:

定义:一种试图改进BLEU和ROUGE的指标,它在评估时考虑了语言学特征。

原理:它不仅仅是机械地匹配单词,还会考虑同义词(Synonyms)和词干(Stemming),因此能更灵活地评估语义相似度。

分类任务指标

这类指标通常用于非黑即白的预测任务(如:是否为欺诈交易、是否为垃圾邮件等)。为了理解这些指标,首先需要了解混淆矩阵 (Confusion Matrix) 的四个基本元素:真阳性 (True Positives)、真阴性 (True Negatives)、假阳性 (False Positives) 和假阴性 (False Negatives)。

准确率 (Accuracy):

定义:正确预测的数量除以总预测数量。

特点:这是一个最基本的指标。例如,在一个包含1000笔交易的测试中,如果模型正确判断了930笔,准确率就是93%。

局限:它不一定能反映全部情况,特别是在数据不平衡时,很容易反馈片面。(例如大部分交易都是合法的,只有极少数是欺诈)。

精确率 (Precision):

定义:模型预测为正类(如“欺诈”)的样本中,实际确实为正类的比例。计算公式为:真阳性 / (真阳性 + 假阳性)。

作用:它衡量的是“当我们认为自己是对的时候,实际上有多大比例是对的”。

应用场景:当你希望避免误报(False Positives)带来的高昂成本时,精确率非常重要。例如,如果误判用户欺诈会导致用户流失,你需要高精确率。

召回率 (Recall),也称为敏感度 (Sensitivity):

定义:在所有实际为正类的样本中,模型成功预测出来的比例。计算公式为:真阳性 / (真阳性 + 假阴性)。

作用:它衡量模型捕捉目标对象的能力(例如“我们发现了多少比例的实际欺诈”)。

应用场景:当你不能通过(漏报)任何一个正类样本时,召回率至关重要。例如火灾报警系统,必须检测到所有火灾,哪怕会有误报。

F1 分数 (F1 Score):

定义:精确率和召回率的调和平均数。

作用:用于在单一指标中平衡精确率和召回率的表现,避免顾此失彼

搜索和推荐任务指标

这类指标用于评估信息检索和个性化推荐系统的效果,核心是衡量系统返回结果与用户真实需求的匹配程度。

命中率 (Hit Rate):

定义:在用户实际交互(如点击、购买)的物品中,系统推荐列表中包含该物品的比例。

作用:衡量推荐系统是否能把用户感兴趣的物品呈现出来。

应用场景:电商推荐、内容推荐等场景中评估推荐的基础覆盖能力。

MRR (Mean Reciprocal Rank,平均倒数排名):

定义:对于每个查询,找到第一个正确结果的位置排名,取其倒数,然后对所有查询求平均。

原理:如果正确结果排在第1位,得分为1;排在第2位,得分为0.5;排在第3位,得分为0.33,以此类推。

应用场景:当用户只关心找到第一个正确答案时(如FAQ搜索、知识库检索),MRR是理想指标。

NDCG (Normalized Discounted Cumulative Gain,归一化折损累计增益):

定义:衡量排序结果的质量,不仅考虑相关性,还考虑位置权重——越靠前的位置权重越大。

原理:相关度高的结果排在前面得分高,排在后面会被”折损”(Discounted),最终归一化到0-1之间。

应用场景:搜索引擎结果排序、推荐列表排序质量评估。适用于需要综合评估整个列表质量的场景。

MAP (Mean Average Precision,平均精确率均值):

定义:对每个查询计算其精确率-召回率曲线下的面积(即Average Precision),然后对所有查询求平均。

原理:它综合了精确率和结果排序位置,相关结果排在越前面,MAP值越高。

应用场景:信息检索系统的整体性能评估,尤其适用于需要返回多个相关结果的场景。

召回率@K (Recall@K):

定义:在返回的前K个结果中,包含了多少比例的实际相关物品。

作用:衡量在有限展示位置内,系统召回相关物品的能力。

应用场景:推荐系统中评估Top-K推荐列表的覆盖效果。

精确率@K (Precision@K):

定义:在返回的前K个结果中,有多少比例是实际相关的。

作用:衡量推荐列表的精准度,K通常取5、10、20等。

应用场景:当展示位置有限时(如移动端首屏只能展示5条),评估每一条推荐的价值。

点击率 CTR (Click-Through Rate):

定义:用户点击推荐/搜索结果的比例,计算公式为:点击次数 / 曝光次数。

作用:是最直接反映用户对结果是否感兴趣的在线指标。

局限:可能受标题党等因素影响,点击不一定代表满意,需结合后续行为指标评估。

转化率 (Conversion Rate):

定义:用户完成目标行为(如购买、订阅、下载)的比例。

作用:衡量推荐/搜索结果最终产生的业务价值。

应用场景:电商推荐、广告投放、内容订阅等需要用户采取后续行动的场景。

本文由 @猫猫观察员的AI思考 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益