从“贾维斯”到“宕机龙虾”:我的OpenClaw云端奇幻漂流记

OpenClaw的开源AI助手项目以其强大的执行力和隐私安全性迅速走红,但在实际云端部署中却暴露了高成本、配置复杂和稳定性问题。本文将分享48小时深度体验中的惊艳与挫败,揭示当前AI代理从概念走向实用的核心矛盾,并提供实用的避坑指南。

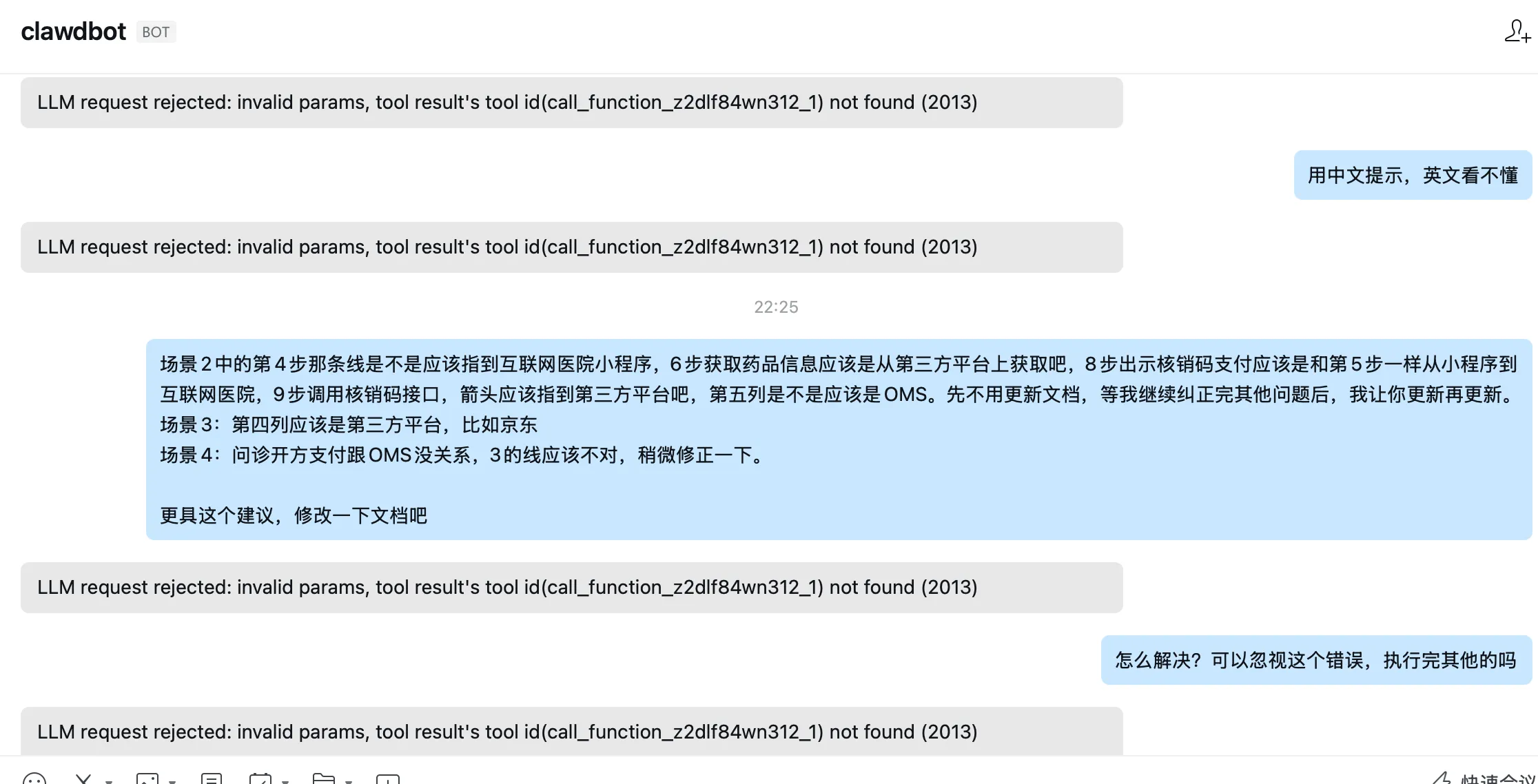

深夜,手机屏幕的微光映照着我疲惫的脸。企业微信里,我那位刚刚还“文思如泉涌”、半天就帮我搞定一份系统PRD的AI助理“龙虾”(OpenClaw),此刻只留下一行冰冷的错误代码:

“LLM request rejected: invalid params, tool result’s tool id(call_function_z2dlf84wn312_1) not found (2013)”。

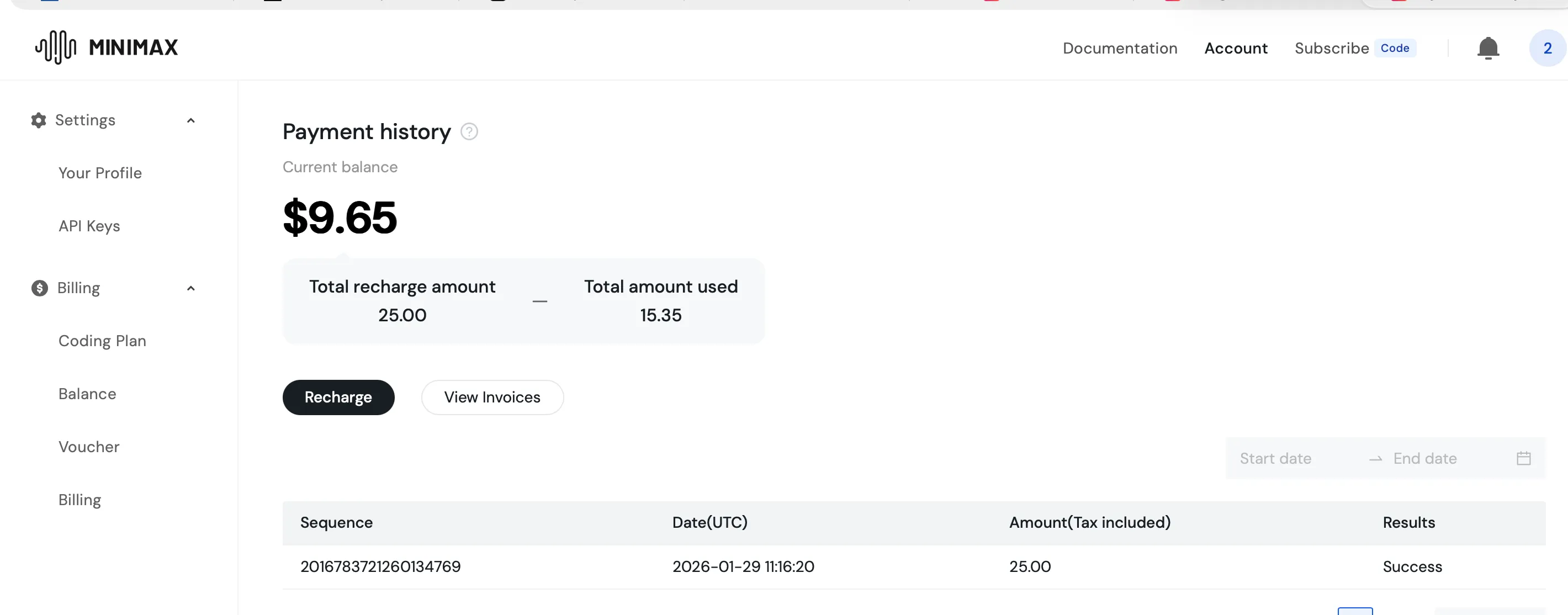

而MiniMax控制台的账单提醒,则默默记录着它今天“思考”所消耗的价值一百多元的Token。这,就是我与这只风靡全球的“太空龙虾”在腾讯云上共度48小时的真实写照——一场交织着惊艳、便利、困惑与账单惊吓的奇幻漂流。

一、初体验:当“贾维斯”真的能听懂人话

近日,备受关注的开源个人AI助手项目完成第三次更名,从最初的Clawd,到短暂的OpenClaw,再到如今的OpenClaw。项目官方宣布:”龙虾终于蜕变为最终形态”,标志着这个病毒式传播的AI代理平台进入稳定发展阶段。

至1月31日,该项目在代码托管平台GitHub上的星标数量已超过12万个,官网累计访问量突破200万人次,成为近期增长最快的开源技术项目之一。

不论是之前的豆包智能手机还是OpenClaw,都预示着,人类已经不满足AI大模型为我们提供创意和解决方案,而是真正变成生产力工具,不仅要替代脑袋,而是要直接替换双手,就像OpenClaw标志性的两个大钳子一样。

既然这么火,当然想体验一把,但为了它去买个mac mini对于家里已经电脑没地方放的我,总是代价太大!恰逢此时,腾讯云推出了便捷的云端部署方案,无需复杂搭建即可快速购买并体验,这让原本停留在想法层面的应用落地变得轻松可行。于是,便顺势借助这一方案开启了部署尝试,让需求与工具在合适的时机完成了对接。在腾讯云Lighthouse上选择”OpenClaw”应用模板,整个过程比想象中顺畅。一键部署后,通过 clawdbot onboard 命令进行简单配置,绑定企业微信,我的私人AI员工就正式”入职”了。

稍微遗憾的是,当我购买完腾讯云的服务后,阿里,火山也纷纷推出了OpenClaw的云服务,而且功能更强大,价格更便宜,希望后面他们能够也卷起来,让我们使用AI的成本越来越低!

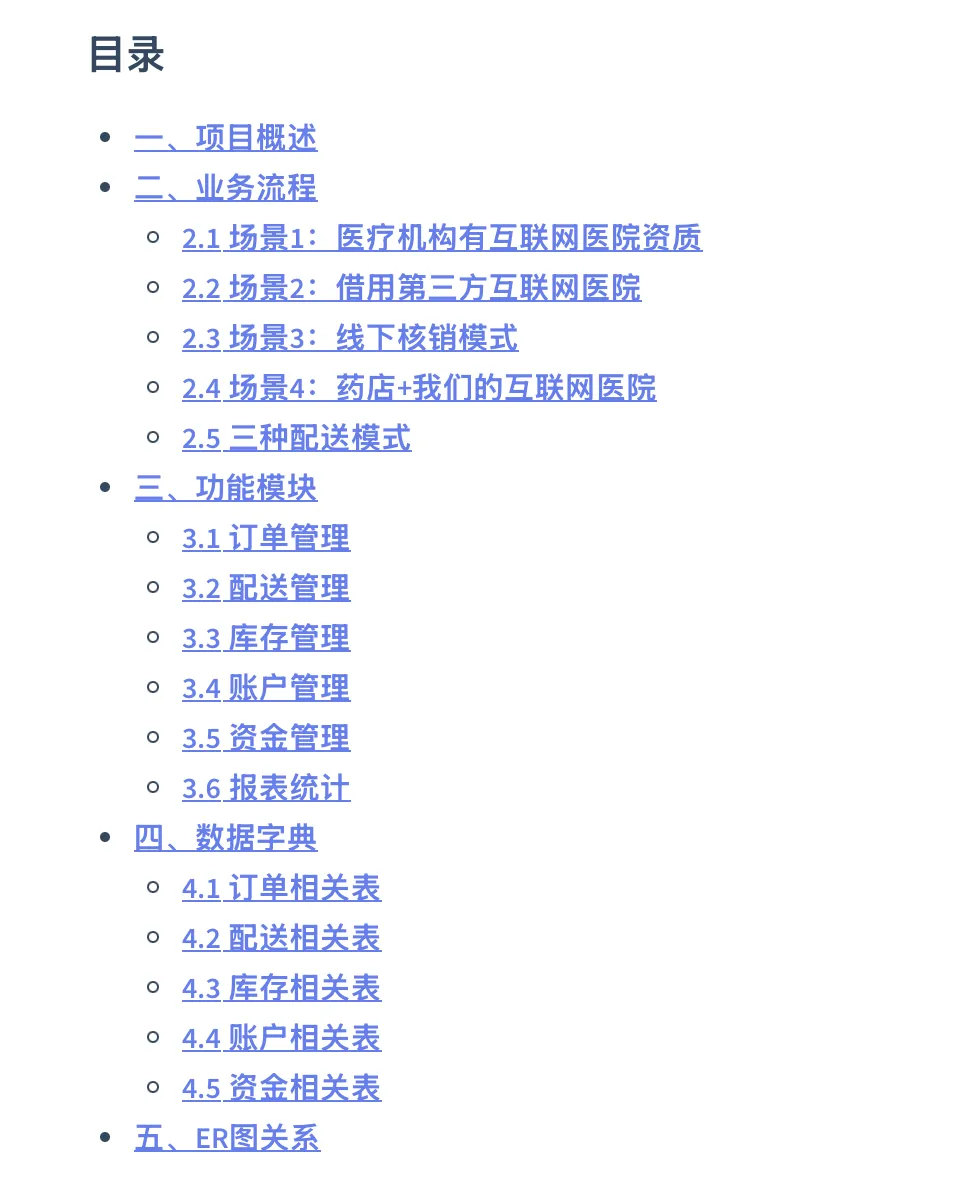

真正的魔法,发生在最平凡的日常里。 开车送娃上学的路上,我用语音在企业微信里发出指令:“帮我起草一份OMS系统的产品需求文档,要包含业务流程、核心功能和数据库设计。”不到半天,一份结构清晰、要点完整的PRD已经生成好了,为了方便我和团队其他伙伴分享阅读,又让它生成了网页版本。

更让我惊讶的是它的“主动性”——在生成PRD的同时,它已经“急不可耐”地开始询问技术栈偏好,试图直接为我生成代码框架。(正如它的作者钟情编程一样)这种从“对话”到“行动”的无缝衔接,让我第一次感受到Agentic AI(代理型AI)的颠覆性:它不再是被动应答的顾问,而是拥有“手和脚”、能推进任务的数字同事。

这种通过最熟悉的聊天软件(如企业微信、飞书)进行自然交互的方式,极大地降低了使用门槛,让我能在碎片化时间中高效调度它。正如许多体验者所言,OpenClaw的核心魅力在于”本地优先”带来的隐私安全感与”真正执行力”的结合。

二、现实骨感:高墙内的“全能助理”与燃烧的账单

然而,惊艳过后,现实的”骨感”很快显现。我的体验集中暴露了当前OpenClaw,尤其是云端部署模式下的三大核心矛盾。

首先,是上手成本与“全能”愿景的落差。 尽管云服务商提供了一键部署模板,极大简化了初期搭建,但后续的模型配置、通道绑定、尤其是技能(Skills)调优,依然需要一定的技术背景。例如,配置国内模型如MiniMax时,必须严格区分其国内版( .com )与海外版( .io )的API地址,否则就会遭遇“401 token is unusable”的顽固错误。对于非技术背景的用户,想将它打造成真正的“个人全能助理”,仍有不短的距离。

其次,是设计初衷与部署环境的错位。 OpenClaw的设计哲学是”本地优先”,意在成为你个人电脑上如影随形的助手,能直接整理本地文档、操作熟悉的应用。但出于安全考虑(它拥有很高的系统权限),许多人选择将其部署在云端服务器。这固然避免了”sudo rm -rf /”误操作本机文件的噩梦,但也让它与我的日常工作环境(电脑中的文件、本地软件)隔离开来,许多预设的便利性大打折扣,仿佛给”贾维斯”戴上了镣铐。

最后,也是最刺痛的一点:高昂且不可控的推理成本。 “没怎么用,一天就100多元没有了。”——这绝非个例。OpenClaw的强大源于其连接的大型语言模型(LLM),而像Claude Opus这类顶级模型的API调用费用极其昂贵。当Agent进入复杂的”思考-执行”循环,特别是遇到需要反复尝试的任务时,Token的消耗会如开闸洪水般飙升。这不再是”一杯奶茶钱”的云服务器成本,而是持续燃烧的”脑细胞”燃料费,让个人用户的使用变得心惊胆战。

三、深夜宕机:当“工具调用ID”成为阿喀琉斯之踵

而文章开头那个导致一切“歇菜”的错误,则揭示了更深层的技术挑战。 LLM request rejected: invalid params, tool result’s tool id… not found (2013) ,这个错误直指Moltbot作为多轮交互智能体的核心机制——工具调用(Tool Calling)的异步状态管理。

简单来说,当OpenClaw(大脑)决定调用一个工具(比如让浏览器技能去搜索资料)时,会生成一个唯一的”工单号”(tool_call_id)。工具执行完毕后,必须带着这个正确的”工单号”回来复命,大脑才能将结果对接到正确的对话线程中。我遇到的这个错误,意味着复命者找不到当初派发的那个”工单”了。这通常源于对话历史管理异常、模型切换导致ID格式不兼容,或在复杂多步任务中状态丢失。

这个看似晦涩的错误,恰恰是AI智能体从演示走向稳定生产过程中必须跨越的鸿沟。它关乎可靠性。当你的数字员工开始“失忆”、无法衔接上下文时,其信任基石便动摇了。这也解释了为何许多资深玩家建议,对于重要或长周期任务,初期应在沙盒环境或专用VPS中进行充分测试,而非直接用于关键工作流。

四、给后来者的避坑指南与理性期待

结合我的踩坑经历与社区智慧,对于想尝试云端Moltbot的朋友,我有如下建议:

- 明确需求,成本先行:不要被“全能”宣传迷惑。先想清楚你最需要自动化的1-2个场景(如邮件摘要、信息监控)。优先选择按量付费或提供免费额度的国内模型API(如DeepSeek、通义千问),并在配置中设定用量警报,严防“账单惊吓”。

- 谨慎授权,沙盒测试:在配置技能和权限时,遵循最小权限原则。初期不要授予完整的文件系统访问权。可以利用Docker容器或单独的服务器用户进行沙盒隔离,即使Agent“幻觉”或出错,也能将影响控制在有限范围。

- 攻克配置,耐心调试:针对国内用户,模型配置是第一道坎。牢记:国内平台申请的API Key配国内版地址(如 api.minimaxi.com ),海外平台Key配海外版地址(如 api.minimaxi.io )。遇到连接问题,首先检查此处。对于“tool id not found”类错误,尝试简化初始任务,确保对话历史清晰,或查阅日志进行排查。

- 调整预期,拥抱进化:目前的Moltbot,更像一个潜力巨大但需精心调教的“实习生”,而非即插即用的完美管家。它的价值在于自定义和扩展性,你可以通过社区技能市场(ClaudHub)为其赋能,甚至教会它学习新技能。这是一个共同成长的过程。

结语:未来已来,但请系好安全带

我的48小时Moltbot奇幻漂流,是一场浓缩的体验:它让我真切触摸到了“数字员工”的便捷与强大,也让我深刻体会到前沿技术落地过程中的成本、复杂性与不确定性。

这只“龙虾”的爆火,绝非炒作。它标志着AI正在从“问答机”蜕变为“执行者”,从云端走向个人可控的终端。然而,通往“一人独角兽公司”的愿景之路,仍需要跨越易用性、成本控制和运行稳定性等多重障碍。

对于每一位跃跃欲试的探索者,我的建议是:带着明确的问题和审慎的预算上路,享受它带来的生产力飞跃,但也要准备好亲手调试和为其“思考”付费。未来已来,但请系好安全带,它可能是一段颠簸但值得的旅程。

本文由人人都是产品经理作者【菜根老谭】,微信公众号:【菜根老谭】,原创/授权 发布于人人都是产品经理,未经许可,禁止转载。

题图来自作者提供

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益