AI真的能理解人的情绪吗?这家刚融资5000万美金的公司尝试给出答案!

如果 AI 能理解和处理人类情感会发生什么?这一主题是科幻作品中的常客,比如《银翼杀手》和《她》等。如何让 AI 兼具情感和智能,也是 AI 领域内的热门话题。近期,一家初创公司 Hume AI 推出了可以理解人类情感的语言大模型。

Sense 思考:

我们尝试基于文章内容,提出更多发散性的推演和深思,欢迎交流。

- Hume AI 的 EVI 产品展示了情感计算领域的新方向,其创始人推出的语义空间理论为 EVI 提供了坚实的理论基础。使得大模型不仅能够理解用户的情绪,还能在对话中以类似人类的方式做出反应,这一点可能会彻底改变人机互动模式。

- 尽管 Hume AI 的使命是“优化 AI 以提高人类的幸福感”,但引入情感智能到 AI 中也可能带来很多人对社会和伦理问题的思考。机器能够理解和模仿人类情感的范围有多大?人们是否会开始更多地依赖与 AI 的情感互动,从而影响人际关系?

AI Native 产品分析——Hume AI

1. 产品上线时间:2024 年 3 月

2. 创始人:Alan Cowen

- 前 Google 研究员和科学家,Google AI 情感计算研究团队创始成员之一,语义空间理论提出者

- 语义空间理论:基于数学的情感理论,将情感视为复杂、多维空间的维度

3. 产品简介:

Hume AI 推出了 EVI(Empathic Voice Interface)共情语音接口,搭载了强大的语言模型技术,可以对文本、音频和视频进行情感分析,旨在将情感理解融入聊天机器人的互动中。

4.官网:https://www.hume.ai/

产品体验:https://demo.hume.ai/

飞速发展的人工智能时代,我们见证了 AI 在客户服务、自动驾驶、医疗、企业服务等领域的广泛应用。除了应用 AI 的智能,让 AI 可以理解和处理人类情感这一复杂挑战也让众多科学家和创业者投入其中。

近期,一家名为 Hume AI 的初创公司推出共情语音接口 EVI(Empathic Voice Interface),可以让开发人员通过几行代码将情感智能人工智能语音集成到各类应用场景。与此同时,Hume AI 完成了 5000 万美金的 B 轮融资。投资方包括 EQT Ventures、 Comcast Ventures、LG Technology Ventures 等知名投资机构。

一、让 AI 表达更像人类的 EVI

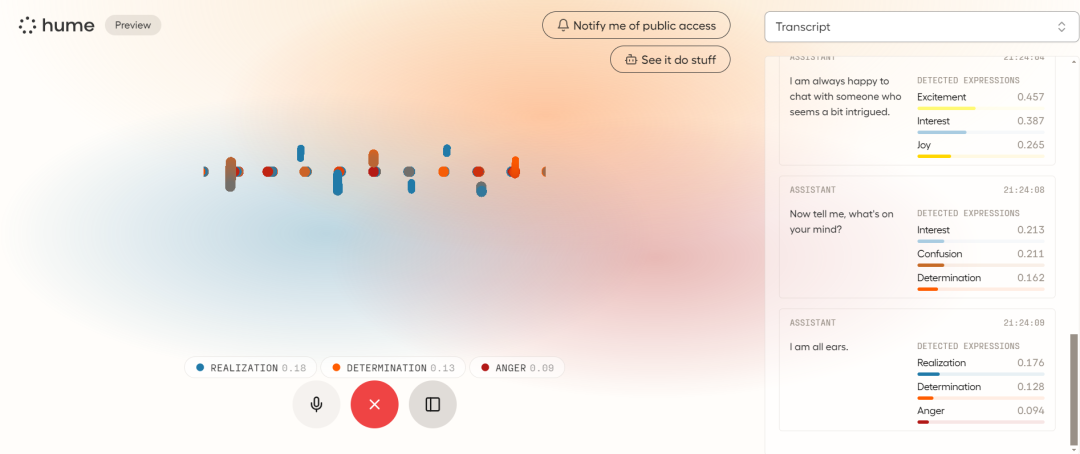

EVI 代表 Empathic Voice Interface(共情语音界面),与其他主要通过文本形式进行交互的多模态大模型不同,EVI 的特殊点在于能够通过倾听人们的声音了解他们的感受,同时使用符合这一感受的话语进行回应。

为了让与 AI 的语音交流更加自然,业内正致力于加入能表达情感或自然停顿的语句。OpenAI 通过 ChatGPT-Voice 实现了这一点。而像 Figure 01 机器人甚至偶尔会说“嗯”和“呃”。

Hume AI 的目标是实现真实情感的整合,使机器人能够感知并以一种反映或对抗对话中人类情绪的方式来回应。EVI 能够理解用户的语调,这为每一个词汇增添了更深的含义,并利用这一点来指导其语言和发音。

EVI 拥有若干独特的共情功能:

- 基于用户的表情用类似人类的语调进行回应

- 用符合用户需求的语言来增加满意度

- EVI 知道何时说话,可以判断用户合适结束对话

- 在被打断时会停止,但能从中断处继续

- 通过应用用户的反应来自我改进

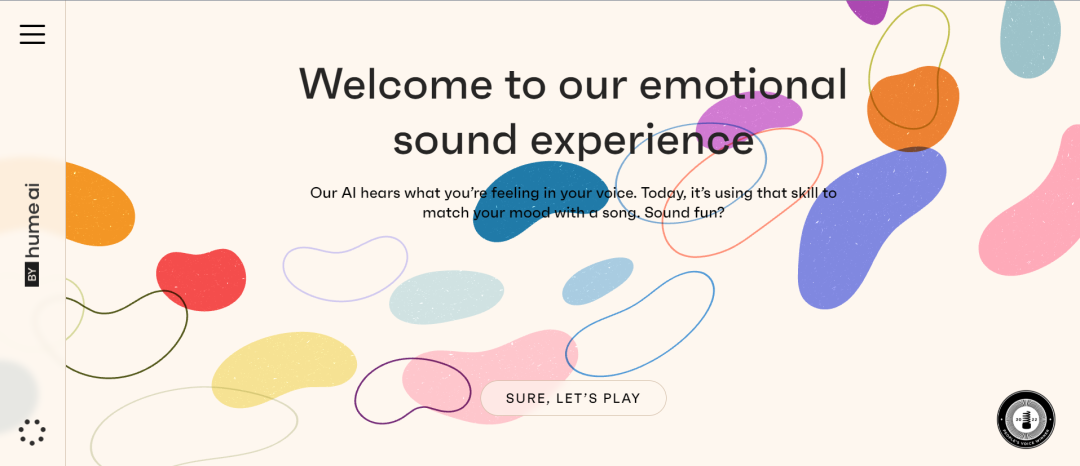

EVI 不仅是一款产品,还提供了 API 便于其他应用程序的集成,并能与任何大型语言模型(LLM)无缝对接。

为了展示其 API 的能力,Hume 官方推出一款体验应用,可以通过用户的声音分辨现在的情绪状态,并搭配相应的歌曲。

二、能听懂人类情绪的大语言模型

传统 AI 系统更多关注语言层面的理解,但 Hume AI 的 CEO 兼首席科学家 Alan Cowen 指出人类的情感很大程度上是通过声音、面部表情等非语言方式表达的。这一领域被称为”情感计算”,在生成式 AI 模型应用当中相对落后。

为填补这一空白,Hume 开发了一种新型多模态生成式人工智能 eLLM(移情大语言模型),它将先进的自然语言处理技术与情感识别算法集成在一起。通过理解语音、面部表情等,模型能够学习分辨何种表现意味着快乐、沮丧、困惑等情绪,并做出相应响应。

因此 eLLM 能够检测和解释人类语言数据中的情感线索,使人工智能系统能够生成句法和语义上一致,并且在情感上与用户输入相协调的响应。

通过利用情感分析模块、情感识别算法和情境理解机制,eLLM 使 AI 技术能够让用户参与更具同理心和响应性的对话。这种功能增强了人机交互,促进更深层次的参与和融洽关系。

模型从大量真实数据中学习,包括全球数百万人的语音和表情数据。因此这一模型不仅会学习情感的平均模式,还会捕捉个体和文化差异。当然,对于不同语言和文化背景,Hume AI 需要对模型进行微调或重新训练。有些语言的理解差异会更大。因此,该技术目前仅支持英语。

三、与 EVI 交谈是一种怎样的体验

科技媒体的报道和社交网络上首批用户的反馈,都表现出对 EVI 的情感感知和回应能力的赞叹。

AI 媒体编辑 Ryan Morrison 表示:“与 EVI 对话,既不同寻常又引人入胜。它并不模仿人类,而是坦诚地表明自己是人工智能。然而,它对情感的敏锐理解力却让人着迷。”在一次对话中,Rayn 询问它能否判断自己是否吃过早餐,EVI 回应道这个语调“显得饥饿且坚定”,因此判断 Rayn 可能没吃早餐,而且它判断得完全正确。

笔者在体验了 EVI 的 demo 后感知到它跟其他 AI 语音模型的差异。首先是语调和发音上并没有极大的机械感,而且连贯性和语气方面表现的非常好,而这种感觉伴随着交流的频次增加更加的明显,甚至不太能分辨其 AI 的真实身份。

一般用户将其他的 AI 应用当做工具或者助手来使用,更多应用到 AI 理性和智能的一面。或许在 EVI 上,确实可以体验到情绪和感性的一方面。就像 Alan 描述的 AI 助手作为”朋友”的愿景,它能够理解并回应人类的情感需求。

四、为什么 AI 需要情感

Hume AI 公司的核心使命是“优化 AI 以提高人类的幸福感,而情感则是构成幸福感的重要部分。”

想让 AI 更好地服务于提升人类福祉或使人机交互更加自然,让 AI 拥有共情能力是关键。当前的 AI 助手只理解语义内容,而忽视了语音语气和情感这些同样重要的因素,导致交互体验生硬和不自然。赋予 AI 情感理解能力,能让人机交互更自然、富有温度。

Alan 表示现有 AI 系统最大的限制是它们受限于人类的浅层评价和指导,未能充分挖掘 AI 创造幸福新方式的潜力。因此 Hume 团队开发的 AI 模型基于人类幸福感的直接数据学习,这些数据与驱动多模态 AI 模型的标准数据集一同作为训练材料。

Hume AI 的技术目前已经应用于培训心理治疗师、改善客户服务等领域。通过分析语音和面部表情,系统能更好地理解患者或客户的情绪状态,从而提供更精准的服务。

目前,已经有很多不同背景的用户,尝试借助 EVI 来开发自己的应用。Hume AI 社区的活跃用户除了开发者和工程师、设计师和产品经理以及研究人员之外,还包括了很多教育培训、医疗健康领域人士和艺术家与创意工作者。每个人都带着自己独特的视角和需求,希望通过 Hume AI 的相关技术来推动自己领域的进步。

他们正在或想要开发的应用涵盖了健康与福祉、社交通讯、教育学习工具、情感分析、多模态内容生成等不同领域。其中大多都应用到了 EVI 的情感智能这一特点。例如让用户能更加真诚连接的在线社交应用,分析用户自信水平和提高其状态的应用,通过增强语音体验帮助老年人的 AI 助理,根据用户的情绪状态调整健康程序的女性健康应用等等。

(Hume AI 社区成员开发的产品)

当 AI 拥有了情感智能,融合了理性和感性两方面的能力,或许可以让 AI 真正接近人类智能的高度。让它们更贴近人性,为人类生活带来全新体验。

参考材料:

https://www.tomsguide.com/ai/i-had-a-conversation-with-evi-the-new-empathic-ai-voicebot-from-hume

https://www.youtube.com/watch?v=uR-z-Ypio-M

https://twitter.com/hume_ai/status/1773017060173365306

编译:Wes

来源公众号:深思SenseAI;关注全球 AI 前沿,走进科技创业公司,提供产业多维深思。

本文由人人都是产品经理合作媒体 @深思SenseAI 授权发布,未经许可,禁止转载。

题图来自 Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益