从Prompt到Multi-Agent 大模型应用架构演进

从单一提示到多智能体协作,AI应用架构的演进不仅是技术的迭代,更是生产力范式的重塑。本文将带你洞察这一转变背后的逻辑与趋势,理解它如何重新定义人与智能的关系。

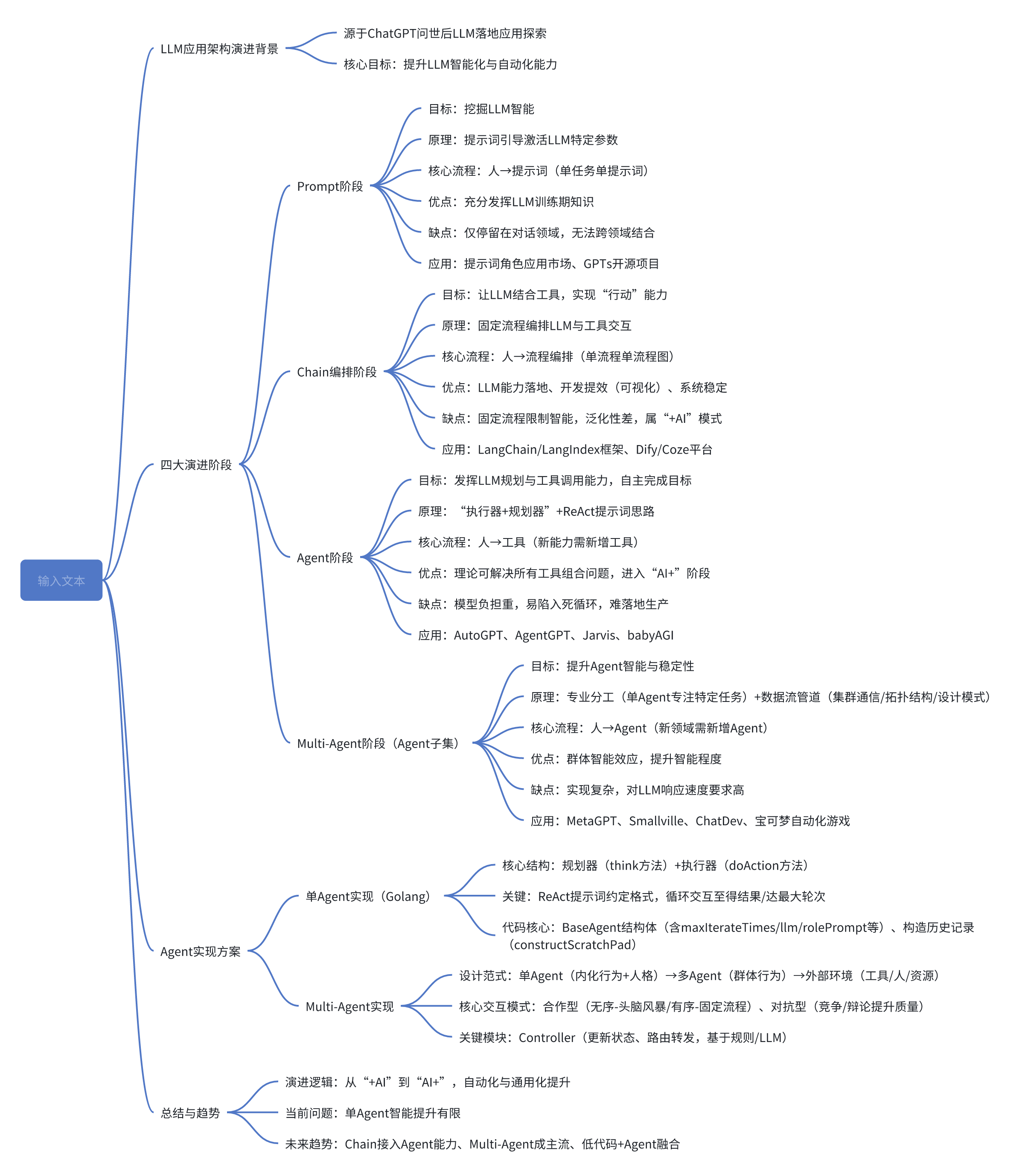

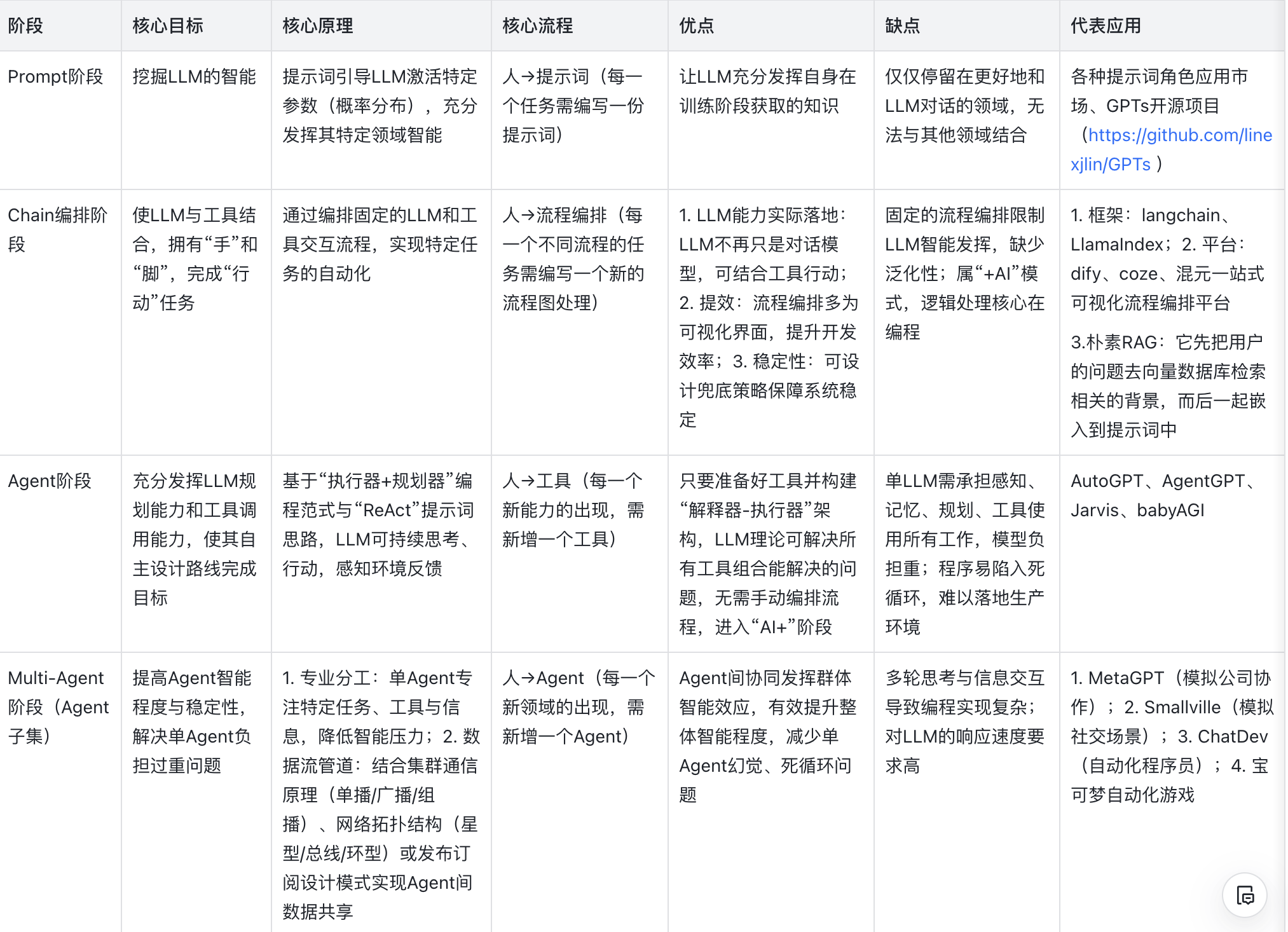

自ChatGPT问世后,LLM应用落地经历了“Prompt阶段”、“Chain编排阶段”、“Agent阶段”及作为Agent子集的“Multi-Agent阶段”四大演进阶段:

- Prompt阶段通过手动设计提示词挖掘LLM智能,仅停留在对话领域;

- Chain阶段以固定流程串联LLM与工具实现“+AI”落地,虽稳定高效但限制智能发挥;

- Agent阶段凭借“执行器+规划器”范式让LLM自主规划、调用工具进入“AI+”阶段,却存在模型负担重、易陷入死循环的问题;

- Multi-Agent阶段则通过多领域专家Agent协作,结合集群通信原理与特定交互模式,在提升智能与稳定性的同时,面临实现复杂、对LLM响应速度要求高的挑战,Multi-Agent实际上算是Agent的一个子集,它用于处理单Agent工作量过重,导致容易陷入幻觉、死循环等问题;

一、思维导图(mindmap)

二、详细总结

1. LLM应用架构演进背景

自ChatGPT问世以来,业内围绕LLM落地应用展开多维度探索,核心目标是持续提升LLM在实际场景中的**智能化**与**自动化**能力,最终形成从基础对话到自主协作的四大演进阶段,同时衍生出对应的技术方案与实现思路。

2. LLM应用四大演进阶段详情

3. Agent实现技术方案

(一)单Agent实现(基于Golang)

1)核心结构:采用“规划器(think方法)+执行器(doAction方法)”架构,结合ReAct提示词思路实现LLM与环境的持续交互

2)关键逻辑:

- 提示词约定:要求LLM按特定格式输出“行动方案”(工具名称+输入)或“最终答案”

- 循环交互:规划器生成方案后,执行器解析并调用工具,将结果作为历史记录(constructScratchPad方法构造)反馈给LLM,直至获取答案或达到最大循环次数(默认值为工具数量+1)

3)核心代码模块:

- BaseAgent结构体:包含maxIterateTimes(最大轮次)、llm(大语言模型实例)、rolePrompt(人设提示词)、Tools(工具列表)、steps(思考步骤)等字段

- NewBaseAgent构造器:初始化Agent,补全默认参数(如角色提示词、最大轮次)

- think方法:生成提示词、调用LLM推理、解析结果(判断执行工具或输出答案)

- doAction方法:获取工具、调用工具并记录执行结果(成功/失败信息)

(二)Multi-Agent实现

1)设计范式:

- 左侧:单Agent(含内化行为:计划/推理/反思;人格特征:认知/情感/性格)

- 中间:多Agent群体(通过合作/对抗模式实现交互)

- 右侧:外部环境(虚拟/物理环境,含人类参与者与资源,其他Agent也属环境一部分)

2)核心交互模式:

- 合作型:无序合作(自由表达,适用于头脑风暴)、有序合作(按规则流程,适用于固定任务如日志解析)

- 对抗型:通过竞争、谈判、辩论让Agent反思修正,提升系统响应质量(如self-RAG中反思Agent判断回答有效性)

3)关键模块(Controller):

- 功能:更新环境状态、选择下一个行动Agent、路由转发信息

- 路由方式:基于规则(如状态机/SOP思路)、基于LLM

- 交互流程:Controller选Agent→Agent交互环境更新记忆→Agent“规划-执行”循环生成信息→更新环境→Controller重新选Agent

4. 总结与未来趋势

演进核心:LLM应用从“+AI”(依赖编程逻辑)逐步过渡到“AI+”(依赖LLM自主决策),自动化与通用化水平持续提升

当前问题:单Agent纵向智能提升有限,存在落地障碍

未来趋势:

- Chain模式:保留稳定性,接入Agent能力突破固定流程限制(如LangChain向LangGraph发展)

- Multi-Agent:通过水平扩展成为主流,优化架构提升实用性

- 低代码融合:可视化编排结合Agent能力,降低开发门槛

本文由 @独屿~ 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

评论

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益