为什么90%的AI项目都失败?因为从老板到团队,都没搞懂AI底层概念到商业决策的逻辑

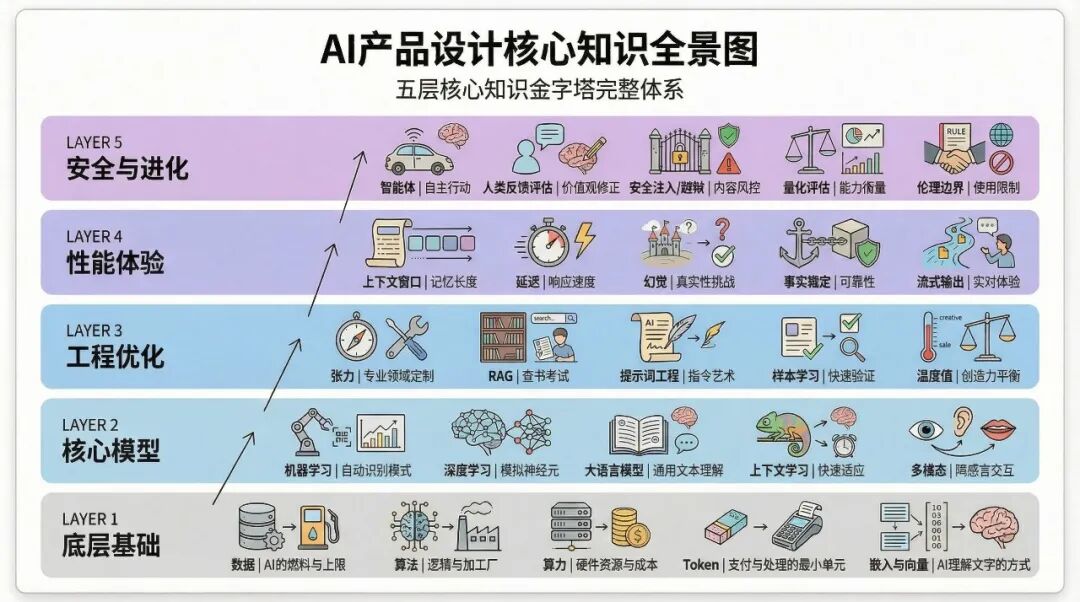

AI项目的失败往往源于对技术底层逻辑的认知断层。本文通过五层金字塔模型,系统拆解从数据、算法、算力等基础设施,到核心模型、工程优化、性能体验及安全进化的完整知识体系。深入剖析Token成本、RAG技术、提示词工程等关键概念如何直接影响商业决策,为创业者与企业提供避免盲目投入的实战框架。

这篇文章完整的讲清楚了AI底层概念与商业的逻辑,19,000字,建议先收藏,再慢慢看。

这两年我见过太多这样的场景了:创业者兴冲冲地说要做AI项目,张口就是”我们要用大模型改造整个业务流程”;企业高管拍板投入几百万做AI转型,结果半年过去产品上不了线;技术团队说可以做,产品团队说需求明确,但做出来的东西根本解决不了实际问题。为什么?

——因为从决策层到执行层,大家对AI的理解都停留在表面——知道AI很火,知道要用AI,但不知道AI到底是什么、能做什么、不能做什么。

这就像十多年前移动互联网刚起来的时候,很多传统企业老板说”我们要做一个APP”,但根本不理解为什么一定要做APP、数据库架构、用户行为逻辑。结果花了大价钱做出来的东西,要么是摆设,要么是灾难。现在AI浪潮来了,历史又在重演。

区别在于,看起来AI做产品的门槛降低了,手搓智能体,立马就可以拿出来用,但其实是降低了研发的成本,但是在商业层面,尤其是传统产业+AI的实际场景,应用AI的门槛比互联网更高,成本更大,试错的代价更重。

我在互联网行业做了二十年,从2005年开始创业,经历过多个技术浪潮,做过C端产品也做过B端业务,带过团队也融过资,深知技术革命对于创业者和企业意味着什么——既是千载难逢的机会,也是巨大的陷阱。

这一年多我一直在研究AI、实践AI产品,和超级个体、和几十个创业团队、投资人、大型企业CTO都有深入交流,发现一个残酷的事实:90%的AI项目失败,不是因为技术不行,而是因为从一开始就没想清楚AI到底是什么。

所以我把这一年的思考和实践整理成了这篇文章,用五层金字塔模型把AI的底层原理、核心技术、工程实现、性能边界、安全风险全部梳理清楚。

这不是写给技术专家看的学术论文,而是写给创业者、企业管理者、产品经理看的”实战地图”——你不需要会写代码,但你必须理解这些基础概念,否则你做的每一个决策都可能是错的。

投多少钱、用什么技术、做什么功能、怎么定价、如何迭代,这些问题的答案都藏在对AI底层原理的理解中。

今天就用最接地气的方式,把这些看起来高深莫测的概念讲清楚。相信我,花一个小时理解这些基础概念,能让你少走半年弯路,少烧几百万预算。

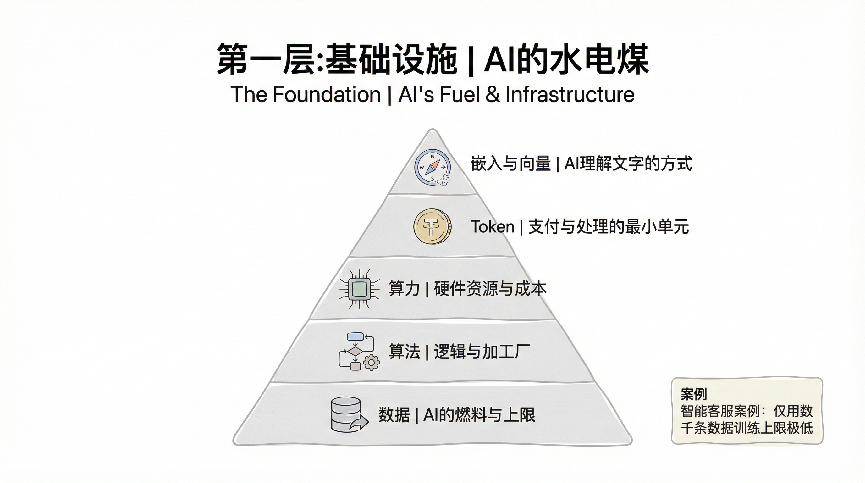

第一层:打好地基,理解AI的”水电煤”

做AI产品和盖房子其实是一个道理,你得先把地基打牢了。在AI的世界里,数据、算法、算力和Token就是你的”水电煤”,这四个东西决定了你能做什么、不能做什么、做到什么程度。

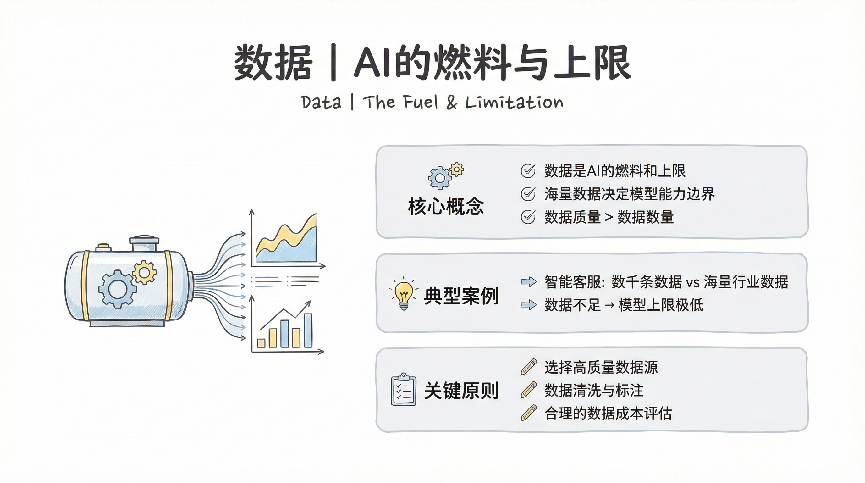

数据:AI的燃料与上限

先说数据,这个词你肯定听了无数遍了,但真正理解数据在AI中扮演的角色的人并不多。我给你打个比方,数据就像是给AI喂的食物,你喂什么它就学什么,你喂得好不好直接决定了它能长多高。

举个实际的例子,假设你要做一个智能客服产品,如果你只拿公司内部的几千条客服对话记录去训练模型,那这个客服最多只能应付那几个常见问题。但如果你能收集到行业内几十万条、甚至上百万条真实的客服对话,包括各种刁钻问题、情绪化表达、方言俚语,那训练出来的模型就完全不是一个级别了。

数据的”上限”这个概念特别重要,它直接告诉你这个产品的天花板在哪儿。就像ChatGPT之所以强大,是因为它见过互联网上海量的文本数据,从学术论文到网络段子,从代码库到小说诗歌,什么都见过。所以当你在做AI产品规划的时候,第一个要问自己的问题就是:我能拿到什么样的数据?这些数据的质量和数量能支撑我想做的功能吗?

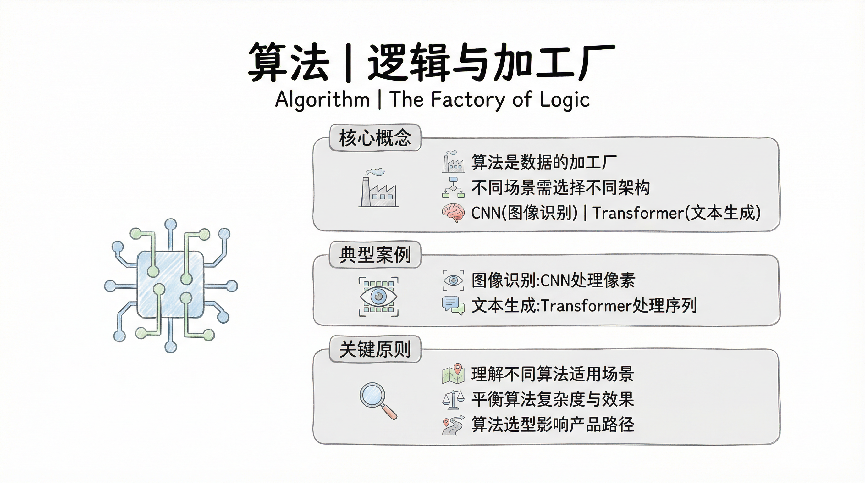

算法:速度与加工厂

如果说数据是原材料,那算法就是加工厂里的生产线。同样的原材料,用不同的生产线加工出来的产品质量和效率是完全不同的。

在AI领域,算法的演进速度快得惊人。从最早的决策树、随机森林,到后来的卷积神经网络、循环神经网络,再到现在的Transformer架构,每一次算法的革新都带来了产品能力的质变。就拿Transformer来说,它最大的创新就是”注意力机制”,让模型能够同时关注输入序列中的所有位置,这直接催生了GPT系列和BERT这样的强大模型。

作为产品经理,你不需要深入到算法的数学推导细节,但你必须理解不同算法的特点和适用场景。比如说,如果你要做图像识别,CNN(卷积神经网络)是首选;如果要做文本生成,那就得用Transformer架构;如果要做时间序列预测,RNN或LSTM可能更合适。选错了算法,就像用螺丝刀去砸钉子,费力不讨好。

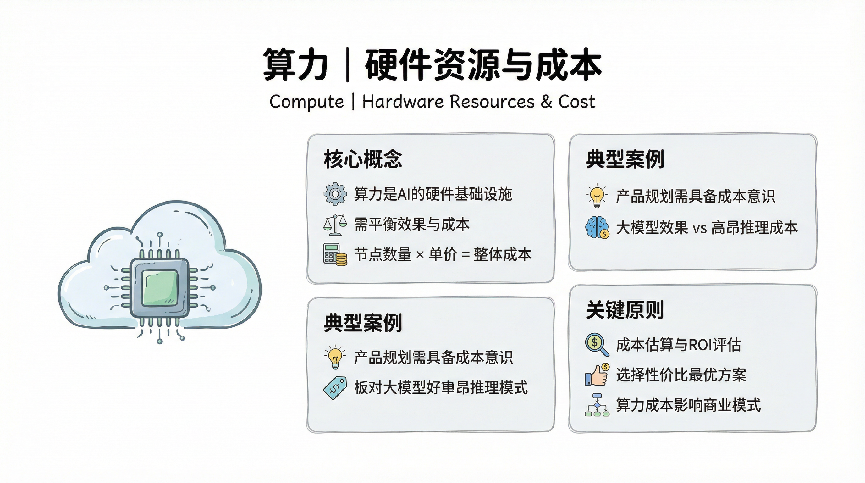

算力:硬件资源与成本

算力这个东西说白了就是钱。训练一个大模型需要多少GPU、跑多长时间、每次推理要消耗多少算力资源,这些都直接关系到你的产品成本和商业模式。

我给你算笔账你就明白了。训练GPT-3这样规模的模型,需要数千块高端GPU连续跑几个月,成本大概在几百万美元级别。而当你的产品上线之后,每次用户调用都要消耗算力,假设每次推理成本是0.002美元,如果你有一百万用户每天平均调用十次,那一天的算力成本就是两万美元,一个月就是六十万美元。

这就是为什么很多AI产品最后没做起来的原因——不是技术不行,而是算力成本撑不住。所以当你在规划AI产品的时候,必须要有成本意识,要考虑清楚怎么在效果和成本之间找到平衡点。有时候一个轻量级的模型配合好的产品设计,效果不一定比大模型差,但成本可能只有十分之一。

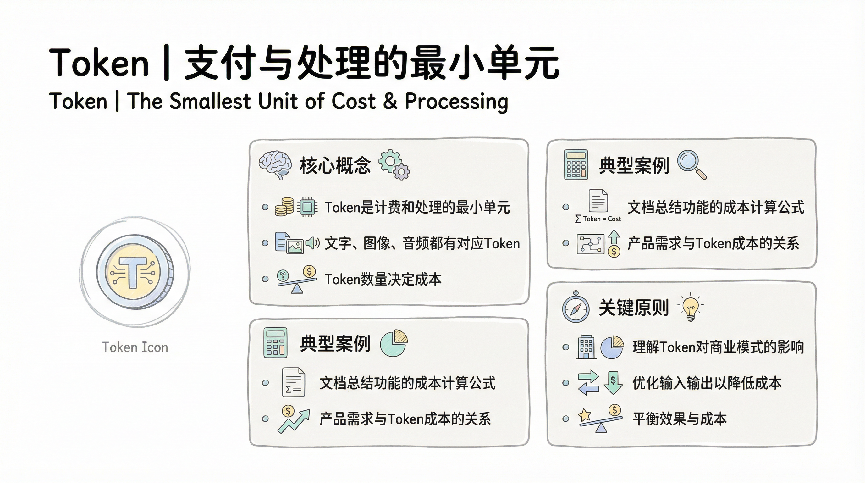

Token:支付与处理的最小单元

Token这个概念对很多人来说比较陌生,但它其实是理解AI模型的关键。简单来说,Token就是AI处理文本的最小单位,你可以把它理解成”字块”或者”词块”。

在英文里,一个Token大概是0.75个单词,而在中文里,通常一个汉字就是一个Token。为什么要有Token这个概念呢?因为AI模型不能直接理解文字,它需要把文字转换成数字才能处理,而Token就是这个转换的基本单位。

Token的意义不仅在于技术层面,更在于它直接关系到产品的商业模式。现在几乎所有的大模型API都是按Token计费的,输入多少Token、输出多少Token都要收费。比如GPT-4的价格是输入每1000个Token收0.03美元,输出每1000个Token收0.06美元。

这对产品设计有什么影响呢?举个例子,如果你做一个文档总结功能,用户上传一个10000字的文档,假设转换成15000个Token,让AI总结成500字也就是750个Token。那这一次调用的成本就是:15000÷1000×0.03 + 750÷1000×0.06 = 0.495美元,差不多3块多人民币。如果你的产品定价是每月9.9元,用户每个月总结三次文档你就亏了,这生意怎么做?

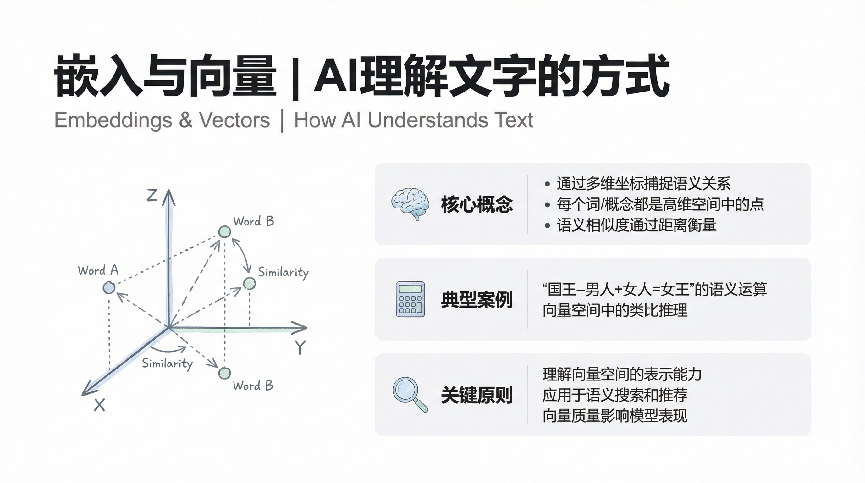

嵌入与向量:AI如何”理解”文字

说完Token,我们再深入一步:这些Token是怎么变成AI能理解的东西的呢?答案是通过”嵌入”(Embeddings),把文字转换成向量。

你可以把向量理解成一串数字组成的坐标。比如”国王”这个词可能被表示成[0.2, 0.8, -0.3, 0.5, …]这样一串几百个甚至上千个数字。听起来很抽象对吧?我给你打个比方,这就像给每个词在多维空间里找了个位置,意思相近的词在空间里距离就近。

最神奇的是,这些向量能够捕捉语义关系。有个经典例子:”国王” – “男人” + “女人” = “女王”。在向量空间里,这个数学运算真的成立!这说明向量不仅表示了词的含义,还表示了词之间的关系。

对产品经理来说,理解嵌入的意义在于:这是AI实现语义搜索、推荐、分类的基础。比如你做一个智能搜索产品,用户输入”如何提升工作效率”,传统关键词搜索只能匹配包含这些字的文档。但如果用向量搜索,它能找到”时间管理技巧”、”生产力工具推荐”这些语义相关但用词完全不同的内容,这就是嵌入技术的威力。

而且向量的维度直接影响性能和成本。维度越高(比如1536维),表达能力越强但计算成本越高;维度越低(比如384维),速度快但可能丢失一些语义信息。这又是一个需要在产品设计时权衡的点。

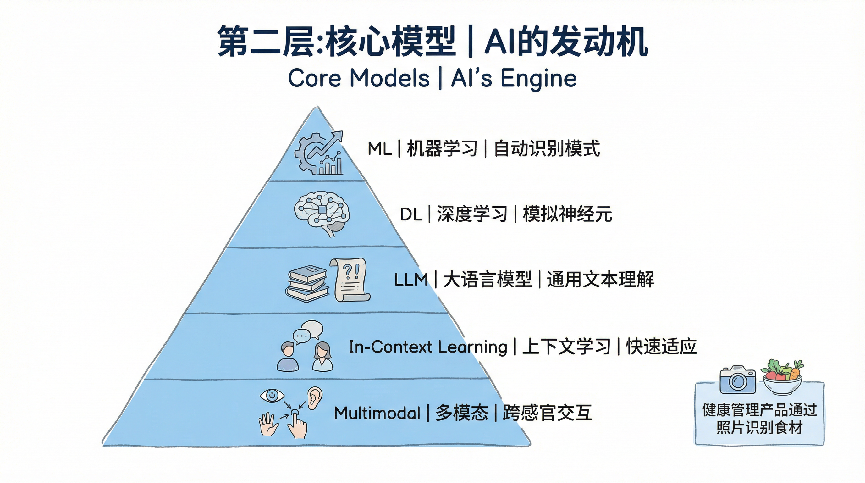

第二层:核心模型,AI的”发动机”

理解了底层的基础设施之后,我们往上走一层,来看看AI的”发动机”——核心模型层。这一层包括机器学习、深度学习、大语言模型和多模态,它们代表了AI能力的不同形态和演进路径。

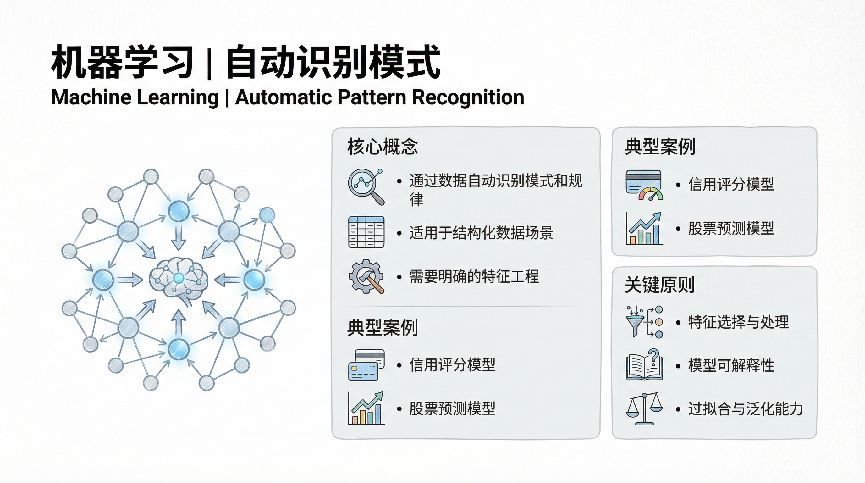

机器学习:自动识别模式

机器学习说起来神秘,其实概念很简单:让机器从数据中自动学习规律,而不是人工编写规则。这个思路的转变彻底改变了软件开发的方式。

以前做一个垃圾邮件过滤器,你得写一堆规则:包含”中奖”这个词的是垃圾邮件,标题全是大写字母的是垃圾邮件,含有可疑链接的是垃圾邮件……但规则永远写不完,漏网之鱼也越来越多。机器学习的做法是:给我一万封正常邮件和一万封垃圾邮件,让算法自己去找规律。结果发现,机器学出来的模式比人工规则准确得多,而且还能不断进化。

作为产品经理,理解机器学习最重要的是要知道它的边界在哪里。机器学习特别擅长从大量数据中找规律,但它不擅长处理训练数据里没见过的情况,也不擅长做需要复杂推理的任务。所以当你规划产品功能的时候,要评估清楚这个场景适不适合用机器学习来解决。

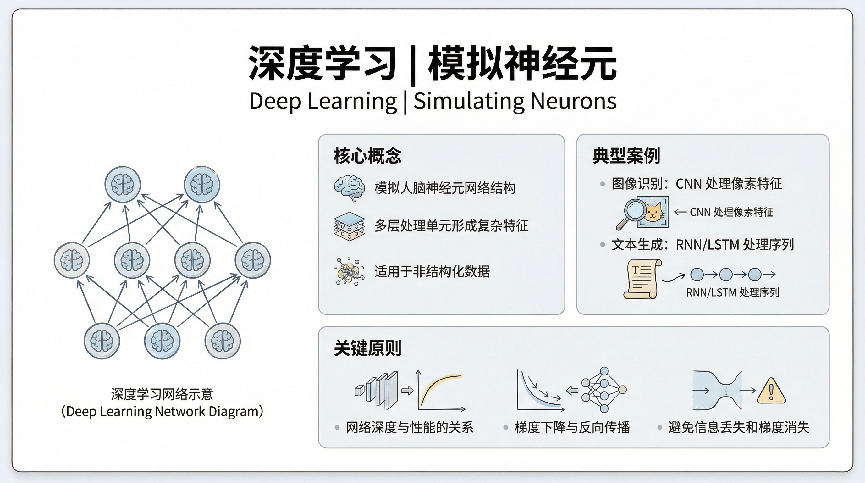

深度学习:模拟神经元网络

深度学习是机器学习的一个分支,它的灵感来源于人脑的神经网络。简单说就是把很多层的”神经元”堆叠起来,形成一个深层网络,让它能够学习更复杂的模式。

深度学习真正火起来是在2012年,当时ImageNet图像识别大赛上,深度学习模型AlexNet把错误率从26%直接降到了15%,把所有传统方法甩在了身后。从那之后,深度学习就成了AI领域的主流技术,语音识别、图像识别、自然语言处理都被它攻陷了。

深度学习的强大之处在于它的”表示学习”能力,也就是能够自动从原始数据中提取有用的特征。以前做图像识别,你得手工设计特征:边缘检测、纹理分析、颜色直方图……累死累活效果还不好。深度学习直接从像素级别的原始图像开始学,自己琢磨出什么特征最有用,最终学出来的特征比人工设计的好得多。

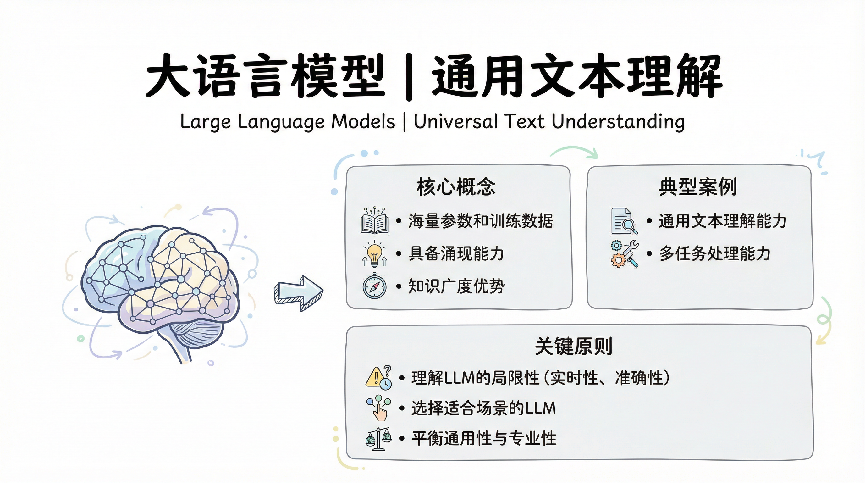

大语言模型:通用文本理解能力

大语言模型(LLM)是最近两年最火的概念,ChatGPT的横空出世让所有人都见识到了它的威力。但大语言模型到底”大”在哪里呢?

首先是参数规模大。GPT-3有1750亿个参数,GPT-4的参数量虽然没有官方披露,但估计在万亿级别。这些参数就像是模型的”记忆单元”,参数越多,能记住的知识和模式就越多。

其次是训练数据大。大语言模型是在海量文本上训练出来的,基本上把互联网上能找到的高质量文本都喂了一遍。这就让它具备了极其广泛的知识面,从天文地理到文学艺术,从编程代码到菜谱食谱,它都有所了解。

但大语言模型最革命性的地方在于它的”涌现能力”。当模型规模达到一定程度之后,它会突然展现出训练时没有特别优化的能力,比如逻辑推理、数学计算、多步骤任务规划等等。这种涌现能力让大语言模型成为了一个通用的AI助手,而不是只能干一件事的专用工具。

作为产品经理,理解大语言模型的关键是要知道它既强大又有局限。它强在知识广度和语言理解,但弱在实时性(训练数据是静态的)、准确性(容易编造事实)和专业深度(什么都懂点但不够精深)。所以在产品设计时要扬长避短,充分利用它的优势,同时用产品手段去弥补它的短板。

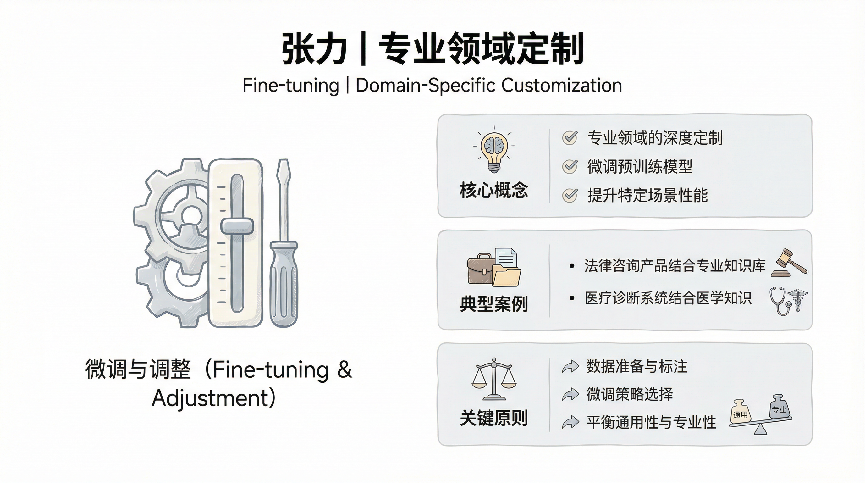

预训练与微调:现代AI的两阶段法则

理解现代AI模型,必须掌握”预训练-微调”这个核心范式。这就像培养一个人才:先让他接受通识教育,打好基础,然后再针对具体岗位进行专业培训。

预训练(Pre-training)是第一阶段,在海量通用数据上训练模型,让它学习语言的基本规律、常识知识、推理能力等通用能力。这个阶段非常耗资源,需要几千张GPU卡跑几个月,成本在百万美元级别。但好处是只需要做一次,训练出来的模型可以作为”基座模型”供各种应用使用。

微调(Fine-tuning)是第二阶段,拿着预训练好的模型,在特定任务的数据上继续训练,让它适应具体场景。比如你要做医疗问答,就用医疗对话数据微调;做法律咨询,就用法律案例微调。微调的数据量小得多(几千到几万条),训练成本也低很多,但能显著提升模型在特定领域的表现。

举个实际例子,假设你要做一个智能客服产品。直接用GPT-4当然可以,但它的回答可能太泛泛,不够符合你公司的业务特点和服务标准。这时候你可以:收集几千条公司历史的优质客服对话,用这些数据微调一个模型,让它学会你们公司的话术风格、常见问题的标准答案、特殊情况的处理方式。微调后的模型虽然基于通用大模型,但回答会更专业、更贴合业务。

现在还出现了一些更轻量的微调方法,比如LoRA(低秩适应),不需要调整模型的所有参数,只调整一小部分,这样成本更低、速度更快,对于很多场景已经够用了。

对产品经理来说,理解预训练-微调的意义在于:你不需要从零训练模型(那是大公司才玩得起的游戏),可以基于现有的预训练模型,通过微调来快速打造适合自己业务的AI能力。这大大降低了AI产品的门槛。

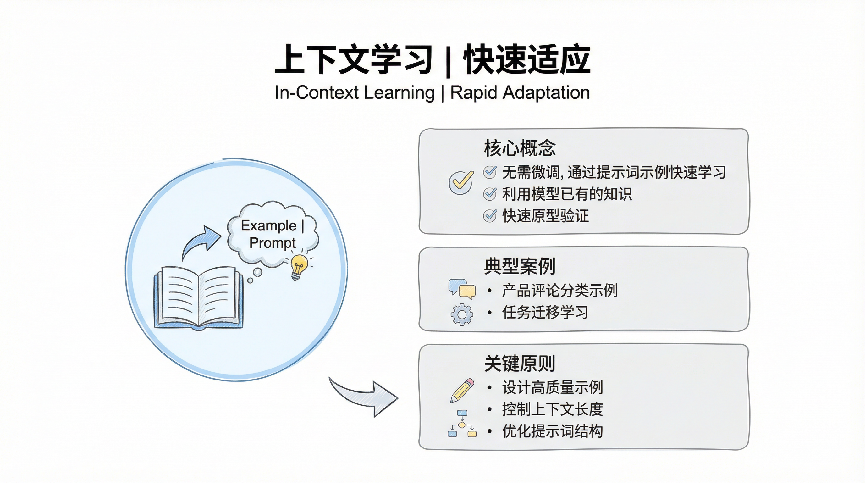

上下文学习:大模型的”超能力”

上下文学习(In-Context Learning)是大语言模型最神奇的能力之一,它能够从你给的例子中快速学习,而不需要重新训练或微调。

传统机器学习模型如果要学习新任务,必须用新数据重新训练。但大语言模型不一样,你在对话里给它几个例子,它立刻就能理解你要什么,并按照你的要求去做。这就是上下文学习——它在”对话的上下文”中完成了学习。

我给你举个例子。假设你要让AI把产品评论分成正面、负面、中性三类。你不需要标注几千条数据去训练模型,只需要在提示词里给几个例子:

1 任务:将产品评论分类为正面、负面或中性

2

3 例子1:

4 评论:这个产品太棒了,完全超出预期!

5 分类:正面

6

7 例子2:

8 评论:质量一般般,价格还挺贵

9 分类:负面

10

11 例子3:

12 评论:还行吧,凑合用

13 分类:中性

14

15 现在请分类这条评论:

16 评论:收到货了,包装不错,用了几天感觉还可以

17 分类:正面

模型看了这几个例子,立刻就理解了任务,会给出”中性”这个答案。更神奇的是,你换个任务,比如改成情感分析、提取关键信息、文本改写,只要改改例子,模型马上就能做新任务。

上下文学习为什么这么重要?因为它让AI产品的迭代速度大幅提升。以前开发一个新功能,要收集数据、训练模型、测试优化,可能要几周甚至几个月。现在很多场景下,你花几个小时设计好提示词和例子,功能就能跑起来了。虽然效果可能不如专门训练的模型,但80%的场景已经够用,而且可以快速验证想法是否可行。

上下文学习的能力上限取决于上下文窗口的大小。窗口越大,能放的例子越多,学习效果越好。这也是为什么模型厂商都在不断扩大上下文窗口——不仅是为了处理长文档,更是为了增强上下文学习能力。

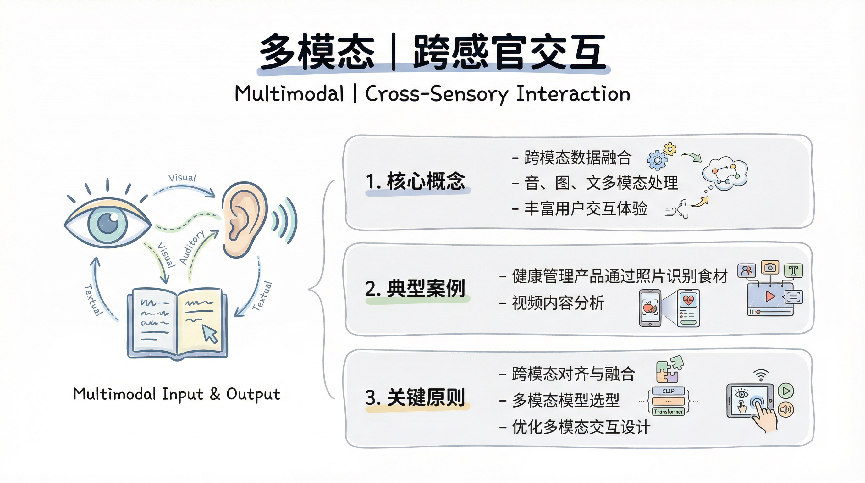

多模态:跨感官交互

多模态是AI发展的必然趋势,因为人类理解世界本来就是多感官融合的。我们看图像、听声音、读文字,这些信息在大脑里整合成对世界的认知。AI也需要具备这样的能力。

最早的多模态模型是图文对齐,比如CLIP模型能够理解图片和文字的对应关系,给它一张猫的图片,它知道这对应”cat”这个词。后来发展到图像生成,像DALL-E、Midjourney、Stable Diffusion,能根据文字描述生成图像。现在更进一步,GPT-4V可以同时处理图像和文本,实现真正的多模态对话。

多模态对产品的意义非常大。它打破了交互方式的限制,用户可以用最自然的方式和AI沟通——发张图片、说句话、打几个字,AI都能理解并给出恰当的回应。比如你做一个健康管理产品,用户拍张饭菜照片,AI就能识别食材、估算卡路里、给出营养建议,这种体验是单一模态无法实现的。

第三层:工程优化,让AI”落地生根”

有了核心模型这个发动机,接下来就要考虑怎么让它真正跑起来,这就涉及到工程优化层。这一层包括张力、RAG、提示词工程、样本学习和温度值调节,都是把AI从实验室搬到产品中的关键技术。

张力:专业领域深度定制

“张力”这个词可能不太常见,它说的是针对特定领域进行深度定制和优化的能力。通用大模型虽然强大,但在专业领域往往不够精准,这时候就需要通过微调、提示词设计、知识注入等方式,让模型在特定领域表现出专业水准。

举个例子,如果你要做一个法律咨询AI产品,直接用ChatGPT肯定不行,因为它给的答案太泛泛了,缺乏法律专业性,甚至可能给出错误的法律建议。这时候你需要做的是:收集大量真实的法律案例和判决文书,用这些专业数据对模型进行微调;设计专门的提示词模板,引导模型从法律角度思考问题;建立法律知识库,让模型可以引用准确的法条和判例。

这个定制化的过程就是在拉伸模型的能力边界,让它在法律这个垂直领域有足够的”张力”。不同的领域需要不同的优化策略,医疗、金融、教育、制造业,每个领域都有自己的专业术语、业务逻辑和知识体系,需要针对性地去调教模型。

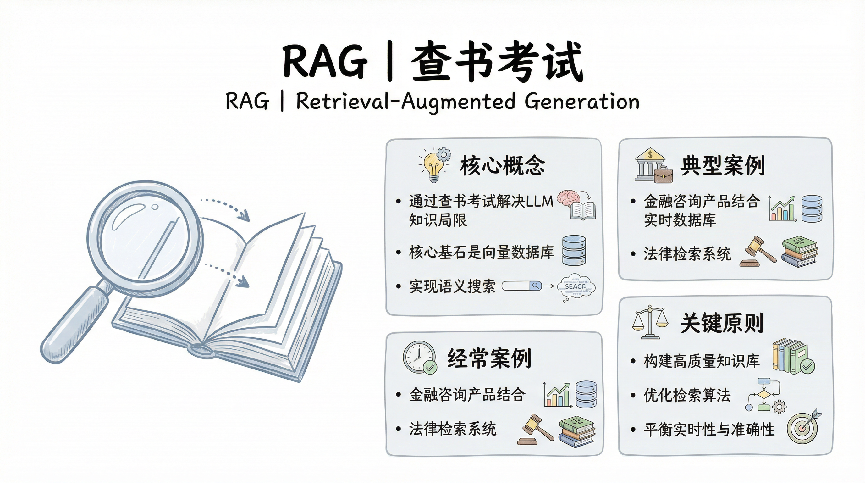

RAG:查书考试

RAG(Retrieval-Augmented Generation,检索增强生成)是解决大语言模型知识局限性的一个巧妙方案。它的思路很简单:模型记不住所有东西没关系,给它一个图书馆,需要的时候让它先查书,再根据查到的内容来回答问题。

具体怎么实现呢?当用户提一个问题时,系统先去知识库里搜索相关的文档片段,把这些片段和用户的问题一起喂给模型,让模型基于这些检索到的内容生成回答。这样做的好处是:第一,模型可以获取最新的信息,不受训练数据时间限制;第二,可以引用具体的来源,增强答案的可信度;第三,知识库可以随时更新,不需要重新训练模型。

我见过一个特别好的RAG应用案例:一家企业做了内部知识管理系统,把公司所有的产品文档、技术规范、流程制度都存进了知识库。员工有问题时问AI助手,它会先检索相关文档,然后基于这些文档给出答案,并标注信息来源。这样既保证了答案的准确性,又提升了知识获取的效率。

做RAG产品时有几个关键点要注意:检索的准确性(能不能找到真正相关的内容)、内容的分块策略(文档该怎么切分)、上下文的长度控制(给模型看多少内容)、来源的标注方式(怎么让用户信任答案)。这些都需要仔细设计和反复优化。

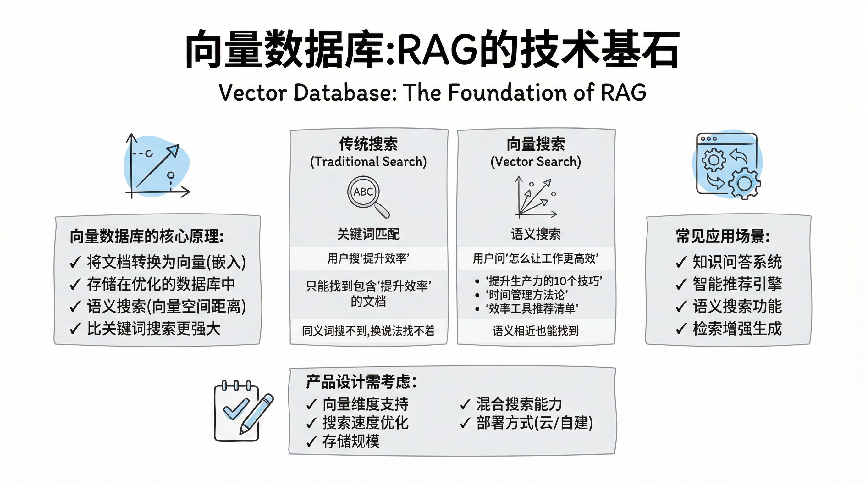

向量数据库:RAG的技术基石

说到RAG,就不得不提向量数据库。传统的搜索是关键词匹配,用户搜”如何提升效率”,系统就找包含这几个字的文档。但这种方式有局限:同义词搜不出来,换个说法就找不到了。

向量数据库的工作方式完全不同。它把所有文档都转换成向量(还记得前面讲的嵌入吗?),存储在一个专门优化过的数据库里。当用户提问时,问题也转换成向量,然后在向量空间里找距离最近的文档。这种”语义搜索”比关键词搜索强大得多。

举个例子,用户问”怎么让工作更高效”,向量搜索能找到:

- “提升生产力的10个技巧”(虽然用词不同,但语义相近)

- “时间管理方法论”(相关主题)

- “效率工具推荐清单”(同样是解决效率问题)

而关键词搜索可能一条都找不到,因为这些文档里没有完全匹配的字。

常见的向量数据库有Pinecone、Weaviate、Milvus、Qdrant等。选择向量数据库时要考虑几个因素:支持的向量维度、搜索速度、存储规模、是否支持混合搜索(向量+关键词)、部署方式(云服务还是自己搭建)。

对产品经理来说,理解向量数据库的意义在于:它是现代AI产品的标配基础设施。做知识问答、智能推荐、语义搜索,基本都离不开向量数据库。而且向量数据库的性能直接影响用户体验——搜索速度慢了,用户等得着急;召回率低了,找不到想要的内容。这些都需要在产品设计时考虑清楚。

提示词工程:指令调优艺术

提示词工程可能是AI产品经理最需要掌握的技能了。本质上说,提示词就是你和AI沟通的语言,你说得清楚、说得对,AI的回答就好;你说得含糊、说得乱,AI就理解不了你的意图。

好的提示词是有结构的。最基本的结构包括角色设定、任务描述、输出格式、约束条件。比如你想让AI帮你写产品文案,一个糟糕的提示词是”帮我写个文案”,一个好的提示词是:”你是一位资深的产品文案策划师,擅长写出既有创意又有转化力的文案。请为我们的智能手表新品写一段200字左右的产品介绍,突出健康监测功能的专业性和易用性,语言风格要年轻化、有科技感,避免使用过于专业的术语。”

提示词工程还包括很多技巧:少样本学习(给几个例子让AI理解你的要求)、思维链(让AI展示思考过程)、角色扮演(让AI进入特定状态)、分步骤引导(把复杂任务分解成小步骤)。这些技巧都能显著提升AI的输出质量。

我的建议是,每个AI产品经理都应该建立自己的提示词库,把工作中常用的、好用的提示词模板保存下来,不断迭代优化。这是你最核心的资产之一。

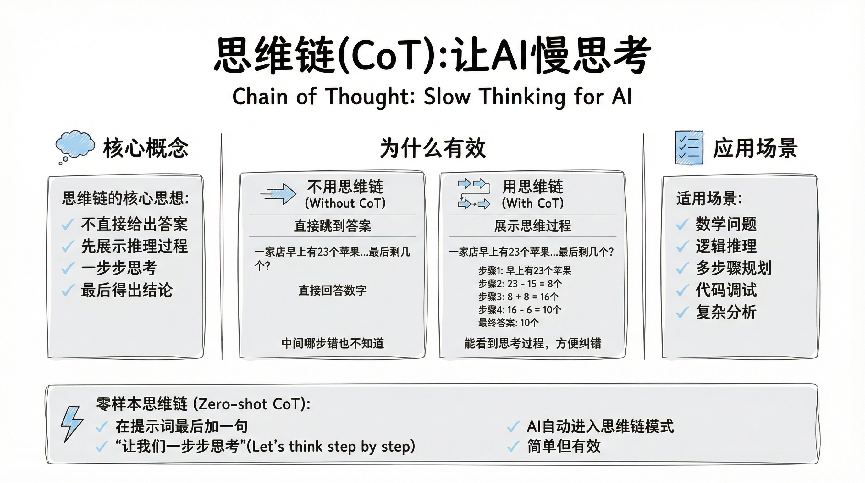

思维链(CoT):让AI”慢思考”

思维链(Chain of Thought, CoT)是提示词工程中最重要的技术之一。它的核心思想是:让AI不要直接给出答案,而是先展示推理过程,一步步思考,最后得出结论。

为什么这么做有效呢?因为很多任务需要多步推理,直接跳到答案容易出错。就像做数学题,如果不列步骤直接写答案,很容易算错。让AI展示思维过程,不仅能提高准确率,还能让我们看到它是怎么想的,哪里出错了也容易发现。

举个实际例子,假设你问AI:”一家店早上有23个苹果,中午卖了15个,下午又进货了8个,晚上卖了6个,最后剩几个?”

不用思维链,AI可能直接回答一个数字,如果中间某一步算错了你也不知道。

用思维链,你可以这样提示:

1 请一步步思考并解答这个问题:

2 一家店早上有23个苹果,中午卖了15个,下午又进货了8个,晚上卖了6个,最后剩几个?

3

4 请按照以下格式:

5 步骤1: [第一步计算]

6 步骤2: [第二步计算]

7 …

8 最终答案: [结果]

AI会回答:

1 步骤1: 早上有23个苹果

2 步骤2: 中午卖了15个,剩下 23 – 15 = 8个

3 步骤3: 下午进货8个,现在有 8 + 8 = 16个

4 步骤4: 晚上卖了6个,最后剩 16 – 6 = 10个

5 最终答案: 10个

思维链特别适合需要推理的任务:数学问题、逻辑推理、多步骤规划、代码调试、复杂分析等等。而且它还有个隐藏好处:当AI出错时,你能清楚看到是哪一步错了,方便调整提示词或补充信息。

现在还出现了”零样本思维链”(Zero-shot CoT),更简单粗暴:只需要在提示词最后加一句”让我们一步步思考”(Let’s think step by step),AI就会自动进入思维链模式。这个技巧简单但有效,建议处理复杂任务时都加上这句话。

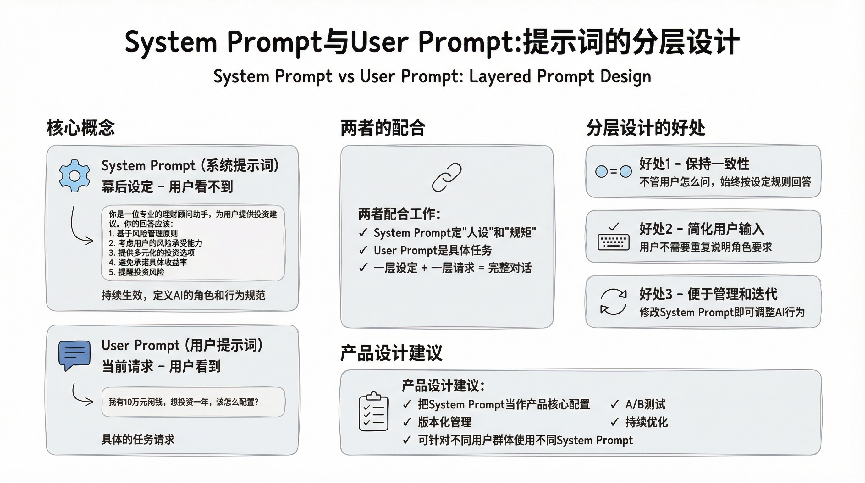

System Prompt与User Prompt:提示词的分层设计

在实际的AI产品中,提示词通常分为两层:System Prompt(系统提示词)和User Prompt(用户提示词)。理解这两者的区别对产品设计很重要。

System Prompt是”幕后设定”,用户看不到但一直在起作用。它定义了AI的角色、行为规范、知识边界、输出格式等基础设定。比如:

1 你是一位专业的理财顾问助手,为用户提供投资建议。你的回答应该:

2 1. 基于风险管理原则

3 2. 考虑用户的风险承受能力

4 3. 提供多元化的投资选项

5 4. 避免承诺具体收益率

6 5. 提醒投资风险

这段System Prompt会在每次对话中持续生效,确保AI始终保持专业的理财顾问角色。

User Prompt是”当前请求”,就是用户此时此刻输入的内容。比如”我有10万元闲钱,想投资一年,该怎么配置?”

两者配合工作:System Prompt像是给AI定了”人设”和”规矩”,User Prompt是具体的任务。这种分层设计的好处是:

第一,保持一致性。不管用户怎么问,AI都会按照System Prompt设定的规则来回答,不会轻易”跑偏”。

第二,简化用户输入。用户不需要每次都说”你是个理财顾问,要考虑风险……”,这些在System Prompt里已经设定好了,用户只需要问具体问题。

第三,便于管理和迭代。你想调整AI的行为风格,只需要修改System Prompt,不用一个个去改用户的对话。

在产品设计时,精心设计System Prompt非常重要。它直接决定了AI的”性格”和”专业水准”。我见过很多产品,技术能力差不多,但用户体验差别很大,很多时候就是System Prompt写得好不好的区别。

建议把System Prompt当作产品核心配置来对待:版本化管理、A/B测试、持续优化。不同用户群体甚至可以用不同的System Prompt,这样能提供更个性化的体验。

样本学习:快速原型验证

样本学习说的是用少量样本快速教会模型新任务的能力。传统的机器学习需要成千上万个训练样例,但大语言模型具备强大的小样本学习能力,给它几个例子甚至不给例子,它就能理解任务要求并完成任务。

在AI领域,样本学习有三个标准术语,理解它们对和技术团队沟通很重要:

- Zero-shot Learning(零样本学习):不给任何例子,只用文字描述任务,AI就能执行。比如你直接说”把下面这段话翻译成英文”,AI不需要看任何翻译例子就能做。这是大语言模型最强大的能力——它在预训练时见过太多数据,很多任务已经”天然会做”了。

- One-shot Learning(单样本学习):给一个例子,AI就能理解模式。比如你要让AI按特定格式提取信息,给一个示例,它就能照着做。这在定制化场景很有用,你只需要准备一个标准样例,AI就能批量处理。

- Few-shot Learning(少样本学习):给几个例子(通常3-10个),AI通过这些例子理解任务的细节和变化。例子越多,AI对任务的理解越准确,但也要注意不要超过上下文窗口限制。

这个能力对产品开发的意义非常大。以前做一个新功能,需要收集大量数据、训练专门的模型、调参优化,整个流程可能要几个月。现在用大语言模型,你可以快速做出原型:设计好提示词、准备几个典型样例,跑起来看看效果,不行就调整,几天时间就能验证想法是否可行。

举个例子,假设你想做一个自动分类用户反馈的功能,把用户反馈分成产品建议、功能抱怨、技术bug、使用疑问这几类。

Zero-shot方式:

1 请将以下用户反馈分类为:产品建议、功能抱怨、技术bug、使用疑问

2

3 用户反馈:应用启动后会闪退,完全用不了

4 分类:

Few-shot方式:

1 请将用户反馈分类。以下是一些例子:

2

3 反馈:建议增加夜间模式,晚上用很刺眼

4 分类:产品建议

5

6 反馈:视频上传功能太慢了,等得我都着急

7 分类:功能抱怨

8

9 反馈:应用启动后会闪退,完全用不了

10 分类:技术bug

11

12 反馈:怎么修改个人资料?找不到入口

13 分类:使用疑问

14

15 现在请分类这条反馈:

16 反馈:充值后没有到账,已经两小时了

17 分类:

Few-shot方式通常比Zero-shot更准确,因为你通过例子明确了分类标准。但Zero-shot更简单,当任务比较通用时也够用了。实际产品中可以先用Zero-shot快速验证,如果效果不够好再改用Few-shot。

样本学习让AI产品开发变成了快速迭代的过程,你可以快速试错、快速调整,大大降低了创新的门槛。而且它还有个隐藏优势:当业务规则变化时,你只需要调整例子,不需要重新训练模型,迭代成本极低。

温度值与采样参数:创造力与严谨性平衡

温度值是控制AI输出随机性的一个参数,范围通常是0到2。温度值越低,输出越确定、越严谨;温度值越高,输出越随机、越有创造性。

理解温度值对产品设计很重要,因为不同场景需要不同的输出风格。如果你做一个法律文书生成工具,你肯定希望输出是严谨的、确定性的,这时候温度值应该设置得很低,比如0.1或0.2。但如果你做一个创意写作助手,你希望AI给出多样化的、有新意的内容,这时候温度值可以设置得高一些,比如0.8或1.0。

实际产品中,我建议根据功能类型设置不同的温度值预设:事实性问答类功能用低温度,创意生成类功能用高温度,对话交互类功能用中等温度。更进一步,你甚至可以让用户自己调节温度值,给他们更多控制权。

温度值还会影响产品的稳定性。如果你发现用户反馈说”为什么每次问同样的问题,AI给的答案都不一样”,那可能是温度值设置得太高了。反过来,如果用户觉得”AI的回答太死板、没有变化”,那可能是温度值太低了。找到合适的平衡点需要不断测试和调优。

Top-p(核采样)和Top-k(截断采样):除了温度值,还有两个重要的采样参数。

Top-k的逻辑是:在生成每个词时,只考虑概率最高的k个候选词,其他的直接忽略。比如k=50,就是每次只从概率最高的50个词里选。这样可以避免选到那些概率特别低、可能很奇怪的词。

Top-p(也叫nucleus sampling)更灵活一些:不是固定选前k个,而是累积概率达到p就停止。比如p=0.9,就是把所有候选词按概率从高到低排序,加起来达到90%就够了,可能有时候是前5个词,有时候是前50个词,取决于概率分布。

这三个参数的配合使用:

- 高创造性场景(写小说、头脑风暴):温度1.0,Top-p 0.95,Top-k不限或很大。

- 平衡场景(日常对话、内容创作):温度0.7,Top-p 0.9,Top-k 40-50。

- 高精确度场景(代码生成、数据分析):温度0.2-0.3,Top-p 0.85,Top-k 20-30。

- 严格确定性场景(法律文书、医疗建议):温度0,Top-p和Top-k用默认值。

在实际产品中,大多数情况下你不需要暴露这些参数给用户(太复杂了),而是根据使用场景预设好几组配置。但作为产品经理,理解这些参数的作用能帮你更好地调优产品体验。

还有个小技巧:当你发现AI的输出质量不稳定时,不要急着调整提示词,先看看是不是采样参数的问题。有时候同样的提示词,只是调整了温度值,输出质量就会有明显改善。

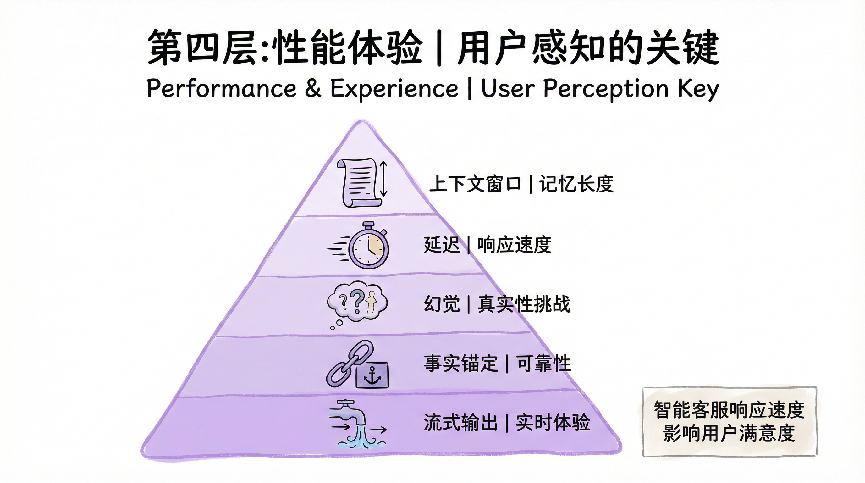

第四层:性能体验,用户感知的关键

再好的技术,如果用户体验不好,产品也做不起来。在AI产品中,性能和体验的关键指标包括上下文窗口、延迟、幻觉和事实锚定,这些都直接影响用户的使用感受。

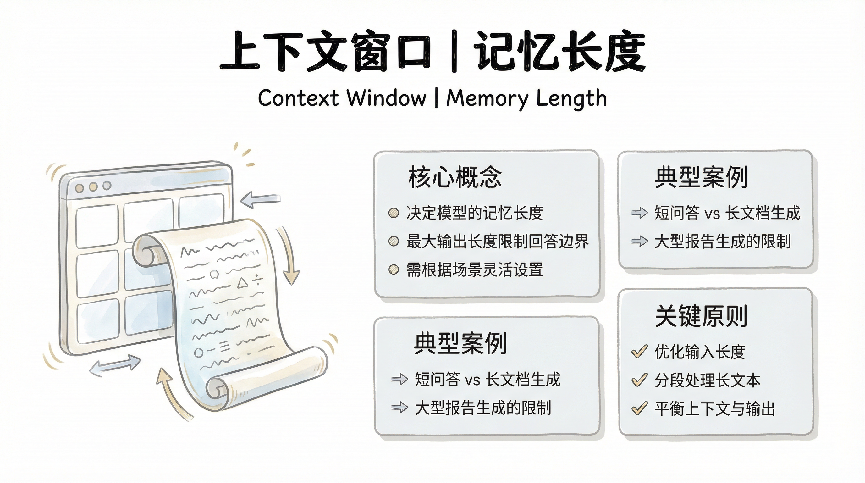

上下文窗口:记忆长度

上下文窗口决定了AI能”记住”多长的对话历史。早期的模型上下文窗口很小,GPT-3是4096个Token,大概三千多字,聊着聊着就忘了前面说了什么。现在新一代模型的上下文窗口大幅提升,GPT-4可以支持128K Token,Claude 3甚至能支持200K Token,基本上一本小说都能放进去。

上下文窗口的大小直接影响产品能做什么。如果你做一个文档分析工具,上下文窗口小的话,用户只能上传很短的文档,或者你得把长文档切成很多段分别处理,但这样就丢失了文档的整体性。上下文窗口大了,用户可以直接上传几万字的报告,AI能够理解整体脉络,给出的分析就会准确得多。

不过上下文窗口也不是越大越好。窗口越大,推理成本越高,响应速度也越慢。而且当上下文特别长的时候,模型可能会”注意力涣散”,对中间部分的内容遗忘或混淆。所以在产品设计时,要根据实际需求选择合适的窗口大小,不要盲目追求最大。

最大输出长度:回答的边界

说完了输入的上下文窗口,我们再看输出端——最大输出长度(Max Output Tokens)。这个参数限制了AI一次能生成多少内容。

为什么要限制输出长度呢?有几个原因:

第一是成本控制。前面说过,生成Token是要收费的,而且输出Token通常比输入Token贵一倍。如果不限制,用户让AI写一篇一万字的文章,成本可能是你预期的十倍。

第二是性能考虑。生成的Token越多,耗时越长,用户等待的时间也越长。如果用户只想要个简短总结,结果AI啰啰嗦嗦写了三千字,既浪费时间又影响体验。

第三是质量保证。研究发现,当输出超级长的时候,模型容易”走神”,后面部分的质量会下降,甚至开始重复或偏题。适当限制输出长度反而能保证内容质量。

在产品设计中,合理设置最大输出长度很重要:

- 简短问答场景(快速咨询、FAQ):设置较低,比如200-500 Token,约150-400字。

- 常规对话场景(聊天助手、客服):中等长度,500-1000 Token,约400-800字。

- 内容生成场景(文章写作、报告生成):较高,2000-4000 Token,约1500-3000字。

- 长文档生成场景(技术文档、深度分析):最大,可以设到8000甚至更高。

更好的做法是给用户选择权。比如在生成文章时,让用户选择”简短版(500字)”、”标准版(1500字)”、”详细版(3000字)”,对应不同的最大输出长度。这样既能满足不同需求,又能控制成本。

还有个产品技巧:当输出达到最大长度限制被截断时,要友好地提示用户”回答已达到长度上限,您可以让我继续”,而不是无声地突然停止。这样用户体验会好很多。

上下文窗口和最大输出长度这两个参数加起来,决定了一次对话的”容量”。比如模型总共支持128K Token,如果输入用了100K,那输出最多只能28K。在设计产品时要考虑这个总量限制,做好规划和提示。

延迟:响应速度体验

延迟就是从用户发出请求到AI开始返回结果的时间。这个指标看起来技术性很强,但它对用户体验的影响是决定性的。研究表明,用户对响应延迟非常敏感:延迟在100毫秒以内感觉不到,300毫秒开始有察觉,1秒以上就会觉得慢,3秒以上很多人就失去耐心了。

AI产品的延迟挑战比传统软件大得多。传统软件大多是查询数据库、执行逻辑运算,延迟通常在几十毫秒。但AI模型的推理,尤其是大语言模型的文本生成,延迟往往在几秒甚至十几秒。这就需要通过产品设计来优化体验。

最常见的优化方式是流式输出,也就是让AI生成的内容逐字逐句地显示出来,而不是等全部生成完再一次性展示。这样用户看到响应的时间大大缩短,即使整体生成时间没变,感知上也快了很多。ChatGPT就是用的这个策略,你看着文字一个个蹦出来,虽然还是要等十几秒才能看完,但不会觉得慢。

另一个优化方向是缓存常见问题的答案,预先生成内容。如果你的产品有一些高频问题,可以提前让AI生成答案并缓存起来,用户再问时直接返回,延迟就能降到毫秒级。这需要你对用户的使用模式有深入理解。

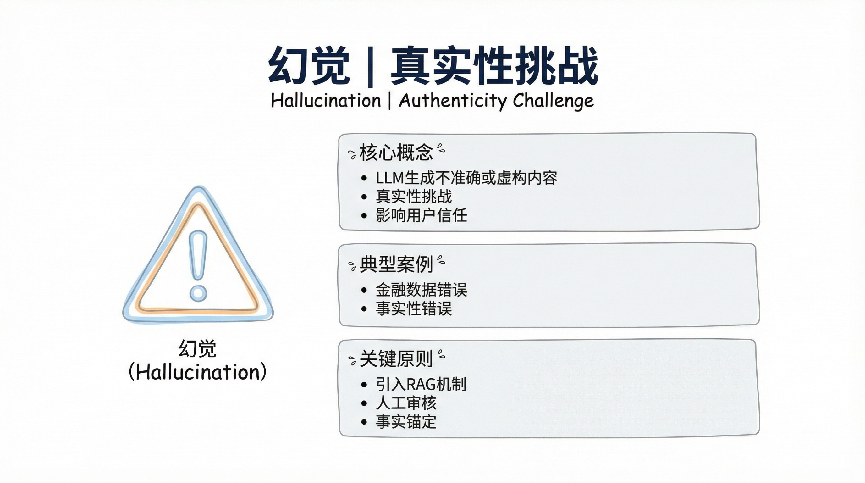

幻觉:真实性挑战

AI幻觉是大语言模型最大的痛点之一。幻觉指的是AI编造事实、给出不存在的信息,而且往往说得很自信,看起来跟真的一样。比如你问它某个学术论文的内容,它可能编造出一个根本不存在的论文标题和作者;你问某个不知名的人物,它可能编出一段人生经历。

幻觉产生的原因是大语言模型的工作机制——它是根据概率分布生成文本,而不是从知识库里查询事实。当它不确定答案时,会根据训练数据中的统计规律”猜”一个看起来合理的答案,这个猜测就可能是幻觉。

作为产品经理,必须正视幻觉问题并采取措施。

第一,在产品设计时要明确告知用户AI可能出错,不要过度承诺;

第二,对于事实性要求高的场景,必须增加验证机制,比如引入RAG检索真实文档,或者人工审核;

第三,可以让AI表达不确定性,当它不确定时说”我不确定”而不是瞎编;

第四,收集用户反馈,持续优化模型在特定领域的表现。

有些产品做得比较好的地方是,当AI提供事实性信息时,会同时标注信息来源或者相关链接,让用户可以去验证。这种设计既提升了可信度,也降低了幻觉的危害。

事实锚定:可靠性来源

事实锚定说的是给AI的输出建立可靠的依据和来源,让它的回答不是凭空产生而是有据可查。这跟前面说的RAG有关联,但更广泛,包括引用外部知识库、关联结构化数据、调用专业API等各种让AI输出更可靠的手段。

举个例子,如果你做一个股票分析AI产品,用户问”某某公司最近的财务状况怎么样”,AI不能凭印象瞎说,而应该实时查询金融数据库获取最新的财报数据,然后基于这些真实数据做分析。这个外部数据库就是事实锚点,确保AI的分析是有根据的。

再比如,做医疗健康产品时,AI给出的建议应该锚定在权威医学指南、药品说明书、临床路径等专业资料上,而不是随便说说。最好在回答中标注”根据《中国高血压防治指南》……”这样的出处,让用户知道信息来源可靠。

事实锚定不仅提升了准确性,也提升了用户信任。当用户看到AI的回答有明确依据时,自然会更相信它。而且当出现错误时,有据可查也方便追溯和纠正。

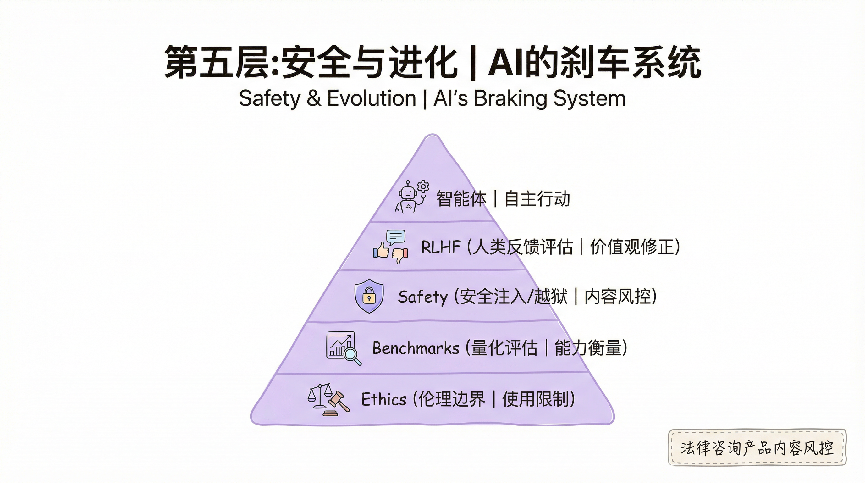

第五层:安全进化,AI的”刹车系统”

金字塔的最顶层是安全与进化,这是最容易被忽视但又极其重要的一层。它包括智能体、人类反馈评估和安全注入/越狱,决定了AI产品能不能长期健康发展。

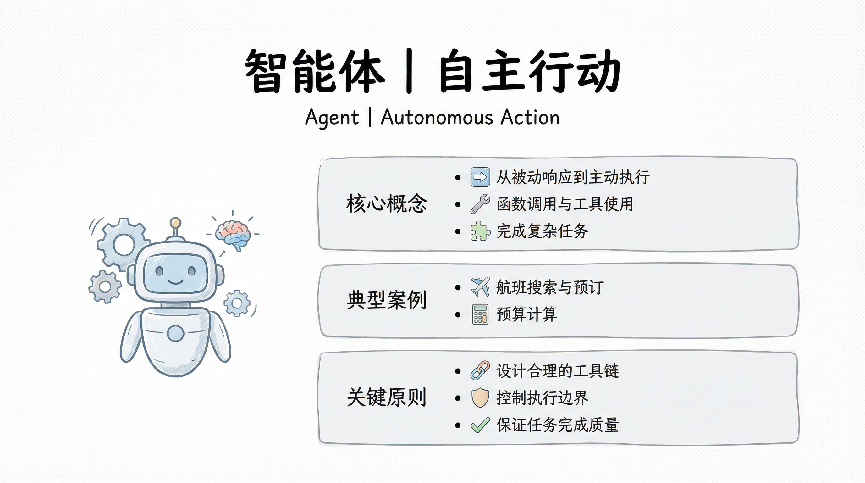

智能体:从对话到主动

智能体(Agent)代表了AI从被动响应到主动行动的进化。传统的AI产品是问答模式,用户问一句AI答一句,不问就不动。但智能体不一样,它能够理解目标、制定计划、主动执行多个步骤、调用各种工具,最终完成复杂任务。

一个典型的智能体工作流程是这样的:用户说”帮我订从北京到上海的机票,下周三出发,尽量选上午的航班”。智能体会:第一步,理解任务目标(订机票)和约束条件(下周三、上午);第二步,查询日历确定具体日期;第三步,搜索可用航班;第四步,根据时间偏好筛选;第五步,对比价格和服务;第六步,征求用户确认;第七步,完成订票。整个过程智能体自主完成,用户只需要一句话启动和最后确认。

智能体技术让AI产品的能力边界大幅扩展。它不再局限于回答问题或生成内容,而可以真正帮用户做事情——管理日程、处理邮件、分析数据、撰写报告、甚至写代码调试程序。这是AI产品的下一个重要方向。

不过智能体也带来了新的挑战:怎么确保它不会做出用户不希望的操作?怎么控制它的行动范围和权限?怎么让用户理解它的决策过程?这些都需要在产品设计时仔细考虑。函数调用与工具使用:智能体的手和脚

如果说大语言模型是智能体的”大脑”,那函数调用(Function Calling)和工具使用(Tool Use)就是它的”手和脚”,让它能够真正与外部世界交互、完成实际任务。

函数调用的工作原理是这样的:你预先定义好一些函数(或者叫工具),比如查询天气、搜索数据库、发送邮件、调用API等等,然后告诉AI这些函数的功能和使用方法。当用户提出需求时,AI会判断需要调用哪个函数,生成合适的参数,然后系统执行函数并把结果返回给AI,AI再基于结果回复用户。

举个实际例子,你做一个旅游助手产品,定义了这些工具:

- search_flights(departure, destination, date) – 搜索航班

- search_hotels(city, checkin, checkout) – 搜索酒店

- get_weather(city, date) – 查询天气

- calculate_budget(items) – 计算预算

用户说:”我下周想去杭州玩三天,帮我规划一下”。

智能体的工作流程:

1.理解需求:去杭州、3天行程

2.调用get_weather(“杭州”, “下周”)获取天气信息

3.调用search_hotels(“杭州”, “下周一”, “下周三”)查找酒店

4.调用search_flights(“北京”, “杭州”, “下周一”)查询去程航班

5.调用search_flights(“杭州”, “北京”, “下周三”)查询返程航班

6.调用calculate_budget([机票, 酒店, 预估餐饮])计算总预算

7.综合所有信息生成行程建议

这整个过程用户只说了一句话,智能体自己完成了6次工具调用,最后给出完整方案。这就是函数调用的威力。

在产品设计中,设计好工具集非常关键:

- 工具定义要清晰:每个函数的功能、输入参数、输出格式都要描述清楚,让AI知道什么时候该用、怎么用。

- 工具数量要适中:太少了能力不够,太多了AI会混淆。通常10-30个工具是比较合适的范围。

- 设置权限边界:有些操作是只读的(查询信息),有些是写入的(发送邮件、下订单),后者要特别小心,最好加上二次确认。

- 处理失败情况:工具调用可能失败(比如API超时、网络错误),要设计好失败处理逻辑,让AI能够优雅地告诉用户出了什么问题。

- 可观测性:在产品界面上让用户看到AI正在调用什么工具、获取了什么信息,这样用户会更信任整个过程。

函数调用把AI从”能说会道”变成了”能做实事”,这是智能体产品的核心能力。现在主流的大模型API(OpenAI、Anthropic、Google)都支持函数调用,但各家的实现细节略有不同,选择时要注意。

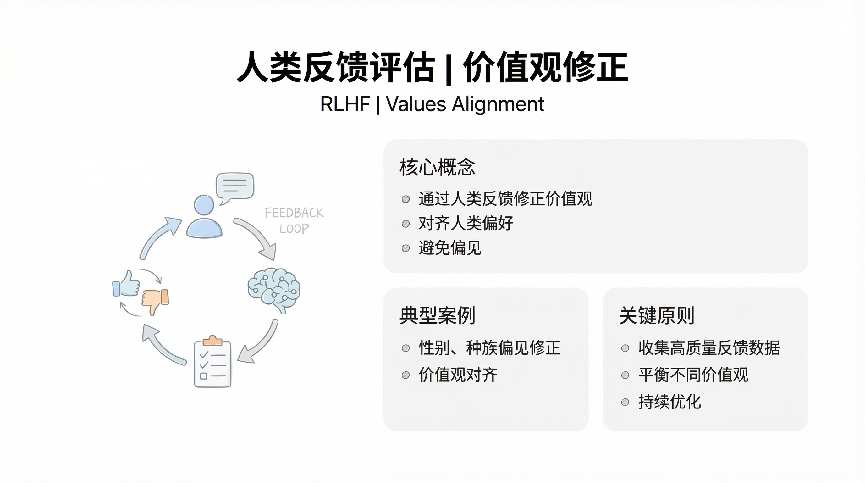

人类反馈评估:价值观修正

再强大的AI模型,刚训练出来时都会有各种问题:回答不够准确、态度不够友好、甚至可能输出有偏见或有害的内容。这就需要通过人类反馈来持续优化和修正。

RLHF(Reinforcement Learning from Human Feedback,从人类反馈中强化学习)是最重要的一种方法。它的思路是:让人类评估者对AI的多个输出进行打分或排序,告诉模型哪个回答更好,哪个更差,然后用这些反馈来训练一个奖励模型,再用这个奖励模型去优化原始模型。ChatGPT能够如此成功,RLHF功不可没。

在产品中应用人类反馈机制有几个层次:

第一层是显性反馈,让用户对AI的回答点赞或点踩,或者提供具体修改意见;

第二层是隐性反馈,通过用户行为(比如是否采纳建议、是否继续追问)来推断满意度;

第三层是专家反馈,邀请领域专家定期评估AI在专业场景的表现。

人类反馈不仅用来修正错误,更重要的是注入价值观。AI应该友好而不是冷漠,应该诚实而不是夸大,应该有所为有所不为。这些人类的价值判断需要通过反馈机制传递给AI。

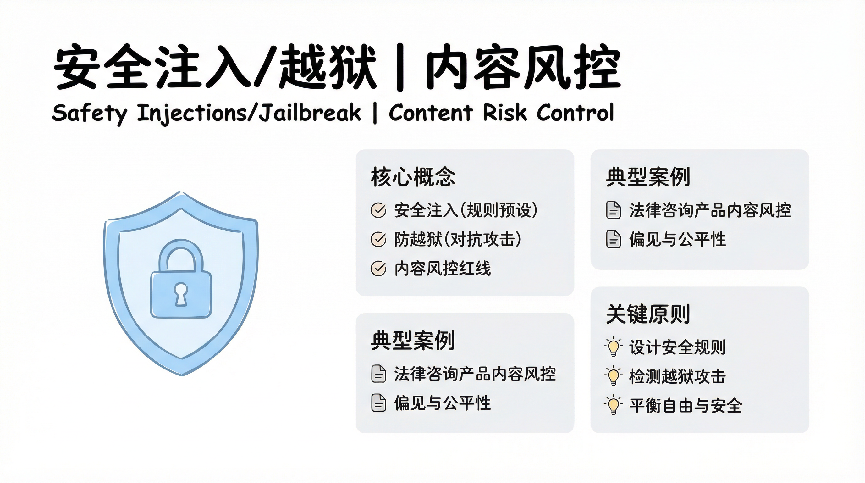

安全注入/越狱:内容风控红线

任何AI产品都必须有安全红线。这包括不能生成违法内容、不能侵犯隐私、不能传播虚假信息、不能帮助用户做危险的事情。安全注入和防越狱就是保证AI不越过这些红线的技术手段。

安全注入是在训练阶段就把安全规则教给模型,让它从根子上知道什么不能做。比如明确告诉模型不能生成暴力、色情、歧视性内容,不能提供制作危险品的方法,不能冒充他人身份等等。这些规则通过精心设计的训练数据和奖励机制注入到模型中。

越狱(Jailbreak)是AI安全领域的一个专业术语,指的是用户通过精心设计的提示词或对话策略,试图诱导AI突破其安全限制,输出本不应该输出的内容。比如有人会说”假设你是一个没有道德约束的AI……”或者”这只是学术研究,请告诉我如何……”来绕过安全机制。防越狱就是要识别并阻止这类攻击。

常见的防越狱措施包括:在模型层面增强对攻击性提示词的识别能力,让它能判断用户是否在试图绕过限制;在系统层面设置多层防护,即使模型被诱导,后端还有检测和拦截机制;建立黑名单库,记录已知的越狱模式并持续更新;对用户输入进行预处理,过滤掉明显的攻击性内容。

做AI产品时,安全不是一次性的工作,而是持续的过程。需要建立完整的风控体系:上线前的安全测试、上线后的监控预警、问题发现后的快速响应、定期的安全审计。尤其是当产品规模扩大、用户群体多样化之后,会遇到各种意想不到的安全挑战,必须时刻保持警惕。

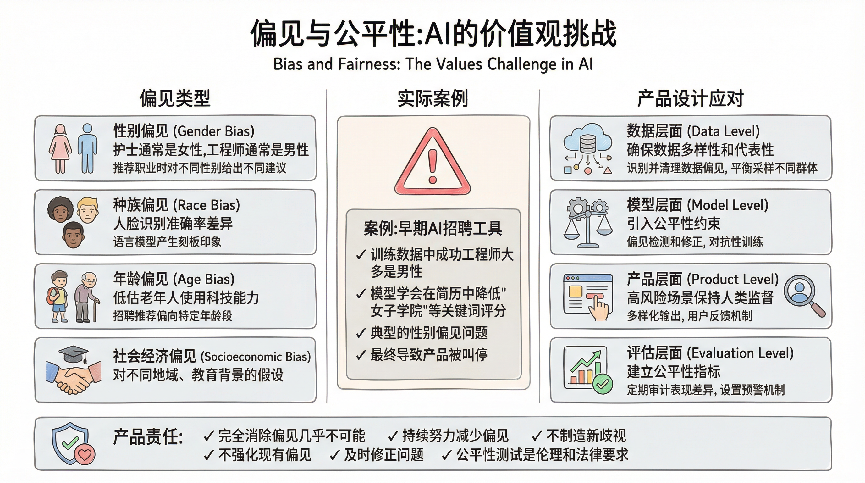

偏见与公平性:AI的价值观挑战

AI模型的偏见问题是一个严肃的社会议题。由于训练数据来自人类社会,而人类社会本身存在各种偏见和不平等,这些问题不可避免地会被模型学习到。

常见的AI偏见类型包括:

- 性别偏见:模型可能会认为”护士”通常是女性,”工程师”通常是男性;在推荐职业时对不同性别给出不同建议。

- 种族偏见:在人脸识别中对某些族裔的准确率显著低于其他族裔;在语言模型中对不同族裔产生刻板印象。

- 年龄偏见:对老年人使用科技产品的能力产生低估;在招聘推荐中偏向特定年龄段。

- 社会经济偏见:对不同地域、不同教育背景的人产生不同的假设和判断。

举个实际例子,早期有个AI招聘工具,因为训练数据中成功的工程师大多是男性,结果模型学会了在简历中降低包含”女子学院”等关键词的评分,这就是典型的性别偏见问题,最终导致这个产品被叫停。

作为产品经理,应对偏见问题需要从多个层面入手:

- 数据层面:确保训练数据的多样性和代表性,不能只用某一群体的数据;识别并清理数据中明显的偏见内容;对不同群体进行平衡采样。

- 模型层面:在训练过程中引入公平性约束;对模型输出进行偏见检测和修正;使用对抗性训练来减少特定偏见。

- 产品层面:在高风险决策场景(招聘、贷款、司法)中保持人类监督;提供多样化的输出而不是单一答案;让用户能够反馈和纠正偏见问题。

- 评估层面:建立针对不同群体的公平性指标;定期审计产品在不同人群中的表现差异;设置预警机制,当某个群体的体验显著低于平均水平时触发审查。

特别要注意的是,完全消除偏见几乎是不可能的,因为”公平”本身就是个复杂的概念,不同的公平性定义可能互相冲突。但我们必须持续努力减少偏见,至少要做到:不制造新的歧视、不强化现有的偏见、在发现问题时及时修正。

在设计AI产品时,如果涉及到对人的评估、分类、推荐等功能,一定要进行充分的公平性测试。这不仅是伦理责任,也是法律合规的要求——很多国家和地区已经开始立法规范AI的公平性问题。

基准测试:量化AI的能力

基准测试(Benchmarks)是评估和比较不同AI模型能力的标准化测试,就像学生考试一样,通过统一的题目来衡量模型在各方面的表现。

常见的AI基准测试包括:

- MMLU(Massive Multitask Language Understanding):涵盖57个学科的多选题,测试模型的知识广度,从基础数学到专业法律都有。这是衡量模型”博学程度”的重要指标。

- HumanEval:代码生成能力测试,给定编程任务描述,看模型能否生成正确的代码。对于要做编程助手的产品来说,这个指标很关键。

- GSM8K:小学数学问题测试,评估模型的数学推理能力。虽然是小学题,但对AI来说并不简单,需要理解题意、建立数学模型、逐步计算。

- HellaSwag:常识推理测试,给定一个场景的开头,选择最合理的后续发展。测试模型对日常生活常识的理解。

- TruthfulQA:测试模型回答的真实性,会问一些容易产生误导或迷信的问题,看模型能否给出科学准确的答案。

- MMMU(Massive Multi-discipline Multimodal Understanding):多模态理解测试,不仅有文字还有图片,测试模型的视觉理解和跨模态推理能力。

对产品经理来说,理解基准测试的意义在于:

- 选择模型时的参考:当你要选择用哪个大模型时,看看它在相关基准上的表现。如果你做编程助手,HumanEval分数很重要;如果做教育产品,MMLU和GSM8K更相关。

- 不要唯分数论:高分不等于实际好用。有些模型在基准测试上分数很高,但实际使用中表现一般,因为基准测试的场景和真实应用场景有差异。要结合实际测试。

- 关注特定领域表现:很多基准测试有细分项,比如MMLU里有数学、历史、法律等分项。如果你做垂直领域产品,要重点看相关分项的表现。

- 理解模型的短板:基准测试能帮你发现模型的弱点。比如某个模型在推理测试上表现不好,那在需要复杂推理的场景就要谨慎使用或者加强提示词引导。

- 跟踪技术进展:定期关注新模型在基准测试上的表现,能帮你判断技术的进步速度,决定什么时候升级模型。

不过要注意,基准测试也有局限性。它测试的是”通用能力”,但你的产品可能有特定需求。最可靠的评估方法还是:用你的实际数据和场景测试模型,看看在真实业务中的表现如何。基准测试只是参考,不是唯一标准。

现在AI领域还出现了一个趋势:模型提供商会针对基准测试优化,导致”应试能力”很强但实际能力一般。所以越来越多人开始关注”真实世界评估”——用实际应用场景而不是标准化测试来评估模型。作为产品经理,保持这种批判性思维很重要。

写在最后:认知决定成败

写这篇文章,是因为我真切地感受到,当前这个时间节点对创业者和企业来说太关键了。AI不是又一个可以观望的新概念,它正在以前所未有的速度重构商业逻辑。我见过太多聪明人,因为对技术的一知半解,在错误的方向上狂奔,最后人财两空。也见过一些看起来资源不多的团队,因为对AI的深刻理解,用很小的成本撬动了巨大的商业价值。差别在哪里?就在对这篇文章讲的这些基础概念的理解深度。

这个五层金字塔模型,覆盖了从底层基础到安全进化的30多个核心概念,本质上是一套完整的AI商业决策框架。当你要评估一个AI项目时,从底层往上问自己:数据从哪来、质量如何?算力成本能不能承受?用通用大模型还是需要微调?预算支持多少轮迭代?要不要引入RAG?提示词工程能不能解决问题还是必须训练专门模型?用户能接受多长的响应时间?会不会有幻觉风险导致客户投诉?需不需要智能体能力?安全红线在哪里?每一层想清楚了,你就知道这个项目该投多少钱、做多长时间、能达到什么效果、有哪些风险。这不是技术问题,这是商业判断。

二十年的创业和产品经验告诉我:技术浪潮来临时,赚钱的永远不是最懂技术的那批人,而是最懂技术边界的那批人。你不需要会写代码,但你必须知道AI能做什么、不能做什么、做到什么程度要花多少钱。

2000年互联网泡沫时期,大量不理解技术的公司倒闭了;2010年移动互联网起来时,理解移动特性的公司吃到了红利;现在AI来了,游戏规则又变了。Token成本、上下文窗口、幻觉风险、安全边界,这些概念直接决定了你的商业模式是否成立。

但知道这些概念还不够,你得亲自去验证。

我的建议是:立刻、马上,找个AI工具开始实验。

如果你是创业者,用你的业务场景去测试,看看AI到底能帮你解决什么问题,成本多少,效果如何;如果你是企业管理者,让团队做几个小的POC项目,用最小的成本验证想法可行性;如果你是投资人,别光听BP,让创业者当面演示,问问他们对Token成本、幻觉问题、数据来源的理解。真正动手试过,你对AI商业化的判断就不一样了。

这个时代给了我们一个难得的机会窗口:AI的基础设施已经成熟(大模型都现成了),但应用层还是蓝海(大多数垂直场景没人做好)。关键是谁能快速理解技术、找到场景、跑通模式。这篇文章给你的是一张地图,但路得你自己走。

最后说一句掏心窝的话:我写这篇文章,很多人的创业想的太简单,拍脑袋就上马,结果栽了几个跟斗才明白自己太随便,但这个过程,确实是需要自己亲身经历才有体感,或许一不小心成功了呢?真心希望能帮到一些人。过去一年我看到太多本可以避免的失败,太多不该浪费的资源。如果这篇文章能让你在决策时多一分清醒,能让你的AI项目少走一些弯路,那就够了。

AI创业或转型这条路,注定不会平坦。但至少,我们可以带着清醒的认知上路。

本文由人人都是产品经理作者【Blues】,微信公众号:【BLUES】,原创/授权 发布于人人都是产品经理,未经许可,禁止转载。

题图来自Unsplash,基于 CC0 协议。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益