拨云见日:与智能体共建意图

智能体正在从工具向伙伴进化,但当前的交互方式仍停留在老虎机式的问答循环。当模糊意图遇上狭窄输入框,我们被迫压缩真实需求,智能体则用大而全的通用答案应付。本文深度剖析了意图共建(Intent Co-construction)的交互革命——如何通过多模态洞察、隐喻化呈现和渐进式记忆,让AI真正成为能读懂弦外之音、激发深层思考的对话伙伴。

当我们把内心模糊的想法告诉智能体时,期待的是意料之内的标准答案,还是预期之外的惊喜?

随着智能体能力以惊人的速度在进化,我们对智能体“善解人意”的期望越来越高,但结果往往事与愿违。如果问题是模糊抽象的,通常也只能得到大而全的通用答案。于是我们陷入反复追问、修正的循环,伴随着大量的努力和挫败感之后勉强得到一个符合预期的结果。

这是人与智能体之间非常主流的交互方式之一,但这是我们想要的未来吗?

真正的共鸣往往潜藏在棋逢对手的对话之中。相比于你问我答就结束的方式,我们和伙伴留下深刻印象的交流,更多的时候不是要立刻得出答案,而是在一来一回的反问、确认和启发中,慢慢浮现出水面下真正的意图。

如果智能体要从“工具”跃升为“伙伴”,不妨重新想象一下,它仅仅是有问必答,还是能真正陪伴我们探索,激发我们思考,最终帮助我们发现和抵达自己真正内心深处的意图?

01 速度≠理解

意识朦胧的早晨,你刚刚给家人编辑好一段早上的问候,手指下意识地落到了“发送”按钮,轻轻一点,成功发送。这个再自然不过的动作,如果回到几十年前会怎么样?

你可能得先在屏幕上小心翼翼地敲击一行行代码,错一个字母或多一个空格,计算机就会用难懂的乱码“指责”你。

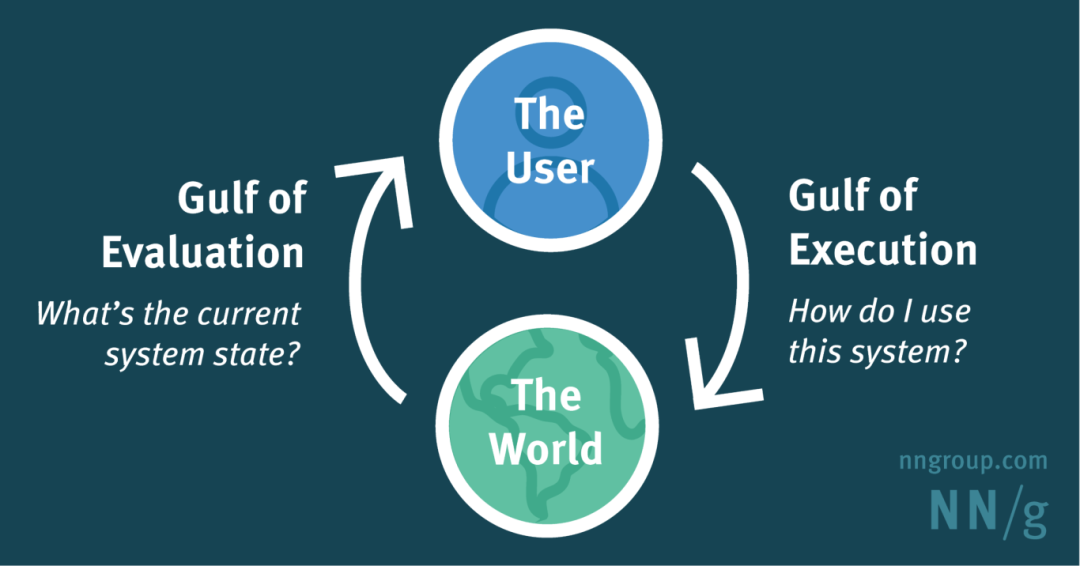

本质上这两种体验的差别,是在人类的模糊意图和计算机精确指令之间的“翻译”难题。早在上世纪80年代唐纳德·诺曼(Don Norman)就将这个难题具体化为了两道鸿沟:从我们脑中想法到机器指令有一道“执行的鸿沟”,从机器反馈到我们理解结果之间还有一道“评估的鸿沟”。

鸿沟越小,意图的传达和结果的理解就会变得更顺畅。从文本命令行(CLI)到图形用户界面(GUI),人机交互领域几十年来的努力都在大幅缩小这两道鸿沟。

“执行的鸿沟”和“评估的鸿沟”:用户与任何设备成功交互必须克服的两大挑战

集成了智能体的各个应用也在遵循这条路径。不断把执行的门槛降到最低,让我们更快给智能体传达自己想说的。但这种快,是否意味着我们的意图真的被清晰传达到了?

02 智能体在帮我们更好地探索吗?

“荷兰的首都是哪里?”

“荷兰的首都是阿姆斯特丹,但荷兰的政府机构、中央部门、议会和外国使馆都设在海牙…”

“生成一个计时器 Demo,要能直接使用。”

“好的,这个 Python 脚本实现了一个简单的倒计时器,用户可以输入秒数,然后程序会进行倒计时,并在结束时打印消息…”

的确,在做总结文章、文字翻译、初级数学计算这类意图清晰、目标明确、上下文需求低的任务时,智能体能准确且及时地提供答案。但如果面对现实生活中更复杂一点的任务,是不是还能保持这么高效呢?

无懈可击,但毫无用处

“帮我规划一次让全家人都能开心的日本旅行。”

“好的,为您规划一次让全家人都能享受的日本旅行,以下是一些建议,您可以根据实际情况进行调整。春季(3-5月)和秋季(9-11月)天气温和,是较适合亲子旅行的季节。根据家庭成员的假期来确定旅行天数。如果计划在多个城市间移动,可以考虑购买 Japan Rail Pass,但需根据具体行程计算是否划算…”

和智能体的交流似乎没有执行层面的鸿沟,你并没有在“怎么发送”的任务上遇到任何困难,智能体也能及时根据问题提供标准方案,但这对我们来说有多少价值?

父母想要悠闲地泡温泉,孩子渴望去环球影城,伴侣则期待更小众、独特的文化体验…每个人对于这趟旅行的期待都不一样,然而智能体给出的回答似乎没法这些诉求。但我们为什么在一开始没有把这些细节一起提供给智能体?

老虎机式的对话陷阱

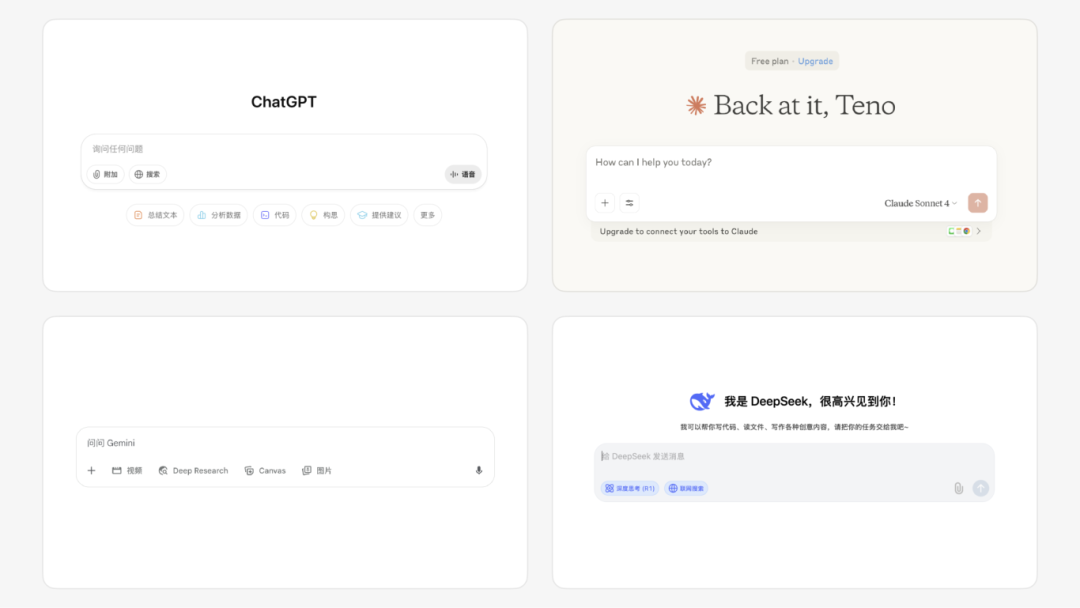

当我们带着这些模糊的复杂问题求助于智能体时,99%的情况下都绕不开输入框,这是当前我们与AI或智能体最主流的交互方式之一。这种简洁高效的模式最初是 ChatGPT 希望让人们以最直接的方式,体验大语言模型所带来的革命性突破。

主流与 AI 的交互方式几乎都是以纯输入框为主体

然而,要把自己记忆中大家的期望偏好,全家的预算等等细节内容一下子都塞进这个细窄输入框,还要不停反复编辑修改…太累了。

“先不搞这么麻烦,删掉一些好了。”

大脑天生喜欢走捷径,为了快点说出自己的模糊想法,就会下意识地省略掉那些三言两语无法说清的背景、偏好和其他维度的细节,强行压缩成“让家人开心”这几个贫瘠的文字扔进输入框,将期望高度依赖于智能体的能力。

接下来像赌徒一样拉下控制杆,祈祷碰上一个猜中心思的好结果。智能体为了在少得可怜的上下文里提高“中奖率”,只能炫技式地调用各种工具,输出大而全的通用答案。

结果我们并没有得到有助于启发思考的向导,而是一堆未经消化的倾泻式信息。这种互动方式变得越来越像老虎机一样,充满了各种不确定的结果。这在无形中不断加重我们的认知负担,让我们离探索真正的问题越来越远。

即使智能体的能力已经进化到可以处理高维、模糊、充满探索性的任务,和智能体交流的方式,仍然是我们自己都不擅长用来表达复杂思想的低维通道。

“当参与者要求 ChatGPT 生成一条社交媒体帖子时, ChatGPT 的输出太长了。她不得不要求它缩短长度。她说:‘通常它根本不听我的,还是太长,所以我一直说缩短那个缩短那个,直到缩减到 280 个字符。’ ”

—— 来源:《早期生成式人工智能用户行为》

别再猜了,先想想真正的问题

我们现在回头来看最初的想法,如果要真正规划一次让家人都开心的旅行,如果不问智能体,我们通常会怎么做?也许是对自己不知道的事情反复思考、查询、假设等等一系列探索性的行为,希望在大家不同的需求之间规划出都能接受的旅行方案。

没有清晰的指令,没有明确的执行,模糊又混乱的挑战才是我们的日常。无论是安排一次家庭旅行,还是启动一个新的工作项目,我们最常面对的棘手问题往往是如何从模糊的冲动,转变为明确有价值的目标。

所以我们应该怎么做,才让智能体帮我们更好地探索那些模糊又脆弱的冲动,建立更连贯自然的交流,而不是一次次地反复猜谜?

“不要容忍随意和偶然。设计的逻辑性和精确性,最终都是表达对用户的尊重。”

—— 迪特·拉姆斯

03 像伙伴一样:意图共建式交互

“这盆花是不是要换个位置摆好看点?”

“怎么了,为什么突然想换个位置?我以为你挺喜欢现在这样的。”

“也不是不喜欢…最近总觉得看哪里都不太顺眼,想给自己换个心情。”

…

我们和自己的朋友、恋人、家人等等交流探讨话题时,并不会期待对方立刻给出一个标准答案,而往往会从一个模糊的初始意图或者冲动开始。

对方可能会顺着你的话说:“那我们试试窗边?阳光好可能长得更茂盛。”也可能更深一层探寻我们背后的动机:“最近是不是有点累?我感觉你想换的不是花的位置,是想给生活找点新的感觉。”

人和人的交流是一个动态、充满探索的过程。这个过程不仅仅是简单的信息传递,而是两个人一起把模糊的想法,通过你一言我一语的互动,共同发现、打磨、甚至塑造出了最初没想到的新大陆。

这是一种意图共建(Intent Co-construction)的过程。

随着人与智能体的关系从“工具”向“伙伴”演进,我们向智能体倾诉越来越多模糊的意图。为了应对这种需求趋势的转变,我们应该如何借鉴伙伴之间交流的模式,设计人与智能体之间深度连接和共建意图的交互方式?

Anthropic 的官方介绍:遇见 Claude,你的思考伙伴

洞察言外之意的多模态

一个阳光正好的周末,开着车窗,车里放着喜欢的歌手专辑,驶向一直想去的新公园玩。

我们在车上跟语音助手说想去的地方,助手迅速在屏幕上列出三条路线,用不同颜色标注了时间和拥堵情况,还贴心地推荐了从算法上看最快到达的那一条。

但当我们下意识选择这条路开到一半后,发现不太对劲。

尽管物理上来说是最短的距离,但是这条路线需要频繁变道,路窄得刚好只能通过一辆车,两旁是随时可能打开的车门和突然窜出的小孩。我们的精神一直高度紧张,握着方向盘的手心开始出汗,开的时候还在不断抱怨路窄人多,最后差点撞上了前面的电单车。

但是导航仍然不为所动,坚持最开始选择的那条路线。

的确,现在我们能通过多模态的方式更明确传递指令给智能助手。但是当没办法一次性表达完整时,产生的也是通用解决方案。

“如果用户一直觉得这条线路太复杂难走,要不要换成距离比较长但是更好走的选择?”

“他一直在骂脏话,而且检测到经常急刹急停,是不是因为道路的复杂程度是用户难以驾驭的?”

…

真正的挑战在于,不仅仅要关注用户在说什么,还要结合用户是怎么说的,主动关注周围各个环境的变化,动态洞察。打字时的一气呵成还是频繁删改?圈出数据点时果断还是犹豫…这些下意识信号往往代表我们最真实的想法。

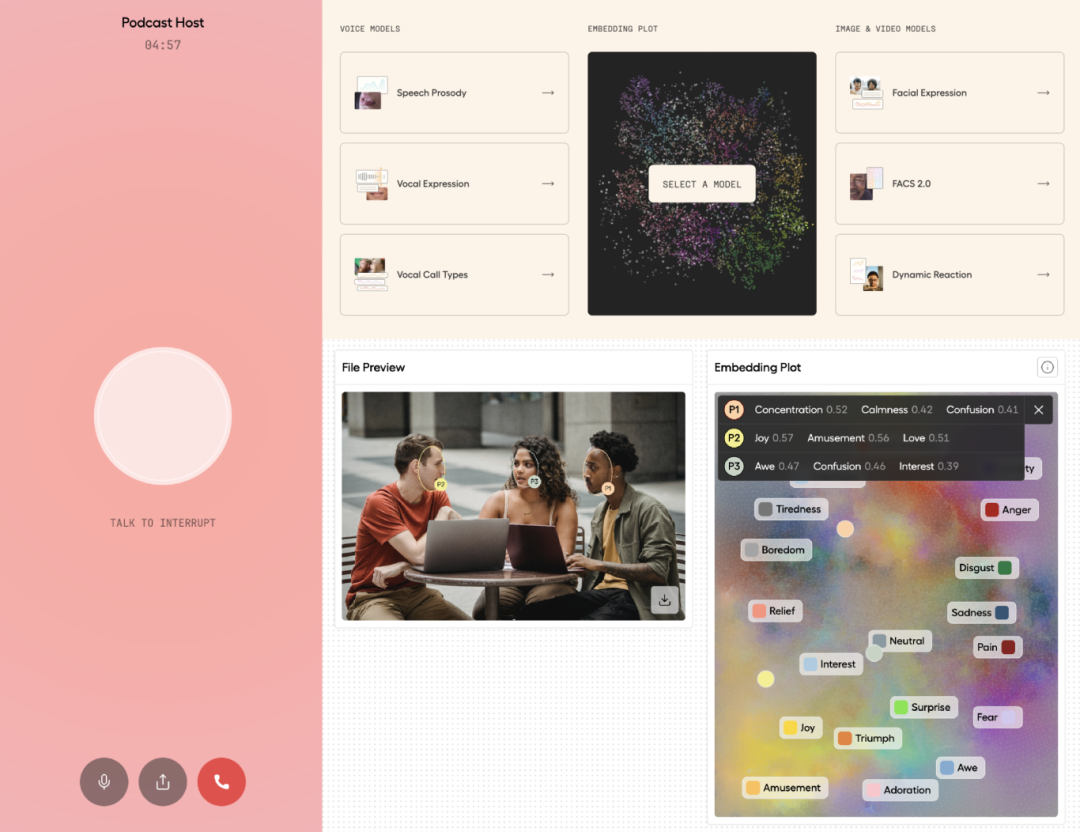

Hume AI(2025)基于语音或图像等多模态分析识别对方情绪,给出深思熟虑的回答

我们需要的智能体,不单单是同时处理文本、语音、图像、视频、手势等多种信息通道的能力,而是一个在确保隐私的前提下,能从多模态信号的不匹配中,敏锐持续解读出我们弦外之音的伙伴。

“要设计最佳用户体验,关注用户的行为,而不是他们的言论。用户的自我陈述不可靠,用户对未来行为的猜测也不可靠。用户并不知道自己想要什么。”

—— 雅各布·尼尔森

现在我们不妨再往前想一步。假设通过多模态的捕捉,智能体已经完全理解了我们的真实意图。但如果它只是将一个看似完美的答案像数据报告一样丢给我们,这种方式是不是真的利于我们吸收?

信息是流动的“过程”

现在我们试着倒带,重新去一次新公园那段路。这次的导航助手从智能体换成了坐在副驾,活生生的朋友。开到一半的时候,我们又遇到了那条算法的推荐路线,看着窄小的巷子下意识紧张了起来,朋友立刻就察觉到了,全程带着我们路过各种挑战:

“这条路很难走,我带你走另一条。”

“过了前面那个咖啡店右转。”

“我们快到了,路边开始有拿着野餐垫的人了。”

…

整个过程很顺利,但是我们发现,其实朋友提供的信息并不一定比语音助手多,但朋友能及时根据不同的场景,通过让我们理解的方式提供当下最需要的关键信息。

同样,智能体输出的信息维度多种多样,文本也绝不是唯一的承载方式。我们试着回想最近一次印象深刻的对话,它之所以难忘,也许是因为像词典一样的庞大信息量。但更多时候是因为我们被讲述方式所吸引,让我们脑子里“有画面”了,这种感觉其实就是一种隐喻。

“好的隐喻不是解释,而是创造新的理解,启发我们与观点互动的方式。”

—— 来源:《The secret of good metaphors》

文件看起来像纸张,文件目录看起来像文件夹,计算器、记事本、闹钟…早在上世纪,个人计算机就基于人们熟悉的物理元素,通过图形隐喻的方式把陌生又复杂的命令行巧妙地融入了日常生活。

Apple Lisa II 截屏(1984)桌面上的图标,菜单栏,图形面板等大幅降低了个人计算机的操作门槛

隐喻的目的在于恰当地唤醒人过往的经验,与另一个看似无关的事物巧妙联结,帮助理解。那它和智能体的输出有什么关系?

可以试想一下,通常当我们想通过智能体深入了解一个疑惑的时候会怎么做。也许是直接询问,也许是让智能体搜索整合各个来源的行业报告或者论文,或者我们事先网罗好一连串的资料给智能体帮我们提炼总结。

尽管智能体已经很努力了,但是我们每次点开结果看到满屏的文字,也会下意识感到不少理解的压力。

我们不知道智能体思考过程是怎么样的,不知道我想到的它想到没有,我们应该从哪里开始理解…我们真正需要的,不仅仅是一个结果,而是像好朋友在跟你娓娓道来他的想法一样,让信息变成共同探索答案的启发式过程。

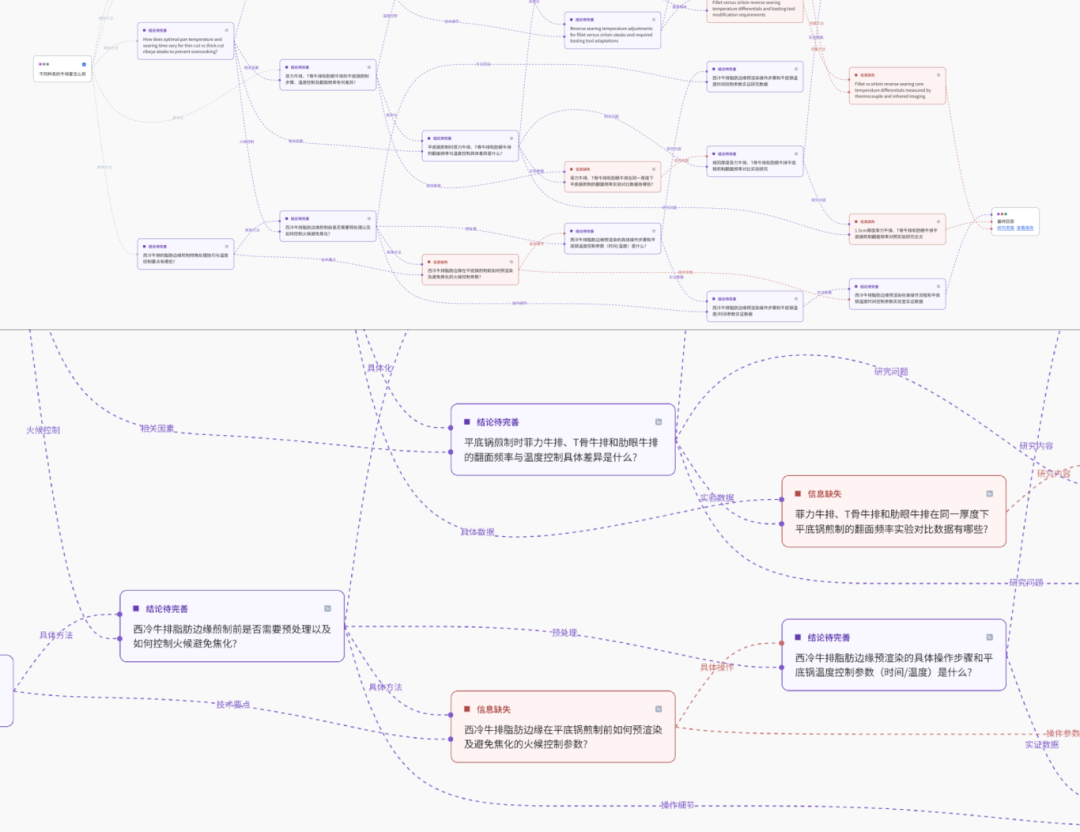

秘塔 AI(2025)根据问题在画布中实时可视化智能体的全思考过程

但即使清楚了思考过程,最终答案还是非常晦涩怎么办?

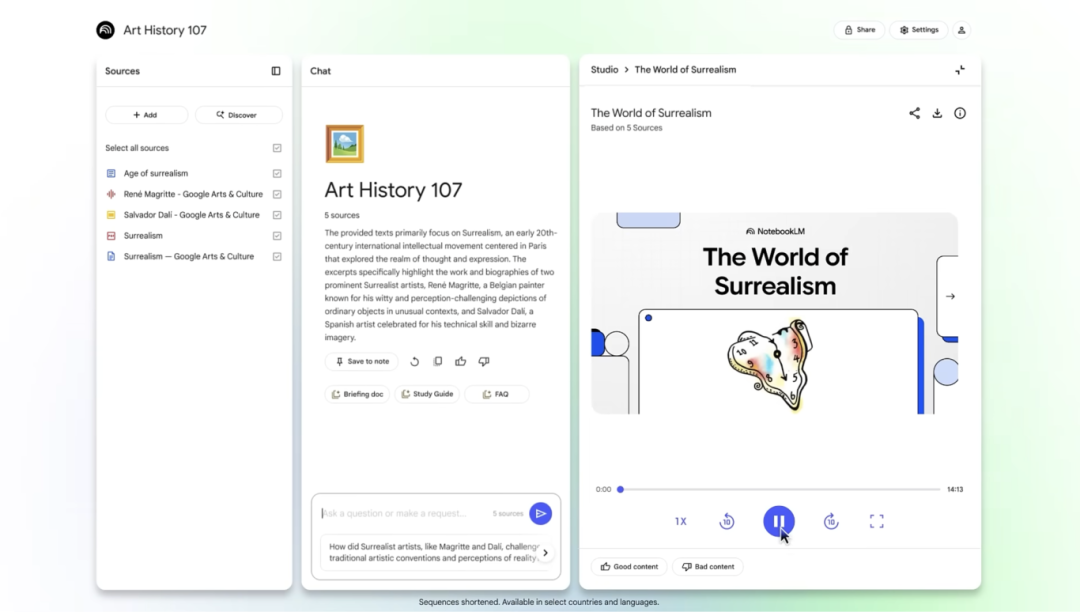

我们面对各种资料和信息的时候,经常能在趋势信息中看到图表,形状和思维导图形成的流程,氛围音效和图像组成的故事…无论是什么样的交流,都会将不同维度的信息精心编排为约定俗成,容易理解的呈现方式,以更容易理解的方式传递意义。

Google NotebookLM(2025)将读取到的资料可以自主转换为图文并茂的视频讲解、播客讲解、思维导图等等各种易理解的方式解释,让学习从单向的接收变成了鲜活的共建

不过,当智能体通过精心编排的隐喻,将它的输出打磨得越是清晰美观、逻辑看起来毫无破绽时,越像一个无法被挑战的最终答案。

我们在和伙伴实际交流的时候,也是如此吗?

面对伙伴的观点,除了认可和赞同,我们的回应中还常常伴随着怀疑、否定,有时候甚至整个任务都会因为一次启发而完全改变。有意义的对话和交流,相比于句号,更重要的是逗号或问号。

在交流和记忆中“渐进式构建”

“这个周末我们去爬山吧,我想挑战一下自己。”

“可以啊!不过你上次爬到一半你就说膝盖不舒服了。还可以吗,要不一起找一个容易点的路线?”

“没事,我膝盖好了。”

“别逞强了…”

…

真正的伙伴记得你之前膝盖受过伤,记得你是路痴,记得你不擅长阅读文字…长期记忆能让你们之间的互动不用再从头开始,而是超越了简单的问答的默契,不需要复杂解释就能很准确猜到对方心思。

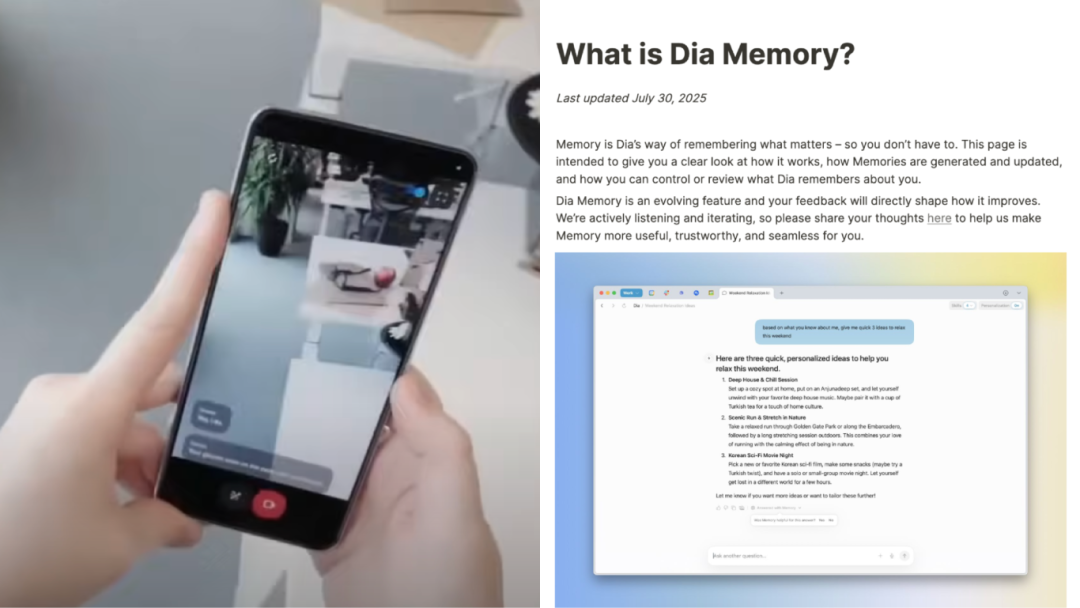

图左:Project Astra 实时记住“刚才的眼镜”等之前看到或听到的上下文

图右:Dia 浏览器的记忆功能,持续积累、学习浏览历史,真正懂你的品味

为了让智能体真正实现伙伴一样的共建意图,“持久记忆”这一关键能力必不可少:

“决定智能体成败的关键在于你赋予它的上下文的质量。大多数智能体失败不再是模型失败,而是上下文失败。”

—— 来源:《The New Skill in AI is Not Prompting, It’s Context Engineering》

但仅仅记住,好像还不够,我们需要活用这样的特性。正如一开始所说,探索不是为了马上得到答案,而在于能打磨清晰意图,提出更具洞察力的,真正的问题。

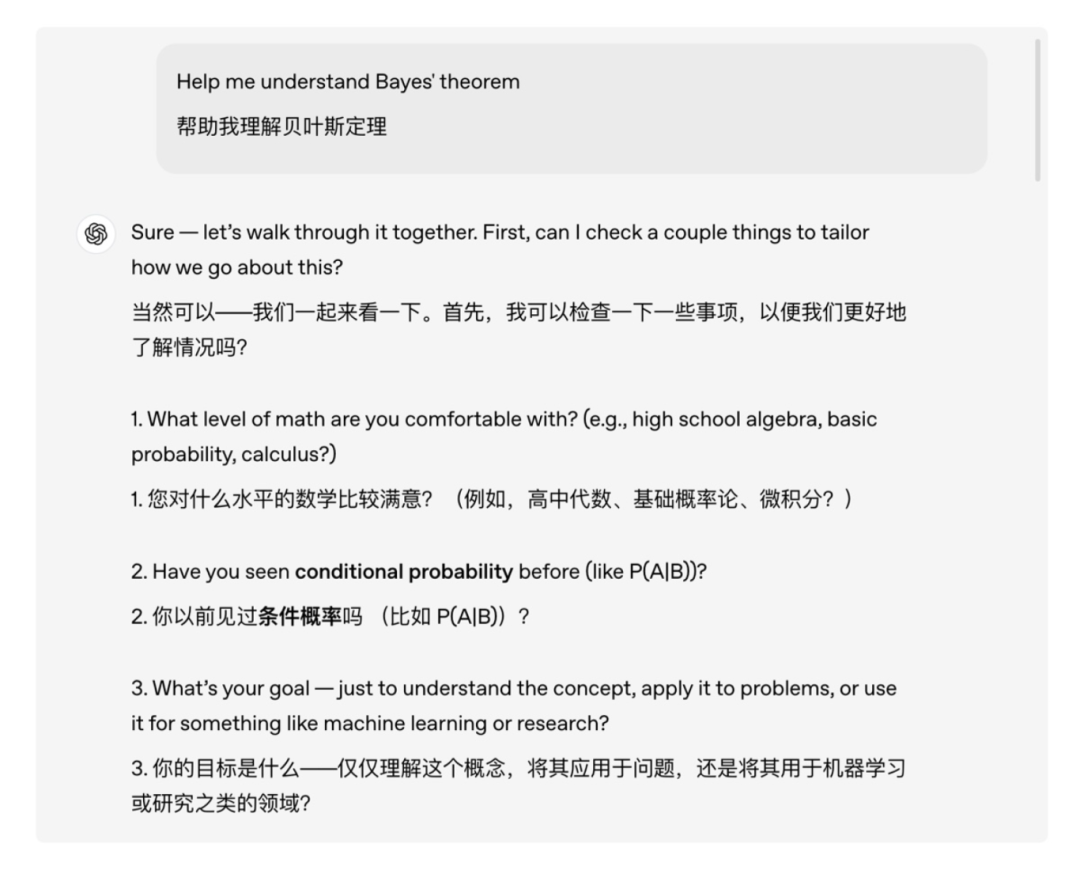

ChatGPT 学习与研究模式(2025)接到任务时,它的第一反应不是立刻给出答案,而是先反问用户,明确问题

每当一个个模糊的想法或问题涌上心头,我们希望智能体不仅仅是一个解答者,而是真正的思考伙伴:能够超越当前上下文,基于我们的偏好和记忆主动发起有意义的对话。与我们反复商榷,引导我们抽丝剥茧,最终在一个渐进的,共同构建的过程中,清晰勾勒出真正的意图。

04 意图共建的终点只是我们的起点

通过多模态完成更深刻的洞察,动态帮助了解信息的呈现,像朋友聊天一样有来有回的交流循环…与智能体的对话越深层和有意义,我们在探索中对问题的理解也会更深刻,意图更清晰。

但这里是终点吗?

电影《Her》中,Theodore 在与人工智能“Samantha”的无数次对话中被迫审视自己的情感、过去的失败婚姻,以及他对重新建立联系的渴望与恐惧。Samantha 在过程中不断展现好奇、学习,不断挑战 Theodore 固有的想法,让他更清晰地看清了自己,开始重新感受、面对生活。

电影《Her》截图(2013)

《Her》的世界离我们并不遥远,甚至这就是我们当下的写照。在智能体将作为长期伙伴陪伴着我们的未来,它的终点也许更像是促进我们成长的催化剂,而不是替代人类情感的工具:

意图共建式交互的最终价值,不仅是为了让我们更深刻地认识自己,更是像引擎一样,将深刻的自我认知,转化为在现实世界中成就自己的不竭动力。

当然,时代在变化,但是本质并没有改变。这也是人机交互的先驱们一直以来努力的目标:

“增强人类应对复杂且紧迫问题的能力。”

—— 道格拉斯·恩格巴特(鼠标发明者)

参考文献

- Johnson, Jeff. Designing with the mind in mind: simple guide to understanding user interface design guidelines. Morgan Kaufmann, 2020.

- Whitenton, K. (2018, March 12). The two UX gulfs: evaluation and execution. Nielsen Norman Group. https://www.nngroup.com/articles/two-ux-gulfs-evaluation-execution/

- DOC – The secret of good metaphors. (n.d.). https://www.doc.cc/articles/good-metaphors

- Nielsen, J., Gibbons, S., & Mugunthan, T. (2024, January 30). Accordion Editing and Apple Picking: Early Generative-AI User Behaviors. Nielsen Norman Group. https://www.nngroup.com/articles/accordion-editing-apple-picking/

- Varanasi, L. (2025, May 25). Meta chief AI scientist Yann LeCun says current AI models lack 4 key human traits. Business Insider. https://www.businessinsider.com/meta-yann-lecun-ai-models-lack-4-key-human-traits-2025-5?utm_source=chatgpt.com

- Apple Lisa 2 screenshot – CHM Revolution. (n.d.). https://www.computerhistory.org/revolution/input-output/14/348/1864

*图片来自网络公开资料,若涉及版权请联系修改。

本文由 @HAI Design 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益