豆包“翻车”?!——AI产品经理视角下的技术、生态与信任博弈

2025 年豆包 AI 手机助手因跨应用操作微信致用户账号下线,此事件是 AI Agent“上机”后的大冲突。它反映出的诸多矛盾,让 AI 产品经理必须深思其未来方向,从权限平衡到生态博弈,从信任构建到产品演化。

2025年12月初,科技圈被一场突如其来的冲突搅动:字节跳动旗下豆包团队与中兴努比亚合作推出的“豆包AI手机助手”,因其强大的跨应用操作能力在操作微信时,导致大量用户账号被强制下线。这一事件迅速发酵,被业界称为AI Agent“上机”后的首场大规模冲突。这不仅是一次技术“翻车”,更是一面棱镜,折射出AI产品在追求极致体验时,与现有应用生态规则、用户隐私安全、商业利益格局之间错综复杂的矛盾。作为AI产品经理,我们必须从这次“压力测试”中汲取教训,深度思考AI产品的未来之路。

方向一:产品定义与权限边界的平衡

对于任何一个旨在颠覆用户体验的产品,尤其是AI产品,产品经理常常面临一个核心抉择:是选择稳妥的渐进式创新,还是大胆地追求“一步到位”的魔法体验?豆包手机助手显然选择了后者,而其魔法的核心,便在于一个名为INJECT_EVENTS的安卓系统高危权限。

机遇:INJECT_EVENTS权限下的“魔法体验”

INJECT_EVENTS权限,即“注入事件”权限,允许应用向系统注入模拟的用户输入事件,如点击、滑动、按键等。对于AI助手而言,这意味着它拥有了一双“无形的手”,可以像真人一样操作手机上的任何应用。豆包手机助手正是利用这一权限,实现了跨应用比价、自动订票、回复微信消息等令人惊艳的功能。从产品定义上看,这无疑是AI Agent理想形态的雏形——一个能理解用户意图并自主完成复杂任务的智能体。这种“系统级调度+后台执行”的能力,极大地提升了操作效率,为用户带来了前所未有的便捷体验,这也是其工程机一经发售便迅速售罄的核心原因。

风险:打破“沙箱”的潘多拉魔盒

然而,这双“无形的手”也同时打开了潘多拉魔盒。现代手机操作系统设计的基石是“沙箱机制”,即每个应用都在一个隔离的环境中运行,不能随意访问或操作其他应用的数据。INJECT_EVENTS权限从根本上打破了这一隔离,带来了三大核心风险:

1)安全风险:

该权限与许多外挂、木马的技术原理异曲同工。一旦被恶意利用或劫持,攻击者可以控制用户账户进行恶意操作,如盗取资金、发送欺诈信息,后果不堪设想。这正是部分安全专家和应用开发者将其视为“洪水猛兽”的根本原因。

2)生态冲突:

第三方应用(如微信)的风控系统,旨在识别和阻止“非典型用户行为”,如自动化脚本、群控软件等。AI助手的模拟点击,即使出于用户授权,其操作路径和速度也与真人有异,极易被风控系统判定为机器人行为,从而触发封禁。豆包操作微信导致账号异常,正是这一冲突的直接体现。

3)用户认知鸿沟:

豆包方面强调,该权限的使用经过了“用户主动授权”并在隐私白皮书中“彻底披露”。但对于绝大多数普通用户而言,“注入事件权限”这样的技术术语如同天书。他们在勾选“同意”时,很可能并未完全理解自己让渡的控制权有多大,以及背后潜在的风险。产品经理在利用这种认知鸿沟追求功能实现时,实际上承担了巨大的伦理责任。

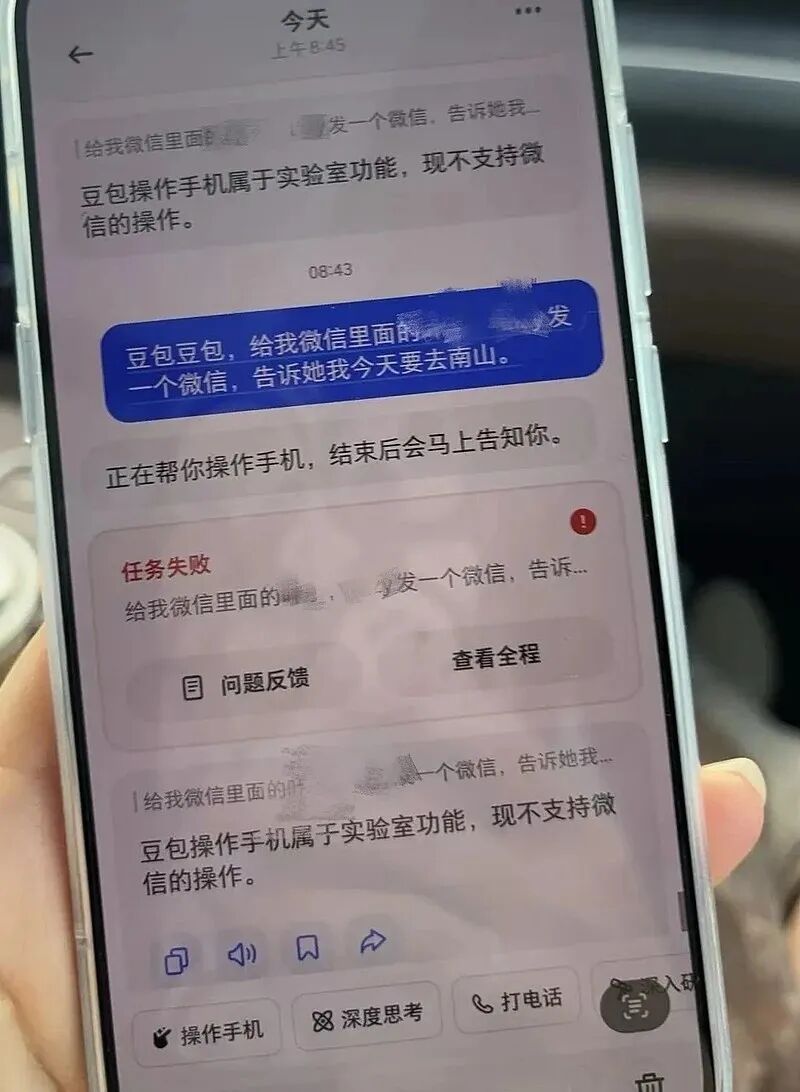

豆包手机助手在尝试操作微信时,因触发风控而失败,提示“现不支持微信的操作”。

因此,从产品经理的视角看,豆包事件的第一个教训是:在定义具备系统级能力的产品时,必须对权限边界有敬畏之心。追求极致的用户体验不能以牺牲系统安全和生态稳定为代价。将一个“高危权限”包装成核心卖点,本身就是一场行走在钢丝上的豪赌,一旦触碰到底线,产品的根基便会动摇。

方向二:生态博弈下的AI产品策略

豆包与微信的冲突,并非孤例。它深刻揭示了在当前移动互联网生态中,一个第三方AI产品(非手机厂商原生、非应用本身内置)所面临的严峻生存挑战。这背后是手机厂商、超级应用和AI技术公司三方之间的复杂博弈。作为产品经理,必须清晰地认识到这一格局,并制定明智的生存与发展策略。

超级应用的“护城河”:为何微信们如此警惕?

微信等超级应用之所以对豆包这类AI助手采取“封杀”态度,其核心原因远不止于安全风控。腾讯方面的回应虽然轻描淡写为“可能触发了正常的安全风控”,但背后是深层的商业逻辑和生态战略考量:

- 维护运营秩序与用户生态:微信的核心是社交关系链。如果允许AI助手大规模进行自动化操作(如批量点赞、自动抢红包、群发消息),将严重破坏“真人”社交的根基,导致垃圾信息泛滥,最终侵蚀其核心价值。

- 捍卫商业模式:超级应用的商业模式建立在流量入口、用户停留时长、广告分发和支付佣金之上。AI助手通过“绕过UI”的方式直接完成任务,可能影响App的真实流量、广告加载和数据采集,从根本上动摇了平台的变现逻辑。

- 数据与隐私责任:AI助手读取屏幕内容进行操作,一旦发生数据泄露或隐私纠纷,作为被操作平台的微信将面临巨大的连带责任和舆论压力。

事实上,不仅是豆包,此前华为小艺、荣耀YOYO、OPPO、vivo等手机厂商的原生AI助手在尝试调用微信功能时,也屡屡碰壁,相关功能最终都被迫下架或调整。这表明,超级应用对其生态的封闭性和控制权有着不容挑战的决心。

第三方AI产品的三条路径

面对如此强势的生态壁垒,作为第三方AI产品的产品经理,可以考虑以下三种策略:

1)“硬闯”模式(高权限依赖):

这是豆包最初选择的路径,通过与手机厂商深度合作获取系统级权限,强行打通应用壁垒。

优点:能实现最强大、最接近理想形态的AI Agent功能,带来颠覆性体验。

缺点:风险极高,极易与应用开发者产生正面冲突,导致产品核心功能被封禁,用户体验极不稳定。豆包最终下线微信操作能力,宣告了此路在当前阶段的失败。

2)“合作”模式(寻求官方API):

主动与超级应用沟通,寻求官方提供的API接口进行集成。

优点:合规、稳定,能获得官方认可,避免被封杀的风险。

缺点:过程漫长且艰难,主动权完全掌握在超级应用手中。它们可能出于自身战略(如自研AI助手)或商业利益考量而拒绝开放,或者只开放非常有限、非核心的功能。智谱AI曾演示的微信发红包功能,最终也因“没谈下来”而取消,便是例证。

3)“迂回”模式(聚焦非敏感场景):

避开与超级应用正面冲突的敏感领域(如社交、支付),转而聚焦于工具类、信息整合类等风险较低的场景。

优点:生存压力小,能平稳发展,逐步积累用户。

缺点:产品想象空间受限,难以形成强大的护城河和“一招鲜”的用户心智。

对于豆包这样的“外来者”,既没有手机厂商的系统控制权,也难以撼动超级应用的生态地位。此次“翻车”后,最现实的路径或许是采取一种混合策略:一方面继续探索“迂回”场景,打磨核心AI能力;另一方面,将这次冲突作为谈判筹码,积极寻求与应用厂商建立对话,推动“合作”模式,哪怕是从最基础的API开始。长远来看,单打独斗的“硬闯”模式已证明不可持续。

方向三:风险前置与信任构建的产品设计

豆包事件给所有AI产品经理上的最重要一课是:信任是AI产品能够被用户和生态接纳的基石。当产品能力越强大、权限越高时,就越需要将风险控制和信任机制前置到产品设计的每一个环节,而不是在事后通过公关声明来弥补。

豆包在官方回应中提到的几点,恰恰是构建信任体系的关键要素,值得我们深入分析和借鉴:

1. 透明的授权与沟通

“豆包手机助手需要用户主动授权,才可以调用该权限,使用操作手机功能。该权限的使用,我们也在权限清单中进行了明确的披露。”

这是构建信任的第一步,但仅仅“披露”是不够的。产品经理需要设计更友好的授权流程,用通俗易懂的语言和场景化示例,向用户解释请求高危权限的“必要性”和“安全性”。例如,可以设计一个分步引导,在用户首次使用跨应用功能时,弹窗说明:“为了帮您完成跨应用订票,豆包需要获得模拟您点击屏幕的权限,此过程全程在您的监督下进行,您可以随时中止。”这比在冗长的隐私协议中隐藏一行小字要有效得多。

2. 全程可控的用户监督机制

“豆包手机助手在执行长任务时会在屏幕有明确提示,且用户可以随时中断,全程可控。”

这是降低用户失控感的关键设计。产品在执行自动化任务时,必须提供一个清晰、持久的视觉提示(如悬浮窗、状态栏图标),让用户时刻知道“AI正在工作”。同时,必须提供一个简单直接的“停止”按钮,确保用户拥有最终的控制权。这种“全程可见、随时可控”的设计,能极大地缓解用户对于“手机被AI接管”的恐惧。

3. 明确的敏感操作边界

“操作第三方App若遇到敏感授权,如系统敏感权限授权弹窗、支付环节、身份验证等,任务会暂停,并由用户人工接管完成相关授权、支付、验证动作。”

这是产品风控设计的核心。AI助手必须明确自己的能力边界,绝不触碰支付密码、身份验证等最高安全级别的操作。在这些关键节点,产品设计应主动“让权”,将控制权交还给用户。豆包官方演示的跨平台比价后,引导用户“手动支付”的案例,正是这一原则的绝佳体现。这种设计不仅保护了用户财产安全,也向生态伙伴(如电商、支付平台)传递了合作而非颠覆的善意信号。

豆包AI助手在完成跨平台比价后,主动暂停任务,将支付环节交由用户手动完成,体现了明确的风险边界意识。

4. 坚定的隐私保护承诺

“手机助手不会在云端存储任何用户屏幕内容。……屏幕和操作过程都不会在服务器端留下存储,且所有的相关内容也都不会进入模型训练。”

在AI时代,数据隐私是用户的终极关切。AI助手要读取屏幕内容才能工作,这天然引发了用户对聊天记录、支付信息等敏感数据被“偷窥”的担忧。因此,产品经理必须在产品设计和隐私政策中,以最明确、最坚定的方式做出承诺。将数据处理尽可能放在端侧,明确声明云端不存储任何个人屏幕内容,并且不将其用于模型训练,这是消除用户疑虑、建立长期信任的根本保障。

总之,一个值得信赖的AI助手,其产品设计应遵循“透明授权、全程可控、边界清晰、隐私至上”四大原则。只有将这些原则内化为产品基因,才能在复杂的生态博弈中赢得一线生机。

方向四:从“翻车”案例看AI手机的产品演化路径

豆包将此次发布的产品定位为“技术预览版”,面向的是行业和AI技术爱好者,而非普通消费者。这个定位本身就说明,团队对产品的前沿性和不成熟性有着清醒的认知。从这个角度看,这次“翻车”事件不仅不是终点,反而是一个关键的起点,它为整个AI手机助手行业揭示了一条从“技术演示”走向“大众市场”的必经演化路径。

第一阶段:功能探索与技术预览(极客狂欢)

这是AI手机助手发展的初期阶段,以豆包为代表。此阶段的核心目标是探索技术边界,展示AI Agent的可能性。产品经理会优先考虑功能的强大与炫酷,甚至不惜采用一些“灰色地带”的技术手段(如高危权限)来实现“魔法效果”。目标用户是乐于尝鲜、容忍度高的技术爱好者。这个阶段的“翻车”是必然的,因为它扮演了“压力测试员”的角色,主动去碰撞现有规则的边界,从而暴露问题。

第二阶段:生态冲突与规则重塑(行业阵痛)

豆包与微信的冲突,标志着行业正式进入这一阶段。新技术的力量开始冲击旧有的商业模式、安全规则和法律框架。各方利益主体——AI公司、应用平台、手机厂商、监管机构——被动或主动地卷入这场博弈。此阶段的特征是混乱、摩擦与谈判。我们会看到更多的“屏蔽”与“反屏蔽”,更多的法律诉讼(如亚马逊起诉Perplexity AI),以及行业组织开始尝试制定初步的指引(如中国信通院发布的《端云协同 智能体交互双重授权安全指引》)。

第三阶段:标准建立与规模化应用(大众普惠)

这是AI手机助手走向成熟的最终阶段。在经历了充分的博弈和试错后,行业将逐步形成新的共识和规范。产品演化的未来路径可能包含以下三个方向:

技术路径:建立官方API与权限分层。

未来的操作系统可能会为AI Agent设计专门的、更安全、更精细化的权限管理体系,取代目前这种“要么没有,要么全给”的粗放模式。同时,超级应用也可能在压力和机遇下,逐步开放标准化的AI Agent接口,实现从“对抗”到“合作”的转变。

产品路径:从“万能”到“专业”。

AI助手可能会从追求“什么都能做”的通用型,向在特定垂直领域(如出行、购物、健康)提供深度、可靠服务的专业型演进。产品经理需要更聚焦于解决用户的真实痛点,而不是单纯炫技。

政策路径:形成清晰的法律与政策框架。

随着技术发展,监管机构将出台更明确的法律法规,界定AI Agent的行为边界、数据责任和隐私标准。这将为行业的健康发展提供稳定的外部环境,解决当前存在的“法律真空”问题。

对于AI产品经理而言,理解这三个演化阶段至关重要。豆包的“翻车”并非宣告了AI Agent的失败,恰恰相反,它以一种激烈的方式,将整个行业从理想化的第一阶段,强行推入了充满挑战但也充满机遇的第二阶段。它用真金白银的代价,为后来者标示出了雷区,也催促着所有从业者去思考通往第三阶段的桥梁该如何搭建。

豆包手机助手事件,是AI浪潮下“新技术”与“旧秩序”碰撞的标志性缩影。它提醒我们,任何颠覆性的技术创新,其落地过程都非一帆风顺,必然伴随着与现有生态的磨合、博弈乃至冲突。作为AI产品的缔造者,产品经理不仅要仰望星空,构想AI带来的无限可能,更要脚踏实地,敬畏规则、尊重伙伴、珍视信任。只有在技术理想、商业现实和用户信任之间找到精妙的平衡,AI Agent才能真正从极客的“玩具”,演变为改变亿万用户生活的“助手”。

本文由 @郑正好AI 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益