RAG前生今世:重塑AI记忆的大模型“外挂”进化史

RAG技术正在重塑大语言模型的应用边界!从最初的朴素检索到如今的多模态融合,这项技术如何突破AI的‘参数茧房’?本文将深度解析RAG从概念诞生到GraphRAG演进的全过程,揭示其在知识时效性、专业领域准确性和数据隐私保护方面的革命性突破。

一、起源:被困在“参数茧房”里的超级大脑

在RAG技术爆发之前,大语言模型(LLM)虽然展现出了惊人的语言理解与生成能力,但在实际商业应用中面临着“不可能三角”的困境:

- 知识时效性滞后(Cut-off Date): 模型的知识截止于训练数据收集的那一刻。对于“今天股价多少”、“上周发布了什么新政”等问题,模型无能为力。

- 专业领域幻觉(Hallucination): 当被问及训练数据中稀缺的垂直领域知识(如企业内部报表、医疗病历)时,模型倾向于“一本正经地胡说八道”。

- 数据隐私与训练成本: 企业不愿将核心机密数据上传用于公有模型训练,而私有化微调(Fine-tuning)不仅成本高昂,且难以应对数据的频繁更新。

此时的LLM就像一个“博学但记忆停留在过去且爱瞎编的教授”。业界迫切需要一种既不需要重新训练模型,又能让模型利用外部新鲜数据的技术方案。

二、诞生:2020年的范式转移

RAG(Retrieval-Augmented Generation) 的概念由Facebook AI Research(现Meta AI)团队的Patrick Lewis等人于2020年在NeurIPS会议上正式提出。

1. 核心理念:从“闭卷考试”到“开卷考试”

在RAG出现之前,模型回答问题完全依赖参数记忆(Parametric Memory),即训练时内化在神经网络权重中的知识。RAG引入了非参数记忆(Non-Parametric Memory),即外部知识库。

- 传统LLM: 用户提问 — 模型大脑检索内部权重 — 生成答案。

- RAG流程: 用户提问 — 检索器(Retriever) 在外部数据库搜索相关信息 — 将信息作为“参考资料”喂给模型 — 生成器(Generator) 结合参考资料生成答案。

这一转变,标志着AI从单纯的“计算”走向了“检索+计算”的混合智能时代。

三、演进:从“朴素”到“高阶”的技术跨越

随着ChatGPT的爆发,RAG技术迅速进入了快车道,经历了三个主要发展阶段:

1. 朴素RAG(Naive RAG):简单的“搜-填-写”

这是最早期的落地形式,逻辑非常线性:

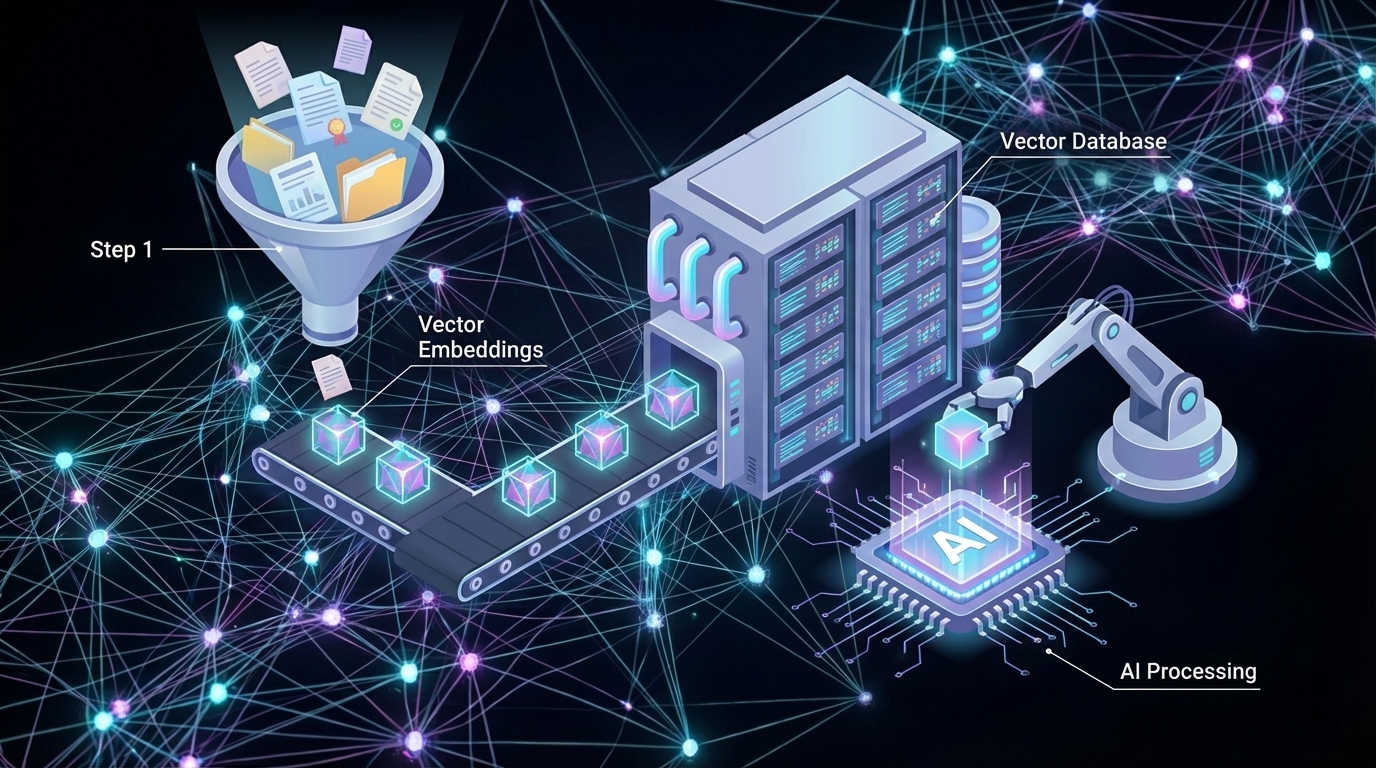

- 索引(Indexing): 将文档切片,通过Embedding模型转化为向量,存入向量数据库。

- 检索(Retrieval): 将用户问题转化为向量,在数据库中匹配最相似的片段。

- 生成(Generation): 将匹配到的片段直接拼接到Prompt中,让LLM回答。

痛点: 检索精度低(搜不到关键信息)、内容连贯性差、无法处理复杂推理问题。

2. 高阶RAG(Advanced RAG):精细化控制

为了解决朴素RAG的缺陷,业界引入了更复杂的预处理与后处理机制:

- 预检索优化(Pre-Retrieval): 改写用户查询(Query Rewriting),使其更符合机器检索逻辑;或者使用假设性文档嵌入(HyDE)。

- 检索优化: 引入混合检索(Hybrid Search),结合关键词匹配(BM25)与语义向量检索;引入重排序(Re-ranking) 模型,对检索回来的结果进行二次精选,大幅提升准确率。

- 后检索优化(Post-Retrieval): 对上下文进行压缩或过滤,只保留高价值信息给大模型,避免超出Token限制或造成模型迷失(Lost in the Middle)。

3. 模块化RAG(Modular RAG):即插即用的生态

当下的RAG已经演变成一个高度模块化的系统。开发者可以根据场景需求,灵活组合不同的模块,如:LangChain、LlamaIndex等编排框架的兴起,让路由(Routing)、记忆(Memory)、融合(Fusion)等模块可以像积木一样搭建。

四、现状:GraphRAG与企业级架构

进入2024年后,RAG技术进入了深水区,重点解决**“全局理解”和“复杂推理”**问题。

1. GraphRAG的崛起

微软在2024年大力推崇GraphRAG。传统的向量检索难以处理“这三份文档有什么共同的主题?”这类宏观问题。GraphRAG利用知识图谱(Knowledge Graph),提取实体与关系,构建数据的结构化网络。

优势: 不仅能找到“点”的信息,还能理解点与点之间的“线”与“面”的关系,显著提升了复杂商业分析场景下的表现。

2. RAG vs 微调(Fine-tuning)的辩证关系

业界已达成共识:RAG与微调并非你死我活,而是互补。

RAG:负责提供事实性、时效性知识(外挂硬盘)。

微调:负责调整模型的说话风格、格式规范或特定领域的思维模式(内化技能)。最佳实践: 通用基座模型 + RAG(解决知识) + 轻量级SFT(解决风格)。

五、未来:长文本(Long Context)会杀死RAG吗?

随着Gemini 1.5 Pro支持200万Token,GPT-4o支持128k Token,一种声音认为:“如果我能把整本书甚至整个数据库直接扔给模型,还需要RAG吗?”

结论是:RAG不会消亡,但会进化。

- 成本与延迟: 每次都输入百万级Token不仅价格昂贵,而且推理延迟(Latency)极高,无法满足实时交互需求。

- 大海捞针(Needle in a Haystack): 即便上下文窗口极大,模型在处理超长文本中间位置的信息时,注意力机制仍会出现衰减。

- 动态更新: 对于TB/PB级的企业数据库,不可能每次都全量输入。

未来的形态将是:

- Agentic RAG(代理式RAG): RAG不再是被动的检索工具,而是作为AI Agent的主动工具。Agent自主判断“是否需要查资料”、“去哪里查”、“怎么验证资料的真伪”。

- 多模态RAG: 检索对象不再局限于文本,PDF图表、视频片段、音频记录都将被向量化,实现跨模态的精准问答。

结语

RAG的前生,是对大模型静态记忆缺陷的一次补救;RAG的今世,是企业构建私有化AI应用的最优解;而RAG的未来,将进化为连接人类海量动态数据与AI智能中枢的标准化桥梁。

在通往通用人工智能(AGI)的路上,RAG通过赋予AI“查阅资料”的能力,让机器智能真正接上了现实世界的地气。

本文由 @阿洋 原创发布于人人都是产品经理,未经许可,禁止转载。

题图来自作者提供

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益