做题家vs科学家:一个30B模型如何颠覆万亿参数的AI军备竞赛

当AI行业陷入万亿参数的军备竞赛时,MiroThinker 1.5用30B参数重新定义了智能的本质。这款模型通过‘科学家模式’的训练理念,将主动查证、多轮校验与自我修正内化为核心能力,在多个基准测试中媲美甚至超越超大模型。本文深度解析其Interactive Scaling技术如何突破传统Scaling Law的天花板,为AI发展路径提供全新思路。

整个行业都在比谁的参数更大、谁的上下文更长时,你有没有想过一个问题:智能的本质到底是什么?是把整个互联网塞进参数里,还是学会如何在需要时精准地找到并验证信息?当所有人都在用蛮力堆砌万亿参数的”做题家模型”时,陈天桥和代季峰却选择了一条完全相反的路:用30B参数的”科学家模型”,跑出了万亿参数模型的性能。这不是什么渐进式改良,而是对整个AI发展路径的根本性反思。

2026年1月5日,由陈天桥和清华AI学者代季峰联合发起的MiroMind团队,正式发布了自研旗舰搜索智能体模型MiroThinker 1.5。这个消息本身并不算特别,毕竟最近几个月几乎每周都有新模型发布。但当我深入了解后发现,这个模型背后代表的思路,可能会彻底改变我们对AI能力边界的认知。它用仅30B参数的版本,在多个基准测试中跑出了与万亿参数模型旗鼓相当甚至更好的表现。更关键的是,它的推理成本只有同类模型的1/20,推理速度还更快。这听起来像是在违反物理定律,但MiroMind团队却找到了一个非常有说服力的解释:他们没有让模型变成一个死记硬背的”做题家”,而是训练它成为一个会主动查证、反复验证、不断修正的”科学家”。

参数竞赛的尽头在哪里

我一直在思考一个问题:为什么大模型发展到现在,大家都在拼命堆参数?从几十亿到几百亿,再到现在动辄上万亿,参数规模的增长似乎永无止境。背后的逻辑其实很简单,就是所谓的Scaling Law:模型越大,能力越强。这个规律在过去几年确实有效,每次参数翻倍,模型性能都会有显著提升。但我越来越感觉到,这条路可能正在接近它的天花板。

想想看,把参数从1000亿增加到10000亿,需要10倍的算力、10倍的训练时间、10倍的成本。但性能提升有10倍吗?显然没有。边际收益递减的规律在这里体现得淋漓尽致。更重要的是,即使你把整个互联网的内容都塞进模型参数里,它还是会出现幻觉,还是会在遇到训练数据中没见过的问题时给出错误答案。因为它本质上只是在做模式匹配和统计推断,并不是真正的理解和推理。

MiroMind团队提出的”做题家模式”这个比喻特别贴切。传统大模型就像一个死记硬背的学生,试图把所有知识都装进脑子里,考试时靠记忆和题感作答。这种方法在应对见过的问题时确实有效,但一旦遇到新问题,就只能靠概率猜测,给出一个”看起来合理”的答案。这就是为什么大模型经常会一本正经地胡说八道,因为它们并不知道自己不知道什么,只是根据统计规律拼凑出一个答案。

而MiroThinker 1.5代表的是另一种思路,团队称之为”科学家模式”。它不是试图记住所有知识,而是学会如何进行研究:遇到问题先提出假设,然后主动去外部世界查找证据,发现证据不符就修正假设,再次查证,不断迭代直到证据收敛。这个过程和真正的科学研究如出一辙,也是人类解决复杂问题的方式。关键区别在于,它不是在参数空间里闭门造车,而是不断与外部世界交互验证。

MiroThinker-v1.5

Interactive Scaling:智能增长的第三维度

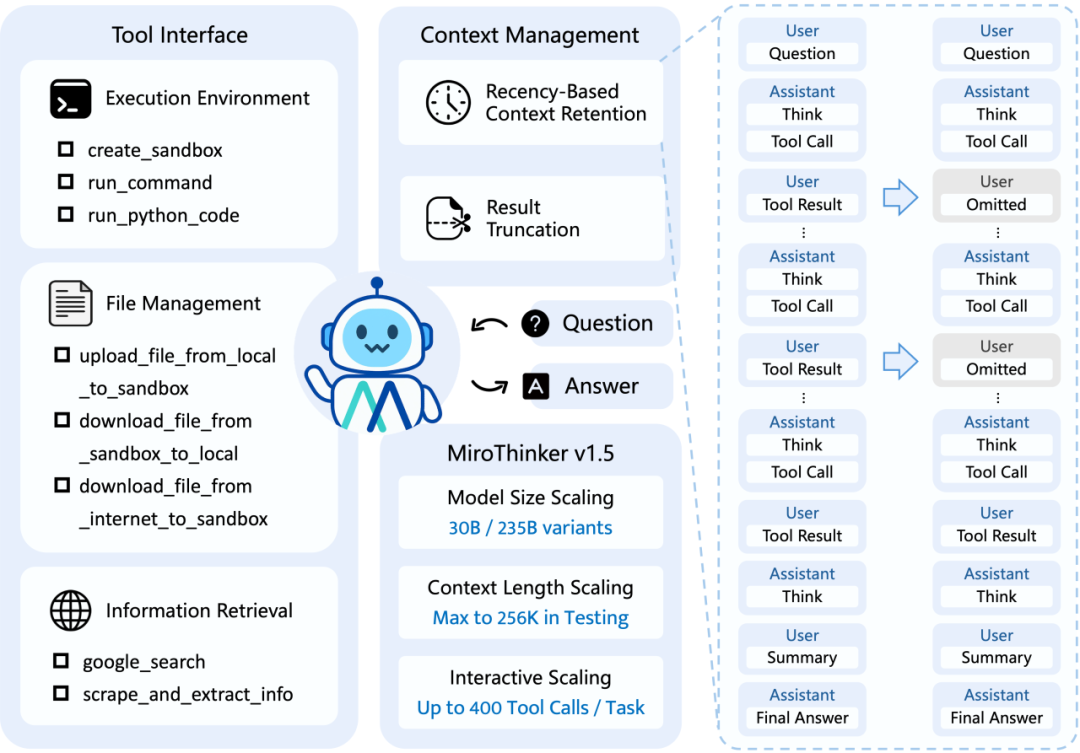

我认为MiroMind团队最大的贡献,不是做出了一个性能更好的模型,而是系统性地提出了”Interactive Scaling”这个概念。过去我们谈论模型能力的扩展,主要关注两个维度:模型参数规模和上下文长度。参数越大,理论上能存储的知识越多;上下文越长,能处理的信息越多。但MiroMind指出了第三个维度:与外部世界的交互频率和深度。

这个观点听起来简单,但意义深远。传统的Scaling Law本质上是在扩展模型的”内存”,试图把世界知识都装进参数里。但世界是无限的,参数是有限的。无论你的模型有多大,总有它没见过的知识、没学过的概念、没经历过的情况。而Interactive Scaling的思路是:与其把有限的算力都用来扩大内存,不如训练模型学会高效地”借力”——在需要时快速从外部世界获取信息。

MiroThinker 1.5在训练阶段就把这种交互能力内化了。它不是把Interactive Scaling当作推理时的外挂功能,而是从训练开始就系统性地强化这种行为模式。具体来说,训练过程中会刻意削弱对”单次完美推理”的奖励,转而强化三种核心能力:主动求证、多轮校验与自我修正、以及对推理捷径的系统性过滤。

主动求证这个能力特别关键。模型被训练成会把每个关键判断拆解为可验证的子假设,然后主动发起对外查询、检索和比对。它不会满足于给出一个”看起来合理”的答案,而是要找到可靠的信源支撑。如果输出缺乏证据支持,在训练中会被系统性惩罚。这就培养了模型的一种本能:在不确定时,先查证再判断。

多轮校验与自我修正则让模型学会了”慢思考”。推理不再是一次性的线性路径,而是可以反复回溯和修正的过程。当模型发现证据冲突时,它会显式调整假设,重新查证,而不是带着错误继续推下去。这就避免了传统思维链推理中常见的问题:一旦某一步出错,后面的所有推理都会随着错误累积而崩溃。

最后是反幻觉机制。训练中不仅评估答案是否正确,更关注答案是如何得到的。那些依赖统计相关性、模式记忆或隐含先验而绕过证据验证的路径,都会被标记为低质量推理。这种训练方式让模型形成了一种习惯:在高风险结论前,必须先查证再收敛。

通过这种方式,MiroThinker 1.5用更小的参数规模,换来了更高的智能密度。它不需要记住所有知识,只需要知道如何在需要时快速、精准地找到并验证信息。这就是为什么30B参数的模型能跑出万亿参数模型的性能——因为它的智能增长空间不在内部参数,而在外部交互。

时序敏感训练:破解因果律的关键

除了Interactive Scaling,MiroThinker 1.5还有一个独特的技术创新:时序敏感训练沙盒。这个技术解决了一个长期困扰大模型的根本性问题——如何真正预测未来,而不是复述已知结果。

我发现很多人在谈论大模型的”预测能力”时,其实混淆了两个概念。传统大模型在训练时通常处于一种”上帝视角”,它在训练数据里早已”见过结果”,所学到的往往只是如何复述这些结果,而不是真正的预测。这就像让学生做练习题,但题目和答案都已经告诉他了,他只需要记住就行。这种训练方式培养不出真正的预测能力。

MiroMind团队设计的时序敏感训练沙盒,为模型戴上了一个”紧箍咒”:严格约束只能使用当前可见的信息,在信息可见性受限的情况下做出判断。这个约束贯穿整个训练过程,模型的每一步推理都只能访问当前时间戳之前的信息,从机制上彻底杜绝了”未来信息泄露”的可能性。

具体实现上,团队构建了一个可控数据合成引擎,能够生成覆盖多任务类型、难度和时间戳都可控的训练数据。关键是,每道题目的”正确答案”不是静态标签,而是随时间戳动态演化的。模型必须在严格的信息可见性约束下,基于当时可获取的信息做出判断,而校验过程同样会显式引入时间戳约束,确保推演与评分都符合真实世界的时序逻辑。

更令我感兴趣的是,这些预测不是”玄学”或事后诸葛亮,而是可以完全复盘验证的。团队提供的每个案例都有完整的思考过程记录,可以看到模型是如何收集信息、如何分析情绪面和板块走势、如何在多个候选中做出选择的。这种可验证性正是时序敏感训练带来的:模型被迫学会在信息不完备、噪声存在、信号延迟的真实条件下进行推演与修正。

实测体验:城镇人口增长

我花了相当长时间测试MiroThinker 1.5的实际表现,选了一个需要跨时间数据分析的问题:”从1949年到2009年,中国城镇人口数量年均增长百分之多少?”这个问题特别有意思,因为它需要模型找到可靠的历史统计数据,理解年均增长率的计算方法,还要确保数据源的权威性。

MiroThinker 1.5的回答过程让我印象深刻。它首先梳理了自己需要收集的所有信息:1949年中国城镇人口基数、2009年城镇人口数据、数据来源的可靠性验证。然后逐一查证,还会在每个步骤中反思验证当前数据的准确性。比如它会交叉对比国家统计局、历年统计年鉴等多个权威来源的数据,确保数字的一致性。

最终给出的结论很严谨,整个推理过程透明可见,数据来源清晰标注,计算步骤完整展示。我注意到MiroThinker 1.5从不会直接给出一个数字就完事,而是会呈现完整的数据获取、验证和计算过程,让用户可以完全复现和检验。

实测城镇居民增长案例

通过这些实测,我最深刻的感受是:MiroThinker 1.5确实实现了从”给答案”到”找答案”的转变。它不是告诉你一个结论让你相信,而是展示完整的研究过程让你理解。这种透明性和可验证性,对于需要高置信度决策的场景来说,价值远超一个简单的答案。

想自己试试的朋友可以访问:https://dr.miromind.ai/

基准测试:用数据说话

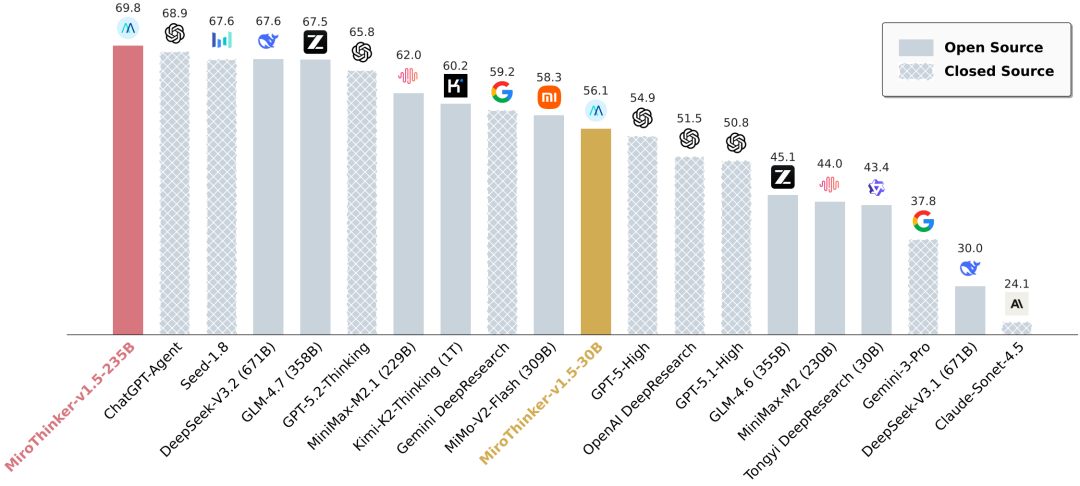

当然,实际体验只是一方面,更客观的评价还是要看基准测试。MiroThinker 1.5在多个权威基准测试中的表现都达到了全球第一梯队水平。

在BrowseComp测试中,MiroThinker 1.5的表现尤为亮眼。这是一个专门针对网页检索类大模型的基准测试,要求模型能够在互联网环境中高效搜索、理解和整合信息。MiroThinker 1.5的235B版本在英文测试中得分69.8%,在中文版本中更是达到71.5%,直接刷新了此前ChatGPT-Agent保持的榜单纪录。

BrowseComp 性能对比

在GAIA验证集测试中,MiroThinker 1.5达到了82.4%的准确率。GAIA是一个评估AI agent真实世界任务完成能力的基准,包含需要多步推理、工具使用和复杂决策的任务。这个成绩超过了OpenAI Deep Research的67.4%,证明了MiroThinker 1.5在复杂任务处理上的优势。

HLE测试的结果同样令人印象深刻。这是一个号称”人类终极测试”的基准,包含大量需要深度推理和世界知识的问题。MiroThinker 1.5在HLE-Text测试中达到29.5%,与DeepSeek-V3.1的29.8%几乎持平,而后者的参数规模要大得多。

更值得关注的是FutureX基准测试。这是一个专门评估模型预测未来事件能力的基准,MiroMind在2025年9月15日登顶排行榜第一,并保持了4个月的第一。他们将GPT-5对未来事件的预测准确率提升了11%,这个提升幅度非常显著。

这对AI行业意味着什么

我认为MiroThinker 1.5的意义远超一个性能优异的模型本身。它代表了AI发展路径的一次重要反思,提出了一个根本性问题:我们是要继续在参数规模的红海里拼资源,还是探索更智能、更高效的增长路径?

过去几年,AI行业陷入了一种”军备竞赛”的状态。每家公司都在比拼谁的模型更大、谁的训练数据更多、谁的算力更强。这种竞争推动了技术进步,但也导致了资源的极度消耗和边际收益的递减。当模型参数从千亿增加到万亿,训练成本可能增加十倍,但性能提升可能只有30%。这种投入产出比显然是不可持续的。

MiroThinker 1.5的出现,提供了一个完全不同的思路:与其把有限的算力都用来扩大模型内部的知识存储,不如训练模型学会如何高效地与外部世界交互。这个思路的核心在于认识到,智能不等于全知,而是等于会学习、会查证、会推理。一个30B参数的模型,如果知道如何精准地从外部世界获取信息,就能解决那些需要万亿参数才能记住的问题。

从技术演进的角度看,Interactive Scaling可能会成为继模型规模、上下文长度之后的第三个核心扩展维度。未来的模型竞争,可能不再是比谁的参数更多,而是比谁的交互能力更强、验证机制更严密、自我修正能力更好。这种转变会从根本上改变AI系统的架构设计和训练方法。

对于开发者和企业来说,这意味着更低的部署成本和更高的可解释性。一个30B参数的模型可以在单张RTX 4090上运行,这让更多中小企业和个人开发者能够使用先进的AI能力。而且由于MiroThinker 1.5的推理过程是透明可见的,企业可以更好地理解和控制AI的决策过程,这对于需要合规性和可审计性的应用场景特别重要。

网站:https://dr.miromind.ai/

Github代码:https://github.com/MiroMindAI/MiroThinker

Hugging Face模型:https://huggingface.co/miromind-ai/MiroThinker-v1.5-235B

本文由人人都是产品经理作者【深思圈】,微信公众号:【深思圈】,原创/授权 发布于人人都是产品经理,未经许可,禁止转载。

题图来自Unsplash,基于 CC0 协议。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益