增长策略:如何用AB测试进行活动评估及优化?

本文以电商行业的促销活动为例,尝试构建促销的评估体系,以及讨论应该如何优化。enjoy~

电商行业充斥着大大小小的促销活动,O2O领域也常常上演补贴大战,在开疆辟土阶段,砸钱让利招揽用户的法子自然最为好使,但当形成一定规模之后,疯狂促销补贴的模式是否仍然高效?个性化的运营策略是否有必要?活动的真实效果到底如何?

为了解决以上问题,建立科学的活动效果评估体系,当前最简便的方法莫过于AB测试。

一、如何建立评估体系?

AB测试目前广泛应用于产品灰度发布阶段,除此以外,AB测试还有更为广泛的用途,比如:精准营销等增长策略。

要进行某类方案的验证,其理念非常朴素,无非就是控制变量,但商业世界尤其复杂,想要控制一切不相干变量极其困难,因此AB测试大行其道,成为了检验“真理”的常用标准。

基于AB测试的思想,通过随机分组,可以保证两个组的其他变量基本一致,通过对实验组施加影响,来观察实验组相对于对照组的表现差异,从而评估该影响的效果。

接下来,我们就以电商行业的促销活动为例,尝试构建促销的评估体系。

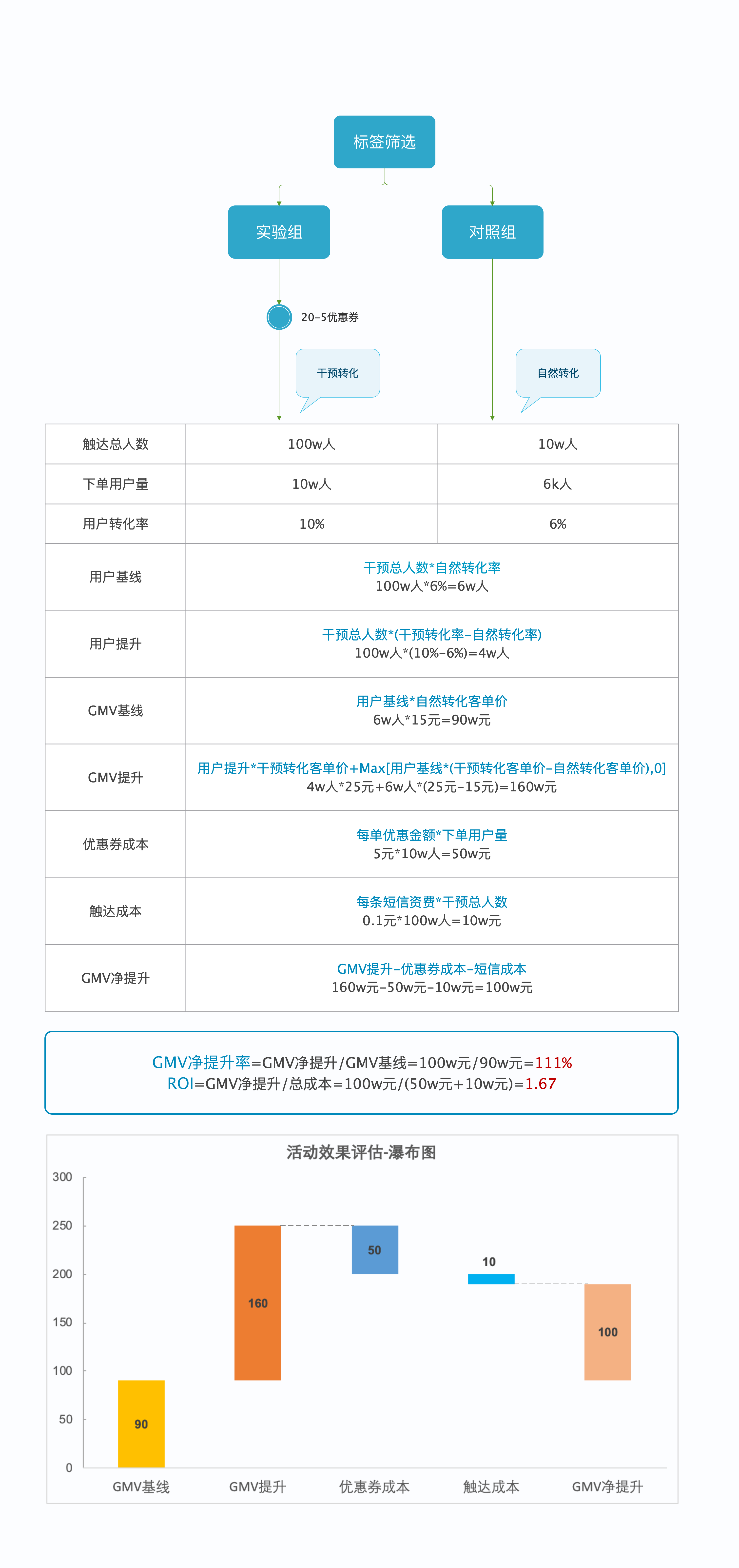

首先,通过标签筛选出潜在人群,并随机抽取一部分用户作为测试组,在不做任何干预的情况下,暗中观察用户的转化情况。

- 对于实验组的用户,我们通过定向优惠券加短信触达的形式进行干预,然后静静等待用户转化。

- 对于对照组而言,用户都是自然转化,而实验组的用户是在干预下产生的转化。在实验组中,一部分用户确实是被优惠吸引,从而下单购买,但还有一部分用户即使没有优惠券也很有可能自然转化。

因此,我们以对照组的转化率作为没有优惠券情况下的自然转化率,那么,我们可以得到以下与用户相关的指标:

- 用户基线=干预总人数*自然转化率

- 用户提升=干预总人数*(干预转化率-自然转化率)

- 用户提升率=用户提升/用户基线

同理,从经营分析的层面,我们可以评估实际的销售效果:

- GMV基线=用户基线*自然转化客单价

- GMV提升=用户提升*干预转化客单价+Max[用户基线*(干预转化客单价-自然转化客单价),0]

- 成本=每单优惠金额*下单用户量+每条短信资费*干预总人数

- GMV净提升=GMV提升-成本

注:GMV提升一方面体现在拉来本不会下单的用户所产生的GMV,另一方面体现在,提升了本来就会下单的用户的客单价,因此要计算这两部分的GMV提升。而对于优惠券而言,尤其是满减优惠券,一般会对客单价产生提升作用,如果客单价降低了,可能是因误差或外部因素导致,因此此处用了Max(),即当客单价降低时,取值0。

最终,我们可以得到评估经营效果的综合指标:

- GMV净提升率=GMV净提升/GMV基线

- ROI=GMV净提升/总成本

上边的指标这么多,那哪个才是最重要的呢?

以上指标罗列的目的是便于理解指标的拆解计算过程。但对于不同角色而言,最终只需要关注与其相关的结果指标。

- 对于运营或者营销而言,他们的考核目标可能聚焦于月活跃用户数,所以,他们会更关心用户提升率,通过多次活动的横向比较,可以识别活动效果的好坏,从而再逐步挖掘根因。

- 对于负责销售的同事而言,需要考量的因素会相对复杂一些,但他们也可以直接通过GMV净提升率和ROI这两个指标来评估活动的综合效果。

其中,GMV净提升率反应的是活动对于GMV的提升效果,如果当前的目标是不惜一切代价冲GMV的话,那么应该选择GMV净提升率高的活动形式或力度。而如果需要权衡考量利润的话,那么还应该把ROI纳入分析,选取GMV净提升率较高,同时ROI也较为可观的活动方案。

二、如何构建优化策略?

上边有提到,运营或者销售可以通过AB测试优化活动方案,那么具体应该如何实现呢?

如果需要测试不同促销形式、不同活动力度的效果,那么有必要对实验组进一步细分。

例如:对于实验组1可以发放满100减20的券,实验组2发放满100减10的券,最后与对照组比对分析活动效果差异。满100减20的券GMV提升可能较高,但由于成本较大,也会导致GMV净提升率和ROI并不高。

同样,对于不同促销形式,如定向优惠券、定向优惠价格等,同一折扣力度不同门槛,如100减20和200减40,也可以以相似方法进行测试。

进行多次AB测试之后,可以根据历史测试数据进行初步判断,识别符合目标的最优促销方案。

三、AB测试有哪些坑?

方法论总是看上去很美好,但一到落地层面就会面临很多意想不到的问题,下面就来扒一扒,按照上述AB测试的方法来做活动效果评估及优化会有哪些坑。

- 测试组人数太少:测试组和实验组的人数不需要完全一样,但各组的人数要保证有统计学上的意义,如果实验组10w人,测试组只有10个人,那么测试组的结果受个体的影响会很大,最终可能导致异常的结果。

- 实验组人数太少:如果想要测试什么门槛的优惠券效果更好,那么需要拆分多个实验组,发放不同的优惠券,如果分的组太多,会使得每个实验组人数偏少,从而导致结果不准确。

- 你的测试组是别人的实验组:现实环境下,不存在绝对干净的试验田,你以为测试组可以代表用户在不受干扰下的自然转化,殊不知有其他活动已经将他们划入了实验组。如果是公司内部的冲突,那么可以在数据回流后剔除掉参与其他实验的用户,但如果是受到外部友商的干扰,那么我们将无从知晓,只有通过多次实验综合评估,对冲单次活动可能会面临的特殊情况。

- 你的实验组是别人的实验组:同理,外部友商可能有更大力度的活动,刚好圈定了你的实验组用户,那么结果可想而之。

- 干预时间滞后:从圈定用户、申请优惠券到最后的短信触达,这个时间多少有些滞后,如果系统不判断用户是否已经下单,那么用户在下单之后才收到优惠券,一方面会影响体验,另一方面,用户可能取消订单后再下单,导致履约成本的上升。如果在发送短信前剔除已下单用户,那么最后实际干预的都是购买倾向相对偏弱的人群,会导致结果失准。因此,营销系统的完善性、各部门的协同执行力都至关重要。

结语

现实世界纷繁复杂,想要抽丝剥茧,捋出头绪谈何容易。试验总会好过停步不前,在实践之中,我们可以学着避开一个又一个的坑。

我们都在试图去搭建一个框架,在这个框架下反复地探究,找到一丝可能的线索,最终,这些线索会编织起一个网络。

作者:Mr.墨叽,公众号:墨叽说数据产品

本文由 @Mr.墨叽 原创发布于人人都是产品经理。未经许可,禁止转载

题图来自Unsplash,基于CC0协议

起点课堂会员权益

起点课堂会员权益

如果平台促销活动类型五花八门 种类太多,一个一个做AB测试会不会太麻烦 有无其他解决办法呢

100W vs 10W ?

你这个没考虑投入进去的人工成本吧?包括数据分析的成本、开发的成本和运营投入的成本

你好,请问你的实验组和对照组ab各自流量占比是多少?看你这边实验组100w触达人数感觉占比很大

请问一下~这个自然转化客单价15和干预转化客单价25是自己设的吗?

您好啊,这种数据图片是用什么工具做出来得呀,求问~期待您的回复。

edraw

学习了

💡

这个优惠劵应该是满20-2吧 😉

哈哈哈,随意了,不过20-2更符合客单价为20的结果。

有个问题想请教下您roi要把优惠券的优惠金额算上吗?优惠金额不是在利润之内的吗?我觉得让利并不等于投入不因该算进投入成本里吧

这里是评估活动效果,优惠的金额和短信的成本就算是这次活动的额外投入,因为如果不让利,还是有一部分用户会购买。我们通过AB测试,分析的是做了这次活动所带来的额外提升。 额外的提升 比上 额外的投入 就是这次活动的ROI。(商品本身的成本、利润这里是没有考虑的)

😐 辛苦