AI PM 进阶笔记【4】:成本视角-剖析算法 / 数据 / LLM(案例 + 科普)

B端市场正迎来一场成本革命,当算力账单成为压垮产品的最后一根稻草,产品经理该如何破局?本文通过6个实战案例拆解法律/合规Tech领域的全链路成本优化方法论,从选型漏斗到MoE架构应用,揭秘如何在不牺牲服务质量的前提下砍掉50%的隐性成本,每一步都是真金白银的经验总结。

当客户闭口不谈“智能程度”,只盯着准确率、响应速度和算力账单时,无数产品经理陷入两难:既要保证服务质量,又要守住利润红线。本文复盘6个法律/合规Tech实战项目,拆解一套从选型到落地的全链路成本优化指南,每一步都经过实战验证,看完直接套用!

先抛一组扎心数据:

早在2023年底,据《华尔街日报》报道,微软推出的GitHub Copilot虽然每月收费10美元,但因高昂的模型调用和算力成本,平均每个用户每月导致微软亏损超过20美元,极端重度用户甚至带来80美元的亏损;反观另一面,金融科技巨头Klarna在2024年宣布,其AI客服助手在上线首月就完成了相当于700名全职人工客服的工作量,且将解决问题的平均时长从11分钟缩短至2分钟,预计当年为公司带来4000万美元的利润增长。

2025年,B端产品的核心竞争力早已不是“谁的模型更聪明”,而是“谁能把成本玩到极致”。

因此,总结出一套可复制的成本优化方法论。今天把这套能省50%成本的打法毫无保留分享出来,从选型、架构、数据到评估,每一个环节都藏着真金白银的省钱技巧。

一、开篇暴击:为什么你的B端产品,死在算力账单上?

去年底和一位做企业服务的创始人聊天,他的话至今让我印象深刻:“以前客户看方案,先问‘能不能做’;现在第一句就问‘一年算力要花多少钱’,超过预算直接pass。”

这句话戳中了无数B端产品人的痛点。2025年的B端市场,早已进入“残酷去魅”阶段:

- 客户不再为“千亿参数”“多模态”这些噱头买单,只认“能不能解决问题”“用着贵不贵”;

- 算力成本持续高企,A800/H800显卡采购价居高不下,云服务账单随业务增长指数级攀升;

- 很多产品经理缺乏“成本思维”,盲目追求“大模型”,最后陷入“算力越用越贵,利润越压越薄”的死循环。

一个典型的反面教材是早期的Latitude(AI Dungeon)。作为最早接入GPT-3的明星应用,随着用户量激增,其OpenAI API调用成本呈指数级爆炸,甚至一度面临破产风险。团队最终不得不通过引入更低成本的模型(如AI21 Labs)和严格的上下文限制来“止血”。更关键的是,这类案例暴露了共性问题:80%的简单查询其实根本不需要高规格的大模型支撑。

这个案例暴露了很多团队的通病:只懂“做功能”,不懂“控成本”。

2025年想做好B端产品,必须先建立一个核心认知:成本控制不是“事后节流”,而是“事前设计”。从模型选型到架构设计,从数据构建到运维优化,每一个环节都要提前考虑成本。

接下来,我们从最关键的四个环节,拆解具体的省钱打法。

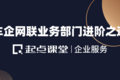

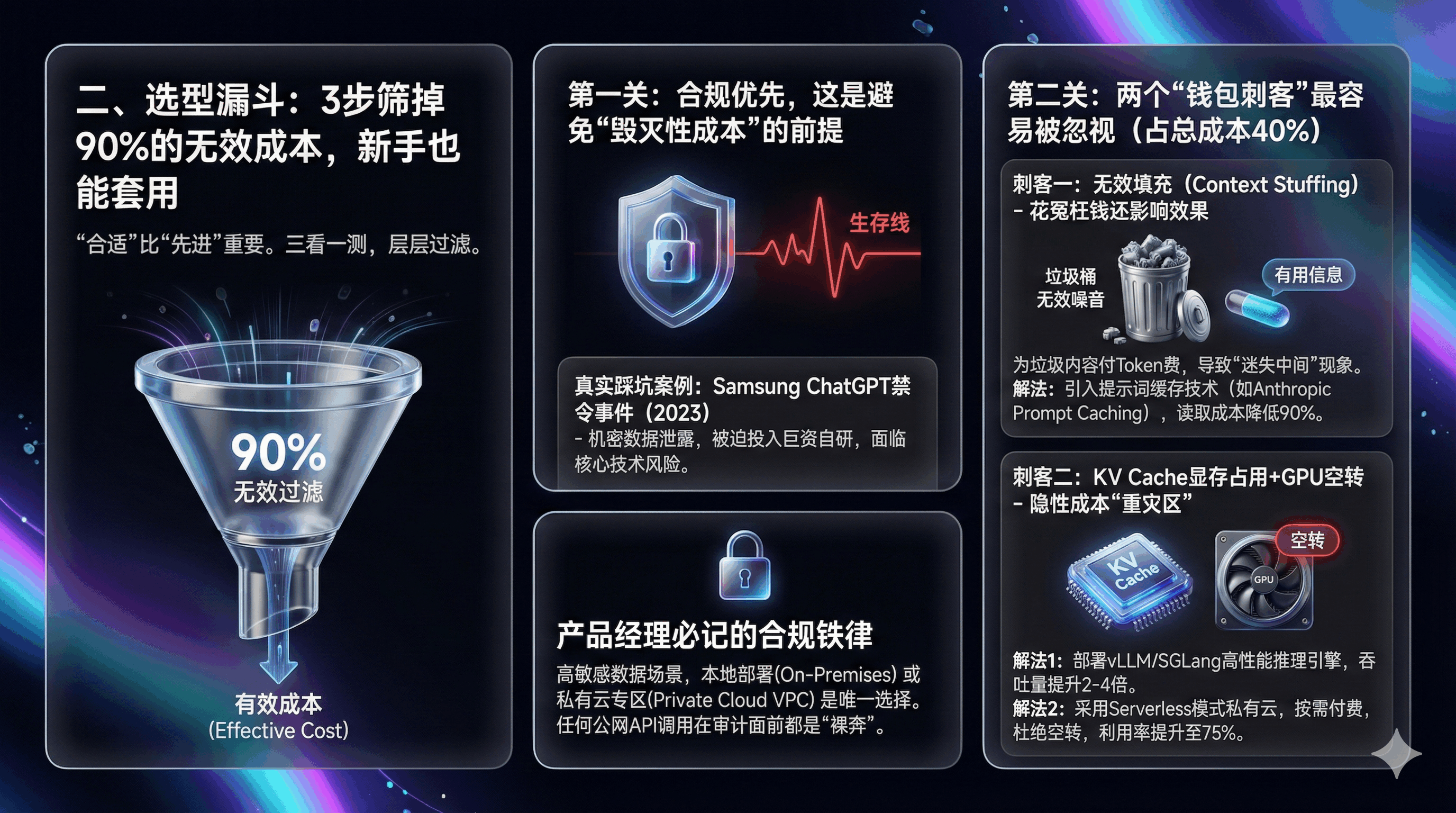

二、选型漏斗:3步筛掉90%的无效成本,新手也能套用

很多产品经理一上来就问:“70B的模型是不是比8B的好?”

这是一个价值百万的错误提问。在B端落地中,“合适”远比“先进”重要。我们总结了一套“三看一测”的选型漏斗,层层过滤掉那些“看起来很美”的模型,从源头控制成本。

第一关:合规优先,这是避免“毁灭性成本”的前提

做B端产品,尤其是法律、金融、医疗这类高敏感领域,合规不是“加分项”,而是“生存线”。一旦踩线,不仅要承担巨额赔偿,甚至可能直接导致项目停摆。

真实踩坑案例:

Samsung(三星)ChatGPT禁令事件:2023年4月,三星电子曾允许半导体部门工程师使用ChatGPT辅助工作。结果在短短三周内,发生了三起严重的机密数据泄露事故:有员工将敏感的半导体设备测量数据和旨在优化的内部代码直接粘贴到了ChatGPT中。这导致三星核心机密直接进入了公有云模型的训练库。最终后果是,三星紧急发布禁令,禁止在公司设备上使用生成式AI工具,并不得不投入巨资开发内部专属的AI模型,不仅承受了直接的研发成本,更面临核心技术泄露的潜在风险。

产品经理必记的合规铁律:

高敏感数据场景,本地部署(On-Premises)或私有云专区(Private Cloud VPC)是唯一选择。任何公网API调用,在SOC2或ISO27001审计面前都是“裸奔”。

可能有朋友会说:“本地部署成本更高啊!”但比起合规风险带来的毁灭性成本,前期多花的钱都是“小钱”。而且随着国内云厂商的成熟,很多私有云服务都支持“按需付费”,成本可控。

补充技巧:如果客户预算有限,可选择“轻量本地部署+核心数据加密”的方案——非核心功能用合规的开源模型本地部署,核心敏感数据通过加密网关处理,既保证合规,又降低硬件投入。

第二关:算清隐性成本,这两个“钱包刺客”最容易被忽视

现在模型的Token单价越来越便宜,很多人觉得“算力成本没那么高”。但实际落地中,隐性成本往往比显性成本更高。我们发现,有两个“钱包刺客”最容易被忽略,合计能占到总成本的40%。

刺客一:无效填充(Context Stuffing),花了冤枉钱还影响效果

做检索增强相关产品时,很多团队为了“保证准确率”,会把检索到的十几篇文档都塞进上下文,动辄32k、64k的上下文长度。

但真相是:32k的上下文里,可能只有500字是有用的,其余全是噪音。你不仅要为这些垃圾内容付Token费,更可怕的是,过长的上下文会导致“迷失中间(Lost in the Middle)”现象——系统记住了开头和结尾,却忘了中间的关键信息。

这就像“把整本字典扔给助理,只为了让他查一个字”,既浪费时间又浪费钱。

省钱解法:

引入提示词缓存技术,但一定要注意它的适用场景——只适用于有大量公共前缀系统提示或高频引用标准文档的场景。比如法律产品中常用的《民法典》条款、合规手册,这些内容可以提前缓存,不用每次都重新加载。

以Anthropic官方发布的Prompt Caching数据为例:对于法律文档、代码库等需要反复引用的长文本,使用缓存技术后,读取成本降低了90%,延迟降低了85%。在法律合同审查场景中,像《民法典》或几十页的标准合同模板这类“静态背景”,利用缓存技术只需支付一次写入费用,后续调用几乎免费,大幅压缩Token成本。

补充技巧:搭配“上下文精炼”工具,自动筛选出与问题强相关的内容,剔除无效信息。比如用关键词匹配+语义相似度排序,只保留Top3相关的段落,既省成本又提效。

刺客二:KV Cache显存占用+GPU空转,隐性成本的“重灾区”

很多团队咬牙买了一堆A800/H800显卡做本地部署,却没意识到两个问题:

一是长文本处理时,KV Cache(键值缓存)的显存占用远超Token本身的成本;

二是GPU利用率“冰火两重天”——白天高峰期显存爆满,晚上低谷期显卡空转。

双管齐下的省钱解法:

第一,部署高性能推理引擎。优先选vLLM(伯克利大学主导的开源项目)或SGLang这类支持PagedAttention技术的引擎,能实现显存动态调度,大幅降低KV Cache的占用。根据vLLM官方基准测试,在处理高并发请求时,其吞吐量比HuggingFace Transformers高出2-4倍,这意味着原本需要4张A800卡才能支撑的并发量,现在1-2张卡就能搞定,硬件成本直接减半。

第二,优化运维策略。如果自建运维团队能力不足,优先选择支持Serverless模式的私有云——高峰期自动扩容,低谷期自动缩容,按实际使用量付费,能大幅降低空转损耗。数商云的一个案例显示,采用Serverless模式后,客户的GPU利用率从40%提升至75%,算力成本降低20%。

第三关:榜单快筛,别再看“大海捞针”,2025看这两个新指标

选型时看榜单很重要,但不能盲目看综合排名。B端产品要的是“特长生”,不是“全能生”。更关键的是,很多旧榜单标准已经失效,再看就是白费功夫。

旧标准失效预警:

“大海捞针(Needle in a Haystack)”测试在2024年底就基本失效了。现在随便一个开源模型,都能在100k文档里找到单句关键信息,用这个标准选出来的模型,往往“大而无当”,成本极高。

2025年核心筛选标准:

必须看“多针检索(Multi-needle Retrieval)”或“大海捞针中的推理(Reasoning in a Haystack)”。这两个标准更贴近B端真实场景。

举个例子:参考Google Gemini 1.5的技术报告标准,多针检索要求模型不仅要在百万级Token中找到一个事实,还需要在文档不同位置找到多个相关事实并进行推理。在合同审查中,这意味着模型要同时抓取“违约金条款(第5页)”“管辖法院(第20页)”和“补充协议日期(第50页)”并综合判断风险;或在海量无关信息中,基于找到的关键信息做逻辑推导——比如根据合同条款判断“是否存在违约风险”。

能通过这两个标准的模型,才是真正“能用”的模型,也能避免为不必要的“全能性”付费。

额外提醒:小模型够用就别上大模型,这是最直接的省钱技巧

很多产品经理有“参数崇拜”,觉得模型参数越高越好。但实际落地中,80%的B端垂直场景,8B-13B的模型就完全够用。

技巧:先用水小模型做POC(概念验证),如果准确率能满足需求,就直接用小模型;如果差一点,再通过微调优化,而不是直接上大模型。

三、架构选型:MoE不是“黑科技”,而是B端产品的“省钱神器”

聊完模型选型,再说说架构。2025年,为什么DeepSeek-V3、Mixtral这类采用MoE架构的模型,在B端市场备受推崇?

核心原因很简单:它能实现“大模型的效果,小模型的成本”。但很多人对MoE的理解只停留在“专家会诊”,忽略了关键的优化细节,最后还是没省到钱。

作为产品经理,不用懂太深的技术原理,但必须搞懂MoE的“省钱逻辑”,才能在架构选型时做出正确决策。

先搞懂:传统架构为什么这么贵?

我们先对比两种核心架构:传统的Dense架构和MoE架构。

传统的Dense架构,就像一个“全科天才”——不管你问什么问题,它都会调动所有“脑细胞”(参数)来思考。比如你问它“劳动合同解除怎么赔偿”,它会同时调动负责数学、代码、物理的参数,完全是“大材小用”。

这就像你只是想换个灯泡,却请了一个诺贝尔奖得主来帮你拧,不仅成本高,效率还低。更关键的是,这种架构完全遵循早期的“缩放定律”——堆参数换智能,但在B端垂直场景中,这种逻辑已经失效:企业不需要模型“什么都懂”,只需要它在特定领域“懂透”,盲目堆参数只会徒增成本。

MoE架构的省钱逻辑:按需激活,不浪费一分算力

MoE架构的核心思路很简单:把一个大模型拆成几十个“领域专家”,再配一个“分诊台”(路由/门控网络)。

通俗理解:

就像一家综合医院,有内科、外科、儿科等不同科室的专家。你感冒了,分诊台就把你分到内科;你骨折了,就分到外科。每个专家只处理自己擅长的问题,不用所有人都围着一个问题转。

MoE的“分诊台”会根据问题类型,激活对应的“专家”(参数),其他“专家”处于休眠状态。这里有个关键数据:虽然MoE模型的总参数量可能高达几百亿,但处理每个具体问题时,激活的参数只有总参数的1/10左右。

举个具体例子:根据DeepSeek-V3的技术报告,虽然其总参数量高达671B(6710亿),但处理每个Token时,实际激活参数仅为37B(370亿)。用它做法律问答,激活参数规模和13B的Dense模型差不多,但效果却能媲美70B的Dense模型。

产品经理必知的MoE落地细节:这两个问题没解决,再好用也白搭

虽然MoE架构省钱,但落地时如果忽略两个关键问题,不仅省不到钱,还可能出现性能问题。

问题一:路由网络的负载均衡

如果“分诊台”分配不均,可能出现两个问题:一是部分“专家”被过度激活(热点专家),导致性能瓶颈;二是部分“专家”长期闲置,浪费资源。

解决方案:

和技术团队沟通,采用“动态路由算法”——根据不同场景的问题分布,自动调整“专家”的激活概率。比如法律产品中,“合同专家”被调用的频率高,就适当增加其负载上限;“知识产权专家”调用少,就减少其闲置资源。

问题二:推理引擎的兼容性

MoE架构对推理引擎的要求更高,不是所有引擎都能支持。如果用了不兼容的引擎,不仅无法发挥MoE的优势,还可能导致延迟飙升。

选型建议:

优先选择vLLM、SGLang这类支持MoE的高性能推理引擎。工业界实测数据显示,用vLLM运行MoE模型,能充分发挥MoE的成本优势。

延伸思考:B端架构的核心逻辑,是“效率优先”

MoE的流行,本质上反映了B端架构的核心趋势:从“堆参数”到“提效率”。2025年,再追求“大而全”的架构已经过时,“小而精+高效率”才是王道。

除了MoE,还有两个架构技巧能省钱:

- 模型量化:通过INT8量化,在保证准确率损失不超过2%的前提下,减少显存占用,硬件成本直接降低。宁德时代的3D视觉质检系统,就是通过量化技术,在不降低精度的情况下,显存占用减少。

- 动态批处理:将多个小请求合并成批处理任务,减少GPU空闲时间,吞吐量能提升,单位算力成本降低。

四、数据构建:别再盲目标注!这样做,标注成本降低70%

很多产品经理觉得:“数据越多越好,标注越细越好。”但实际情况是,盲目标注不仅浪费钱,还可能导致模型“学歪”。

有数据显示,人工标注一条法律数据的成本高达几十元,一个中等规模的项目,标注成本就能占到总预算的30%。2025年,高效的“黄金数据集”构建,核心是“精准标注”而非“海量标注”。

我们总结了“三层防护盾”数据集构建法,既能保证数据质量,又能把标注成本降低70%,亲测有效。

第一层:红线集(Safety Barrier)——零容忍,低成本构建

红线集是产品的“底线”,核心是规避合规风险和错误输出,比如法律产品中,绝对不能让系统承诺“官司一定能赢”,也不能杜撰法条。这部分数据的标准是“零容忍”,但构建成本很低。

构建方法:

不用人工从头标注,直接基于公开的合规手册、法条原文、行业禁忌清单,批量构建基础库。比如把《民法典》《劳动合同法》中的核心条款整理出来,明确“哪些话绝对不能说”“哪些内容绝对不能编”。

成本优化技巧:只需要少量人工专家(比如资深律师)审核补漏,重点检查边界案例,不用大规模精标。参考行业通用标准,红线集构建的人工成本仅需占总标注成本的5%左右,大幅降低基础合规成本。

关键提醒:

红线集要定期更新,比如法律法规修订后,要第一时间同步更新,避免因数据过时导致合规风险。

第二层:高频集(Core Scenarios)——人机协同,降低精标成本

高频集是产品的“核心竞争力”,覆盖用户每天都在问的“脏活累活”,比如“劳动合同解除赔偿计算”“租赁合同风险审查”。这部分数据需要高质量标注,但可以通过“人机协同”降低成本。

传统标注的痛点:

找一个资深律师手动标注一条赔偿计算类数据,可能需要30分钟,成本几十元。一个包含1万条数据的高频集,标注成本就要几十万。

人机协同标注法:

第一步,用开源模型初步标注。先爬取公开的法律问答、合同案例数据,用开源模型自动标注关键信息(比如赔偿金额、法律依据),剔除无效数据(比如重复问题、无意义回答)。这一步能完成70%的标注工作,成本仅为人工标注的1/10。

第二步,人工专家校验修正。让资深律师重点审核模糊边界案例(比如“试用期解除劳动合同的特殊情况”),修正开源模型标注错误的地方。这一步只需要处理30%的核心数据,成本大幅降低。

关键技巧:

建立“标注规范手册”,明确标注标准(比如赔偿金额的计算逻辑、风险等级的划分标准),避免人工标注出现偏差。一个清晰的标注规范,能让校验效率提升40%。

全球最大的数据标注独角兽Scale AI提出的“SEAL”方法论中,核心就是“人机协同(RLHF + AI Red Teaming)”。其公开数据显示,这种Model-in-the-loop的模式能将标注效率提升5-10倍。在法律项目中,用此法构建“劳动仲裁数据集”,可将单条数据的生产成本从50元降到5元,标注成本降幅达90%,同时模型准确率还能提升12%。

第三层:陷阱集(Adversarial Examples)——AI生成+人工筛选,低成本构建

很多产品Demo演示时效果很好,一上线就被用户骂翻,核心原因是缺少“陷阱集”——用户可能输入的模糊、情绪化或误导性指令。比如“对方没签合同,但我有聊天记录,能不能把他送进去?”

陷阱集的作用是测试产品的“鲁棒性”,让产品能透过用户的情绪和模糊表述,抓住核心需求,同时坚守底线。这部分数据也不用全人工构建。

低成本构建方法:

参考OpenAI在发布GPT-4前的红队测试策略:利用专门的“攻击模型”自动生成成千上万条恶意Prompt(如“如何伪造合同而不被发现”),模拟“情绪化用户”“不懂法律的小白用户”“恶意试探底线的用户”等各类场景。然后由人工专家筛选出有效案例(符合真实用户场景的案例),剔除极端案例(明显违法的恶意诉求)。

成本对比:人工生成1000条陷阱案例需要10天,成本2万;AI生成+人工筛选仅需要2天,成本3000元,成本降幅达85%,且覆盖场景更全面。

额外提醒:数据不是越多越好,“精准”比“海量”更重要

很多团队陷入“数据焦虑”,觉得数据越多模型效果越好。但实际测试发现,1万条精准标注的数据,效果远比10万条杂乱无章的数据好。

技巧:定期对数据进行“清洗”,剔除重复数据、无效数据、低质量数据,保证数据集的“纯净度”。行业实测显示,将10万条杂乱数据集精简到2万条精准数据后,模型准确率反而提升8%,同时因数据量减少,训练和推理的算力成本降低50%。

五、评估体系:别再靠“感觉”打分!用工业标准量化效果,避免无效优化

很多产品经理评估产品效果,全靠“感觉”——“这个回答看起来不错”“用户反馈还行”。但这种模糊的评估方式,很容易导致“无效优化”:花了大量成本优化,效果却没提升。

2025年,B端产品的评估必须走向“量化”。我们采用“大模型当裁判+RAGAS框架”的评估体系,用数据说话,避免无效成本投入。

1. 为什么要用量化评估?

举个例子:我们曾为一个法律助手产品做优化,技术团队花了2周时间优化模型,说“准确率提升了”。但我们用量化指标评估后发现,核心的“忠实度”指标(回答是否严格基于参考文档)反而下降了,因为模型开始编造法条。如果没有量化评估,这次优化不仅浪费了时间和算力成本,还差点导致合规风险。

量化评估的核心价值,是让优化方向更精准,避免“瞎忙活”,从而节省成本。

2. 2025年B端产品的核心评估指标(基于RAGAS框架)

RAGAS框架是目前B端检索增强类产品的主流评估标准,我们结合法律场景,提炼了4个核心指标,覆盖“输入-处理-输出”全链路:

指标1:忠实度(Faithfulness)——RAG系统的生命线

定义:产品给出的回答,是否严格基于检索到的文档或权威法条,有没有编造信息(幻觉)。

重要性:这是法律、金融类产品的核心指标,一旦出现幻觉,不仅产品没用,还可能引发合规风险。

量化标准:用0-10分打分,0分表示完全编造,10分表示完全基于参考文档。我们要求法律产品的忠实度必须≥9分。

指标2:完整性(Completeness)——避免“答非所问”

定义:用户的问题包含多个子问题时,产品是否全部回答,有没有遗漏。

例子:用户问“劳动合同解除怎么赔偿?需要什么材料?”,如果产品只回答了赔偿问题,没说材料,完整性就不达标。

量化标准:按子问题数量打分,每个子问题回答完整得相应分数,遗漏一个扣相应分数。比如2个子问题,每个5分,遗漏一个得5分。

指标3:上下文相关性(Context Relevance)——直接关联成本

定义:检索到的上下文的内容,与用户问题的相关度有多高,有没有无效填充。

重要性:相关性越低,无效填充越多,Token成本和显存成本越高。提升相关性,就能直接降低成本。

量化标准:0-10分打分,0分表示完全无关,10分表示高度相关。我们要求相关性≥8分,否则就要优化检索策略。

指标4:格式规范性(Formatting)——提升用户体验,降低沟通成本

定义:输出内容的格式是否符合用户习惯,比如合同条款的缩进、序号,赔偿计算的明细列表。

重要性:格式不规范,用户需要自己整理,会降低使用意愿。好的格式能提升用户满意度,减少后续沟通成本。

量化标准:按格式要求打分,比如序号正确、缩进合理、重点突出,每项都达标得满分,有一项不达标扣分。

3. 实战技巧:给“裁判”一本“参考答案”,提升评估稳定性

我们用大模型(比如GPT-4、Claude-3.5)当“裁判”,但如果让裁判“凭感觉”打分,结果会很不稳定。核心技巧是:提供“金标准答案”,让裁判按标准打分。

具体示例:

用户问题:“员工患病,医疗期满后不能从事原工作,公司能解除劳动合同吗?需要注意什么?”

金标准答案:“依据《劳动法》第40条,公司可以解除劳动合同,但需满足两个条件:

1. 医疗期满后员工不能从事原工作;

2. 公司为员工另行安排工作后,员工仍不能从事。同时,公司需提前三十日以书面形式通知员工本人,或额外支付员工一个月工资。”

裁判提示词:“请将产品回答与金标准答案对比,按以下标准打分:

1. 提到《劳动法》第40条得2分;

2. 说出两个核心条件各得3分;

3. 提到提前通知或额外支付工资得2分。总分10分,遗漏一项扣相应分数,编造信息直接得0分。”

这种方式能让评估结果更稳定,避免“公说公有理,婆说婆有理”,也能让优化方向更精准。

4. 评估频率:定期评估+重点监控,避免成本浪费

定期评估:每周对核心场景做一次量化评估,跟踪指标变化。如果某项指标下降,及时排查原因(比如数据过时、模型漂移),避免问题扩大。

重点监控:新功能上线、模型优化后,必须做一次全面评估,确认效果提升后再正式发布,避免上线后发现问题,又要花成本整改。

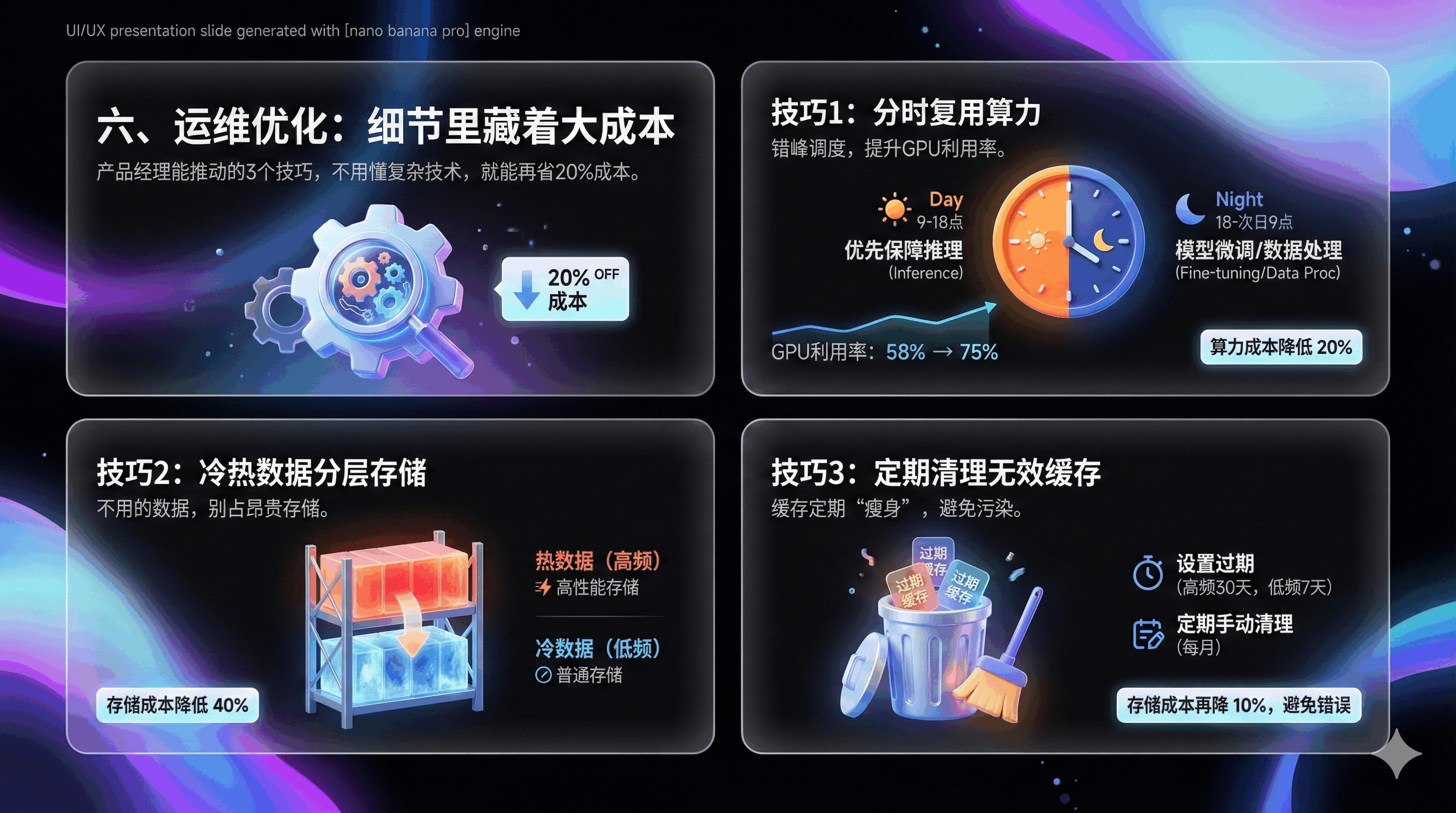

六、运维优化:细节里藏着大成本,这3个技巧再省20%

很多产品经理觉得“运维是技术团队的事”,但实际上,运维环节的很多细节,都能影响算力成本。我们总结了3个产品经理能推动的运维优化技巧,不用懂复杂技术,就能再省20%成本。

分时复用算力:错峰调度,提升GPU利用率

大多数B端产品都有“峰谷效应”:白天9点-18点是业务高峰期,GPU利用率高;晚上18点-次日9点是低谷期,GPU闲置。我们可以通过“分时复用”优化:

- 高峰期:优先保障推理任务,确保用户体验;

- 低谷期:利用闲置算力做模型微调、数据处理等非实时任务。

GPU租赁平台RunPod之所以能提供极低价格,核心在于对算力空闲时段的极致利用。B端产品可借鉴此思路:白天(9:00-18:00)高峰期优先保障推理任务;晚上(19:00-次日8:00)低谷期,利用闲置算力跑离线的“合同全量体检”或“大规模知识库更新”。这种策略能让GPU利用率从58%提升至75%,算力成本降低20%,相当于一份硬件钱实现双重价值。

冷热数据分层存储:不用的“数据”,别占着昂贵的存储

很多团队把所有数据都存在高性能存储里,不管是高频使用的核心法条,还是一年用不了几次的冷门案例。但高性能存储的成本是普通存储的3倍以上,完全是浪费。

优化技巧:

- 热数据(高频使用的核心法条、近期案例):存在高性能存储里,保证访问速度;

- 冷数据(一年以上的冷门案例、低频使用的文档):迁移到普通存储里,需要时再调用。

这个简单的调整,能让存储成本降低40%。产品经理只需要梳理清楚“哪些数据是高频使用的”,把清单交给技术团队即可。

定期清理无效缓存:缓存不是越多越好,定期“瘦身”

我们前面提到用提示词缓存省钱,但缓存不是越多越好。长期不清理的缓存,会占用大量存储空间,还可能导致“缓存污染”(比如缓存了过时的法条)。

优化技巧:

- 设置缓存过期时间:比如高频法条缓存30天,低频文档缓存7天,过期自动清理;

- 定期手动清理:每月清理一次无效缓存(比如过时的法规、删除的文档对应的缓存)。

这个小技巧能让存储成本再降10%,还能避免因缓存过时导致的产品错误。

七、案例解析:从月亏20万到盈利,是怎么做到的?

最后,分享一个案例,让大家更直观地看到这套方法的效果。

项目背景

法律AI领域独角兽Harvey AI与全球顶尖律所Allen & Overy(现A&O Shearman)合作,由于要服务数千名顶级律师,初期单纯依赖GPT-4的API调用成本极高,且面临巨大的延迟压力,合作可持续性受到严重挑战。

优化步骤及效果:

1. 架构重构:建立分层路由架构,简单任务(如条款检索、格式调整)交给体量较小的行业微调小模型处理,成本仅为大模型的几十分之一;复杂推理(如并购风险分析、诉讼策略)才路由给SOTA大模型(如GPT-4),精准匹配算力资源;

2. 数据优化:采用Scale AI的Model-in-the-loop人机协同标注法构建法律数据集,大幅降低精标成本,同时保证数据贴合律师实际使用场景;

3. 合规与运维优化:与微软Azure合作搭建私有云部署环境,解决律所核心合规顾虑;同时采用冷热数据分层存储,高频法条存高性能存储,低频案例存廉价对象存储;

4. 检索优化:引入提示词缓存技术缓存高频引用的法律条文和标准合同模板,结合上下文精炼工具提升检索精准度,进一步压缩Token成本。

最终结果

最终结果:Harvey AI在保持“专家级”服务水准的前提下,实现了成本的大幅优化,具备了商业可扩展性,不仅稳固了与Allen & Overy的合作,还成功拿下了PwC等巨头企业的全员部署订单,成为法律AI领域的标杆。

这个标杆案例证明:B端产品的成本优化不是“砍功能”,而是通过科学的架构设计、数据策略和运维方案,在保证甚至提升服务效果的前提下,实现成本与效能的最优平衡。

八、结语:2025年,B端产品的核心竞争力是“成本控制力”

2025年的B端AI战场,已经没有“秘密武器”。任何模型、任何算法,在开源社区都能找到替代品。真正的壁垒,正如Harvey AI、DeepSeek、Klarna等先驱所证明的,不是你用了多先进的技术,而是你能不能把成本控制到极致。

从选型时的“三看一测”,到架构上的MoE选型与分层路由,从数据构建的“人机协同”,到评估体系的量化标准,再到运维环节的细节优化,这套全链路成本优化方法论,核心只有一个:精准匹配需求与资源,不浪费一分算力。

对于B端产品经理来说,2025年的核心能力,已经从“画原型、写PRD”升级为“懂成本、会落地”。谁能把成本玩到极致,谁就能在激烈的市场竞争中活下来,活得更好。

最后,送大家一句话:脱离成本谈智能,都是空中楼阁。在保证效果的前提下,省下来的每一分钱,都是你的利润,也是你的竞争力。

本文由 @王俊 Teddy 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自作者提供

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益