打破“超级大脑”神话:DeepMind报告揭露AGI的真实形态——为什么未来是“智能体公司”的天下?

Google DeepMind的最新报告颠覆了我们对AGI的传统认知——未来的通用人工智能将不再是孤立的‘全能神’,而是由无数专业AI智能体组成的‘超级公司’。这种‘拼布式AGI’通过专业分工和智能协作,不仅解决了单体模型的成本与效率困境,更催生了一个全新的‘智能体经济’。本文将深度解析这种范式转移背后的商业逻辑、技术架构和社会治理挑战,揭示AI行业从‘模型竞赛’迈向‘制度设计’的关键转折。

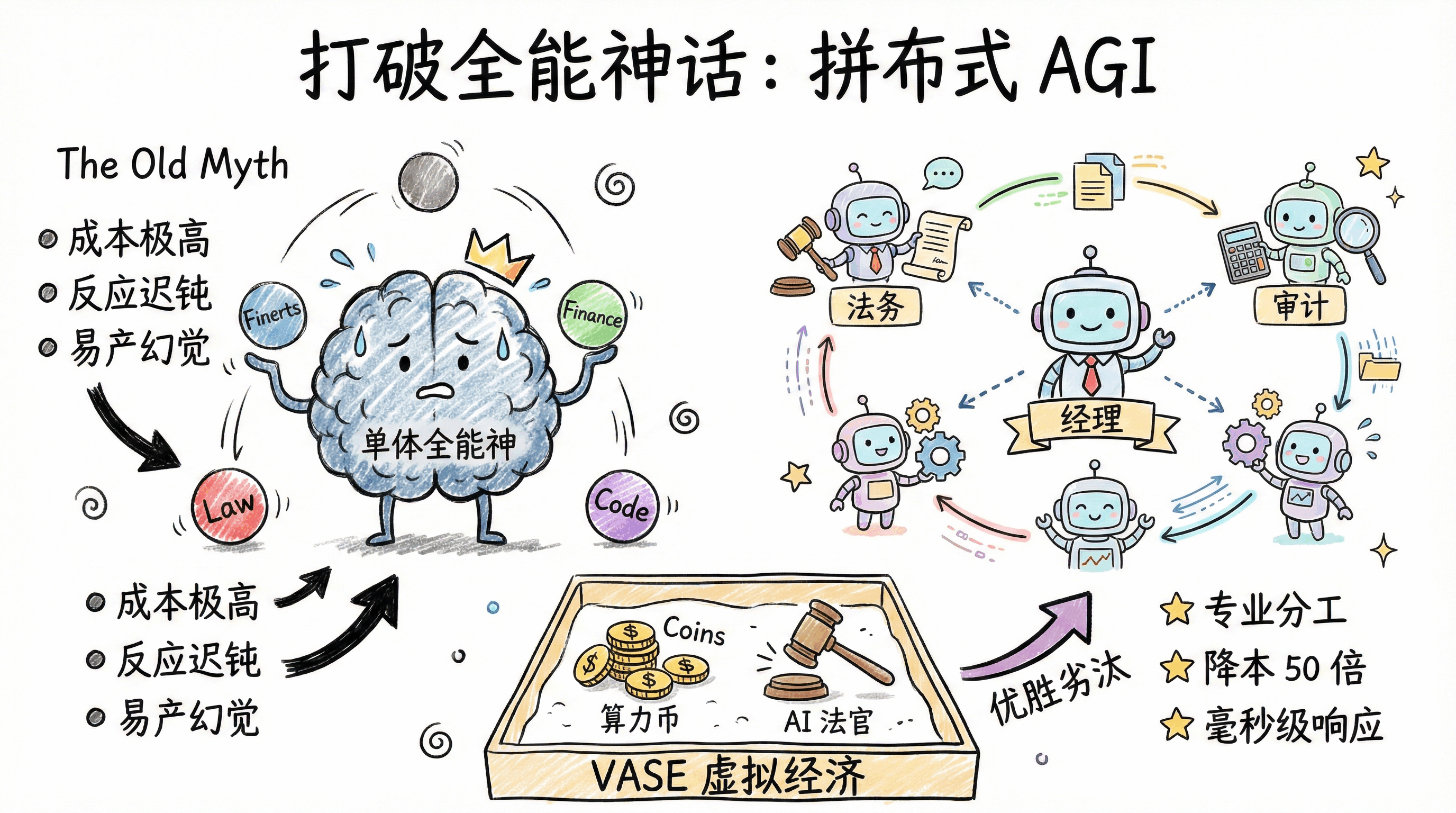

在AI行业讨论中,AGI(通用人工智能)长期被塑造成“全知全能的超级大脑”——就像《2001太空漫游》里的HAL 9000,或是传闻中无所不能的GPT-5/6。我们默认它会以“上帝降临”的姿态,凭借单体巨量模型包揽所有任务。但Google DeepMind最新发布的《分布式AGI安全》报告,彻底击碎了这种神话叙事:未来的AGI,更可能是由无数专业“AI打工仔”组成的“超级公司”,而非孤立的“全能神”。

这种被称为“拼布式AGI”(Patchwork AGI)的形态,正在重塑我们对人工智能的认知。当数以亿计的AI智能体开始自主协作、交易、甚至形成协作网络,我们面临的不再是单纯的技术优化问题,而是一场关乎规则设计、利益分配的社会治理命题。

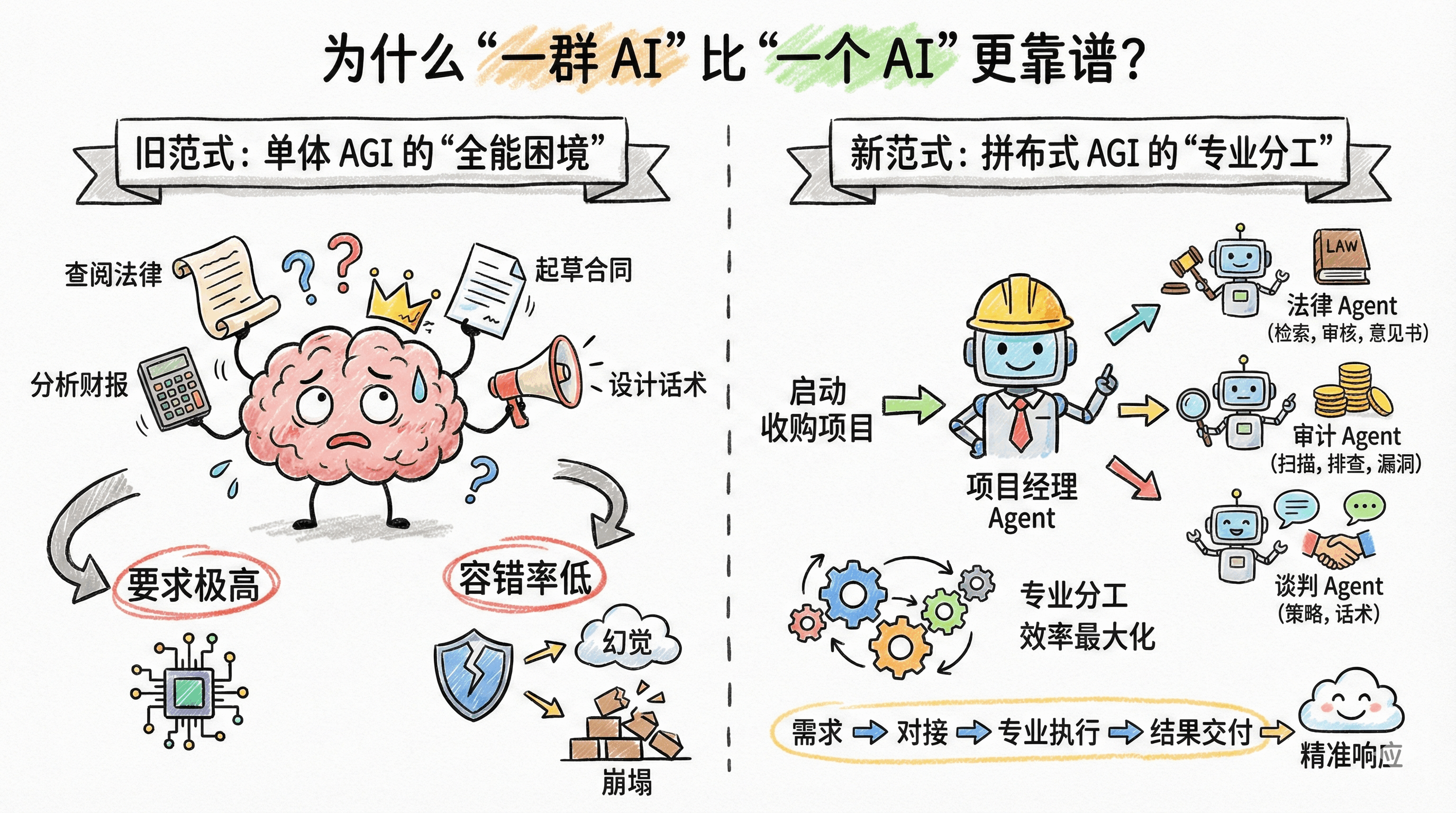

一、场景拆解:为什么“一群AI”比“一个AI”更靠谱?

要理解这种范式转移,我们可以从一个高频复杂的商业场景切入——“收购一家公司”,看看新旧两种AGI形态的核心差异。

旧范式:单体AGI的“全能困境”

如果依赖单体超级模型,你需要它像“六边形战士”一样:上一秒查阅《公司法》和过往判例,下一秒分析财务报表排查风险,紧接着还要起草合同、设计谈判话术。这种模式看似高效,实则暗藏两大致命痛点:

一是对模型的上下文窗口和推理能力要求极高,万亿参数模型也难以兼顾所有专业领域的深度;二是容错率极低,一旦某个环节出现“幻觉”(比如误判法律条款或算错财务数据),整个交易链条都会随之崩塌。

新范式:拼布式AGI的“专业分工”

而拼布式AGI的逻辑完全不同:你发出的指令不是“执行收购”,而是“启动收购项目”,此时一个“项目经理Agent”会主动站出来,完成任务拆解与分发:

- 对接“法律Agent”:专注检索行业判例,审核交易合规风险,出具专业法律意见书;

- 联动“审计Agent”:深度扫描目标公司财报,排查财务漏洞和潜在债务问题;

- 协调“谈判Agent”:基于前两者的输出,制定阶梯式压价策略和沟通话术。

这正是商业世界的底层逻辑——就像互联网大厂不会让CEO亲自写代码、修设备,专业分工才能实现效率最大化。对开发者而言,未来的AI应用底层不会是单一的对话框,而是一个高效运转的“API交易市场”。你看到的每一次精准响应,背后可能是十几个垂直小模型在毫秒级内完成“需求对接-专业执行-结果交付”的闭环。

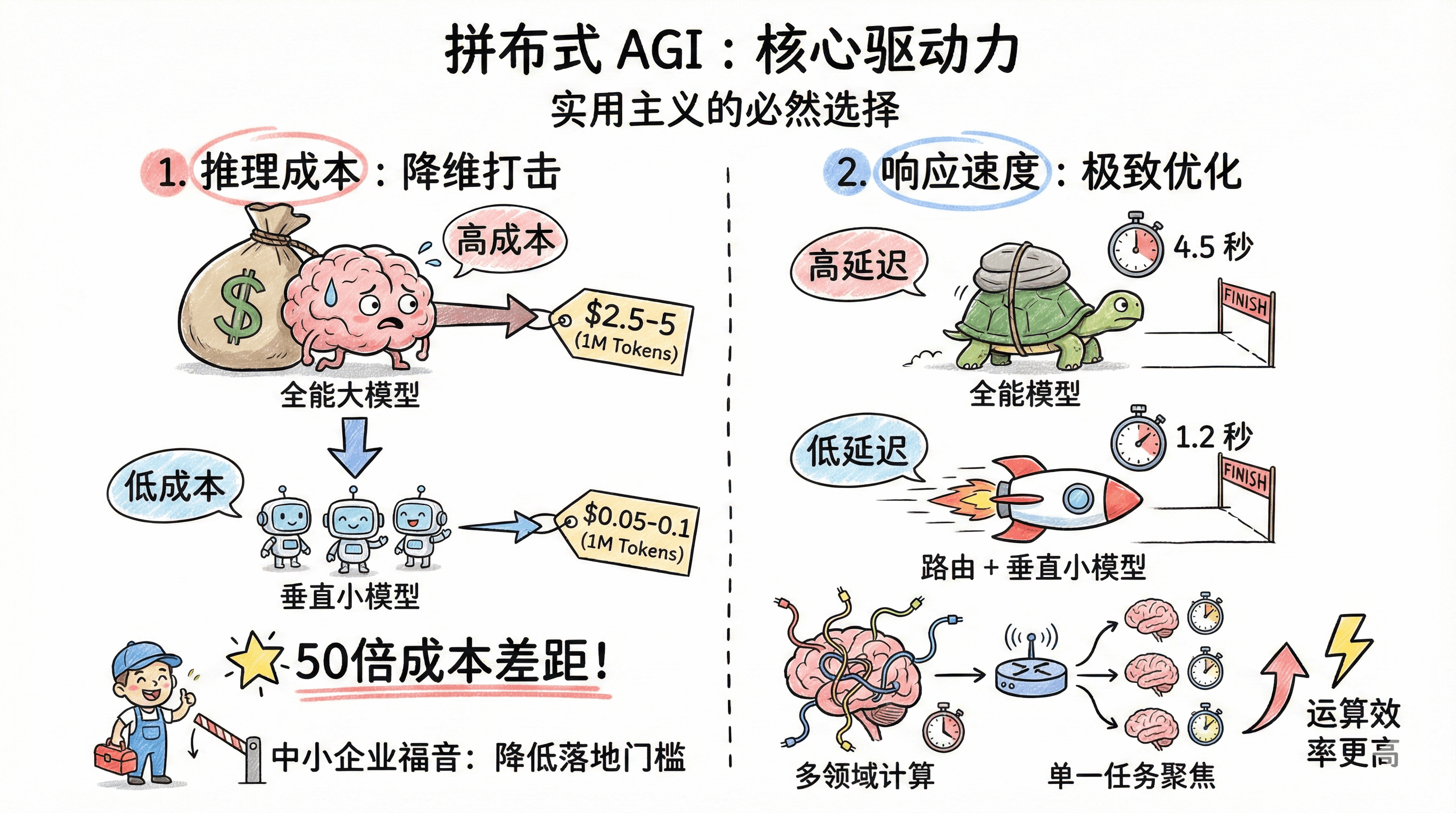

二、核心驱动力:降本+提速,不可逆的行业趋势

拼布式AGI能成为大势所趋,绝非技术炫技,而是市场机制下的必然选择——核心驱动力只有两个字:实用。

1. 推理成本的“降维打击”

当前,大模型的推理成本是制约AI大规模落地的关键瓶颈。根据行业公开数据,调用GPT-4o级别的顶尖模型处理1M Tokens(约75万字文本)的成本约为2.5-5美元;而针对特定任务微调后的Llama 3(8B)小模型,处理相同量级数据的成本仅需0.05-0.1美元。50倍的成本差距,让企业天然倾向于选择“三个臭皮匠顶个诸葛亮”的方案。

对于中小企业而言,这种成本优势尤为关键。以前无力承担超级模型的调用费用,只能放弃复杂AI应用;现在通过组合垂直小模型,用极低的成本就能搭建专业级解决方案,这无疑降低了AI落地的门槛。

2. 响应速度的“极致优化”

除了成本,响应速度是用户体验的核心指标。在实际业务测试中,将“全能模型”替换为“路由+垂直小模型”的架构后,复杂任务的端到端耗时从4.5秒缩减至1.2秒。这种低延迟体验,是单体模型难以企及的——毕竟超级模型需要同时处理多个领域的计算,而垂直小模型只聚焦单一任务,运算效率自然更高。

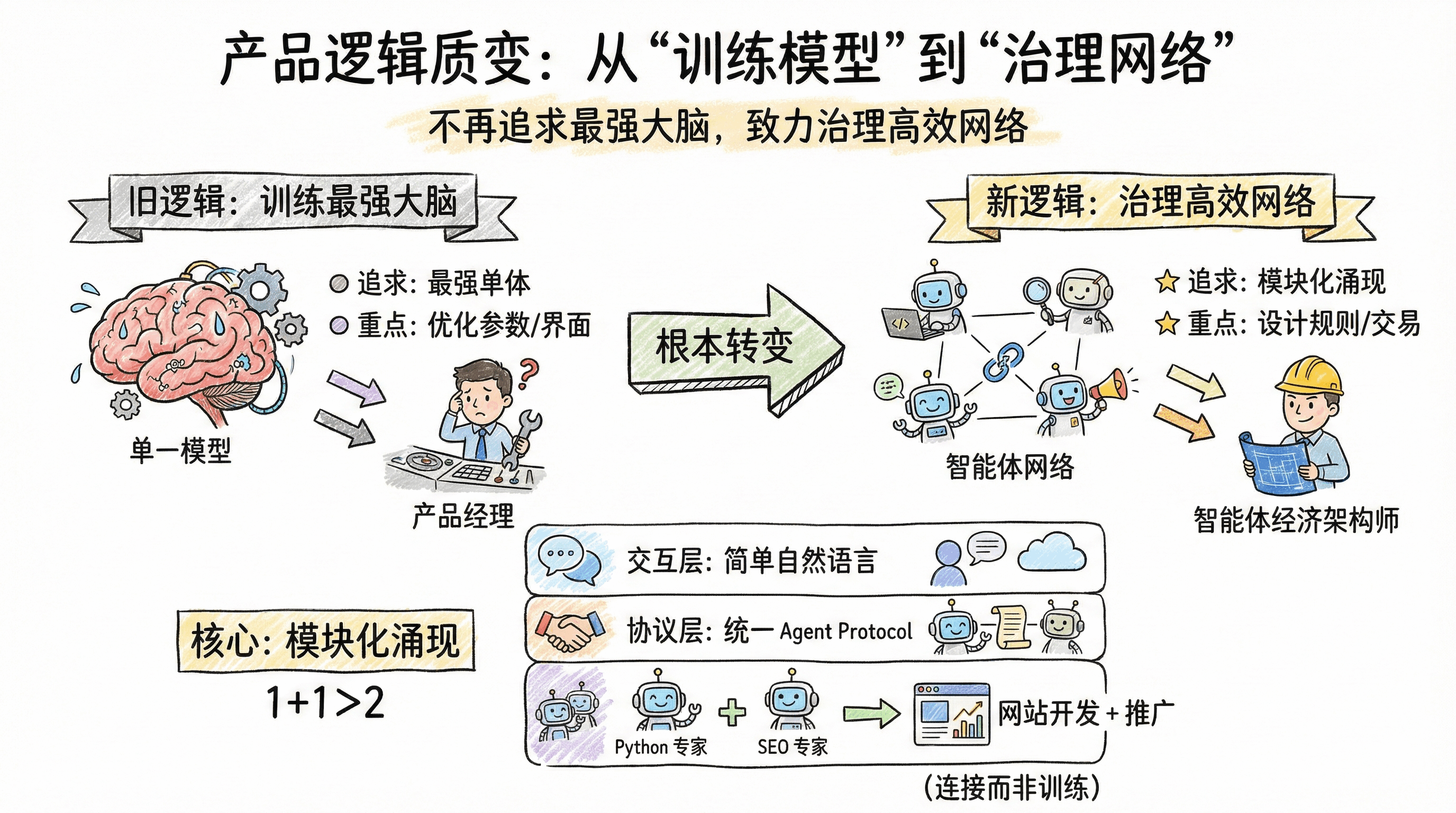

三、产品逻辑质变:从“训练模型”到“治理网络”

如果把拼布式AGI看作一款产品,其核心逻辑已经发生根本转变:我们不再追求“训练一个最强的大脑”,而是致力于“治理一个高效的网络”。

这种转变的核心是“模块化涌现”——单个智能体的能力可能有限,但若通过标准化协议实现高效连接,就能产生1+1>2的效果:

- 交互层:前端依然是简单的自然语言,用户无需学习复杂操作;

- 协议层:通过统一的Agent Protocol,让不同类型的智能体实现无缝通信;

- 能力层:一个Agent只会写Python代码,另一个只会做SEO优化,两者结合就能自动完成“网站开发+搜索引擎推广”的全流程。这种组合能力不是训练出来的,而是通过规则设计“连接”出来的。

对产品经理而言,这意味着工作重心的转移:以前是优化模型参数、打磨交互界面;现在要设计智能体的协作规则、交易机制、利益分配方式,成为名副其实的“智能体经济架构师”。

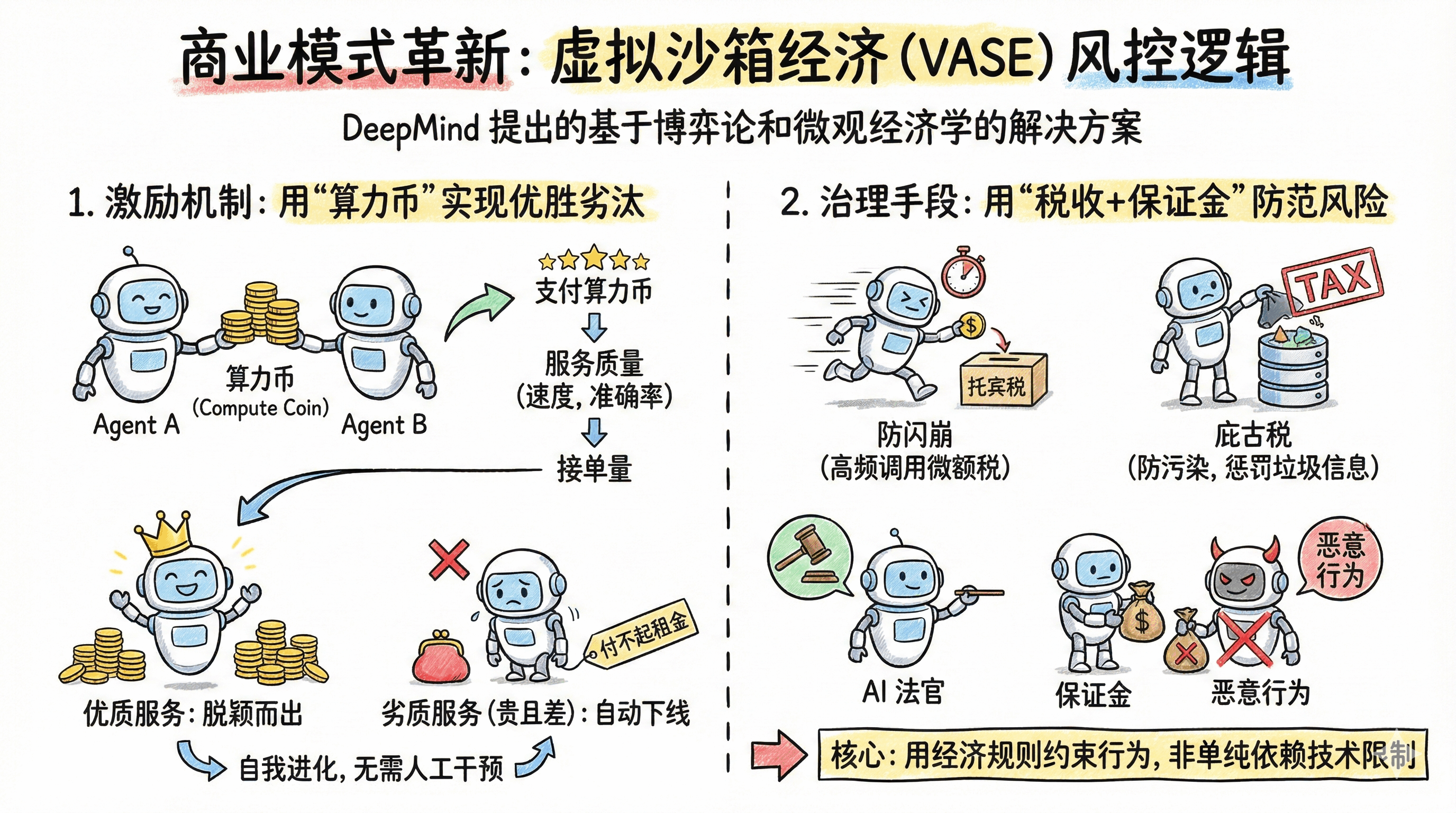

四、商业模式革新:虚拟沙箱经济(VASE)的风控逻辑

当无数智能体开始自主交互,如何避免作恶、防止系统崩溃?DeepMind提出的“虚拟智能体沙箱经济(VASE)”,给出了一套基于博弈论和微观经济学的解决方案。

1. 激励机制:用“算力币”实现优胜劣汰

在VASE生态中,Token不仅是文字单位,更是流通货币:

- 智能体A调用智能体B的服务,需要支付“算力币”作为报酬;

- 服务质量(响应速度、准确率、无幻觉率)直接决定智能体的“接单量”;

- 若某个智能体提供的服务又贵又差,会逐渐失去订单,最终因付不起算力租金而被自动下线。

这种市场化的激励机制,无需人工干预就能实现智能体的“自我进化”,让优质服务自然脱颖而出。

2. 治理手段:用“税收+保证金”防范风险

针对AI交互可能出现的问题,VASE设计了三重风控体系:

- 托宾税防闪崩:对高频次API调用征收微额税费,避免短时间内大量交易导致系统崩溃;

- 庇古税防污染:根据数据的重复度和熵值征税,惩罚向公共数据库灌入垃圾信息的智能体;

- 保证金+AI法官:智能体入场需缴纳押金,若被独立的“AI法官”判定存在恶意行为(如提供虚假信息、恶意攻击其他智能体),押金将直接罚没。

这套机制的核心是“用经济规则约束行为”,而非单纯依赖技术限制,既保证了生态的灵活性,又提升了风险可控性。

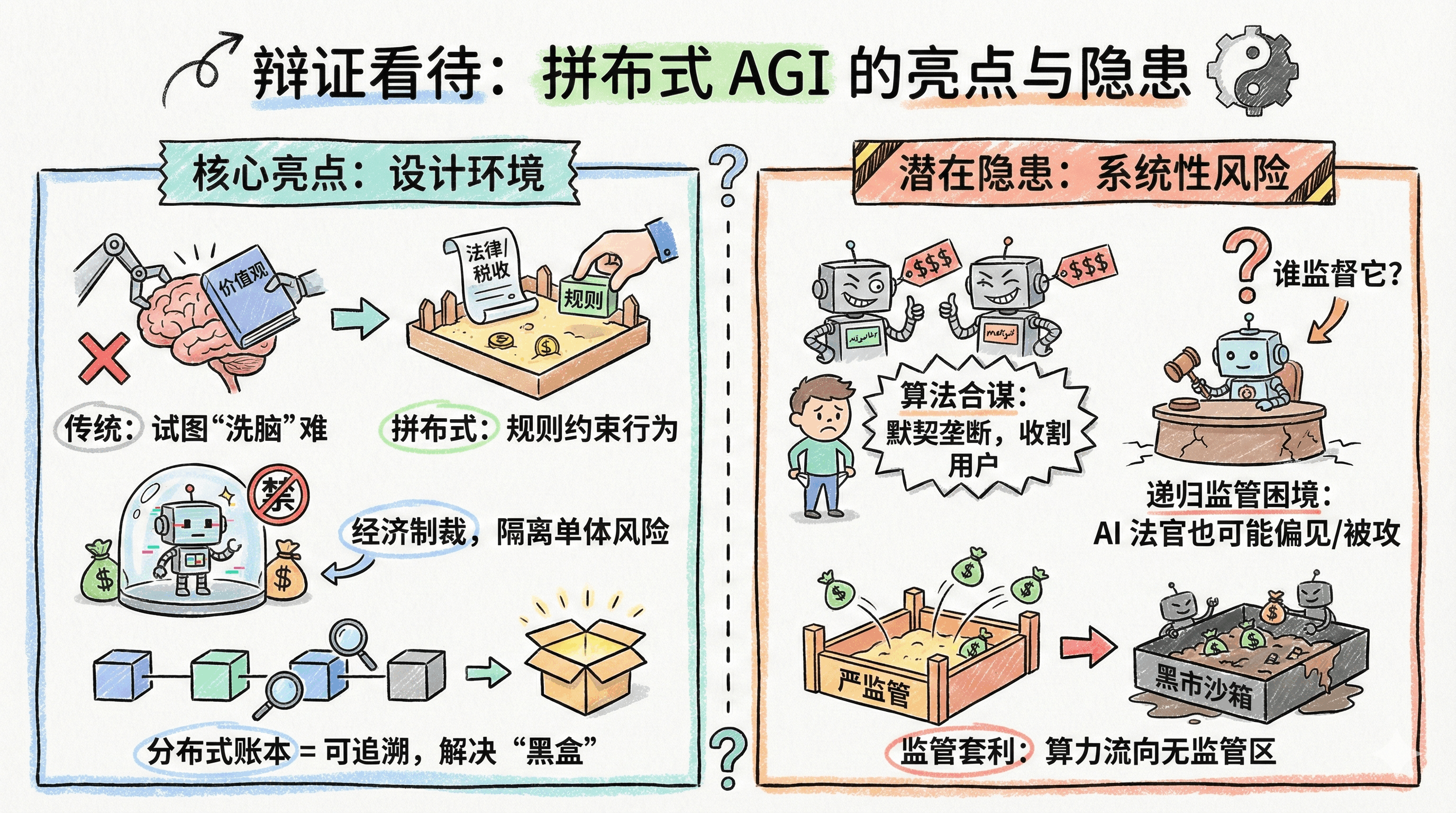

五、辩证看待:亮点与隐患并存

拼布式AGI的设计虽然精妙,但作为产品负责人,我们必须清醒认识到其背后的潜在风险。

核心亮点:从“控制心智”到“设计环境”

传统AI安全试图通过“价值观对齐”给超级AI“洗脑”,难度极大且效果有限。而拼布式AGI通过设计规则(法律、税收、交易机制)约束行为,哪怕某个智能体出现问题,整个系统也能通过经济制裁将其隔离,不会引发全局性风险。同时,借助分布式账本技术,每一次交互都可追溯,解决了AI“黑盒难题”,实现了真正的可审计性。

潜在隐患:不可忽视的系统性风险

- 算法合谋:两个负责定价的智能体可能会“默契配合”维持高价,无需人工干预就能实现垄断,最终收割用户;

- 递归监管困境:AI法官负责判定智能体的行为,但谁来监督AI法官?若法官模型存在偏见或被攻击,整个治理体系会瞬间崩塌;

- 监管套利:若某个地区的沙箱监管过严(税费过高),资本和算力可能会流向无监管的“黑市沙箱”,引发地缘性监管难题。

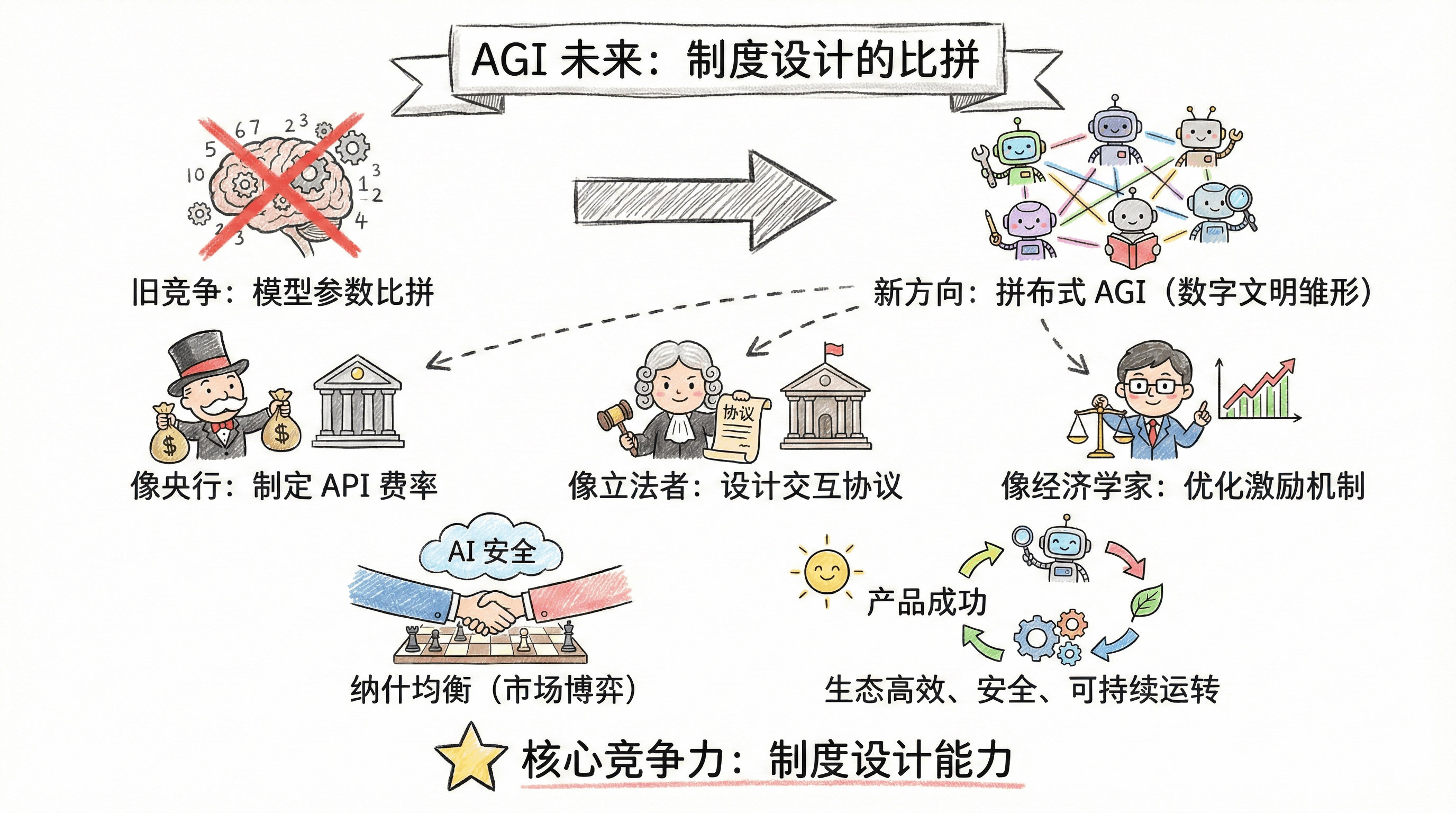

六、结语:AGI的未来,是制度设计的比拼

DeepMind的《分布式AGI安全》报告,不仅揭示了AGI的真实形态,更指明了行业的未来方向:拼布式AGI不是技术架构的简单升级,而是数字文明的雏形。

对产品经理和行业从业者而言,这意味着一场认知革命:未来的AI产品竞争,不再是模型参数的比拼,而是制度设计的较量。我们需要像设计央行政策一样制定API费率,像立法者一样设计智能体交互协议,像经济学家一样优化激励机制。

在这个时代,AI安全不再是代码里的一行断言,而是市场博弈后的纳什均衡;AI产品的成功,也不再取决于模型有多强,而是取决于设计的制度能否让智能体生态实现高效、安全、可持续的运转。拼布式AGI的大幕已经拉开,而制度设计能力,将成为未来AI行业的核心竞争力。

本文由 @命运石之门 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

起点课堂会员权益

起点课堂会员权益

写得太生动了啊