一个系统的 AI 知识架构:从模型原理到产品价值衡量

AI技术日新月异,但你真的理解背后的逻辑吗?本文深度拆解AI的底层架构与运行机制,从模型层的结构与能力、训练进化方式到生成原理,带你穿透技术迷雾,掌握判断AI产品价值的终极框架。

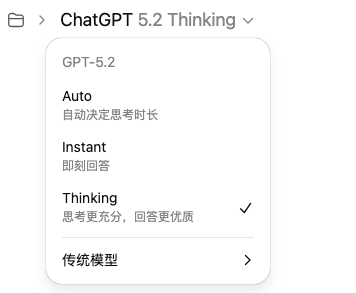

我们每天都能看到很多关于 AI 的新闻:Gemini 3 有多牛、GPT-5.2 又突破了推理能力、某个 Agent 跑完了整个流程……

看到这些,不知道你有没有和我有一样的思考:这些技术背后的本质区别是什么?我怎么判断一个 AI 应用是真创新还是昙花一现?

要回答这些问题,我们必须停止只关注“能做什么”,而开始理解 AI 的“工作原理”。

今天这篇文章希望提供一个系统的 AI 知识框架,从底层逻辑理解 AI 的“大脑”、“记忆”与“学习能力”。

内容很多,文章结构如下,请可以根据需要浏览相关内容:

- 模型层:AI “脑子”的结构与能力

- 训练与进化方式:AI 是怎么“变聪明”的?

- 生成机制:AI 为什么“会写、会画、会想”?

- 产品与系统层:AI 真正落地的地方

- 终极判断框架:如何识别一个好的AI产品?

一、模型层:AI “脑子”的结构与能力

1. 概念基石:大模型与多模态

1)大模型(LLM):所谓“大模型”,指经过海量数据自监督训练,能够适应多种任务的通用 AI 模型。它们是 AI 的“基石”,具备通识“常识”和多领域技能。

用处:大模型相当于 AI 的大脑底座,具备通识和多领域技能,可以在此基础上派生出各类专用模型和应用。

2)多模态(Multimodality):能够同时处理文字、图像、音频等不同形式的信息,就像人有视听触觉多种感官。它通过把各种模态的数据都转化为统一的表示(Token),让 AI 在同一框架下理解和生成不同媒介的内容。

用处:多模态让 AI 具备“看”、“听”、“说”的综合能力,可以实现看图对话、视频理解等复杂任务。例如,你可以问AI一张图里的内容,AI先将图像转成 Token 表示,再结合文字提问一起推理回答。

2. 推理:AI 的“长思考”与“短思考”

1)长思考 VS 短思考:指 AI 推理过程的深浅长短。有的AI模型回答问题“思考”很短,只经过一两步推理就给出结果,我们称为短链思维。而更强的模型会进行多步的推理和演绎,逐步完善答案,称为长链思维。研究表明,长链式的推理能让模型解决更复杂的问题。例如在数学推算、逻辑推理上,让模型逐步列出中间步骤能大幅提高准确率。

用处:具备长思考能力的 AI 可以处理复杂、多步骤的问题,类似人类的深入思考,而不仅是简单情形下的反射回答。

2)推理:推理是AI根据已有信息逻辑演绎出新结论的能力。大模型通过 Few-shot 提示(模型能够从少量示例中学习并泛化到新示例)或链式思维(上文提到的长短思考)可以显著提升推理能力,让 AI 不仅“背答案”,还能像人一样举一反三。用处:推理能力强的AI在数学证明、因果推断、规划等场景表现更佳。良好的推理让 AI 回答更可靠、有依据,减少胡乱瞎编的现象。

3. 容量:短期记忆与高效扩展

1)上下文长度:这是 AI 模型短期记忆的容量,指模型每次处理时能“看”多少输入内容。上下文越长,模型一次对话中能考虑的内容就越多。

用处:上下文窗口决定了模型在一轮对话中能参考多少信息。窗口越大,模型一次性交互就能处理越复杂的任务。但是超长上下文也带来开销和性能问题,需要通过技术(如检索、记忆模块)来权衡处理。

2)参数规模 vs. 有效计算量:早期用参数数量衡量 AI 能力,现在发现有效计算量(参数 × 训练数据量)才是关键。一味堆砌参数而没有足够数据训练是浪费算力。

DeepMind 提出的“Chinchilla定律”就证明了在给定计算预算下,模型参数和训练 Token 应按 1:20 比例扩增才能最优。

3)稀疏模型 / MoE(专家混合模型):它由多位“专家”子模型组成,每次仅激活部分专家参与计算。

意义:MoE 架构使得模型总参数可以极其庞大(万亿级别),但每次推理耗时却只接近小模型。这为扩大 AI 脑容量提供了新方案,是未来超大模型部署的关键。

二、训练与进化方式:AI是怎么“变聪明”的?

AI 如何从一个通用模型,成长为具备知识、符合人类价值观的助手?这依赖于系统的训练流程。

1. 缩放定律

“大力出奇迹”指的就是缩放定律:增加模型参数、数据量和算力会按幂律提升模型性能。

用处:缩放定律指导我们如何让 AI 更强,要么砸更多算力扩大规模,要么提高数据和模型利用效率。从GPT-2到GPT-3、GPT-4,每代提升很大程度上遵循了此定律:参数从15亿→1750亿→上万亿,训练数据也级数级膨胀,最终催生出涌现能力等惊喜能力。当然,光大不够,还需考虑性价比和边际效益,这正是 AI 研究的扩展与优化之处。

2.预训练

预训练是 AI “启蒙教育”的阶段。在这一步,模型被动学习海量无标注数据的统计模式,比如阅读整个互联网语料来学习语言表达的规律。

预训练通常采用自监督方式,比如遮盖一部分文本让模型预测,从而学到词语、句子之间的关系。通过预训练,模型掌握了常识知识和通用技能。用处:预训练后的模型相当于通才,知道大量百科知识、语言用法等。这为后续针对具体任务的微调打下基础。

3.后训练 / 对齐

预训练后的模型往往还不够“听话”或实用,需要进一步对齐人类需求。

这包括两方面:一是微调,用有标注的数据进一步训练模型,使其在特定任务上表现优秀;二是对齐,确保模型的行为和价值观符合人类期望,不乱说乱做。对齐技术中最突出的就是RLHF(人类反馈强化学习),即让模型根据人类偏好来调整回答。具体做法是:人类先对模型输出打分,训练一个“奖励模型”,然后让模型通过强化学习来最大化这个奖励,从而学会更符合人意地回答。用处:后训练和对齐让 AI 从“只懂概率堆砌”进化到“懂得用户意图”。经过这些步骤,模型不但能做题,还更有礼貌、更安全,知道避免有害言论、遵循人类指令等。对齐让 AI 从一个冷冰冰的模型变成一个“贴心的小助手”。

4.强化学习(RL)及其变体(RLHF、RLAIF)

强化学习是 AI 像“小白鼠走迷宫”那样,通过试错获得奖励来学策略的方法。在大模型训练中,RL被用于让模型输出更符合人类喜好(即上面提到的RLHF)。

RLHF的流程是:收集人类对模型输出的偏好反馈,用于训练奖励模型,然后用这个奖励指导模型调整策略。它的难点在于需要大量高质量人工反馈,成本高、速度慢。为了解决这一瓶颈,出现了RLAIF等新方法。RLAIF的思路是用一个现成的大模型(如GPT-4)来自动生成对比反馈,代替人工标注偏好,再训练奖励模型进行强化学习。用处:这些RL方案让模型学会迎合人类期望。RLHF 赋予了ChatGPT礼貌稳重的风格,而 RLAIF 这种新技术有望降低训练成本、扩大对齐规模,因为 AI 自己来提供反馈更高效。

5.合成数据

这是让AI自我提升的“资料库”。简单说,合成数据就是模型自己造的训练数据。例如,GPT-4可以生成问答对、写文章,再用于训练一个较小模型;或大模型自问自答产生新的对话数据,丰富训练集。合成数据可以覆盖真实数据的不足,比如敏感领域、私有场景的数据。

用处:合成数据为模型训练提供了取之不尽的“练习题”。在真实数据有限或敏感的情况下,合成数据能弥补数据短板。例如企业可以让模型基于少量真实客服对话,合成出海量相似对话训练数据,从而定制一个客服 AI。同时,合成数据还能规避隐私问题。当然,前提是生成的数据质量要足够好,否则模型可能学偏。但总体而言,这是 AI自我进化的重要方向。

6. 自我博弈 / 自我改进

让AI和自己对抗、自己提升,最著名的例子莫过于AlphaGo Zero,没有任何人类棋谱指导,纯靠 AI 自我对弈,在短短3天内击败了上一代冠军版本,以40天自学超越了所有前辈,登顶围棋之神。

自我博弈背后的原理是:AI在与自己竞争中不断发现新策略,强化优势、修正失误。在大模型领域,自我改进更多体现在AI利用自己的输出再学习,如自我反馈机制:模型生成一个答案后,再生成对这个答案的评价和改进意见,最后更新答案。这样循环几轮,往往质量明显提高。类似地,模型可以进行自我调试,比如让编程 AI 输出代码后自己找 bug 修复。用处:自我博弈和改进让 AI 具备“闭环学习”能力,不需要人类时时教导。在无人监督的情况下,AI也能越练越强。对于大语言模型,自我改进意味着更少依赖人类标注数据,能自发提高解决问题的正确率,是迈向更高级智能的重要一步。

三、生成机制:AI为什么“会写、会画、会想”

1. 自回归模型

绝大多数生成式 AI(如GPT)都属于自回归模型,它们通过逐步预测下一个内容单元来生成序列。具体而言,模型给定前文,预测下一个Token,然后将这个 Token 并入前文再预测下一个,如此循环。

用处:自回归模型广泛用于文本生成(聊天、写稿)、代码生成,甚至图像、音频序列生成等。例如 GPT 系列模型读取你的提问,然后从开头第一个字依次往后写答案,每输出一个词就把它作为条件去预测下一个,所以能生成连贯的段落。

自回归模型善于保持上下文连贯和局部合理性,但因为缺乏全局规划,有时可能跑题,这是当前让 AI “张口就来” 的核心机制。

2. 扩散模型

如果说自回归像是画家一点点往画布上添加,那么扩散模型就是先泼一层噪点再慢慢擦出画。扩散模型最初在图像生成领域大放异彩。

其原理包括两个过程:正向扩散把训练图像逐步加入噪声,直到变成纯噪声;然后反向扩散训练模型学会从噪声一步步还原出图像。

直观比喻:把一张猫的照片逐渐模糊成雪花点,然后模型学着如何把雪花点变回猫。

生成时,模型先取一团随机噪声,应用反向扩散一步步“除噪”,最终产出一张清晰图像。这样的好处是生成结果质量高、细节丰富,而且可以控制生成过程。

用处:扩散模型如今是图像、音频生成的主力军。著名的Stable Diffusion、Midjourney 等图像 AI 都用它,让你输入文字描述就能“扩散”出相应的图像。它还被用于生成视频、合成语音等。

3. 世界模型

世界模型指AI在内部构建的一个可模拟环境/问题空间的模型。

与其说是一种具体模型架构,不如说是一种思路:让 AI 不直接映射输入到输出,而是先在脑海中形成对外部世界的状态表示,再在这个“心智世界”中推演行动的结果,从而做出更明智的决策。

一个典型案例是Meta发布的代码世界模型:让代码生成AI不仅会写代码,还在脑中模拟代码执行过程、推理程序状态、自我检查逻辑。也就是说,当人类程序员写代码时,会想“如果这段运行,变量会是什么值?”

用处:世界模型的意义在于赋予AI“想象力”和内在检验能力。AI 不再只是模式匹配,而是能够在自己构建的世界里尝试和推理。这对于需要多步骤推理、模拟未来的任务非常关键。

四、产品与系统层:AI 真正落地的地方

1. Copilot vs Agent

在AI产品中,常出现“AI助手(Copilot)”和“AI智能体(Agent)”这两种角色。二者有何区别?

Copilot 可理解为“副驾驶”:始终有人类在主导,它提供智能建议和辅助,但不完全自主。比如 GitHub Copilot 在你编码时自动补全代码,但最后是否采用、如何修改由你决定。Agent则更像“自动驾驶”:给定一个目标,它能自主决策并执行一系列操作来完成任务,自主性更高。用处:Copilot 型产品提升了个人效率,但 Copilot 不会自行跨越多个应用帮你做一个完整项目。而 Agent 型 AI 可以担任流程自动化角色,Agent的强大在于解放人力、自动化执行;Copilot 的价值在于赋能个人、提高质量。两者并非对立,而是适用于不同场景。

2. 记忆

AI 产品中的记忆可以分为短期记忆和长期记忆。

短期记忆类似人类的工作记忆,模型通过上下文窗口维护最近的对话或当前任务的临时信息。比如聊天AI能记住你刚才说的话,这是因为这些对话历史还在上下文窗口内。但短期记忆容量有限,一旦对话太长,早先内容就会被遗忘清除。

长期记忆则是让 AI跨会话、跨任务地保留知识的机制,相当于大脑的永久记忆。这通常需要借助外部存储或知识库,如向量数据库、知识图谱等,把重要信息存下来。

用处:短期记忆保证单次对话的连贯性,避免AI像鱼一样7秒记忆;长期记忆让AI 具备“学习积累”能力,随着使用时间推移变得越来越懂你或越来越专业。可以说,没有记忆的AI只是个一次性工具,有了记忆的AI才算真正生长型的产品。

3. 工具调用

人类遇到问题会借助工具(比如计算器、搜索引擎),AI也类似。大模型内置的知识有限,而且不擅长精确计算或实时查询,于是调用外部工具就成为 AI 扩展能力的途径。

例如一个对话 AI 遇到复杂算术时,调用计算器 API 算出结果再回答;或接到询问实时天气,调用天气服务获取最新数据再回复。

用处:工具调用让AI产品能力边界大大拓展。过去模型问到不会的问题只能瞎编,而现在它可以查资料再回答。

4. 工作流

AI 产品中,工作流泛指把 AI 能力融入既定流程,或编排多个AI/工具形成的复杂流程。

传统的工作流是预定义的顺序步骤,流程图写死,每步按固定逻辑执行。而Agent 强调的是动态决策、灵活应变,不一定按固定路线走。

二者各有用武之地:如果任务流程清晰标准,比如报销审批,可以用规则工作流自动流转;但如果问题开放复杂,比如“帮我筹划一场活动”,可能就需要 Agent 在执行中计划新子任务、调整顺序。

AI 产品中经常结合两者优势:Flow + AI。比如某企业客服系统,会先用工作流引擎把用户请求分类、调用 AI 回答FAQ;遇到 AI 回答不了的再按流程升级给人工。这其实是静态流程和智能决策的融合。

用处:AI 产品不仅是一个模型在真空中工作,而往往嵌入在业务流程里。好的AI 产品设计,会理顺 AI 与现有系统流程的配合:哪些环节AI自动处理,哪些环节人工复核,错误了如何回滚等等。这确保AI落地可控可靠。

5. 搜索增强(RAG)

现实中我们回答一个陌生问题,往往不是“凭记忆硬答”,而是先去翻资料,公司制度、产品手册、历史工单、合同条款、研究报告。

AI 也一样:大模型虽然懂很多通用知识,但对你企业/你行业的私有内容往往既不知道、也不够新,硬让它答就容易“看起来很对、实际上在编”。

于是就有了 RAG(检索增强生成):在回答之前,系统先到你的知识库里检索出最相关的几段资料(比如从内部 Wiki、CRM、客服工单),再把这些资料作为“参考材料”交给模型,让它基于材料生成答案,必要时还可以把引用出处一起给出。

用处:第一,让回答真正贴合企业私有知识,而不是泛泛而谈;第二,显著降低幻觉,因为模型有了可依赖的依据;第三,知识更新更快,文档更新后重新入库即可,不必重新训练模型。

五、终极判断框架:如何识别一个好的AI产品?

综合以上概念,我们可以从技术、能力、壁垒、体验等维度,来判断AI产品是“平庸的噱头”还是“优秀的系统级产品”:

- 底层技术:差的产品通常只是简单调用现成大模型API,没有融合任何自有数据或独特架构;优秀产品往往引入企业自身知识(如检索增强 RAG),利用链式思维提高推理,甚至针对特定任务做了专门微调或插件扩展。这意味着后者在算法上对基础模型有所增强,不是任何人轻易复现的。

- 思考能力:优秀产品实现了长思考能力,具备复杂任务的分解和规划。比如能将一个大任务拆解成多步,由多个Agent分工协作完成(群体智能涌现),或通过工具调用和长链推理解决开放性难题。这反映在用户体验上,后者能搞定真正复杂的需求,而不仅限于闲聊或背答案。

- 价值壁垒:差的产品毫无数据积淀,不管服务多少用户都没学到新东西,用户迁移成本为零;优秀产品通过强化学习或自监督从交互中持续沉淀专有模型,并利用 RAG 积累了独家的知识库。这意味着时间越久产品越聪明,用户即便有别家模型,也难以得到这个产品里的特定知识和定制效果。

- 交互模式:差的产品可能只提供一个简陋的 Prompt 输入框,用户得自己想办法用对提示词,稍不注意 AI 就答非所问;优秀产品追求无提示词的自然交互,可能通过预置对话引导、选项按钮等让小白用户也能玩转。此外,它可能融合语音、视觉等多模态输入输出,超越纯文本界限。

好产品=强大模型脑力 + 深度场景融合 + 不断进化提升 + 优秀交互体验。反之,只有模型而无产品力,只能是“纸上谈兵”。如果你看到这里,祝你开心,不止今天。

作者:张艾拉 公众号:Fun AI Everyday

本文由 @张艾拉 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自作者提供

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益