AI PM 进阶笔记【2】:Agent-万字详解-含案例讲解(科普向)

2025年,AI将从‘会说话’进化到‘会干活’。AI智能体(AI Agent)不再是简单的聊天机器人,而是能够感知环境、规划任务、调用工具并主动推进目标的‘数字员工’。本文将系统性拆解AI智能体的完整知识体系,从核心认知架构到企业级落地细节,深入探讨规划算法、记忆系统和工具使用的关键技术,并展示如何在电商客服等高频场景中实现‘Agent+RAG+长期记忆’的落地流程。

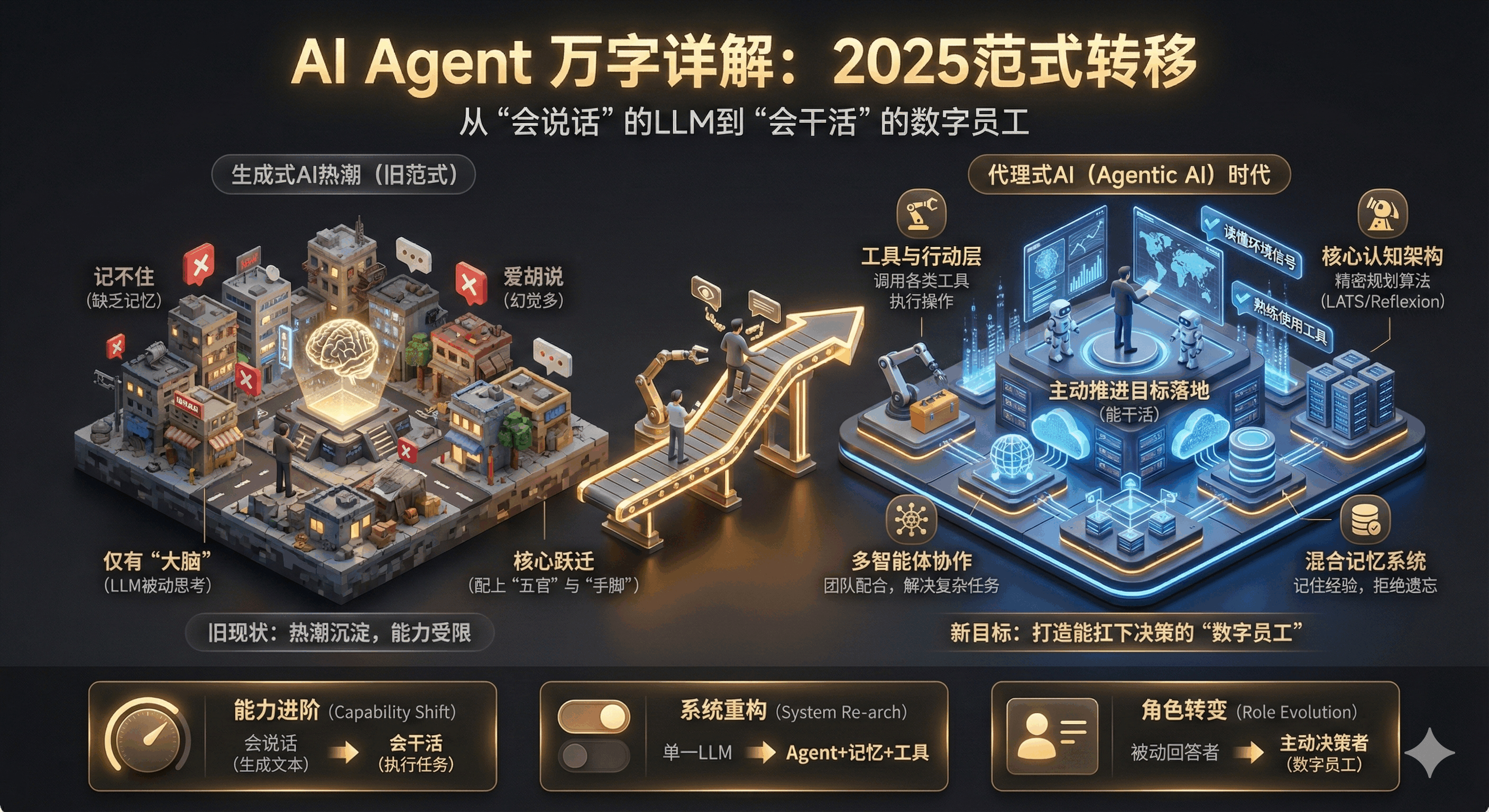

1. 范式转移:2025,AI从“会说话”到“会干活”

2025年绝对是AI发展的“分水岭”——生成式AI的热潮逐渐沉淀,代理式AI(Agentic AI) 正式成为舞台主角。如果说大语言模型(LLM)给机器安上了“会思考的大脑”,那AI智能体(AI Agent)就是给它配上了“能感知的五官”和“会行动的手脚”:能读得懂环境信号、记得住过往经验、用得了各类工具,甚至能主动推进目标落地。

今天我们就来系统性拆解AI智能体的完整知识体系——基于对当前技术前沿的深度调研,从概念源头讲到企业级落地细节,涵盖核心认知架构、混合记忆系统、多智能体协作演进,还会拿电商客服这个高频场景,拆透“Agent+RAG+长期记忆”的落地流程,顺便聊聊可观测性和安全性的标准化方案。

我们调研发现,未来企业的AI竞争壁垒,早已不是模型参数大小,而是代理架构的设计功力——能不能靠精密的规划算法(比如LATS、Reflexion)和分层记忆机制,解决LLM“记不住、爱胡说”的老毛病,最终造出能扛下15%以上企业日常决策的“数字员工”。

2. 搞懂智能体:从认知模型到5个智能层级

要落地AI智能体,先得把它的核心逻辑扒清楚——从理论根源到运作机制,再到智能分级,一步到位讲明白。

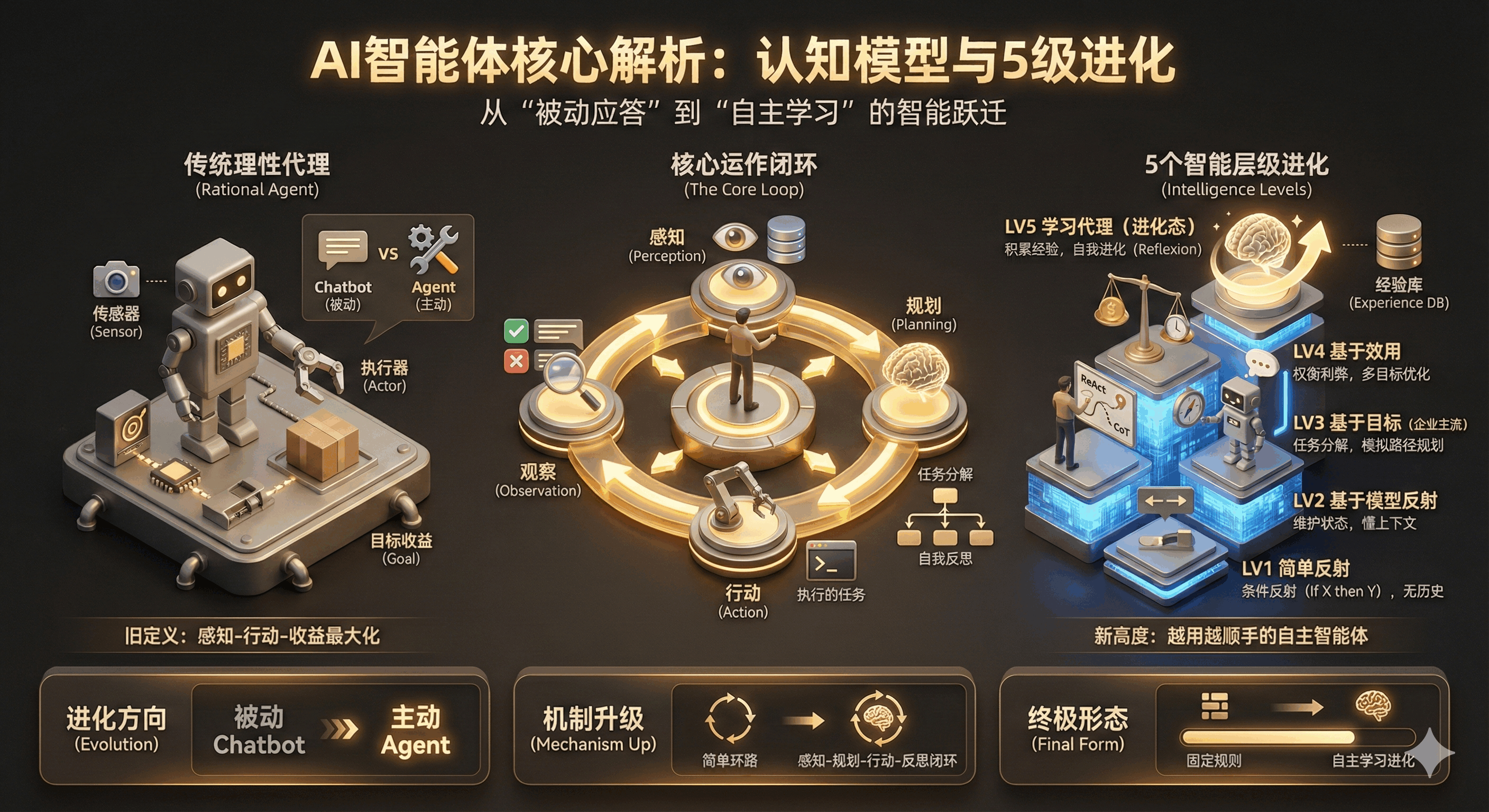

2.1 从“理性代理”到“LLM驱动”:智能体的进化史

“Agent”(代理)可不是新名词,早就在经典AI理论里有定义:所谓理性代理,就是能通过传感器感知环境、通过执行器作用于环境,还能最大化目标收益的实体。

但2025年的AI智能体已经完全升级:以LLM为核心“认知控制器”,自带自主性、反应性、前瞻性和社交性。和传统聊天机器人(Chatbot)比,差别简直天翻地覆:Chatbot是“你问我才答”,只能做即时语言生成;而AI智能体能“自己找事做”——拿到高层目标后,会拆任务、做规划、调工具,遇到错还能自我修正,直到把事办成。

2.2 核心运作逻辑:感知-规划-行动-反思闭环

AI智能体的干活流程,本质是一个不断循环的“行动链”,也就是感知-规划-行动(Perception-Planning-Action)循环,高阶版本还会加个“反思”环节:

1)感知(Perception)相当于“收集情报”。智能体通过“传感器”拿外部信息——可能是用户的提问、API返回的JSON数据、数据库里的记录,甚至是环境状态的变化。

2)规划(Planning)是“大脑决策”的核心。拿到情报和目标后,会做两件关键事:

一是任务分解(比如把“分析本季度销售数据并生成报告”拆成“查数据库→跑分析脚本→写摘要”);

二是自我反思(评估之前的操作有没有用,要不要调整方案)。

3)行动(Action)就是“动手做事”。通过“执行器”和外部交互,比如调用工具、执行代码、发HTTP请求,甚至操作GUI界面。

4)观察(Observation)是行动后的反馈环节——可能是API返回的错误码,也可能是查询到的有效数据,这些反馈会变成新的“感知输入”,触发下一轮循环。

2.3 5个智能层级:从“简单反射”到“自主学习”

结合经典分类和LLM特性,现在的AI智能体能分成5个层级,越往上越“聪明”:

- 简单反射代理-Agent是最基础的“条件反射”,遵循“如果X发生,就做Y”的规则,只看当前输入,不管历史。在LLM实现上类似零样本提示,用户发指令,模型直接映射到工具调用,不做多步推理。但这种代理的短板很明显,环境一变就失效,比如需要跨步骤的任务(“先查订单再退款”)根本搞不定。

- 基于模型的反射代理-Agent能记“近期事”,会维护内部状态,比如知道用户“已登录”“刚才问过退款”,结合“世界模型”理解局势。在LLM实现上会引入对话历史和上下文窗口,能看懂代词指代(比如“它”指之前聊的商品)。

- 基于目标的代理-Agent是企业级主流款,有明确目标,会用搜索、规划算法模拟行动路径,选最优方案。LLM实现上会采用ReAct、CoT(思维链)框架,执行前先“想清楚”:“我要做什么,为什么这么做”。

- 基于效用的代理会-Agent“权衡利弊”,遇到多路径或目标冲突时,用效用函数判断“哪个更好”,比如订票时在“价格低”和“时间近”之间做选择。LLM实现上会在提示词里加复杂偏好指令或奖励模型,能处理多目标优化问题。

- 学习代理-Agent是能“自我进化”的高阶形态,包含学习、性能、批评、问题生成四个组件,能在未知环境中积累经验。LLM实现上会结合Reflexion架构或强化学习,把成功经验写入长期记忆,失败教训变成规则,不用更新模型参数也能越用越顺手。

3. 智能体三驾马车:规划、记忆、工具使用

一个能落地的AI智能体系统,离不开三大核心组件——规划(会思考)、记忆(记得住)、工具使用(能办事),三者缺一不可。

3.1 规划:从“线性思考”到“树状推演”

规划能力是智能体解决复杂问题的关键,把LLM从“文本生成器”变成“逻辑推理机”:

- 思维链(CoT)是基础中的基础,在提示词里加一句“让我们一步步思考”,就能诱导模型生成中间推理步骤,减少逻辑跳跃和幻觉。但它的缺点是线性结构,一步错步步错,适合处理中等复杂度任务。

- ReAct模式是工业界标配,把“思考”和“行动”绑在一起:思考→调用工具→获取结果→再思考… 比如API调用失败,能看到错误信息并修正参数,比纯CoT灵活多了,特别适合需要实时交互的场景。

- 高阶玩法还有Reflexion与LATS:Reflexion(反思架构)会加个“评价者”角色,任务结束后复盘执行轨迹,生成“反思记忆”,下次遇到类似任务避免踩坑;

- LATS(语言代理树搜索)则结合蒙特卡洛树搜索,不只走一条路,而是探索多条行动分支,通过选择、扩展、反向传播三个步骤,像棋手一样“推演”最优路径,复杂代码生成、逻辑谜题都能搞定。

值得注意的是,规划还有两种核心组合模式:

- 先分解后规划(比如Plan and Solve模式)会先拆完所有子任务,再为每个子任务制定执行细节,逻辑严谨,适合数学计算、符号推理等“步骤固定、容错率低”的任务,但缺乏灵活性——若初始拆解有遗漏,或某一步执行失误,会导致整体流程卡顿;

- 边分解边规划(比如ReAct模式)则是拆一个子任务→规划该子任务的执行步骤→执行后再拆下一个,能根据实时反馈调整,适合需要交互、环境多变的任务,但任务流程过长时,LLM可能因上下文过载导致后续拆解偏离目标。

3.2 记忆:解决LLM“健忘症”的关键

LLM本身是“无状态”的,记忆系统就是给它装“记事本”,不仅有明确的分类分工,还有科学的存储和管理方式。

记忆主要分三类:

- 感知记忆是瞬时缓存,比如用户刚发的原始指令,没加工过的“素材”,存得快、清得也快,只负责给后续记忆层“递素材”;

- 短期记忆是当前会话的上下文,比如多轮对话历史、推理草稿,通常存在LLM上下文窗口或Redis里;

- 长期记忆又细分为情景记忆(“用户上周三退了双鞋”)、语义记忆(“用户偏好靠窗座位”)、程序记忆(“怎么调用退款API”)。

这里的感知记忆很特殊,它是类比人类记忆机制的技术逻辑,对应的是Agent感知模块采集的原始信息,比如传感器获取的环境数据、接口抓取的文本/图像/音频数据等,这些数据还未经过筛选解析,是“未加工的原始素材”。它的核心特征是瞬时性、容量有限、无语义加工,和人类感觉记忆的关键区别在于,它是人为设计的“数据缓存机制”,不是Agent自主产生的“感知印象”,目的是解决“感知数据处理不及时”的问题,避免原始输入丢失。

为了突破上下文窗口的“记忆墙”,现在都采用分层存储策略:

- Redis作为“热存储”,存短期记忆和会话状态,读写速度快,能保证实时响应;

- 向量数据库(比如pgvector、Milvus)作为“冷存储”,把长期记忆转成向量存着,新任务来的时候用语义检索调取相关历史;

2025年的最佳实践是“混合检索”,把关键词检索和向量检索结合起来,比如先靠SQL过滤用户ID,再在结果里做语义搜索,既保证安全性又提升准确率。

记忆管理还有专门的工具:

- Mem0能自动管理记忆生命周期,决定该存该删,还支持多粒度记忆隔离(用户级、会话级);

- Letta(原MemGPT)则借鉴操作系统内存管理,把上下文窗口当“内存”,向量库当“磁盘”,能自主加载关键信息,实现“无限上下文”。

而智能体的记忆更新机制也很关键:

主要分两步:

提取和更新。用户和智能体聊天的内容(消息、对话),会先交给大模型“提炼”——把聊天里的关键信息、人物/关系找出来;之后提炼出的新信息,会和原来存在向量数据库、图数据库里的旧记忆合并,再存回去,相当于智能体“把新事儿记到自己的笔记本里,和老事儿放在一起”,后续再处理相关任务时,就能同时用到新记的和以前记的内容。

3.3 工具使用:智能体连接世界的“手”

工具使用是智能体落地的最后一步,现在有三种主流方式:

- Function Calling简单直接,模型输出JSON结构,指定要调用的函数和参数;

- MCP(模型上下文协议)是2025年的行业标准,能解决工具碎片化问题,通过统一接口访问本地文件、GitHub、SaaS API,还自带安全网关;

- CodeAct是新兴范式,不调用预定义API,直接写Python代码完成任务(比如数据分析、文件操作),灵活性极高,但对沙箱安全性要求也更高。

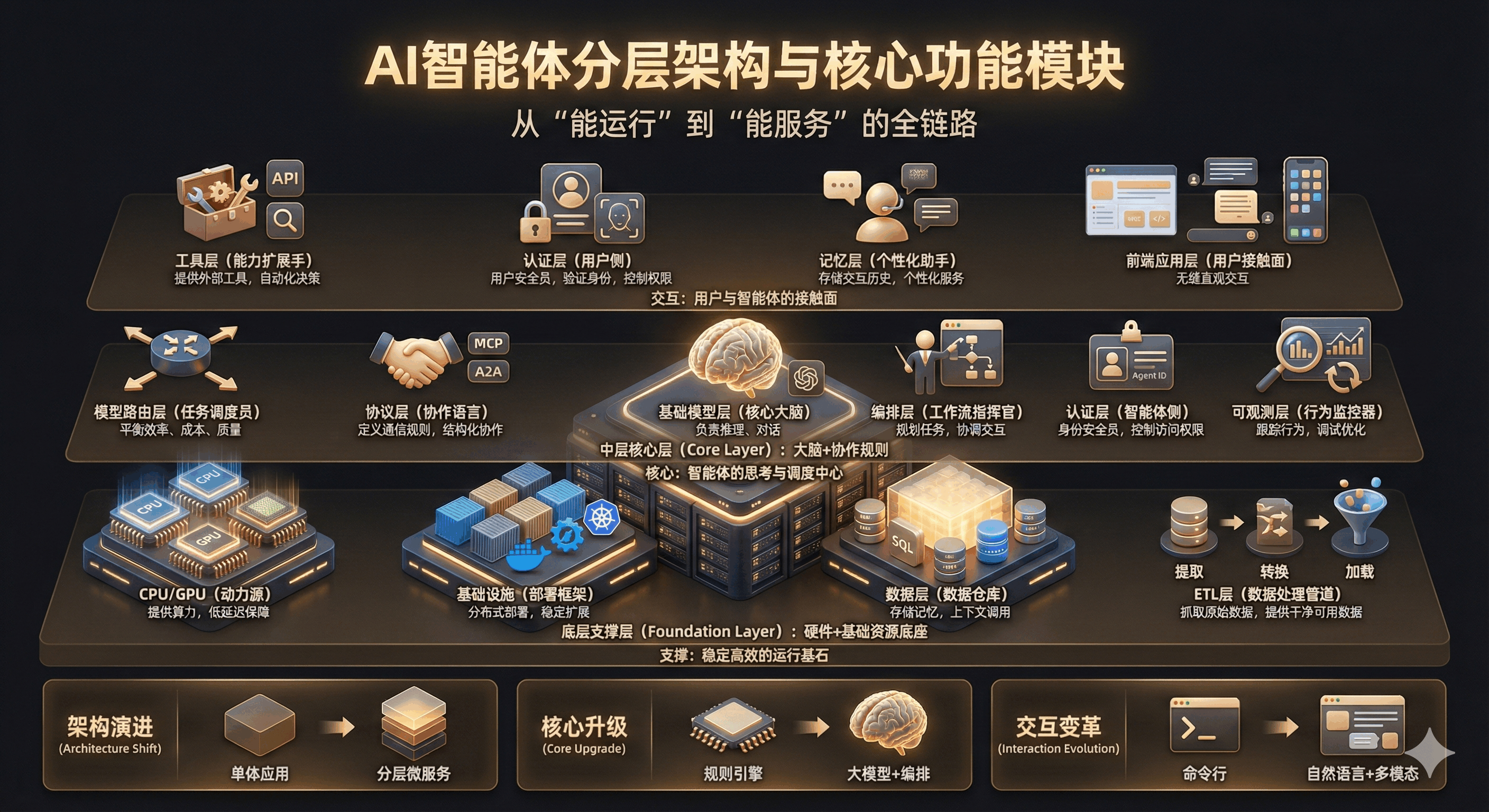

4. 智能体的分层架构与核心功能模块

4.1 分层架构:从“能运行”到“能服务”的全链路

AI智能体的技术架构遵循“底层支撑→中层核心→上层交互”的逻辑,各层环环相扣,确保系统稳定、高效、安全运行:

1)底层支撑层:整个架构的“硬件+基础资源底座”,包含CPU/GPU提供:

- 商层:解决“AI智能体如何落地运行”的问题。CPU/GPU提供商层是“动力源”,提供AI训练和推理所需的算力,低延迟特性保障智能体响应速度;

- 基础设施层:“部署框架”,用容器(如Docker)、编排工具(如K8s)实现智能体的分布式部署,解决“多场景扩展”“稳定运行”问题;

- 数据层:“数据仓库”,存储智能体的“记忆”和上下文,支持结构化、向量化数据的实时调用;

- ETL层:“数据处理管道”,从各类数据源抓取原始数据,经“提取→转换→加载”流程,为上层提供“干净可用”的数据。

2)中层核心层:智能体的“大脑+协作规则”,包含:

- 基础模型层:“核心大脑”,大模型负责复杂推理、对话,小模型负责简单任务,共同构成智能体的“思考能力”;模型路由层是“任务调度员”,根据任务需求选择最优模型,平衡“效率、成本、输出质量”

- 模型路由层:“任务调度员”,根据任务需求选择最优模型,平衡“效率、成本、输出质量”;

- 协议层:协作语言”,通过MCP、A2A等协议定义智能体之间的通信规则,实现多智能体的结构化协作

- 编排层:“工作流指挥官”,规划智能体的任务流程,协调多智能体、工具、环境的交互;

- 认证层(智能体侧:“身份安全员”,给智能体分配可信身份,控制访问权限;

- 可观测层:“行为监控器”,通过日志记录、反馈循环、数据分析,跟踪智能体行为,用于调试问题、优化性能。

3)上层交互层连接智能体与用户/外部系统,包含:

- 工具层:“能力扩展手”,提供API、搜索等外部工具,让智能体突破“自身知识局限”,实现自动化决策;

- 认证层(用户侧):“用户安全员”,通过账号密码、人脸识别等方式验证用户身份,控制用户操作权限;

- 记忆层:“个性化助手”,专门存储用户的历史交互和上下文知识,让智能体实现“个性化服务”;

- 前端应用层:“用户接触面”,通过Web页面、聊天窗口、APP界面等UI组件,让用户能“无缝、直观”地与智能体交互。

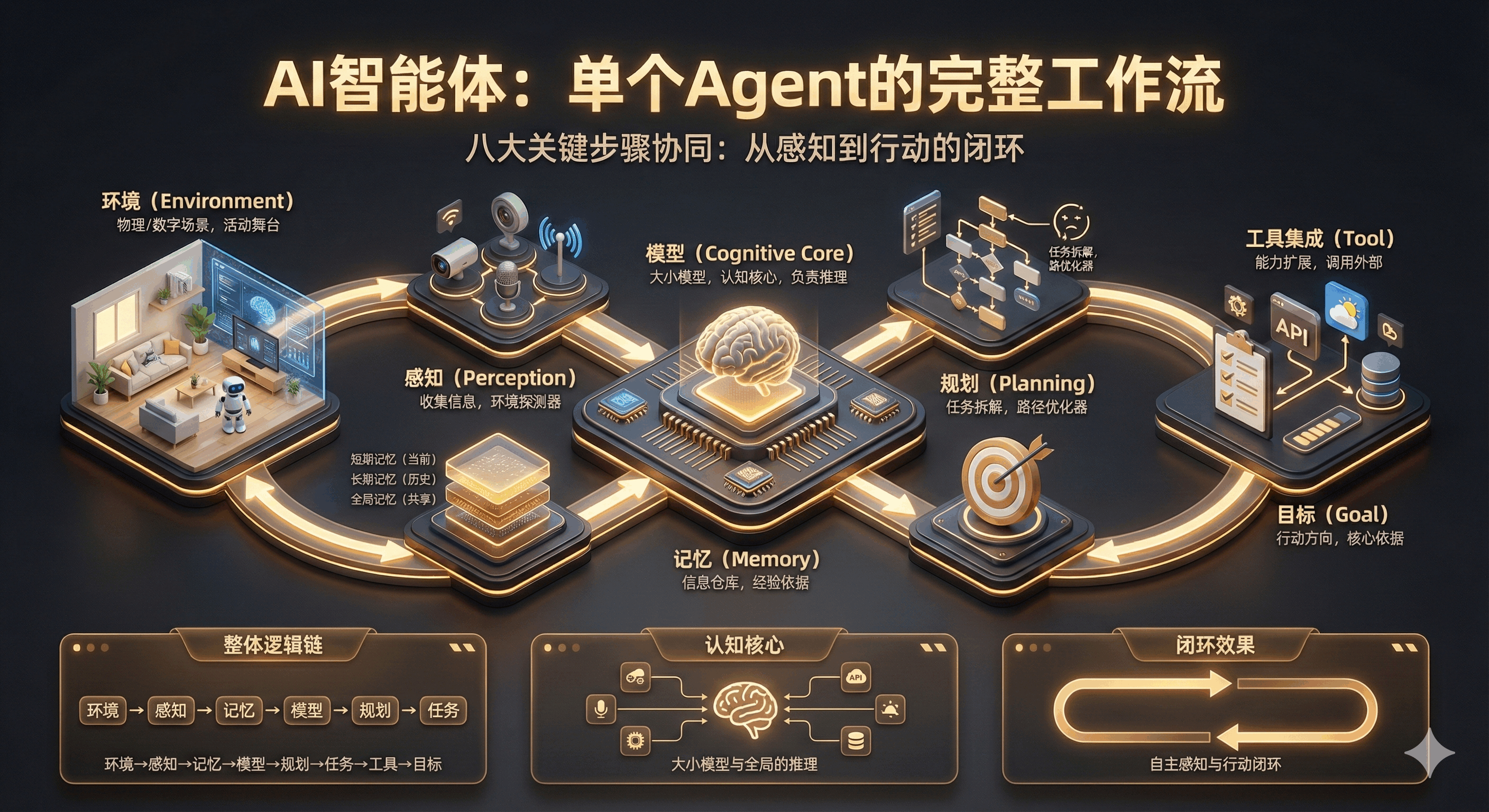

4.2 核心功能模块:“感知 – 处理 – 执行” 的闭环逻辑

AI 智能体的核心功能围绕 “感知环境→处理信息→执行任务” 展开,八个关键模块各司其职又紧密协作:

- 环境是智能体的 “外部场景”,是系统交互的对象基础,比如家庭空间(家用机器人环境)、网络数据池(对话 AI 环境),所有模块的运作都需基于环境信息。

- 感知模块是智能体的 “感官”,通过传感器、输入接口抓取环境数据,将物理世界或用户需求转化为系统可处理的信息。

- 记忆存储是智能体的 “知识库”,分长期记忆(如预设规则、历史交互数据)和短期记忆(如当前任务的上下文),为决策提供信息支撑。

- 规划决策是智能体的 “决策中枢”,结合预设目标和记忆存储,拆解任务、制定行动步骤,比如 “用户要订咖啡,先查附近门店→选口味→下单”。

- 任务执行是智能体的 “行动单元”,将规划好的步骤落地,比如机器人移动、对话 AI 输出回复,是 “想法变行动” 的关键。

- 工具集成是智能体的 “能力扩展接口”,通过调用外部 API、工具,弥补自身功能局限,比如无实时地图数据时,调用工具获取。

- 预设目标是智能体的 “行动方向”,是系统运行的初始依据,可能是开发者设定(如 “家用机器人负责清洁”)或用户指定(如 “帮我写报告”),决定决策和执行的核心方向。

- 核心模型是智能体的 “中央协调器”,类似 “大脑总指挥”,统筹感知、记忆、决策等所有模块的协同,确保各环节衔接顺畅,避免功能混乱。

这八个模块的整体逻辑链十分清晰:

预设目标定方向→感知模块获环境信息→记忆存储提供历史 / 上下文→核心模型协调规划决策制定步骤→工具集成补全能力→任务执行落地行动,形成完整闭环,确保智能体能够自主推进目标达成。

5. 单个 Agent 的完整工作流:八个关键步骤的协同运作

单个 AI 智能体要实现 “自主感知、决策与行动”,离不开八个核心要素的无缝配合,每个步骤都环环相扣,构成完整的工作逻辑:

5.1 记忆是 AI Agent 的 “信息仓库”

按用途分为三类 ——

- 短期记忆服务于当前进程中的任务,比如对话上下文、正在执行的任务步骤;

- 长期记忆存储历史环境信息与行动记录,比如用户过往偏好、之前处理类似任务的经验;

- 全局记忆则支持多 Agent 共享数据,比如团队协作场景中需要互通的任务进度。

这三类记忆共同构成 Agent 决策的 “经验依据”,确保行动不盲目。

1)规划是 Agent 的 “任务拆解与优化器”

- 首先会按需求紧急度或用户偏好把总目标拆成可执行的小任务

- 再结合记忆中的经验和用户行为调整策略

- 还会通过 “自我批评” 复盘过往规划的不足,持续优化行动路径

- 确保每一步都朝着高效达成目标的方向推进。

2)任务是 Agent 的 “待办清单”

- 明确当前要执行的具体事项

- 执行过程中会联动工具实时跟踪进度。比如调用支付 API 后确认订单是否提交成功,是规划落地的 “具体载体”

- 让抽象的规划变成可落地的动作。

3)工具集成是 Agent 的 “能力扩展接口”

通过对接 API、数据库、浏览器等外部工具,打破自身功能局限

比如需要实时天气数据时调用气象 API,需要存储用户信息时连接数据库,让 Agent 不用 “从零构建能力”,就能快速适配各类场景。

4)感知是 Agent 的 “环境探测器”

- 从文本、图像、音频等数据,或位置、网络状态等传感器信息中收集环境信号

- 把 “外部信息” 转化为 Agent 可处理的 “内部数据”,是所有行动的 “信息源头”

- 没有感知模块的精准输入,后续决策就会偏离实际。

5)模型是 Agent 的 “认知核心”,大模型(如 GPT-4、文心一言

- 负责复杂推理、自然语言理解等高阶任务,小模型(如轻量分类模型)处理简单的信息筛选、意图识别等工作。

- Agent 会根据任务难度灵活调用不同模型,甚至多次迭代调用。比如先调用理解模型解析用户模糊需求,再调用推理模型制定具体方案。

6)目标是 Agent 的 “行动方向”

- 即需要完成的总体任务,比如 “帮用户生成旅行攻略”“处理订单退款”

- 是规划、任务拆解的 “核心依据”,所有行为都围绕目标展开,避免 “做无用功”。

7)环境是 Agent 的 “活动场景”

- 可能是物理空间(如自动驾驶的道路、家用机器人的房间)

- 或是数字领域(如客户服务的聊天界面、数据分析的数据库环境)。

- Agent 的感知、行动都需适配环境特性,比如自动驾驶 Agent 要感知道路红绿灯、行人,聊天 Agent 要适配文本输入输出的交互形式。

5.2 单个 Agent 的整体逻辑链的

- 环境提供具体场景→

- 感知模块收集外部信息→

- 记忆存储调用历史经验与上下文→

- 模型处理信息并生成初步思路→

- 规划环节拆解目标、优化路径→

- 任务明确具体待办事项→

- 工具集成补全能力缺口→

- 最终围绕核心目标落地行动,形成 “从感知到行动” 的完整闭环。

6. 多 Agent 协作:以文档撰写为例,看分工协作的高效逻辑

当任务复杂度超出单个 Agent 的处理能力时,多智能体系统(MAS)就会发挥优势,核心逻辑是 “协调 Agent 主导 + 各角色 Agent 分工 + 人机协作收尾”,以 “多 Agent 协作完成文档撰写” 为例,完整流程如下:

6.1 需求启动

是整个流程的起点,以 “用户需要撰写文档” 为初始指令,启动方式十分灵活 —— 既可以是人类直接提出需求,比如用户说 “帮我写一份产品季度报告”;也可以由其他 AI Agent 触发,比如任务管理 Agent 在到期前自动推送 “今日需完成市场分析文档” 的需求,确保任务不遗漏。

6.2 核心调度由 “协调 Agent” 负责,它相当于整个协作流程的 “总指挥”

核心职责有三项:

一是精准掌握其他 Agent 的能力边界,比如清楚 “内容生成 Agent 擅长写初稿、数据整理 Agent 擅长找行业数据、编辑 Agent 擅长优化逻辑”;

二是统筹工作顺序,根据文档撰写的逻辑,规划 “先让数据 Agent 收集素材→再让生成 Agent 写初稿→编辑 Agent 优化→最后人机审核” 的流程;

三是审核中间成果,比如检查数据 Agent 收集的素材是否准确、生成 Agent 的初稿是否符合主题,确保流程不跑偏。

6.3 任务传递通过 “目标提示词” 实现

这是协调 Agent 推动流程的 “指令载体”。它会把 “写文档” 的总目标拆解成多个子目标,比如

- “子目标 1:收集本季度产品销量数据”

- “子目标 2:整理行业竞品动态”

- 再为每个子目标生成精准的提示词

- 下发给对应的负责 Agent

- 同时明确该 Agent 需要用什么模型处理。比如给数据整理 Agent 指定 “擅长结构化分析的 LLM”,给内容生成 Agent 指定 “擅长文本创作的 GPT-4”,确保任务精准落地。

6.4 成果反馈形成 “输出提示词” 闭环

1)子 Agent 完成任务后,会将结果以标准化的 “输出提示词” 形式返回给协调 Agent

比如数据 Agent 返回 “本季度产品销量同比增长 20%,核心增长区域为华东地区”,生成 Agent 返回文档初稿的关键段落。

2)协调 Agent 审核通过后,再推进下一步流程;

3)若审核不通过,会明确指出修改方向

比如 “数据需补充环比数据”“初稿需增加用户反馈部分”,让子 Agent 修正后重新提交。

4)模型适配是多 Agent 协作的 “能力支撑”,不同 Agent 会根据任务需求选择适配的 LLM:

- 内容生成 Agent 用擅长文本创作的大模型,确保文档语言流畅、逻辑清晰;

- 数据整理 Agent 用擅长结构化分析的模型或轻量 AI 技术,提高数据处理效率;

- 编辑 Agent 用擅长语法纠错、逻辑优化的模型,提升文档质量。

5)多个 Agent 也可共用同一 LLM,核心原则是 “模型能力匹配任务需求”,不盲目追求大模型。

6.5 收尾协作聚焦 “人机协作”,这是保障文档质量的关键环节。

当各 Agent 完成初稿、数据补充、逻辑优化等环节后,由 “编辑 Agent” 先做预处理 —— 修正语法错误、调整段落结构、标注需要人类确认的内容,再交由人类审核调整。

人类可以补充主观判断,比如修改报告的侧重点、补充内部核心信息,结合机器的效率与人类的判断力,确保文档完全符合用户预期。

7. 系统治理补全:安全性三重网关 + 可观测性落地细节

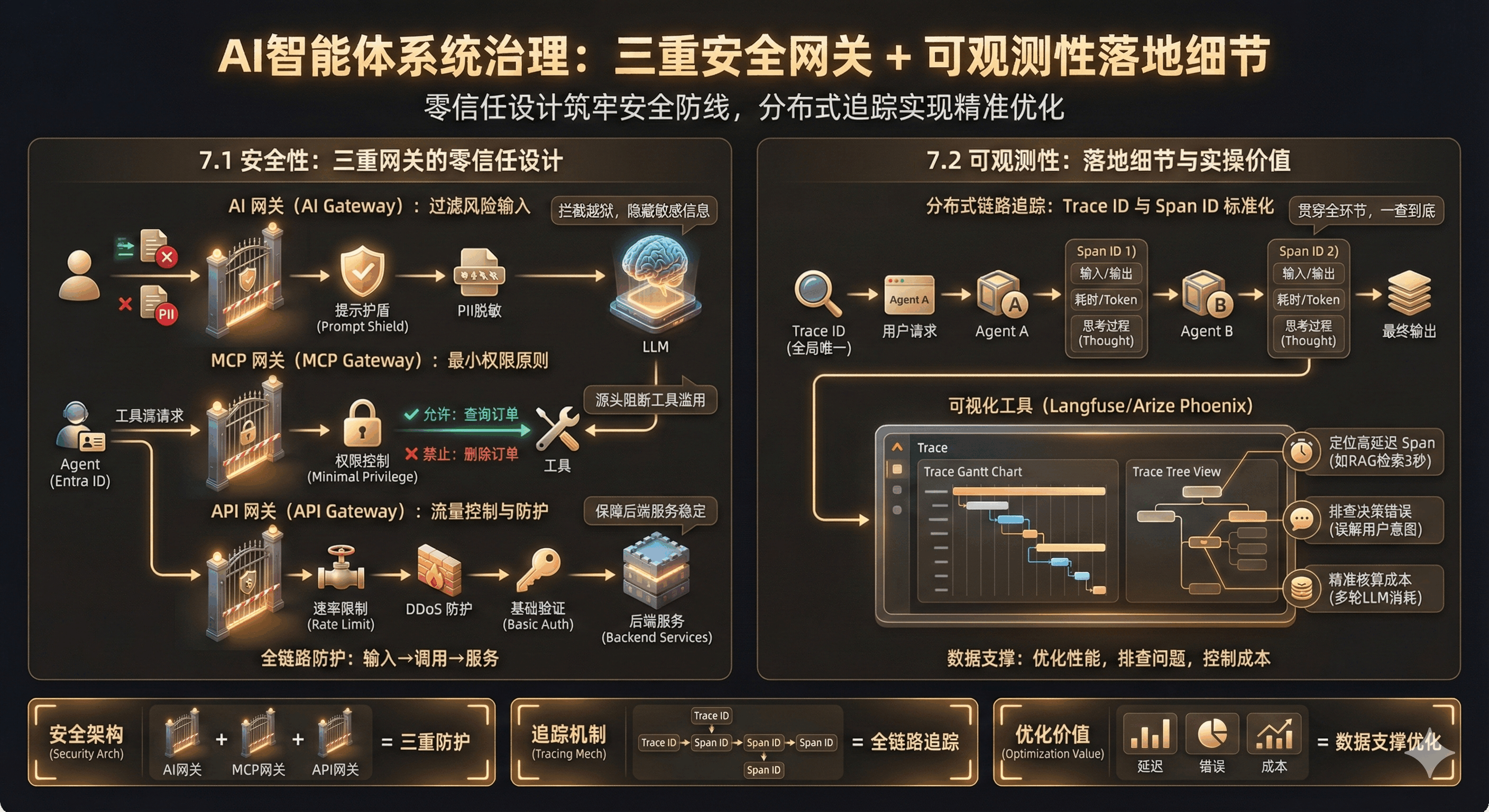

7.1 安全性:三重网关的零信任设计(补全 API 网关)

1)面对提示注入、工具滥用、隐私泄露等新型风险,2025 年 AI 智能体的安全架构核心是“三重网关模式” 的零信任设计,三者层层递进,构建全方位防护:

2)AI 网关位于用户与 LLM 之间,核心功能是 “过滤风险输入”。它集成了提示护盾(Prompt Shield),能实时扫描用户输入,精准拦截越狱攻击、恶意指令等风险;同时还会处理PII(个人敏感信息)脱敏

比如自动隐藏用户的手机号、身份证号,防止隐私数据被发送给公共大模型,典型工具包括 Cloudflare AI Gateway、Kong AI Gateway。

3)MCP 网关位于 Agent 与外部工具之间,遵循 “最小权限原则”。Agent 调用工具时,必须通过网关完成鉴权 —— 网关会根据 Agent 的身份(如 Entra Agent ID)判断权限,比如只允许售后 Agent 调用 “查询订单” 接口,禁止其调用 “删除订单” 等高危操作;同时还会监控工具调用的频率和参数,防止 Agent 被诱导执行恶意操作,从源头阻断工具滥用风险。

4)API 网关承担传统的 “流量控制与基础防护” 职责,负责速率限制(避免高频调用拖垮后端服务)、DDoS 防护(抵御恶意流量攻击)和基础身份验证(确认调用方的合法身份),确保后端工具和数据服务的稳定性,为整个智能体系统筑牢 “基础安全防线”。

这三重网关形成了 “输入 – 调用 – 服务” 的全链路防护,让不可预测的 Agent 行为始终处于安全 “护栏” 内,实现从 Demo 到生产环境的安全着陆。

7.2 可观测性:落地细节与实操价值

分布式链路追踪不是 “纸上谈兵”,而是解决 Agent 调试难题的核心手段,落地时需关注两个关键细节:

一是 Trace ID 与 Span ID 的标准化管理,每个用户请求生成的 Trace ID 要全局唯一,并且贯穿所有环节 —— 无论该请求触发了多少个 Agent、调用了多少次 LLM 或外部 API,所有日志、操作记录都必须关联这个 Trace ID,确保 “一查到底”;而每个 Span ID 对应的原子操作,不仅要记录输入、输出、耗时、Token 消耗和状态,还要额外记录 “Agent 的思考过程”,比如 ReAct 循环中的 Thought 字段,方便开发者还原决策链路。

二是可视化工具的灵活运用,通过 Langfuse、Arize Phoenix、LangSmith 等工具,将 Trace 数据可视化为甘特图或树状图后,能解决三大核心问题:快速定位高延迟 Span,比如发现 “RAG 检索耗时 3 秒”,进而优化知识库索引;排查决策错误原因,比如 Agent 误调用工具时,通过查看 Thought 字段发现 “误解了用户意图”,进而优化提示词;精准核算成本,比如明确 Token 消耗主要集中在 “多轮 LLM 调用”,进而调整模型选型或对话策略,让可观测性真正为系统优化提供数据支撑。

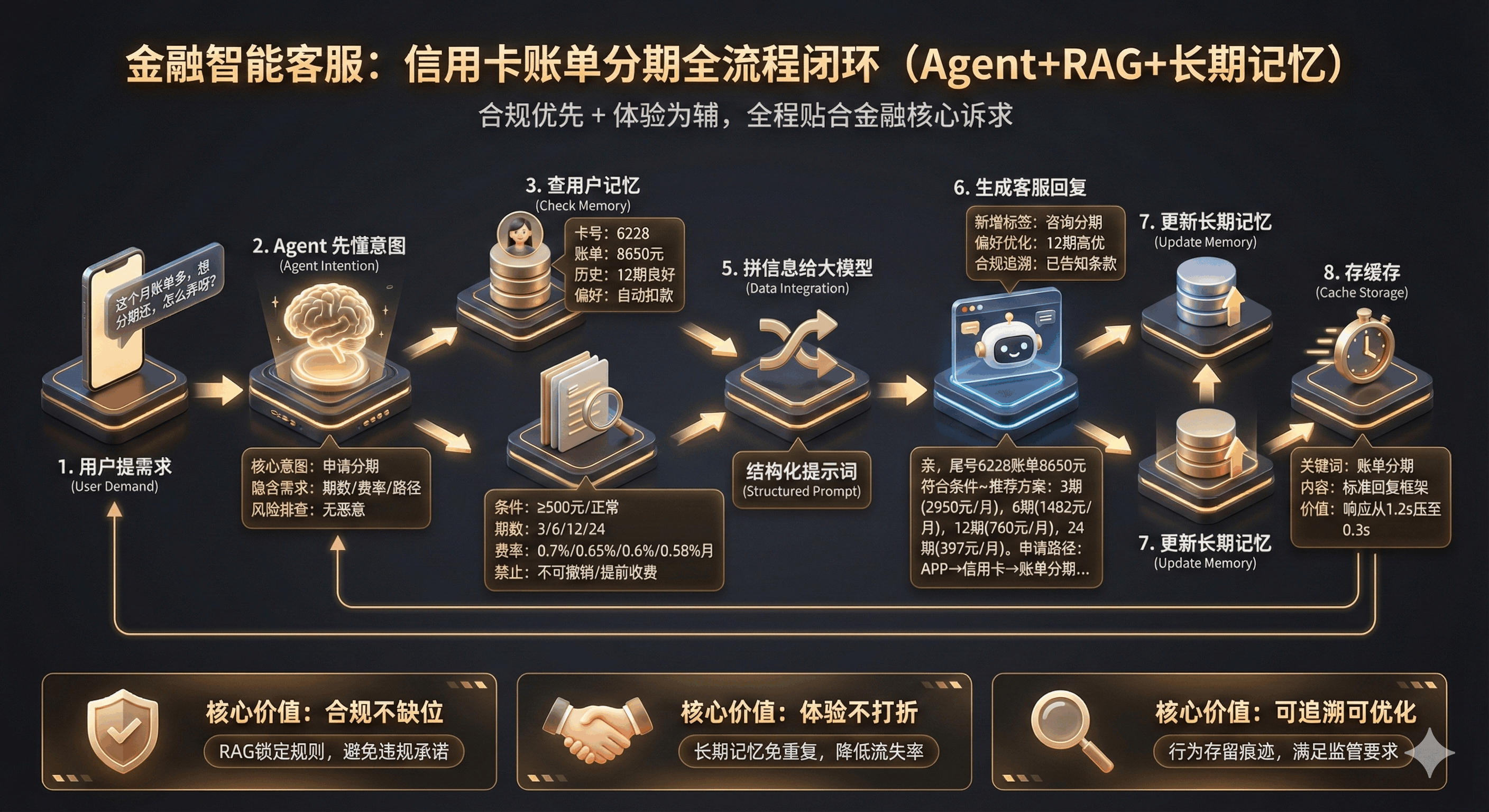

8.金融智能客服案例:信用卡账单分期申请的全流程闭环(Agent + 长期记忆 + RAG)

核心逻辑:金融场景对合规性、用户资产安全性要求极高,该案例通过 “长期记忆精准画像 + RAG 锚定合规规则 + 大模型生成适配方案”,实现 “不用用户重复信息、方案合规无偏差、用户行为可追溯” 的服务闭环,全程贴合金融行业 “安全优先、体验为辅” 的核心诉求。

1. 用户提需求:口语化表达分期诉求

用户通过 APP 聊天窗口发送:“这个月信用卡账单有点多,想分几期还,怎么弄呀?”(注:金融用户常以口语化表达核心需求,Agent 需先破解模糊表述,避免因理解偏差导致合规风险)

2. Agent 先懂意图:精准识别核心诉求 + 隐含需求

Agent 通过自然语言理解模型快速拆解:

- 核心意图:申请信用卡账单分期;

- 隐含需求:需要知道可分期期数、手续费率、申请路径,且大概率希望流程简便(金融用户对复杂操作容忍度低);

- 风险排查:初步判断无恶意诉求(如 “免手续费”“逾期后分期” 等违规暗示),进入正常处理流程。

3. 查用户记忆:调取资产信息 + 历史行为,免用户重复说明

Agent 通过用户 ID(已完成登录态校验)从长期记忆库提取关键信息:

- 核心资产信息:绑定的信用卡卡号后四位(6228)、当前账单金额(8650 元)、账单日(每月 5 日)、到期还款日(每月 23 日)、账户状态(正常,无逾期记录);

- 历史行为偏好:2024 年 10 月曾申请过 12 期账单分期,还款记录良好(无逾期),过往选择 “自动扣款” 方式还款,对手续费敏感度中等(未拒绝过标准费率分期);

- 身份校验补充:长期记忆中留存用户 “常用收货地址”“绑定手机号后四位”,后续若需二次校验可直接调用,无需额外询问。

4. 查合规规则:RAG 知识库精准提取分期政策

Agent 调用金融行业专属 RAG 知识库,基于 “信用卡账单分期” 关键词检索合规规则(避免人工整理规则的遗漏或过时风险):

- 基础申请条件:账单金额≥500 元、账户状态正常(无逾期、无冻结)、申请时间在账单日后至到期还款日前(当前时间为每月 10 日,符合时限);

- 可分期期数:支持 3/6/12/24 期(不同银行政策略有差异,RAG 按用户所持信用卡发卡行规则精准匹配);

- 手续费率:3 期 0.7%/ 月、6 期 0.65%/ 月、12 期 0.6%/ 月、24 期 0.58%/ 月(按央行利率新规,需明确标注 “月费率”,禁止模糊表述 “低至 X 元”);

- 禁止条款:分期后不可撤销、提前还款需支付剩余期数手续费、逾期后不可申请当期账单分期(重点合规点,必须在回复中明确提示)。

5. 拼信息给大模型:合规信息 + 用户画像双重约束

Agent 将 “用户长期记忆数据 + RAG 合规规则 + 金融话术模板” 整合为结构化提示词,核心字段包括:

- 用户信息:卡号后四位 6228,当前账单 8650 元,历史 12 期分期记录,还款良好,偏好自动扣款;

- 合规规则:可分期期数 3/6/12/24 期,对应月费率 0.7%/0.65%/0.6%/0.58%,申请时限内,账户状态正常;

- 输出要求:语言通俗(避免 “年化利率”“剩余本金摊还” 等专业术语,必要时转化为 “每月还款额”)、先讲结论再讲流程、明确提示禁止条款、标注申请路径(APP 端操作,避免引导至非官方渠道)。

6. 生成客服回复:合规优先 + 贴合用户偏好

大模型输出友好且无合规漏洞的回复:

“亲,已查到您尾号 6228 的信用卡当前账单金额 8650 元,符合账单分期申请条件~ 结合您之前选择 12 期分期的偏好,为您整理了可选方案:

✅ 3 期:每月还款约 2950 元(含手续费 60.55 元 / 月),总手续费 181.65 元;

✅ 6 期:每月还款约 1482 元(含手续费 56.23 元 / 月),总手续费 337.38 元;

✅ 12 期:每月还款约 760 元(含手续费 51.9 元 / 月),总手续费 622.8 元;

✅ 24 期:每月还款约 397 元(含手续费 49.17 元 / 月),总手续费 1180.08 元。

申请路径:打开 APP→进入 “信用卡” 页面→点击 “账单分期”→选择期数→确认提交(提交后不可撤销哦)。温馨提示:您过往习惯自动扣款,分期后每月还款额会自动从绑定银行卡扣除,记得保持卡内余额充足;若需提前还款,需支付剩余期数全部手续费~有其他疑问可随时告诉我!”

7. 更新长期记忆:记录用户行为 + 补充画像维度

Agent 将本次交互关键信息写入用户长期记忆库,丰富用户画像:

- 新增行为标签:2025 年 X 月 X 日咨询信用卡账单分期(未明确选择期数)、对多期数方案有查询需求;

- 偏好优化:在 “分期期数偏好” 中增加 “12 期为高优先级推荐”(基于历史选择 + 本次咨询);

- 合规追溯:记录 “已向用户告知分期手续费率、禁止条款”,形成服务痕迹,便于后续纠纷核查。

8. 存缓存:搭建高频问题快速响应库

Agent 将 “信用卡账单分期咨询” 的问题模板、合规规则摘要、回复示例存入缓存库:

- 缓存关键词:“账单分期”“分期怎么弄”“账单太多想分期”;

- 缓存内容:标准化回复框架 + 可替换变量(账单金额、期数、费率);

- 价值:下次有同类咨询时,无需重复调用 RAG 和长期记忆库,直接替换变量生成回复,响应时间从 1.2 秒压缩至 0.3 秒,同时保证合规表述一致。

案例核心价值:金融场景的 Agent 落地关键

- 合规不缺位:通过 RAG 知识库锁定官方规则,避免人工客服因记忆偏差导致的违规承诺(如 “提前还款免手续费”);

- 体验不打折:长期记忆替代 “重复问信息”(如 “你卡号多少”“账单金额多少”),金融服务中用户对隐私信息重复披露的抵触感更强,该设计大幅降低用户流失率;

- 可追溯可优化:用户行为存入长期记忆后,后续可针对性推荐(如用户后续未申请分期,可触发 “低息分期券” 推送),同时服务痕迹满足金融监管 “可追溯” 要求。

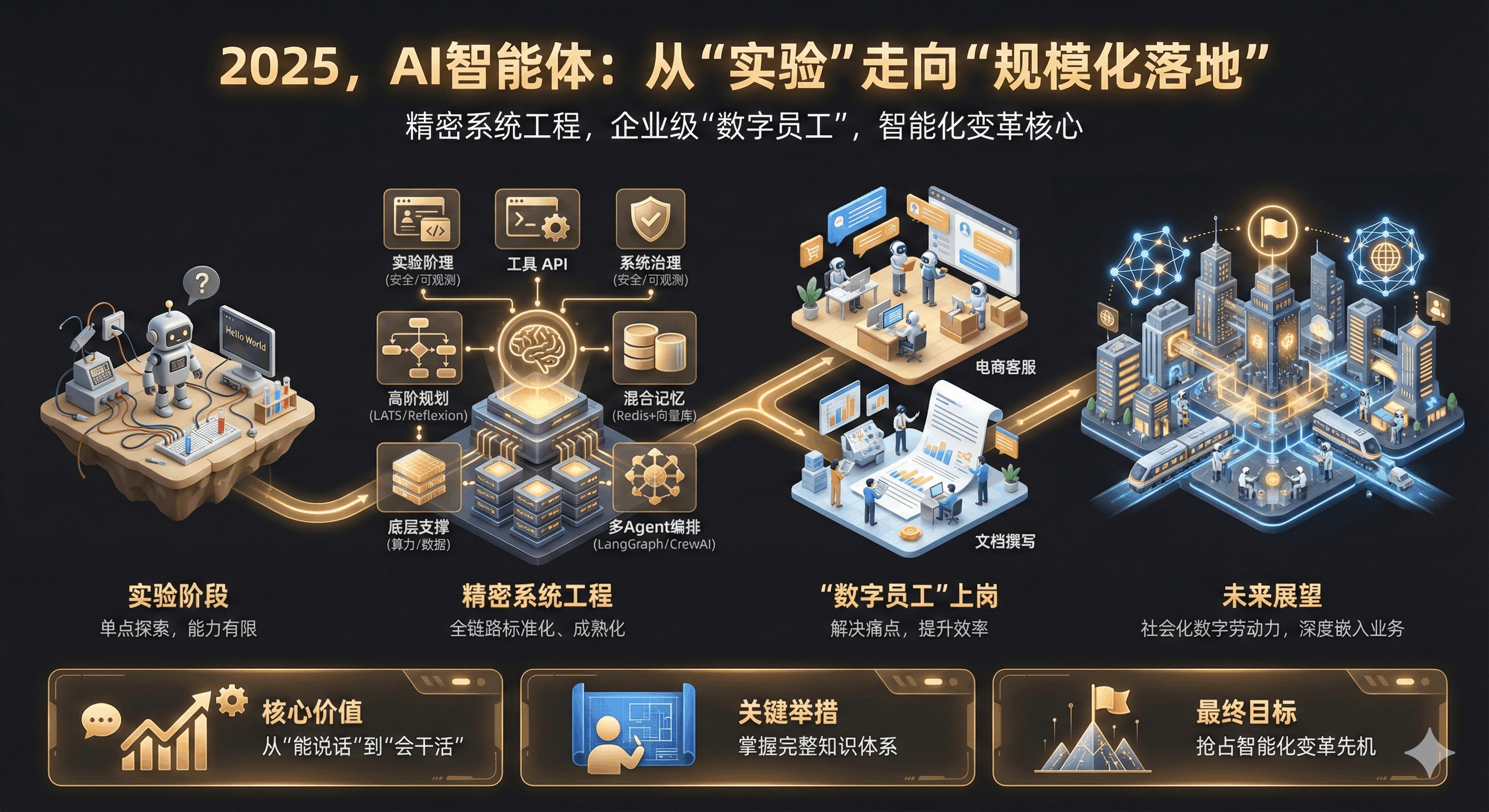

9. 结论:2025,AI 智能体从 “实验” 走向 “规模化落地”

2025 年的 AI Agent 技术体系,早已不是早期的单点实验,而是进化为精密复杂的系统工程 —— 通过融合 LATS、Reflexion 等高阶规划算法,Redis + 向量数据库的混合记忆架构,以及 LangGraph、CrewAI 等多 Agent 编排框架,智能体已经具备处理长时程、多步骤复杂任务的能力,从 “能说话” 真正走向 “会干活”。

回顾整个技术链路,从底层支撑层的算力、数据底座,到中层核心层的模型、协作协议,再到上层交互层的用户体验、工具集成,以及系统治理的可观测性、安全性防护,每个环节都在走向标准化、成熟化。而电商客服、文档撰写等场景的落地实践,更证明了 AI Agent 不是 “空中楼阁”,而是能实实在在解决企业痛点、提升效率的 “数字员工”。

展望未来,随着多智能体协作的普及和安全观测基础设施的进一步完善,AI Agent 将不再是孤立的工具,而是作为具备社会属性的数字劳动力,深度嵌入企业的业务流程中 —— 从日常决策到复杂项目协作,从客户服务到数据分析,都能看到智能体的身影。

对于企业和开发者而言,掌握 AI Agent 的完整知识体系,理解其认知架构、记忆机制、协作逻辑和落地要点,已经成为构建下一代智能化软件的核心竞争力。2025 年,AI 智能体的时代已经到来,唯有紧跟技术演进、吃透落地逻辑,才能在这场智能化变革中抢占先机。

本文由 @王俊 Teddy 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自作者提供

起点课堂会员权益

起点课堂会员权益

最后这个金融智能客服案例,是推荐用智能体做还是用工作流做呢?

等我第三篇文章~有详细解释哈哈哈

🤩

谢谢老铁的支持